تاثیرات عمیق دیپ فیکها و لزوم تفکر انتقادی در عصر هوش مصنوعی

دیپ فیکها در سراسر جهان تیتر اخبار شدهاند و به سرعت دارند به بخشی از زندگی روزمره ما تبدیل میشوند. اما تاثیرات آنها چیست؟ آیا دیپ فیکها در سطح شناختی عمیقتری بر ما تاثیر میگذارند؟ اگر تاثیرات دیپ فیکها اینقدر عمیق است چه کاری میتوانیم در برابر آنها انجام بدهیم؟ آیا میتوان از تفکر انتقادی به عنوان راهحلی برای کاهش تاثیرات مخرب دیپ فیکها استفاده کنیم؟

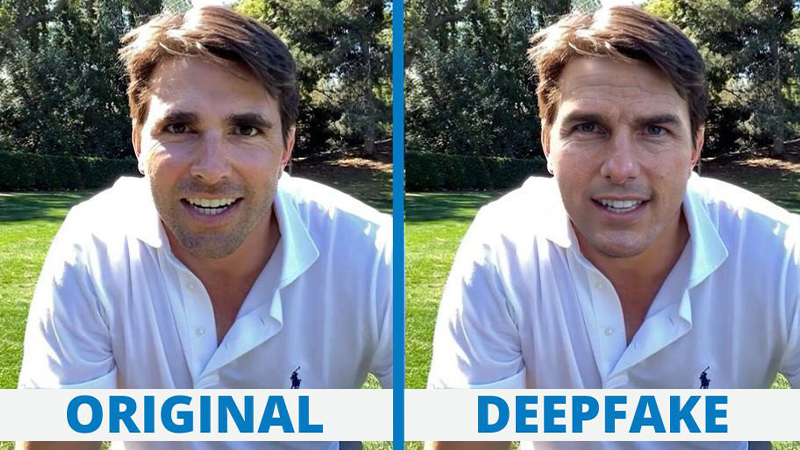

Sora هوش مصنوعی ویدیوساز شرکت Open AI اخیرا موج جدیدی از ویدیوهای ساخته شده با هوش مصنوعی را پیشنمایش کرده است. احتمالا زمانی زیادی نمیگذرد تا شاهد تولید ویدیوها، تصاویر و حتی صداهای مختلف توسط هوش مصنوعی آن هم تنها در عرض چند ثانیه باشم. تاکنون تلاشهای شرکتهای بزرگ فناوری برای کند یا متوقف کردن دیپفیکها، به جایی راه نبرده است. با این حال با افزایش قابلیتهای هوش مصنوعی و آمیخته شدن مرز واقعیت و دروغ، ما نیاز داریم تا مهارتهای تفکر انتقادی را برای تشخیص محتوای واقعی از دروغ پرورش دهیم. هر چند که حالا سیگنالهایی مانند متادیتا و واترمارکتها نیز وجود دارند تا به انسانها در تشخیص محتوای ساخته شده با هوش مصنوعی کمک کنند، اما همچنان جدا کردن محتوای اصیل و هدفمند از آنچه قصد گمراه کردن مخاطب را دارد، همچنان چالشبرانگیز است. به طوری که در درگیری اسرائیل و فلسطین ما شاهد تصاویری نگران کنندهای بودیم که واقعی برچسب خورده بودند در حالی که جعلی بودند و بالعکس.

مسئله این است حالا که دارند دیپ فیکها با سرعت زیادی پیشرفت میکنند و ما شاهد ویدیوها و تصاویر ساخته شده زیاد و متنوعی با هوش مصنوعی هستیم، چه کاری باید انجام دهیم؟ و مسئله بعدی این است که دیپ فیکها چه تاثیری بر تصمیمگیریها ما میگذارند؟ به عنوان مثال، زمانی که افراد در معرض تصاویر جعلی سیاسی قرار میگیرند آیا رفتارهای سیاسی آنها تغییر میکند؟ بیایید به چند مطالعه که دقیقا همین موضوع را ارزیابی میکنند، نگاهی بیندازیم.

تأثیر ویدیوهای دیپ فیک بر باورها و حالات روانی انسانها

در سال 2020 یک پژوهش برای بررسی واکنشها به انواع مختلف ویدیوهای دیپ فیک از باراک اوباما، رئیس جمهور سابق ایالات متحده طراحی شد. در این تحقیق 2005 پاسخگو از بریتانیا شرکت داشتند و به طور تصادفی یکی از سه ویدیو زیر را برای تماشا انتخاب میکردند:

- یک کلیپ 4 ثانیهای که در آن اوباما یک اظهارنظر عجیب و بیپشتوانهای را در آن بیان میکرد.

- یک کلیپ 26 ثانیهای که در آن نشانههایی درباره ماهیت مصنوعی بودن ویدیو داشت.

- یک ویدیو کامل که در آن با صراحت به دیپفیک بودن ویدیو اشاره شده بود و در ادامه جردن پیل فناوری پشت این نوع از ساخت ویدیو را توضیح میداد.

بعد از بررسیها، نتایج تحقیق در سه دسته زیر قرار گرفت:

- فریب: شواهد کمی وجود داشت که نشان میداد مردم واقعا به محتوای جعلی در ویدیوها باور دارند. به طور کلی درصد شرکتکنندگانی که توسط دیپفیکها گمراه شده بودند، در تمام گروههای تحت بررسی، نسبتا پایین بود.

- عدم اطمینان: اما نکته قابل تامل اینجاست که محتوای جعلی باعث افزایش عدم اطمینان در میان بینندگان ویدیو شد. به ویژه افرادی که ویدیوی 4 ثانیهای را تماشا کرده بودند، در واقع حدود 35 تا 37 درصد از افرادی که این ویدیو را دیدند در مورد اصالت آن شک داشتند.

- عدم اعتماد به اخبار: این عدم اطمینان باعث کاهش اعتماد افراد به اخبار در رسانههای اجتماعی شد. افرادی که در معرض دیپ فیکهای گمراهکننده قرار گرفته بودند، سطح اعتماد پایینتری نسبت به کسانی که ویدیو سوم را تماشا کردند، نشان دادند.

بنابراین، هرچند ویدیوهای جعلی لزوماً باعث فریب خوردن مردم نمیشوند، اما میتوانند عدم اطمینان و بیاعتمادی نسبت به منابع اطلاعات را افزایش دهند. این اثرات میتواند طولانی مدت باشد و در نهایت به طور کلی اعتماد افراد به واقعیت را تضعیف کند. پس در کل، محتوای جعلی مانند ویدیوهای دیپ فیک میتواند بر حالات روانی مانند عدم اطمینان و بیاعتمادی ما تأثیر بگذارد، حتی اگر باورپذیر نباشند.

دیپ فیک و ایجاد «خاطرات جعلی»

مطالعه دیگری با نام Face/Off که در سال 2023 با 436 شرکت کننده انجام شد، چگونگی تأثیر دیپ فیکها و سایر محتوای جعلی بر خاطرات و ادراکات ما از فیلمها را بررسی کرد. در این پژوهش، پاسخگویان در یک نظرسنجی آنلاین شرکت کردند که شامل معرفی شش عنوان فیلم بود – چهار بازسازی واقعی و دو مورد خیالی/جعلی. فیلمها به صورت تصادفی انتخاب و با کلیپهای ویدیویی یا توضیحات متنی ارائه شدند.

ویدیوهای ساخته شده با هوش مصنوعی، شامل نسخههایی از فیلمهای درخشش، ماتریکس، ایندیانا جونز و کاپیتان مارول بود که به طور جعلی ادعا میکرد بازیگران سرشناس در آنها بازی کردهاند. به عنوان مثال، به شرکت کنندگان گفته شد که نسخهای از فیلم درخشش با بازی برد پیت و آنجلینا جولی وجود دارد، در حالی که چنین چیزی هرگز ساخته نشده بود.

از شرکتکنندگان در مورد آشنایی آنها با هر فیلم سوال شد. یکی از یافتههای کلیدی این بود که نزدیک به نیمی (49 درصد) از شرکتکنندگان «خاطرات جعلی» از تماشای ویدیوهای دیپفیک را توسعه دادند – به عنوان مثال، آنها فکر میکردند واقعاً ویل اسمیت را در نقش نئو در فیلم ماتریکس دیدهاند.

فیلم کاپیتان مارول بیشترین میزان خاطرات جعلی را با 73 درصد ایجاد کرد، پس از آن ایندیانا جونز با 43 درصد، ماتریکس با 42 درصد و درخشش با 40 درصد قرار داشتند. از میان کسانی که به اشتباه به این بازسازیها باور داشتند، 41 درصد فکر میکردند که نسخه جعلی کاپیتان مارول از نسخه اصلی بهتر است.

یک یافته دیگر این بود که دیپ فیکها موثرتر از توضیحات متنی در تغییر خاطرات نبودند. این نشان میدهد که نوع فرمت اطلاعات گمراه کننده – تصویری یا متنی – در زمینه فیلم، تأثیر قابل توجهی بر ایجاد خاطرات جعلی ندارد.

پدیده «خاطرات جعلی» نشان میدهد که چگونه انسانها میتوانند به طور موثر خاطراتی را بسازند که مطمئن هستند واقعی است، حتی زمانی که وجود خارجی ندارند. دیپ فیکها این رفتار را تحریک میکنند، به این معنی که تماشای برخی محتواهای ساخته شده با هوش مصنوعی میتواند ادراک ما را تغییر دهد، حتی زمانی که ما به طور آگاهانه درک میکنیم که اصیل نیست. این تأثیرات، به ویژه با گردش گسترده محتوای جعلی در میان میلیونها نفر، میتواند طولانی مدت و فراگیر باشد.

در برابر دیپ فیک ها چه باید کرد؟

دیپ فیکها تهدیدی جدی برای اعتماد عمومی هستند. برای مقابله با این چالش نوظهور، اقدامات چندجانبه زیر توسعه میشود:

- افزایش سواد رسانهای و قدرت تجزیه و تحلیل انتقادی- ما باید فراتر از صرفاً باور آنچه که میبینیم، برویم و منابع، زمینه و انگیزههای پشت محتوا را بررسی و شواهد را از منابع معتبر جمعآوری و تحلیل کنیم.

- ایجاد استانداردها و قوانین برای شناسایی و مسئولیت دادن به سازندگان محتوای جعلی یا دستکاری شده- لوایحی مانند DEFIANCE در آمریکا و قانون ایمنی آنلاین در انگلستان در این راستا هستند.

- توسعه فناوریهایی برای شناسایی و تشخیص دیپ فیکها – از جمله هوش مصنوعی و یادگیری ماشین برای کشف نشانههای جعل در محتوا.

- آموزش و آگاهی عمومی در مورد خطرات و چالشهای دیپ فیکها – افزایش آگاهی مردم در این زمینه امری ضروری است.

- همکاری بین دولتها، صنایع و جامعه فناوری برای تدوین راهکارها و استانداردهای جهانی برای مبارزه با این تهدید.

در کل، نیاز به رویکردی چندجانبه شامل آموزش، قوانین، فناوری و همکاری برای حفاظت از فضای عمومی در برابر دیپ فیکها وجود دارد.

پنج استراتژی کلیدی برای مبارزه با اطلاعات گمراه کننده هوش مصنوعی

در عصر حاضر، دسترسی گسترده به فناوریهای پیشرفته مانند هوش مصنوعی، خطر انتشار اطلاعات جعلی یا گمراهکننده را بیش از پیش افزایش داده است. دیپ فیکها، که نوعی محتوای سنتتیک تولید شده توسط هوش مصنوعی هستند، می توانند به راحتی گمراه کننده باشند و تأثیر عمیق و گستردهای بر افکار عمومی داشته باشند. با این حال، با به کارگیری استراتژیهای مناسب، میتوان حقیقت را در میان انبوه اطلاعات آشکار کرد. اینجا پنج استراتژی کلیدی برای کمک به شناسایی و بررسی دیپ فیکهای بالقوه آورده شده است:

- تأیید منبع: قبل از اعتماد به هر اطلاعاتی، ضروری است که منبع آن را بررسی کنید. منابع معتبر و قابل اعتماد معمولا سابقه قوی در ارائه اطلاعات دقیق و بیطرفانه دارند. از طرف دیگر، منابع ناشناس یا منابعی که سابقه گمراه کننده دارند، باید با شک و تردید بیشتری بررسی شوند.

- تجزیه و تحلیل فنی: با پیشرفت فناوریهای دیپ فیک، شناسایی محتوای جعلی دشوارتر شده است. با این حال، هنوز نشانهها و نقصهای ظریفی وجود دارد که میتوانید آنها را جستجو کنید، مانند حالات چهره نامنظم، نورپردازی ناهمگون یا جزئیات مبهم. تجزیه و تحلیل دقیق و حرفهای میتواند به شما در تشخیص چنین نشانههایی کمک کند.

- مقایسه متقابل: هنگامی که با اطلاعات جدید مواجه میشوید، مقایسه آن با چندین منبع معتبر دیگر می تواند دیدگاه گستردهتری ارائه دهد. اگر اطلاعات در میان منابع قابل اعتماد متناقض یا بدون پشتیبانی است، احتمال میرود که جعلی یا گمراهکننده باشد.

- سواد دیجیتال: درک قابلیتها و محدودیتهای فناوریهای هوش مصنوعی و دیپ فیکها امری حیاتی است. آموزش سواد دیجیتال، از جمله نحوه کارکرد این فناوری ها و پیامدهای آنها، می تواند به شما در تشخیص محتوای فریبدهنده کمک کند.

- تعامل محتاطانه: اگر در مورد اصالت یک محتوا تردید دارید، بهترین کار این است که از اشتراکگذاری، لایک یا بازنشر آن خودداری کنید تا زمانی که صحت آن را تأیید کنید. اشتراکگذاری محتوای گمراه کننده میتواند به گسترش آن کمک کند.

در حالی که دیپ فیکها پیچیدهتر میشوند، لازم است استراتژیهای ما برای آشکارسازی حقیقت نیز متحول شوند. این امر در سال 2024 که نیمی از جمعیت جهان در انتخابات مهمی رأی میدهند، اهمیت ویژهای پیدا میکند. شواهد نشان میدهد دیپ فیکها میتوانند ادراک ما را تحتتأثیر قرار دهند و نتایج را دستکاری کنند.

برای جلوگیری از چنین پیامدهای خطرناکی، رویکردی همهجانبه اتخاذ خواهد شد. قوانین و استانداردهای اخلاقی باید برای هوش مصنوعی تدوین شود. آموزش سواد دیجیتال و تقویت تفکر انتقادی امری حیاتی است. با این اقدامات، میتوانیم آیندهای را شکل دهیم که در آن فناوری، حقیقت را ارائه میدهد نه اینکه آن را پنهان سازد.

جامعه جهانی باید متحد شود تا رویکردهای نوآورانه برای تشخیص و مقابله با دیپ فیکها ایجاد کند. تنها با همکاری، آموزش و اقدام مشترک است که میتوانیم از گسترش اطلاعات گمراهکننده جلوگیری کنیم و حقیقت را در دنیای امروز حفظ کنیم.

در پایان، اتخاذ یک رویکرد جامع، شامل آموزش سواد دیجیتال، استانداردهای اخلاقی هوش مصنوعی، قوانین و تفکر انتقادی از سوی افراد، حائز اهمیت است. در دنیایی که دیپ فیکها روز به روز پیچیدهتر میشوند، اینگونه استراتژیها میتوانند به حفظ حقیقت و جلوگیری از فریب افکار عمومی کمک کنند.