تشخیص دیپ فیک و تصاویر جعلی، توسط هوش مصنوعی (بخش اول)

چه کسی می خواهد میلیونر شود؟ 2913 نفر رویای میلیونر شدن را در سر میپرورانند و بر سر جایزه یک میلیونی مسابقه تشخیص دیپ فیک با یکدیگر به رقابت میپردازند. هدف از برگزاری مسابقه در ماه مارس 2020، ساخت و توسعه فنآوریهایی است که بتوانند دیپ فیک و رسانههای دستکاری شده را تشخیص دهند.

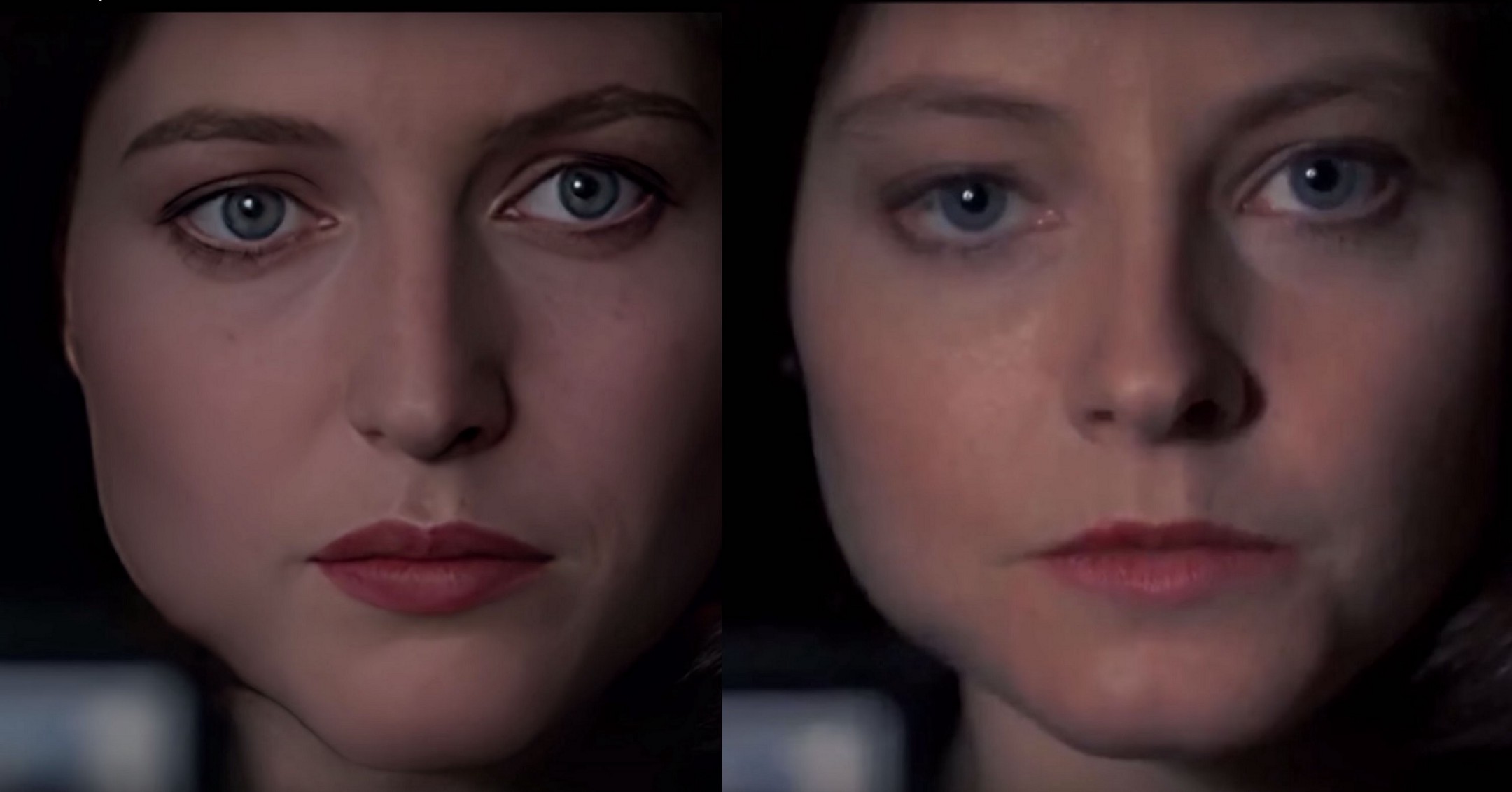

در ماه دسامبر سال 2019، شرکت فیسبوک 682 حساب کاربری را حذف کرد. شرکت فیسبوک مدعی شد صاحبان این حسابهای کاربری با اشاعه اعمال فریبکارانه قصد داشتند 55 میلیون کاربر را به طرفداری و حمایت از ترامپ ترغیب کنند. طبق اظهارات فیسبوک، برخی از این حسابهای کاربری از عکسهای ایجادشده توسط هوش مصنوعی برای پروفایل خود استفاده کردند و خود را آمریکایی جا زدهاند. گزارشها حاکی از آن است که این تصاویر در یک وبسایت عمومی ساخته شده که در آن برای ایجاد تصاویر پروفایل از StyleGAN استفاده میشود. تصاویری که در مقابل مشاهده میکنید توسط نسخه ارتقاء یافته موسوم به StyleGAN 2 ایجاد شده است. StyleGAN 2 در دسترس همگان قرار دارد.

در ماه دسامبر سال 2019، شرکت فیسبوک 682 حساب کاربری را حذف کرد. شرکت فیسبوک مدعی شد صاحبان این حسابهای کاربری با اشاعه اعمال فریبکارانه قصد داشتند 55 میلیون کاربر را به طرفداری و حمایت از ترامپ ترغیب کنند. طبق اظهارات فیسبوک، برخی از این حسابهای کاربری از عکسهای ایجادشده توسط هوش مصنوعی برای پروفایل خود استفاده کردند و خود را آمریکایی جا زدهاند. گزارشها حاکی از آن است که این تصاویر در یک وبسایت عمومی ساخته شده که در آن برای ایجاد تصاویر پروفایل از StyleGAN استفاده میشود. تصاویری که در مقابل مشاهده میکنید توسط نسخه ارتقاء یافته موسوم به StyleGAN 2 ایجاد شده است. StyleGAN 2 در دسترس همگان قرار دارد.

تشخیص دیپ فیک

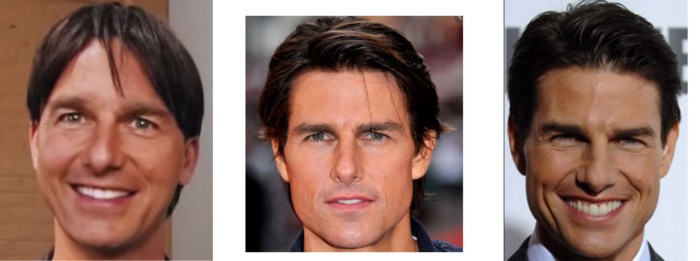

آیا میتوانید تشخیص دهید کدام یک از تصاویر مقابل جعلی است و کدام یک توسط StyleGAN ایجاد شده است؟

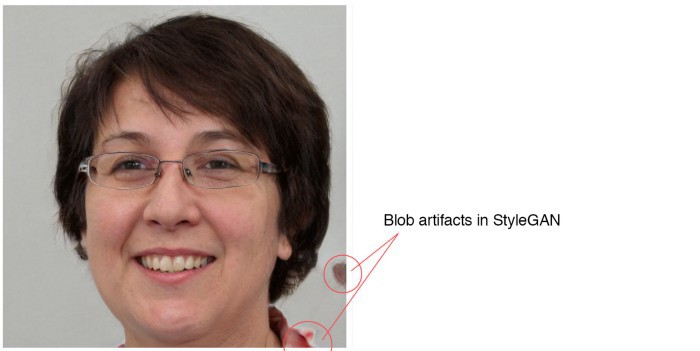

تشخیص اینکه کدام تصویر جعلی است بسیار ساده است. تصویر سمت چپ جعلی و ساختگی است چرا که در بسیاری از تصاویری که StyleGAN ایجاد میکند، آرتیفکت Artifacts به چشم میخورد. حالا تصاویر مقابل را مشاهده کنید.

تمامی تصاویر ستون سمت چپ جعلی و ساختگی هستند. نرخ دقت من در تشخیص تصاویر StyleGAN، 95% است. اما StyleGAN پیشرفته تر و در نتیجه تشخیص اینکه کدام تصویر جعلی است دشوارتر. تمامی تصاویر پیش رو جعلی هستند.

شبکههای مولد تخاصمی GAN و deep fake صرفاً به موضوعی برای تحقیق و پژوهش و یا وسیلهای سرگرمی برای مهندسان محدود نیستند. GAN و deepfake که در ابتدا مفهومی نوآورانه بودند، اکنون به ابزاری برای ارتباطات تبدیل شدهاند. با کلیک کردن بر روی این لینک میتوانید ویدئویی را مشاهده کنید که به طور گسترده به اشتراک گذاشته شده، در حالیکه این ویدئو با استفاده از Adobe After Effects و FakeAPP (یکی از نرمافزارهای کاربردی deep fake) ساخته شده است.

نواقص طراحی و پیادهسازی

طراحی و پیادهسازی همواره با نواقص و کاستیهایی همراه است. برای مثال، شیوه نرمالسازی نمونه Instance normalization method که در StyleGAN از آن استفاده میشود اغلب باعث ایجاد حبابهای آرتیفکت و پخششدن رنگ Color bleeding در تصاویر ایجاد شده میشود.

با این حال همانند سایر فنآوریهای GAN و deep fake، راهکارهایی برای حل این مشکل ارائه شده است. برای مثال، در تصاویر StyleGAN حبابهایی آرتیفکت ایجاد میشد، اما در StyleGAN 2 با بهرهگیری از شیوه تفکیک وزن Weight demodulation – و به عنوان روش جایگزین نرمالسازی – این مشکل حل شده است.

اگر با دقت به تصاویر StyleGAN 2 نگاه کنید باز هم نواقص و کاستیهایی میبینید. برای مثال، در تصویر مقابل، ساختار پسزمینه مناسب و صحیح نیست. به بیانی دقیقتر، ساختارهای ارائهشده حالات صحیح خطوط و اشکال را حفظ نمیکنند.

ایجاد و حفظ تقارن نیز امری دشوار است. برای مثال، ممکن است به یک گوش، گوشواره باشد و گوش دیگر گوشواره نداشته باشد. در تصویر مقابل، حالت شانه سمت راست همسو با شانه سمت چپ نیست.

مروری بر دیپ فیک

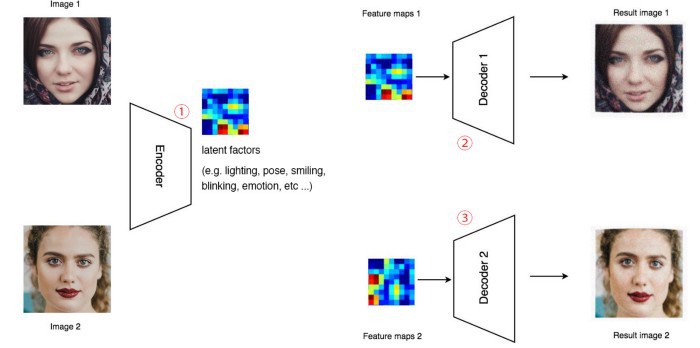

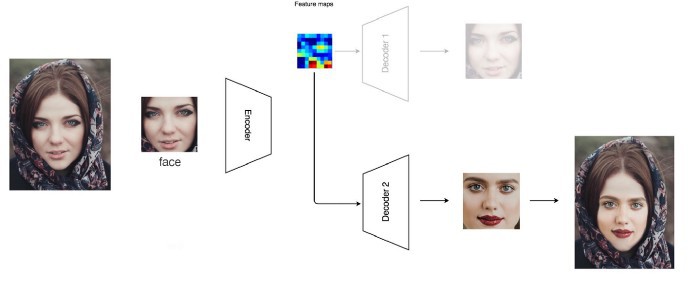

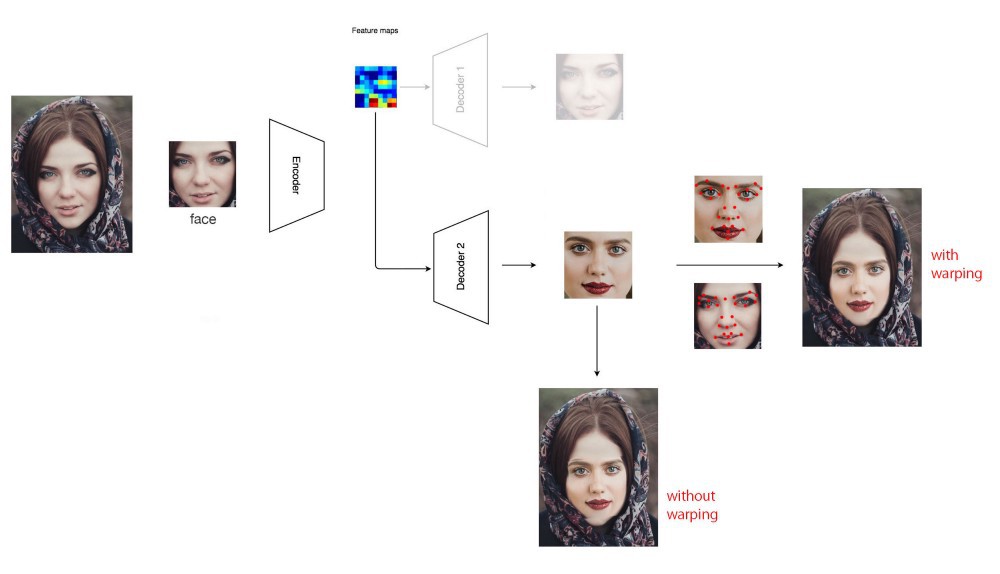

همانگونه که در تصویر مقابل مشاهده میکنید، در مرحله اول دیپ فیک یک رمزگذار Encoder معمولی میسازد تا ویژگیهای تصاویر دو فرد متفاوت را کدگذاری کند. در مرحله دوم و سوم، دیپ فیک دو رمزگشا مجزا میسازد تا تصویر اول و دوم را بازسازی کند. برای آنکه تصویر به درستی بازآفرینی شود، رمزگذار باید تمامی متغیرهای موجود در تصاویر یک فرد را ثبت کند؛ در اینجا منظور از متغیر ویژگیهایی است که دربردارنده اطلاعاتی همچون ژست، حالات، نور و غیره است.

حالا در یک ویدئو چهره مِری را با چهره اِمی جایگزین کنیم. ابتدأ ویژگیهای چهره مِری در این ویدئو را ثبت میکنیم و سپس آنها را با استفاده از رمزگذار سمت امی منتقل میکنیم. در نتیجه، چهره اِمی ژست، نور و روشنایی و حالات احساسی ویدئوی اصلی را خواهد داشت.

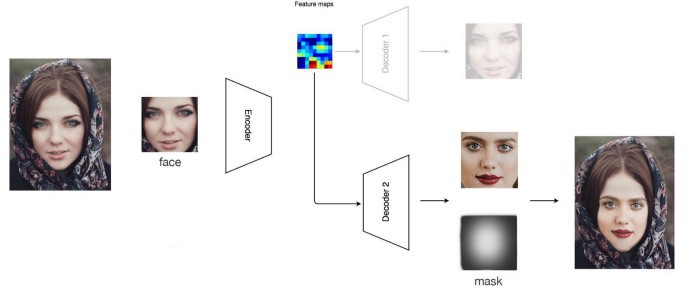

البته اگر این کار به درستی انجام نشود، شکل فرایند «بریدن و درج کردن» به خود میگیرد و در جایی که چهره درج شده بر روی خطوط و مرزها آرتیفکتها به وضوح آشکار خواهند بود.

برای حل این مشکل انکودر میتواند ماسکی را یاد بگیرد تا بهتر بتواند چهره جدید را با چهره اصلی ترکیب کند.

با این وجود، ادغام چهره جدید با چهره اصلی دشواریهایی به همراه دارد. جلوههای سایهاندازی Ghosting effects، تغییر شدت رنگ و مرزهای واضح جعلیبودن محصولات کم بودجه از جمله برخی ویدئوهای موجود در دیتاست DFDC را نشان میدهد.

نقاط راهنمای صورت

برای ارتقا کیفیت از تکنیک دیگری نیز میتوان استفاده کرد. جایگزین کردن صورت با استفاده از نقاط راهنما Face Landmarks

صورت پیش از روی کار آمدن فناوری هوش مصنوعی نیز انجام میشده است. بخشی از صورت بریده میشود و نقاط راهنمای آن با نقاط راهنمای چهره مقصد مطابقت داده میشوند.

به منظور کاهش وضوح مرزها محو گاوسی Gaussian blur اعمال میشود. اما احتمالاً رنگ پوست و میزان روشنایی دو تصویر با هم همخوانی نداشته باشند. همانگونه که پیش از این نیز گفتیم، با استفاده از دیپ فیک میتوان این مشکل را حل کرد.

برخی از پیادهسازیهای دیپ فیک، مشخصههای صورت را تشخیص میدهند و بر روی آن اعوجاج ایجاد میکند تا مطابق با مشخصههای چهره اصلی باشد و موجب میشود ژست بهتری ایجاد شود و با شکل و ابعاد چهره اصلی تطبیق بیشتری داشته باشد. به منظور کاهش وضوح مرزها فیلتر گاوسی اضافه میشود.

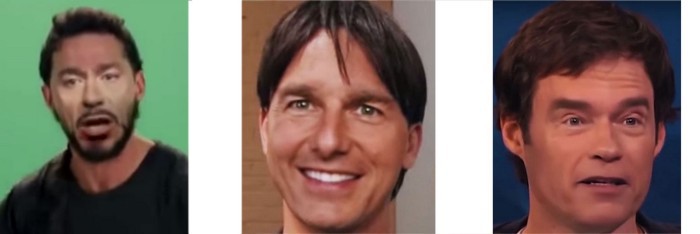

ابتدا محصولات کم بودجه دیپ فیک را با هم بررسی کنیم. در بسیاری از نسخههایی که بودجه بالایی دارند، هنوز نواقص و کاستیهایی مشاهده میشود اما تعداد آنها بسیار کمتر است.

نواقص و کاستیهای deep fake

تیره و تار

در بسیاری از ویدئوهای دیپ فیک، چهرهها به طور غیرمعمولی تیره و تار هستند. چهرهها به دو دلیل در این ویدئوها تیره و تار هستند. اول، چهره جدید باید به خوبی با باقی تصویر ترکیب و ادغام شود. از این روی فیلترهایی اعمال میشود که اندکی چهره را تیره و تار خواهند کرد. دوم، بسیاری از محصولات کم بودجه از تصاویر چهره که وضوح پایینی دارند برای آموزش انکودر استفاده میکنند. از آنجایی که همزمان با افزایش وضوح چهره، زمان آموزش هم افزایش پیدا میکند، استفاده از تصاویری با وضوح پایین باعث میشود از فضای GPU کمتر استفاده شود و علاوه بر آن زمان آموزش هم کاهش پیدا میکند. در ابتدا، بسیاری از محصولات کم بودجه از چهرههایی با وضوح 64×64 استفاده میکردند و در نتیجه چهرههایی تیره و تار به وجود میآمد.

از این روی، در زمان کنونی بسیاری از محصولاتی که بودجه بالایی صرف تولید آنها میشود با دقت بیشتری وضوح ورودی را انتخاب میکنند (اغلب ورودیهایی را انتخاب میکنند که وضوح بالاتری دارند). پس از آنکه ویدئو برای روزهای متوالی با استفاده از کارتهای گرافیک درجه یک High-end graphics cards آموزش دید، کیفیت آن به طرز قابل توجهی ارتقا پیدا میکند و تشخیص دیپ فیک دشوار میشود.

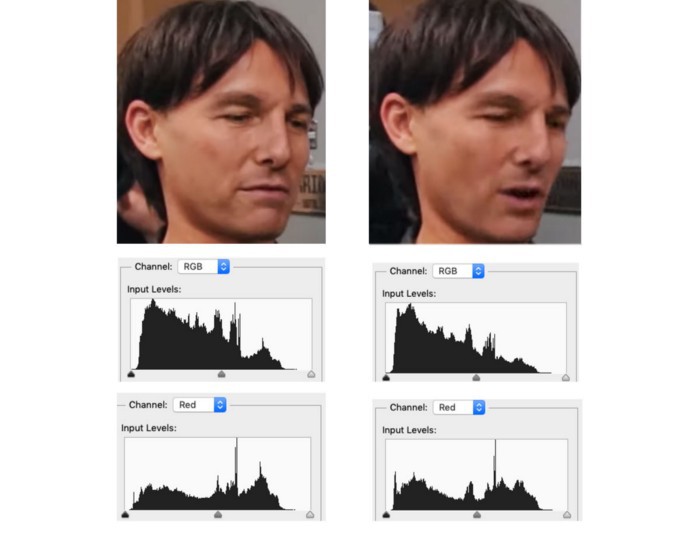

علاوه بر این میتوانیم میزان شفافیت یک تصویر Sharpness، نور و شدت رنگ Tone color را با سایر چهرههایی که در ویدئو نمایش داده میشوند مقایسه کنیم. اگر شخصیت دیگری که در ویدئو حضور دارد واقعی باشد، تشخیص تفاوتها به سادگی امکانپذیر است.

هرچند در ویدئویی که جردن پیل از اوباما منتشر کرده تنها یک فرد حضور دارد. در این ویدئو از ماسکها استفاده میشود تا ناحیه فک و دهان اوباما کمتر تغییر کند. سایر اجزای صورت تغییری نکردهاند و ثابت باقی ماندهاند. اما اگر به دقت ویدئو را تماشا کنید، متوجه میشوید که قسمت دهان نسبت به چشمها تارتر است.

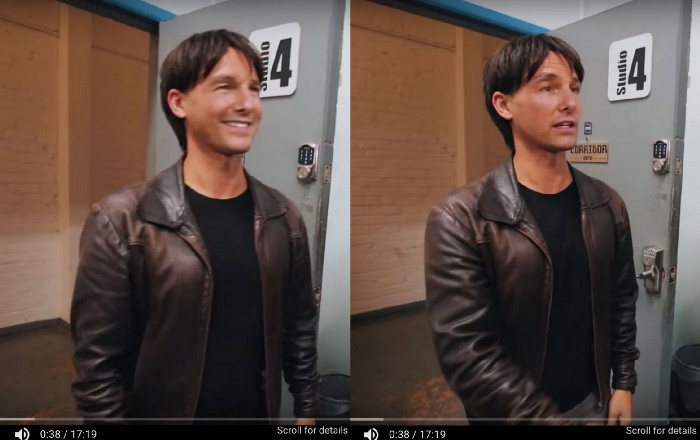

توجه داشته باشید که این مشکل فقط در محصولاتی مشاهده میشود که بودجه پائینی برای تولید آنها در نظر گرفته شده است. بسیاری از ویدئوهای دیپ فیک با چهرههایی با وضوح بالا آموزش میبینند و نتیجه تولید ویدئویی با کیفیت 1440p خواهد بود. هرچند در این حالت نیز چهرهها کمی تار هستند اما در مقایسه با ویدئوهایی که با کیفیت HD (740p) مشاهده میکنیم کیفیت بالاتری دارد. در این حالت، به دلیل کیفیت بالای چهرهها، این فکر کمتر به ذهن بیننده خطور میکند که شاید این ویدئوها ساختگی و جعلی باشند. اما در تصویر مقابل میتوانید قسمتهایی را مشاهده کنید که فیلتر گوسی به طور نامساوی اعمال شده و به همین دلیل میتوان نتیجه گرفت که تصویر دستکاری شده است.

هرچند ویدئوهایی هم وجود دارند که در آنها شخصیتهای اصلی آرایش سنگینی دارند و یا بیش از اندازه در معرض نور قرار دارند. اگر دیپ فیک به درستی آموزش ببیند تشخیص نواقص و کاستیهایی که در بالا به آنها اشاره شد، دشوار خواهد بود.

تصویری که در مقابل سمت چپ مشاهده میکنید یکی از ویدئوهای دیپ فیک با «بودجه بالا» است و وضوح تصویر آن بالا است (1440p). در این تصویر در مقایسه با نسخه HD (740p) جزئیات بیشتری به نمایش گذاشته شده و به دشواری میتوان نواقص و کاستیهایی که پیش از آن به آن اشاره کردیم (تیره و تار بودن) را در این تصویر تشخیص دهیم. با توجه به تصویر مقابل متوجه میشویم دیپ فیک چگونه میتواند بر نواقص و کاستیهای پیشین خود از جمله وضوح پایین، غلبه کند.

رنگ پوست

در برخی چهرههایی که جایگزین چهره دیگری شدهاند رنگ پوست غیرطبیعی به نظر میرسد.

یا شاید افراد مشهور جای مناسبی را برای برنزه کردن و حمام آفتاب گرفتن انتخاب نکردهاند؟!

برای حل این مشکل میتوان افرادی را انتخاب کرد که رنگ پوست، مدل مو و شکل صورت آنها مشابه شخصیتی اصلی است.

در تصویر مقابل، چهره پل راد با چهره جیمی فلن جا به جا شده است.

علاوه بر این، میتوانیم افرادی را انتخاب کنیم که در تقلید صدا، ژست و حالات افراد دیگر مهارت بالایی دارند. برای تماشای این ویدئو کلیک کنید.

دو ابرو

در صورتی که فرایند ترکیب و یا ماسکگذاری به درستی انجام نشود، در زمان ترکیب چهره جایگزین با چهره اصلی ممکن است در تصویر دو جفت ابرو ببینیم- یک جفت ابرو متعلق به چهره جدید و جفت دیگر متعلق به چهره اصلی.

دو چانه

علاوه بر این ممکن است در تصویر دو چانه مشاهده شود، اما اگر شخصیت اصلی حاضر در ویدئو را به خوبی نشناسید، تشخیص اینکه چانه متعلق به شخصیت اصلی است یا خیر دشوار است.

عدم انسجام بخشهای مختلف Spatial inconsistency

برای مشخص کردن ناهنجاریها و موارد غیرطبیعی چهره، ابتدا میتوانیم صورت را با سایر قسمتهای بدن مقایسه کنیم. بدیهی است که نمیتوانیم چهره یک بازیگر 60 ساله را جایگزین چهره یک بازیگر بیست و چند ساله کنیم. در تصویر مقابل چهره بازیگر دیگری جایگزین چهره جنیفر لارنس شده است. بافت پوست و لطافت بازوها با صورت همخوانی ندارد.

به بیانی دیگر برای اینکه تشخیص دهید تصویری اصلی است یا ساختگی، شدت رنگ، میزان شفافیت تصویر و بافت چهرههای جایگزینشده را با باقی فیلم و فریمی که در مقابل شما است مقایسه کنید.

در هنگام جستوجو برای ناهماهنگیهایی که میان قسمتهای مختلف تصویر وجود دارد میتوانید عدم انسجام زمانی را نیز جستوجو کنید.

تکان خوردن

یکی از ایرادات اصلی دیپ فیک ها این است که فریمهای ویدئو به صورت جداگانه و فریم به فریم تولید میشوند. تولید فریمهای ویدئو به صورت جداگانه و تک تک ممکن است منجر به تولید فریمهایی شود که به لحاظ شدت رنگ، نور و سایه با فریم قبلی تفاوتهای فاحشی داشته باشند. علاوه بر این در زمان بازپخش ویدئو، فریمها تکان میخورند. برای تماشای این ویدئو کلیک کنید.

برخی مواقع، کیفیت فریم جایگزین شده به حدی پایین است که فریمهایی که کیفیت پایینی دارند به صورت دستی یا خودکار حذف میشوند. در صورتی که تعداد زیادی از فریمها حذف نشود و بیننده هم دقت زیادی به خرج ندهد، متوجه عدم وجود برخی از فریمها نمیشود.

در مقابل دو تصویر مشاهده میکنید. هرچند دو تصویر مقابل در فاصله کوتاهی از یکدیگر نمایش داده شدهاند اما میزان شفافیت تصویر و شدت رنگ آن دو تفاوتهای فاحشی با یکدیگر دارد.

در نمودار مقابل دو فریم دیگر نمایش داده شده که توزیع رنگ RGB آنها با یکدیگر تفاوت دارد.

تصویر و روشنایی مرتعش و لرزان Shimmering

اگر این ویدئو را با سرعت 0.25 پخش کنید همزمان با تکان خوردن سر، پوست صورت هم تکان میخورد و شدت رنگ به صورت غیرطبیعی تغییر میکند.

در دیپ فیک حرکتهای سریع، ایجاد فریمهایی با صافی موضعی Temporal smoothness مناسب را با مشکل مواجه میکند. ممکن است دیکودر به اشتباه در ویژگیهای چهرههای فریمهای مجاور تغییرات زیادی اعمال کند. تنها راهحل رفع این مشکل این است که در تابع هزینه مدت دیگری اضافه کنیم تا در طول فرایند آموزش ارتعاش در تصاویر و تغییر رنگها را جبران کند ( و ممکن است برای انجام این کار مجبور شویم تغییرات به خصوصی در طراحی و پیادهسازی اعمال کنیم).

مرز

در دیپ فیک، برای آنکه بتوانید ویدئوهای جعلی را تشخیص دهید باید توجه ویژهای به برخی نواحی نشان دهید. یکی از این نواحی مرزهای صورت در جایی است که با چهره اصلی ترکیب شده است.

در ویدئوها و تصاویری که از اهمیت بالاتری برخوردار هستند، تشخیص و مشاهده آرتیفکتها دشوار است. در ماسکگذاری چهرههای جدید میتوان از الگوریتمهای بهتری استفاده کرد و یا به صورت دستی تغییراتی در آن اعمال کرد.

در مقابل تصویری از یک ویدئو با «بودجه بالا» را مشاهده میکنید. تصویر مقابل بینقص است و ایرادی ندارد مگر اینکه با دقت به زوایای صورت گیلیان اندرسون توجه کنید.

ویرایش ویدئو پس از اتمام فرایند تولید

به طور کلی افزودن دادههای آموزش برای برقرای تعادل میان زوایای چهره اصلی و چهره جایگزین یا ارتقا رنگ به صورت خودکار در طول فرایند آموزش بسیاری از آرتیفکتهایی را که در این مقاله به آنها اشاره کردیم، برطرف میکند. با این حال، پس از اتمام فرایند تولید با استفاده از یک ماسک میتوان ویدئو را ویرایش کرد و سایر نواقص و کاستیها را برطرف کرد.

دندان

یکی از اصلیترین ایراداتی که میتوان به ویدئوهای دیپ فیک وارد کرد، قسمت دندان است. بازسازی ناحیه کوچکی که ساختار مشخصی هم دارد برای دیکودر دشوار است. اغلب در ویدئوهای دیپ فیک دندانها تیره و تار هستند.

در موارد دیگر، دندانها نامرتب هستند و یا یکی از دندانها دراز و یا کوچک است.

متوجه شدم که در یکی از فیلمها دیکودر دندانهایی ایجاد کرده که تعداد آنها بیشتر از حد معمول است. برخی مواقع در ایجاد و نمایش دندانها از جلوه سایهاندازی زیاد استفاده میشود. و دندان در فریمهای مختلف فیلم، ظاهری متفاوت دارد. حتی در ویدئوهایی که «بودجه بالا»یی صرف تولید آنها شده و از کیفیت بالایی برخوردار هستند، ممکن است دندانها به درستی نمایش داده نشوند. همانگونه که در تصویر بالا مشاهده میکنید، چندین دندان به هم متصل شدهاند.

ژست

زمانیکه ویدئوهای دیپ فیک فیلم سکوت برهها را با فیلم اصلی مقایسه میکردم، متوجه شدم که چندین ثانیه از فیلم اصلی حذف شده است.

فریمی که از این فیلم حذف شده، شامل قسمتی است که دوربین فک آنتونی هاپکینز را نشان میدهد. به احتمال زیاد تهیهکننده به اندازه کافی از ویلم دفو فریم در اختیار نداشته تا به مدل دیپ فیک آموزش دهد صحنه را به درستی بازآفرینی کند. در نتیجه این صحنه را به صورت دستی ویرایش کرده است. در بسیاری از ویدئوهای دیپ فیک، کیفیت نمای نیمرخ بازیگر جایگزین به حدی پایین است که به آسانی میتوان تشخیص داد که ویدئو جعلی و ساختگی است.

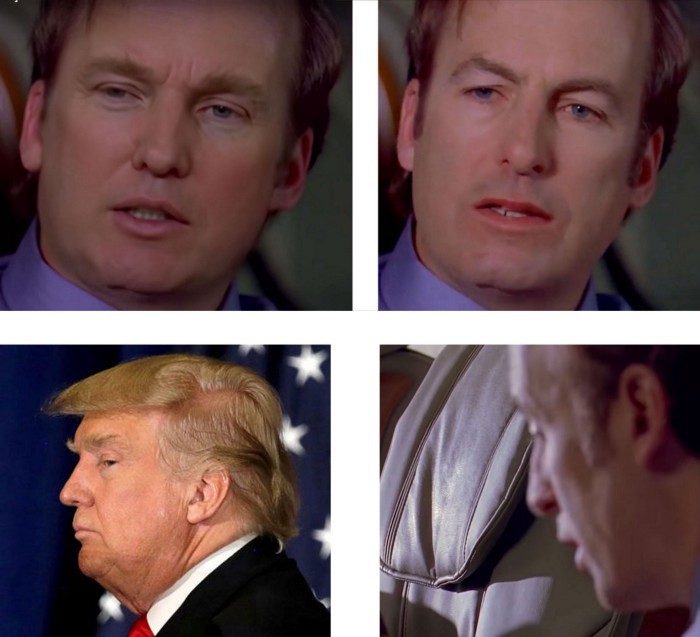

هرچند ویدئوهای دیپ فیک سریال «بریکینگ بد» در تقلید و جعل دونالد ترامپ بسیار موفق عمل کردهاند، اما کیفیت نمای نیمرخ (جانبی) چندان خوب نیست.

در هر حال در فرایند آموزش میتوان ویدئوفریمهای مرتبط را اضافه کرد و بر این مشکل غلبه کرد. در آینده بیشتر به این مبحث خواهیم پرداخت.

اشیای تار Obscure Objects

برخی اوقات اشیای تار و نامشخصی که پیرامون صورت جابهجا میشوند میتوانند مدل دیپ فیک را به اشتباه بیندازند. دلیل اصلی روی دادن چنین اتفاقی این است که به اندازه کافی داده به مدل تغذیه نمیشود تا اینگونه موقعیتها را به درستی یاد بگیرد. در یکی از ویدئوهای «بودجه بالای» دیپ فیک سریال «بریکینگ بد» قسمتی از تصویر حذف شده و باعث شده که چهره سمت چپ تار شود. به همین دلیل اغلب در ویدئوها به دنبال چهرههایی میگردم که مات و نامشخص هستند، وجود اینگونه چهرههای نشان میدهد که ویدئو جعلی و ساختگی است یا خیر.

درخشندگی و انعکاس

به نظر میرسد در برخی ویدئوهای دیپ فیک در میزان درخشندگی و انعکاس یا زیادهروی شده، یا اصلاً اعمال نشده و یا شدت و کیفیت مناسب را ندارند. یکی دیگر از ایراداتی که میتوان به دیپ فیک وارد کرد این است که در ایجاد و نمایش ساختارهای کوچک عملکرد مناسبی ندارد. در هر حال، این عامل باعث میشود که به فیلمهای واقعی – در مقایسه با ویدئوهای جعلی و ساختگی- اعتماد بیشتری داشته باشم.

عینک

در بسیاری از ویدئوهایی با «بودجه پایین»، دستههای عینک از تصویر حذف میشوند.

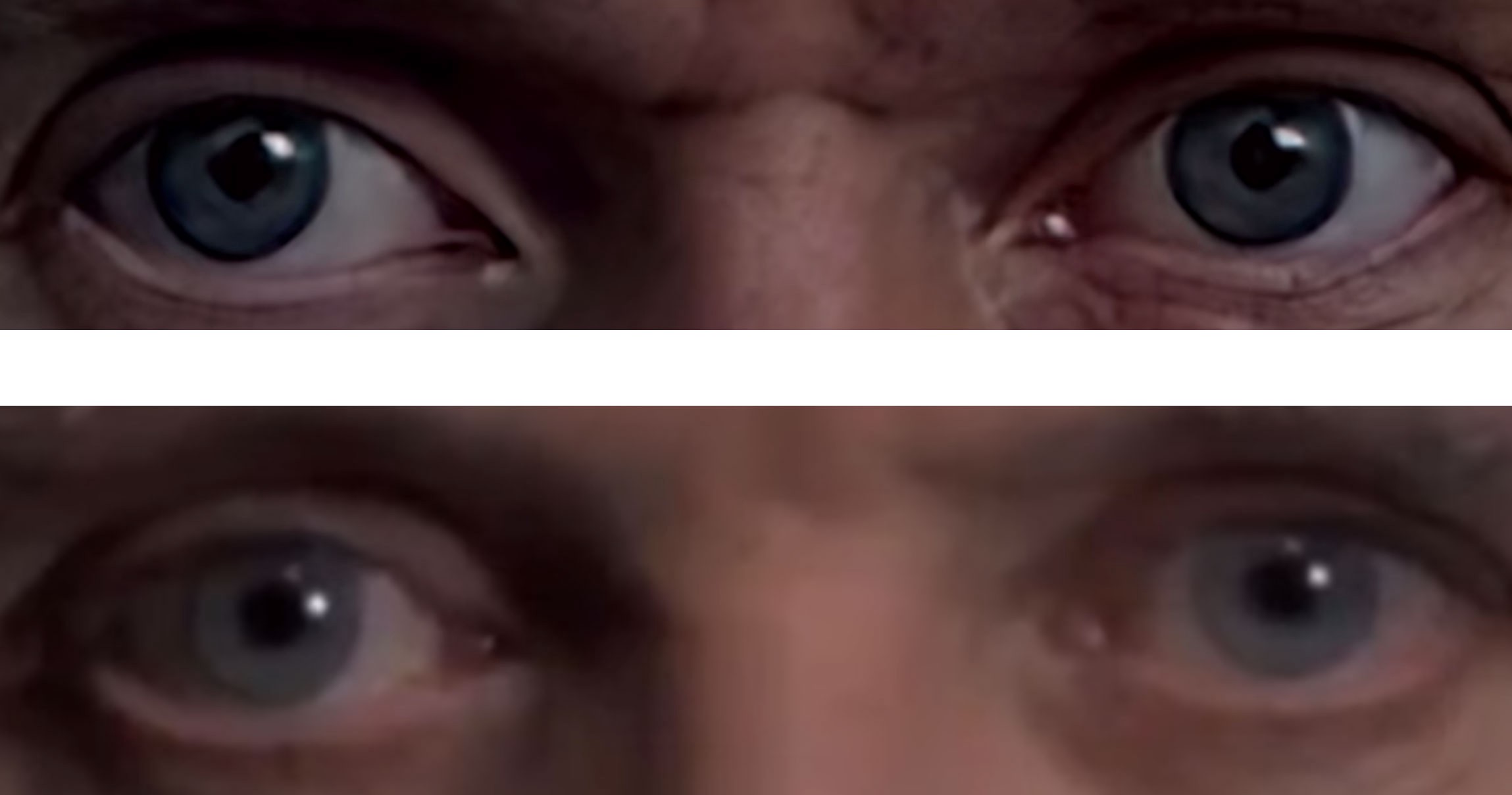

تنبلی چشم

کماکان از فریمهای 2-D برای ساخت مدلهای دیپ فیک استفاده میشود. عملیاتهایی همچون ایجاد اعوجاج ممکن است در طول فرایند از برخی اطلاعات 3-D غافل بمانند. برای مثال، ممکن است در ویدئوی دیپ فیک شاهد تنبلی چشم باشیم،

اما در ویدئوی اصلی نشانی از آن نباشد.

این مشکل میتواند در GAN روی دهد که در مقاله StyleGAN2 نیز راجع به آن توضیح داده شده:

«در این تصویر دندانها همسو با ژست نیستند اما همانگونه که با خط آبی نشان داده شده است، با دوربین در یک جهت قرار دارند.»

سیاستمداران و افراد مشهور

شکل و زاویه صورت

سیاستمداران و افراد مشهور جز کسانی هستند که بیش از سایرین در معرض جعل هویت (در تصاویر و ویدئوها) قرار دارند. معمولاً از deep fake در ویدئوهای مستهجن افراد مشهور استفاده میشود.

در حال حاضر در بسیاری از موارد، نمای کلی چهره را جایگزین نمیکنیم. از این روی، میتوانیم دیتابیسی متشکل از شخصیتهای مردمی ایجاد میکنیم تا بتوانیم ویدئوها و تصاویر ساختگی و جعلی را تشخیص دهیم. هرچند، فنآوریهای نوینتر ممکن است از GAN برای جایگزینی نمای کلی چهره استفاده کنند. اما استفاده از GAN برای جایگزینی نمای کلی چهره هنوز در مراحل اولیه به سر میبرد. لازم است یادآور شویم که برخلاف تصور بسیاری، dدیپ فیکها از GAN استفاده نمیکنند.

برای مثال، در ویدئوهای دیپ فیک فیلم «نابودگر» پیشانی بلند استالونه به خوبی نمایش داده نشده است.

ویدئوهایی با بودجه بالا

منظور از واژه ویدئوهایی با «بودجه بالا» ،که به دفعات در این مقاله به آن اشاره شد، لزوماً پروژههایی که سرمایههای هنگفتی صرف تولید آنها شده نیست. در مقاله پیشرو، واژه ویدئوهایی با «بودجه بالا» به پروژههایی اطلاق میشود که در ساخت و تولید آنها کارتهای گرافیک کامپیوتر با کیفیت بالا استفاده شده، مدت زمان ( روز) قابل قبولی به آموزش مدلهای اختصاص داده شده و علاوه بر آن افراد متخصص در ساخت و تولید آنها مشارکت داشتهاند. جمعآوری، انتخاب و پاککردن دیتاست آموزشی در سطح کیفیت پروژه نقش حیاتی دارد. کسب دانش تخصصی در این زمینه کار دشواری نیست. ویدئوهای آموزشی و ابزارهای رایگان بسیاری در اختیار علاقهمندان به این حوزه قرار دارد. برای یادگیری این حرفه ممکن است به آزمون و خطا نیاز داشته باشید اما نیازی به فراگیری دانش هوش مصنوعی نیست. ( هرچند کسب دانش در حوزه هوش مصنوعی ممکن است به شما کمک کند، اما راهنماهای بسیاری وجود دارند که میتوانند به شما کمک کنند.) اغلب پس از اتمام فرایند تولید به صورت دستی تغییراتی در ویدئو اعمال میشود تا ویدئویی با کیفیت عالی تولید شود. بسیاری از افرادی که تجربه ویرایش فیلم دارند میتوانند به سرعت این فرایند را فرا بگیرند.

در این مقاله، اینگونه به نظر میرسد که به آسانی با تماشای ویدئو میتوان جعلی یا واقعی بودن فیلم را تشخیص داد. اما این باور غلط است چرا که افراد دانش تخصصی بیشتری برای تولید جدیدترین ویدئوها کسب میکنند. برای تشخیص ویدئوهای deep fake یک راهحل واحد وجود ندارد. در هر ویدئو ایرادات و اشتباهات متفاوتی مشاهده میشود. بدتر از آن، اشتباهات کمتر روی میدهند و تشخیص آنها دشوارتر است. در مقالات بعدی، برخی روشهای برنامهای تشخیص ویدئوهای جعلی را با هم بررسی میکنیم. با بهرهگیری از دانشی که در این مقاله کسب کردهاید میتوانید این ویدئوها را تحلیل کنید و نکاتی که در این مقاله فرا گرفتهاید را بر روی آنها اعمال کنید.

اگر با دقت ویدئوها را تماشا کنید متوجه میشوید که یکی از فاحشترین اشتباهات در چشمها روی میدهد. در این ویدئوها مردک چشم دایرهشکل نیست.

همانگونه که پیش از این نیز گفتیم، با دقت به مرزها نیز میتوان ویدئوهای deep fake را تشخیص داد.

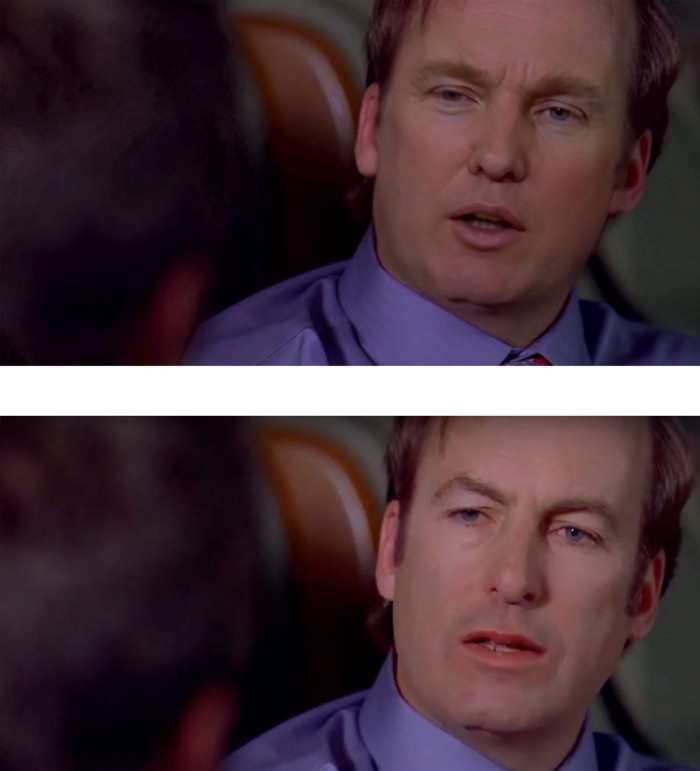

سریال بریکینگ بد

برای تماشای این ویدئو کلیک کنید.

چروک اطراف چشم با لطافت و صافی پیرامون چانه همخوانی ندارد. در بسیاری از ویدئوهای دیپ فیک افراد مشهور اغلب این مشکل روی میدهد. اما شاید جلسات بوتاکس افراد مشهور موفقیت آمیز نبوده است!

سایه یک طرف صورت غیر طبیعی است. و متأسفانه کاملاً نشان میدهد که ویدئو جعلی و ساختگی است.

علاوه بر این، ترس و وحشتی که در چهره نمایان است را به دشواری میتوان بازآفرینی کرد، چرا که جمعآوری دادهها (تصاویر) جرد کوشنر که در صورت وی ترس و وحشت دیده شود، دشوار است. در عوض، در فریمی که بازآفرینی شده فقط علامتهای تار و نامشخصی نمایش داده میشود.

برای تماشای یک ویدئوی ساختگی و جعلی دیگر، کلیک کنید.

و برای مشاهده ویدئوی اصلی بر روی این لینک کلیک کنید تا بتوانید ایرادات و مشکلات را تشخیص دهید.

ویدئوهایی با بودجه پایین

ما همان چیزی را باور میکنیم که میخواهیم باور کنیم. یک ویدئوی جعلی و ساختگی از نانسی پلوسی در اینترنت منتشر شده که به نظر میرسد نانسی پلوسی در آن فیلم حالت غیرطبیعی دارد و جویده جویده صحبت میکند. این ویدئو که کیفیت پایینی دارد با استفاده از deep fake تولید نشده است. در عوض، نما 25% کند شده و گامها تغییر کردهاند تا اینگونه به نظر برسد که وی جویده جویده صحبت میکند. درسی که در اینجا میتوانیم یاد بگیریم این است که ویدئوهای جعلی و ساختگی نیز میتوانند به صورت گسترده به اشتراک گذاشته شوند. محتواها با استفاده از الگوریتمها در شبکههای اجتماعی به اشتراک گذاشته میشوند و هیچ یک از این محتواها از استانداردهای روزنامهنگاری تبعیت نمیکنند. برای همین لازم است ابتدأ منبع را به دقت بررسی کنید. شبکههای اجتماعی منبع اطلاعاتی خوبی نیستند و نمیتوان به اطلاعاتی که در آنها منتشر میشود اعتماد کرد.

ویدئوهای جعلی و ساختگی اخبار حقیقی و واقعی را هم با مشکل مواجه میکنند. بارها شنیدهایم که سیاستمداران مدعی شدهاند که شایعاتی که راجع به آنها منتشر شده ساختگی و جعلی است. این شایعات پیش از روی کار آمدن دیپ فیک منتشر شده، اما دیپ فیک میتواند همه را به اشتباه بیندازد.

چک لیست بررسی دیپ فیک در ویدیوها و تصاویر

حالا دیگر نمیتوان تنها به نگاه بصری اعتماد کرد؛ بلکه لازم است مجموعهای از بررسیهای فنی، ظاهری و الگوریتمی انجام شود تا بهدرستی اصالت یک تصویر یا ویدیو ارزیابی گردد. چک لیستی را آماده کردهایم که میتوانید براساس آن پیش بروید تا عملیات تشخیص دیپ فیک و تصاویر جعلی را انجام دهید:

| معیار بررسی | نوع محتوا | توضیح |

| ناهماهنگی حرکت لب با صدا | ویدیو | لبها دقیق با گفتار هماهنگ نیستند. |

| جهت نور و سایه غیرطبیعی | تصویر/ویدیو | نور و سایه با موقعیت واقعی منبع نور مطابقت ندارند. |

| نرخ فریم نامنظم یا پرش تصویر | ویدیو | ویدیو ممکن است در برخی فریمها پرش داشته باشد یا نرخ فریم یکنواخت نباشد. |

| مرزهای غیرطبیعی اطراف چشم و دهان | تصویر/ویدیو | لبهها ممکن است مصنوعی، تار یا براق به نظر برسند. |

| بافت غیرعادی یا بیش از حد صاف پوست | تصویر | پوست ممکن است بدون منفذ یا بیش از حد نرم دیده شود. |

| عدم پلک زدن یا پلک زدن مکانیکی | ویدیو | پلک زدن ممکن است کم، کند یا غیرطبیعی باشد. |

| تطابق نداشتن انعکاس در چشم | تصویر | انعکاس نور در مردمک چشم با محیط سازگار نیست. |

| صدای بدون ریتم یا تن مصنوعی | ویدیو | صدا ممکن است یکنواخت، بیاحساس یا غیرطبیعی باشد. |

| نویز دیجیتال متفاوت در بخشهای تصویر | تصویر | بعضی نواحی ممکن است وضوح یا نویز متفاوتی نسبت به سایر بخشها داشته باشند. |

| اطلاعات EXIF و متادیتای دستکاریشده | تصویر | دادههای فایل ممکن است حاوی تغییرات مشکوک یا حذف اطلاعات اصلی باشد. |

| حرکت غیرعادی سر نسبت به بدن | ویدیو | چرخش یا موقعیت سر با حرکت بدن تطابق ندارد. |

| تطابق نداشتن زبان بدن با گفتار | ویدیو | حرکات بدن و دست با احساس و ریتم گفتار ناسازگار است. |

| استفاده از ابزارهای تشخیص خودکار | تصویر/ویدیو | ابزارهایی مثل Deepware یا Hive میتوانند بررسی اولیه انجام دهند. |

| نبود انعکاس در عینک یا اشیای براق | تصویر | اشیای براق باید انعکاس نور یا تصویر داشته باشند، نبود آن مشکوک است. |

| حرکات غیرطبیعی مو یا لباس در باد | ویدیو | حرکت مو و لباس ممکن است ساکن یا ناهماهنگ با محیط باشد. |

مشکلات دیپ فیک

فناوری دیپفیک مشکلاتی ایجاد کرده، اما بیشتر این نگرانیها جدید نیستند. یکی از اصلیترین دغدغهها، استفاده از دیپفیک برای دستکاری سیاسی است. این فناوری میتواند ویدیوهایی بسازد که بسیار واقعی به نظر میرسند و باعث گمراهی مردم میشوند. تا امروز، یکی از رایجترین کاربردهای دیپفیک، ساخت ویدیوهایی از سیاستمداران مشهوری مانند ترامپ یا الکساندرا اوکاسیو کورتز بوده که بهطور گسترده در شبکههای اجتماعی منتشر شدهاند. این موضوع نگرانکننده است، اما همانطور که «سامانتا کول» در سایت وایس گفته، ویدیوهای جعلی و گمراهکننده حتی قبل از دیپفیک هم با ابزارهای قدیمیتری ساخته میشدند.

بسیاری از کارشناسان این مشکلات را بررسی کردهاند، اما مسئله مهم دیگری وجود دارد که کمتر به آن پرداخته شده: تأثیر دیپفیک بر امنیت سایبری است. پیش از این هم گفته شده که پخش اطلاعات نادرست میتواند امنیت سازمانها را تهدید کند حالا با افزایش حملات فیشینگ، بهراحتی میتوان تصور کرد که بهزودی دیپفیکهایی ساخته میشوند که در آنها مثلا مدیرعامل شرکت از کارمندان رمز عبور یا اطلاعات حساس را درخواست میکند.

راه حل مقابله با دیپ فیک

برای مقابله با مشکلات ناشی از دیپفیک، دو راهحل اصلی پیشنهاد شده است: استفاده از فناوری برای شناسایی ویدیوهای جعلی و افزایش سواد رسانهای.

راهحل فنی شامل تلاش برای شناسایی دیپفیکها با استفاده از همان فناوری هوش مصنوعی است که برای ساخت این ویدیوها به کار میرود. به عنوان مثال، در آوریل گذشته، آژانس پروژههای تحقیقاتی پیشرفته دفاعی ایالات متحده (DARPA) سه قرارداد به گروه تحقیقاتی SRI International داده تا راههای بهتری برای تشخیص دیپفیک پیدا کنند. محققان دانشگاه آلبانی هم بودجهای از DARPA دریافت کردهاند تا به مطالعه دیپفیک بپردازند.

این تحقیقات بدون شک مهم است، اما سوالی که مطرح میشود این است: اگر یک ویدیو جعلی شناسایی شد، چه اتفاقی میافتد؟ چون در حال حاضر ویدیوهای زیادی که با ویرایش ساده منتشر شدهاند، بدون استفاده از دیپفیک هم اطلاعات نادرست را منتشر میکنند. دیپفیکها ممکن است واقعیتر به نظر برسند، اما اگر مردم به محتوای یک ویدیو باور داشته باشند، معمولاً به دنبال نشانههایی از جعلی بودن آن نمیروند.

بنابراین، نیاز به راهحل دیگری داریم. یکی از پیشنهادات این است که سواد رسانهای مردم افزایش یابد تا بتوانند «اخبار جعلی» را به راحتی شناسایی کنند. اما هنوز مشخص نیست که چگونه میتوان به این هدف دست پیدا کرد.

دیپفیکها معمولا چگونه استفاده میشوند؟

دیپفیکها در کاربردهای مختلفی به کار میروند که شامل موارد مثبت و منفی است:

هنر و سرگرمی: از دیپفیک برای خلق آثار هنری جدید یا در فیلمها و بازیهای ویدیویی برای شبیهسازی صدا و تصویر بازیگران استفاده میشود.

- باجگیری و آسیب به اعتبار: یکی از رایجترین استفادهها که برای انتقام یا آزار و اذیت سایبری به کار میرود.

- پشتیبانی و خدمات مشتری: دیپفیک در خدماتی مانند پاسخ به تماسها و پشتیبانی تلفنی مشتری برای انجام کارهای ساده مانند بررسی موجودی حساب استفاده میشود.

- کلاهبرداری و امنیت سایبری: دیپفیک برای جعل هویت افراد و دسترسی به اطلاعات حساس مانند شماره کارتهای اعتباری به کار میرود.

- اطلاعات نادرست و دستکاری سیاسی: ویدیوهای دیپفیک برای تغییر افکار عمومی یا تاثیرگذاری بر نتایج سیاسی یا اجتماعی استفاده میشود.

- کمپینهای تبلیغاتی و بازاریابی: برای کاهش هزینههای کمپینها، بازاریابان از دیپفیک برای تولید محتوای ویدیویی با استفاده از تصاویر دیجیتالی بازیگران استفاده میکنند.

- دستکاری سهام: دیپفیکها برای تاثیرگذاری بر قیمت سهام یک شرکت از طریق انتشار ویدیوهای جعلی از مدیران یا پیشرفتهای تکنولوژیکی به کار میروند.

- پیامک و تهدیدات هویتی: تهدیدات سایبری میتوانند از دیپفیک برای کپی کردن سبک پیامکی افراد و انجام کلاهبرداری استفاده کنند.

این فناوری در حال حاضر در بسیاری از زمینهها به کار میرود و میتواند تهدیدات مختلفی به همراه داشته باشد.

فناوریهای مقابله با دیپفیکها

شرکتها، سازمانها و نهادهای دولتی مانند آژانس پروژههای تحقیقاتی پیشرفته دفاعی وزارت دفاع ایالات متحده در حال توسعه فناوریهایی برای شناسایی و مسدود کردن دیپفیکها هستند. برخی از شبکههای اجتماعی از فناوری بلاکچین برای تأیید منابع ویدیوها و تصاویر قبل از انتشار آنها در پلتفرمهای خود استفاده میکنند. این کار به شناسایی منابع قابل اعتماد کمک کرده و از انتشار ویدیوهای جعلی جلوگیری میکند. شرکتهای متا و ایکس (که قبلاً به نام توییتر شناخته میشدند) استفاده از دیپفیکهای مخرب را ممنوع کردهاند.

بسیاری از شرکتها و سازمانها نرمافزارهایی برای محافظت در برابر دیپفیکها ارائه میدهند. از جمله این ابزارها:

- ادوبی: سیستمی برای سازندگان فراهم کرده که به آنها امکان میدهد امضای دیجیتال و اطلاعات مربوط به اثر خود را به ویدیوها و تصاویر اضافه کنند.

- Intel FakeCatcher: این سیستم با تجزیه و تحلیل تغییرات جزئی در پیکسلها و جریان خون، دقت بالایی در شناسایی دیپفیکها ارائه میدهد.

- مایکروسافت: نرمافزاری مبتنی بر هوش مصنوعی برای شناسایی دیپفیکها که ویدیوها و عکسها را تجزیه و تحلیل کرده و میزان اطمینان از واقعی بودن آنها را اعلام میکند.

- عملیات مینروا: از کاتالوگهای دیپفیکهای قبلی برای شناسایی ویدیوهای جدید استفاده کرده و از طریق اثر انگشت دیجیتالی، تشخیص میدهد که آیا ویدیو تغییرات جعلی دارد یا نه.

- هوش مصنوعی Sensity: پلتفرمی است که از یادگیری عمیق برای شناسایی نشانههای رسانههای جعلی استفاده میکند و کاربران را از محتوای جعلی آگاه میکند.

- سنتینل (Sentinel): یک پلتفرم مبتنی بر ابر که از روشهایی مانند بررسی زمان، تجزیه و تحلیل نشانههای چهره و تشخیص پلک زدن برای شناسایی دیپفیکها استفاده میکند.

آیا دیپ فیک قانونی است؟

دیپفیکها معمولا قانونی هستند، مگر اینکه قوانین خاصی مانند پورنوگرافی کودکان، افترا یا نفرتپراکنی را نقض کنند. با وجود تهدیدات جدی که این فناوری ایجاد میکند، بیشتر نیروی انتظامی نمیتواند بهطور مؤثر با آن مقابله کند. برخی ایالات در حال بررسی قوانینی هستند تا استفادههای مخرب دیپفیک را محدود کنند. بهعنوان مثال، پنج ایالت دیپفیکهایی که به انتخابات آسیب میزنند را ممنوع کردهاند و برخی دیگر در حال تصویب قوانینی برای ممنوعیت پورنوگرافی دیپفیک بدون رضایت هستند.

با این حال، چون بسیاری از مردم هنوز از خطرات دیپفیک آگاه نیستند، قربانیان در اکثر موارد حمایت قانونی لازم را دریافت نمیکنند. اخیرا تلاشهایی برای تصویب قوانینی مانند «قانون سرپیچی» و «قانون جلوگیری از جعل عمیق تصاویر خصوصی» در جریان است که هدف آنها محافظت از قربانیان دیپفیک و جرمانگاری برخی از سوءاستفادهها از این فناوری است. این قوانین به دنبال ایجاد یک چارچوب قانونی برای مقابله با تهدیدات دیپفیک و حمایت از حقوق افراد هستند.

سوالات متداول

چطور فناوری دیپ فیک میتواند بر امنیت سایبری تأثیر بگذارد؟

دیپفیکها میتوانند برای جعل هویت، دسترسی به اطلاعات حساس یا دور زدن سیستمهای احراز هویت استفاده شوند، که تهدید جدی برای امنیت سایبری است.

چگونه تشخیص دهیم که ویدیوی دیپ فیک است یا نه؟

بررسی دقیق ویژگیهایی مانند حرکت غیرطبیعی چشم، لبخوانی نادرست، یا برشهای غیرطبیعی در صدا و تصویر میتواند نشاندهنده جعلی بودن ویدیو باشد.

آیا دیپ فیکها میتوانند به امنیت فردی آسیب بزنند؟

بله، دیپفیکها میتوانند با جعل هویت افراد در ویدیوهای تماس یا حتی فایلهای صوتی تهدیداتی جدی برای امنیت فردی و اجتماعی ایجاد کنند.

منابع