نگاهی به چالشها و مرزهای فناوری هوش مصنوعی

محدودیت هوش مصنوعی؛ کارهایی که این فناوری نمیتواند انجام دهد!

ایده ایجاد فناوری شبیه انسان پس از جنگ جهانی دوم، زمانی که دانشمندان کشف کردند که ماشینها چیزی بیش از سیستمهای محاسباتی هستند، ظهور کرد. آنها دریافتند که ماشینها میتوانند وظایفی مانند انسان انجام دهند و آیندهای را پیشبینی کردند که در آن فناوری و انسان دستبهدست هم دهند. اگرچه ایدئولوژی آنها شجاعانه بود، اما راه را برای رباتیک مدرن هموار کرد.

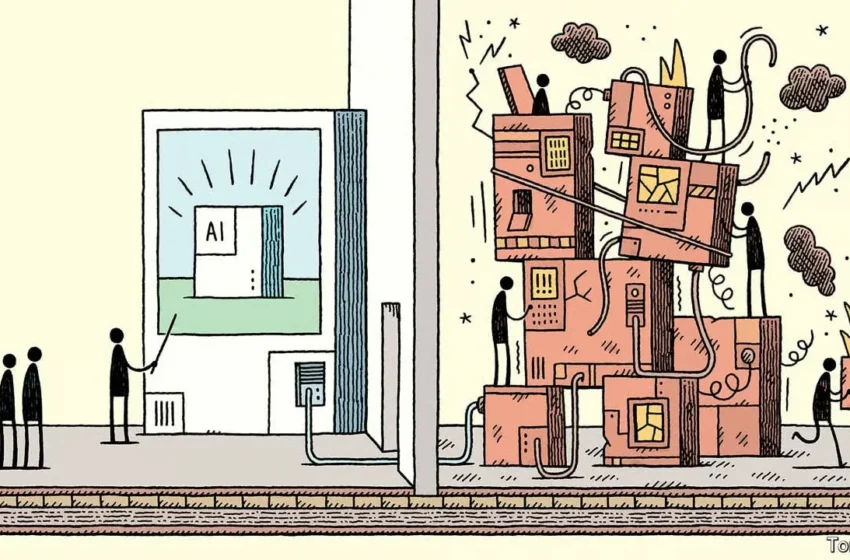

در چند سال اخیر هوش مصنوعی به یکی از پرکاربردترین و جذابترین واژههای جهان فناوری و سیاستگذاری علمی بدل شده است. در رسانهها، دانشگاهها و شرکتهای نوآور، هر روز خبرهای تازهای از دستاوردهای حیرتآور این فناوری منتشر میشود. اما همین هیاهوی رسانهای و شتاب علمی گاه باعث میشود تصویری بیش از اندازه خوشبینانه از آینده این فناوری در ذهن عموم شکل بگیرد. بسیاری تصور میکنند هوش مصنوعی در حال رسیدن به سطحی از هوش انسانی است که میتواند در آیندهای نزدیک جایگزین انسان شود؛ درحالیکه واقعیت پیچیدهتر است. هوش مصنوعی پیشرفتهای شگفتانگیزی داشته، اما همچنان با محدودیتهای بنیادین و عمیقی مواجه است.

محدودیتهای فنی و فناورانه

وابستگی به داده

هوش مصنوعی اساساً «دادهمحور» است. الگوریتمهای یادگیری ماشین و شبکههای عصبی برای یادگیری نیازمند مجموعههای عظیم داده هستند. هرچه دادهها کاملتر، متنوعتر و دقیقتر باشند، عملکرد مدل نیز بهبود میابد. اما اگر دادهها ناقص یا دارای سوگیری باشند، نتایج به همان اندازه ناقص و گمراهکننده خواهند بود.

نیاز به توان پردازشی عظیم

مدلهای پیشرفته مانند GPT-5 تنها با استفاده از ابررایانهها و هزاران پردازنده گرافیکی قابلآموزش هستند. طبق برخی گزارشها، آموزش GPT-3 بیش از ۳۵۵ گیگاوات ساعت انرژی مصرف کرده که معادل مصرف سالانه برق هزاران خانوار است. این هزینههای سنگین سختافزاری و انرژی باعث میشوند توسعه چنین مدلهایی در انحصار چند شرکت بزرگ باقی بماند و از منظر زیستمحیطی نیز پرسشبرانگیز باشد.

مشکل تعمیمپذیری

بسیاری از مدلها در یک حوزه خاص عملکرد فوقالعاده دارند، اما وقتی به شرایط متفاوتی منتقل میشوند، دچار خطا میشوند. مثلاً سامانههای تشخیص تصویر که با دادههای شهری آموزشدیدهاند، در محیطهای روستایی یا کشورهای دیگر بهسرعت دقت خود را از دست میدهند. این ضعف تعمیمپذیری نشان میدهد هنوز فاصله زیادی با «هوش جامع مصنوعی» (AGI) داریم.

جعبه سیاه بودن الگوریتمها

شبکههای عصبی عمیق مانند یک «جعبه سیاه» عمل میکنند که ورودی داده و خروجی پیشبینی را نشان میدهند و سازوکار درونی تصمیمگیری آن هنوز برای انسان قابلدرک نیست. در حوزههایی مانند پزشکی چنین عدم شفافیتی میتواند فاجعهبار باشد. به همین دلیل، حوزهای نوظهور به نام «هوش مصنوعی تفسیرپذیر» (Explainable AI) ایجاد شده که میکوشد الگوریتمها را شفافتر کند.

آسیبپذیری در برابر حملات

هوش مصنوعی، بهویژه مدلهای یادگیری عمیق، در برابر حملات تخاصمی (Adversarial Attacks) آسیبپذیر است. این حملات شامل دستکاریهای ظریفی در ورودیهای مدل (مانند تصویر یا صدا) هستند که برای انسان غیرقابلتشخیصاند اما میتوانند مدل را به اشتباه بیندازند. بهعنوانمثال، افزودن نویزهای نامحسوس به یک تصویر میتواند باعث شود که یک مدل تشخیص تصویر، یک گربه را بهعنوان یک سگ شناسایی کند.

تهدید حریم خصوصی

جمعآوری انبوه دادههای کاربران برای آموزش الگوریتمها تهدیدی جدی برای حریم خصوصی است. حتی اگر دادهها ناشناسسازی شوند، با ترکیب چند منبع داده امکان بازشناسایی هویت افراد وجود دارد. رسوایی کمبریج آنالیتیکا نمونه بارزی از چنین مخاطراتی است.

اختراعنکردن

از نظر علمی، جامعه بشری از طریق یک تکامل آهسته از میمون به انسان تبدیل شد. در راه تبدیلشدن به آنچه امروز هستیم، بر اساس نیازهایمان چیزهای زیادی اختراع کردیم. اگرچه ماشینها برای تقلید از انسان ساخته شدهاند، اما نمیتوانند چیزی را از اراده خود اختراع کنند. به بیان دیگر، محدودیتهای گستردهای در زمینه خلاقیت هوش مصنوعی در رفع نیازهای جدید و تعریف نشده وجود دارد.

تجربه

انسانها در حین رشد چیزهایی را آموختند و اختراع کردند. اما هوش مصنوعی متفاوت است. ماشینها از طریق آموزش با دادهها، فرایند یادگیری را انجام میدهند که این امر بهنوعی محدودیت هوش مصنوعی در یادگیری از تجربه را نشان میدهد. البته امروزه متخصصان هوش مصنوعی بر رفع این محدودیت بسیار متمرکز شده و به دنبال طراحی سیستمهایی هستند که بتوانند به طور خودکار از تجربیات خود بیاموزند که تا حدودی هم در این زمینه پیشرفت داشتهاند. مدلها و روشهایی چون شبکههای مولد تخاصمی (GAN) و یادگیری تقویتی نمودی از این موارد هستند.

محدودیتهای شناختی و نظری

فقدان درک واقعی

هوش مصنوعی در سطحی بالا قادر به تقلید رفتارهای زبانی انسان است، اما این به معنای درک واقعی نیست. مدلهای زبانی بزرگ مانند ChatGPT میتوانند جملات زیبا و منطقی تولید کنند، اما از معنای آنها بیاطلاعاند. این تفاوت میان «تقلید» و «فهم» شکاف مهمی است که مرز میان هوش انسانی و ماشین را مشخص میکند.

ناتوانی در استدلال پیچیده

اگرچه هوش مصنوعی در انجام وظایف خاص مانند حل مسائل ریاضی یا بازیهای استراتژیک مانند شطرنج بسیار موفق است، اما در استدلالهای پیچیده و چندمرحلهای که نیاز به ترکیب دانش از حوزههای مختلف دارند، ضعف دارد. بهعنوانمثال، یک مدل هوش مصنوعی ممکن است نتواند بهخوبی یک انسان، یک مشکل چندوجهی مانند طراحی یک سیاست عمومی را حل کند، زیرا فاقد توانایی تلفیق اطلاعات از زمینههای اجتماعی، اقتصادی و فرهنگی است.

محدودیت در خلاقیت

هرچند هوش مصنوعی میتواند آثار هنری، موسیقی یا متون خلاقانه تولید کند، اما این خلاقیت بیشتر نتیجه تقلید از الگوهای موجود در دادههای آموزشی است تا خلق چیزی کاملاً نوآورانه. بهعنوانمثال، یک مدل تولید تصویر مانند DALL-E میتواند تصاویر خیرهکنندهای خلق کند، اما این تصاویر معمولاً ترکیبی از عناصری هستند که مدل قبلاً در دادههای آموزشی دیده است. این محدودیت باعث میشود که هوش مصنوعی در مقایسه با خلاقیت انسانی که اغلب از شهود و تجربیات شخصی سرچشمه میگیرد، در سطح پایینتری قرار گیرد.

فقدان عقل سلیم

عقل سلیم یعنی توانایی درک موقعیتهای روزمره به شکلی شهودی. انسانها بدون نیاز به محاسبات پیچیده میفهمند که لیوان پر آب نباید وارونه روی میز قرار گیرد، اما بسیاری از الگوریتمهای بینایی ماشین در چنین موقعیتهایی دچار خطا میشوند. نبود عقل سلیم یکی از اساسیترین محدودیتهای هوش مصنوعی است.

مسئله خودآگاهی

حتی پیشرفتهترین مدلها فاقد خودآگاهیاند. آنها «میدانند» که چگونه الگوها را پردازش کنند، اما نمیدانند که «میدانند». این شکاف بنیادین پرسشی مهم در فلسفه ذهن ایجاد کرده است: آیا امکان دارد روزی ماشینها به خودآگاهی برسند؟

مسئله اعتماد

مردم زمانی به فناوری اعتماد میکنند که مطمئن باشند عادلانه و شفاف عمل میکند. اما باتوجهبه خطاها، سوگیریها و جعبه سیاه بودن الگوریتمها، اعتماد عمومی به هوش مصنوعی همچنان شکننده است.

محدودیتهای حقوقی و نظارتی

فناوری با سرعتی فراتر از توان قانونگذاران پیش میرود. بسیاری از کاربردهای هوش مصنوعی در خلأ حقوقی قرار دارند. بهعنوانمثال، قوانین روشنی برای مالکیت آثار تولیدشده توسط هوش مصنوعی وجود ندارد.

در یک نگاه

هوش مصنوعی بیتردید یکی از مهمترین دستاوردهای قرن بیست و یک است؛ فناوریای که میتواند ساختارهای اقتصادی، علمی و اجتماعی را به طور بنیادین دگرگون کند. اما همان قدر که تواناییهای آن چشمگیر است، محدودیتهایش نیز عمیق و جدیاند. این محدودیتها تنها موانع فنی نیستند؛ بلکه ابعاد اخلاقی، حقوقی، اجتماعی، فرهنگی و فلسفی نیز دارند. شناخت دقیق این مرزها کمک میکند انتظارات واقعبینانهتری از هوش مصنوعی داشته باشیم، خطرات را کاهش دهیم و فرصتها را به شکلی مسئولانه بهرهبرداری کنیم. آینده هوش مصنوعی نه در شیفتگی مطلق و نه در ترس بیپایه است، بلکه در رویکردی متوازن، آگاهانه و انسانمحور نهفته است.