مدل جدید تبدیل متن به تصویر: این صندلی آووکادو آینده هوش مصنوعی را رقم میزند

به تازگی شرکت OpenAI با استفاده از مدل GPT-3 نشان داد که یک مدل یادگیری عمیق را میتوان به سادگی و با دادن مقادیر زیادی نوشته برای تبدیل متن به تصویر آموزش داد. همچنین آنها نشان دادند که با جایگزینکردن متن با پیکسل، میتوان از همین روش برای آموزش هوش مصنوعی برای تکمیل تصاویر نیمهتمام استفاده کرد. GPT-3 چگونگی استفاده انسان از کلمات را تقلید میکند. همچنین Image GPT-3 آنچه را میبینیم پیشبینی میکند.

اکنون OpenAI دو مدل جدید به نام DALL · E و CLIP ساخته است که زبان و تصاویر را به گونهای ترکیب میکند که هوش مصنوعی را در درک کلمه و آنچه که به آن اشاره میکنند یاری میکند.

ایلیا ساتسکور، دانشمند ارشد OpenAI میگوید:«ما در یک جهان بصری زندگی میکنیم. در طولانی مدت، شما مدلهایی خواهید داشت که متن و تصویر را درک میکنند و در نتیجه در تبدیل متن به تصویر موفق عمل خواهند کرد. هوش مصنوعی میتواند زبان را بهتر درک کند زیرا قادر است معنی کلمات و جملات را بفهمد.»

برخی اوقات خروجی GPT-3، میتواند از واقعیت دور باشد. محققان OpenAI و جاهای دیگر در تلاشند تا با قراردادن متن در تصاویر، به مدلهای زبانی فهم بهتری از مفاهیم روزمرهای که انسانها برای درککردن استفاده میکنند بدهند.

DALL · E و CLIP از جهات مختلف با این مشکل روبرو میشوند. در نگاه اول، CLIP (Contrastive Language-Image Pre-Training) یک سیستم شناسایی تصویر دیگر است. با این تفاوت که این سیستم مانند دیگر مدلهای موجود برای شناسایی تصاویر از نمونههای برچسبدار موجود در پایگاه داده استفاده نمیکند؛ بلکه از تصاویر موجود در اینترنت و عناوین آنها استفاده میکند. در این روش مدل به جای اینکه از یک برچسب یک کلمهای مانند «گربه» یا «موز» به تصویر پی ببرد از توصیف آنچه در تصویر است آن را میآموزد.

کاربرد CLIP

CLIP آموزش داده میشود تا پیشبینی کند که کدام عنوان که از بین 32،768 عنوان دیگر به صورت تصادفی انتخاب شده برای عکس داده شده مناسب است. برای حل این مسئله، CLIP میآموزد که طیف گستردهای از اشیا را با نام و کلمات توصیفکننده آنها پیوند دهد. سپس مدل اجازه میدهد تا اشیا موجود در تصاویری که خارج از دیتاست هستند را شناسایی کند. بیشتر سیستمهای تشخیص تصویر برای شناسایی انواع خاصی از اشیا مانند چهره در فیلمهای مداربسته یا ساختمانهای موجود در تصاویر ماهوارهای آموزش دیدهاند. مانند GPT-3 ،CLIP میتواند بدون آموزش اضافی، وظایف را تعمیم دهد. همچنین این مدل کمتر از سایر مدلهای پیشرفته شناسایی تصویر توسط نمونههای تخاصمی گمراه میشوند. این نمونهها به طرز ماهرانهای تغییر کردهاند به گونهای که الگوریتمها را معمولاً طوری فریب میدهند که حتی انسانها نیز متوجه آن نمیشوند.

از سوی دیگر DALL · E نوعی از شبکه های عصبی است که میتواند بر اساس ورودی در تبدیل متن به تصویر موفق باشد. در واقع این سیستم به جای شناسایی تصاویر آنها را ترسیم میکند. این مدل نسخه کوچکتری از GPT-3 است که همچنین در مورد جفت تصویر- متنی که از اینترنت گرفته شده آموزش دیده است. یک عنوان کوتاه را که برای توصیف عکس به کار می رود در نظر بگیرید. برای مثال «نقاشیای از یک خوکچه نشسته در یک مزرعه هنگام طلوع آفتاب» یا «یک نمای مقطعی از یک گردو».

DALL · E با همین کپشنها تصاویر زیادی را ایجاد میکند که با آنها مطابقت دارند. دهها خوکچه از همه اشکال و اندازهها در مقابل زمینههای نارنجی و زرد و ردیفهایی از گردو.

تبدیل متن به تصویر، چالشی تحقیقاتی

مارک ریدل، که در حوزه پردازش زبان طبیعی و خلاقیت محاسباتی در انستیتوی فناوری جورجیا در آتلانتا کار میکند میگوید:«تبدیل متن به تصویر یک چالش تحقیقاتی است که مدتهاست وجود داشته است. اما این یک نمونه قابل توجه است.»

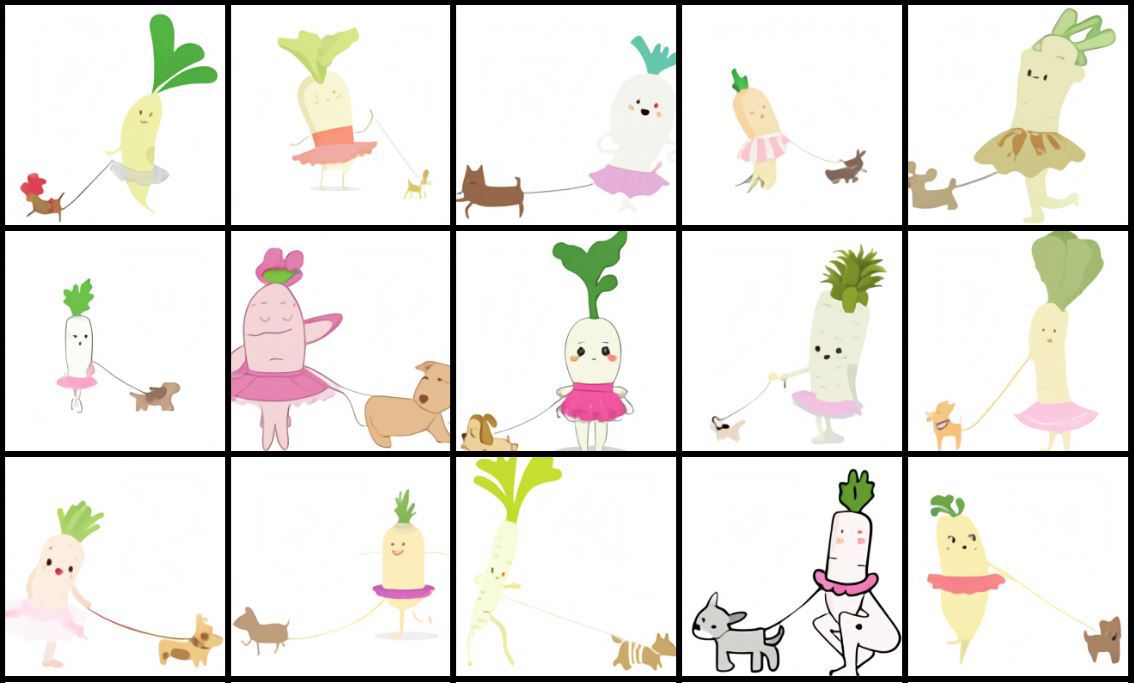

برای آزمایش توانایی DALL · E در کار با مفاهیم نو، محققان عنوانهایی را به مدل دادند که توصیفکننده اشیائی بود که مدل تا پیش از این با آنها آشنا نبوده است. مانند «صندلی آووکادو» و «تصویری از تربچه در حال راه رفتن با یک سگ» که در هر دو مورد، هوش مصنوعی تصاویری ایجاد کرد که این مفاهیم را به روشهای قابل قبولی تلفیق میکرد.

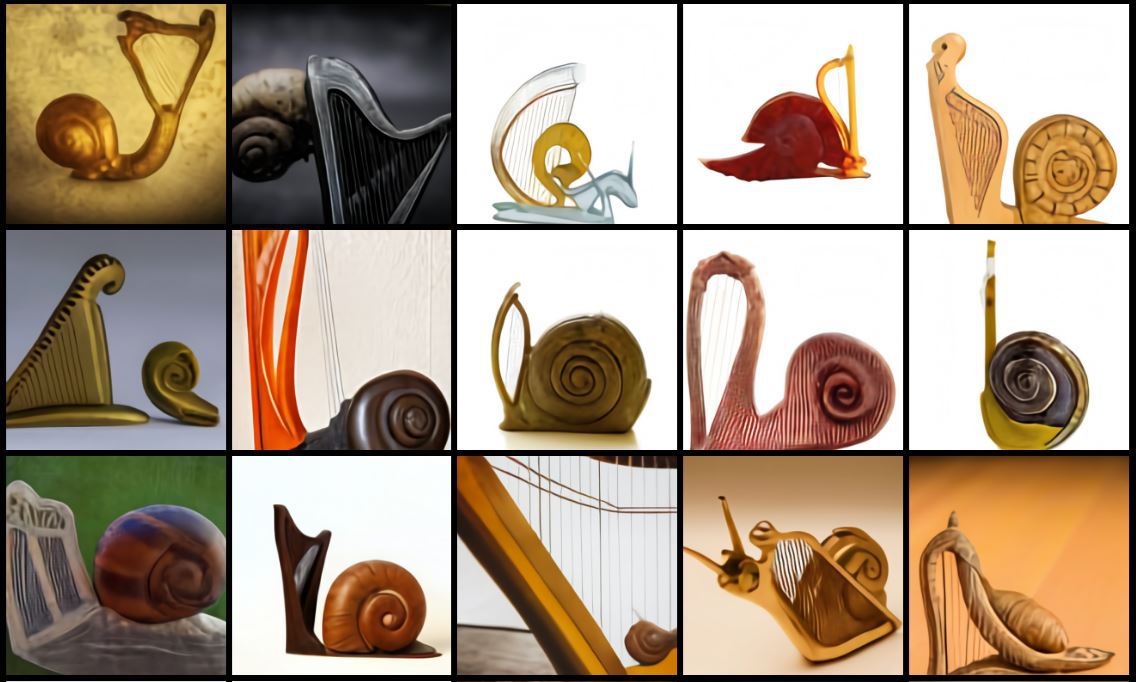

در خصوص صندلیهای راحتی خروجی شبیه صندلی و آووکادو بود. آدیتیا رامش که در DALL · E کار میکرد میگوید: «چیزی که بیشتر مرا متعجب کرد این است که مدل میتواند دو مفهوم غیر مرتبط را بگیرد و آنها را به گونهای کنار هم بگذارد که منجر به نوعی عملکرد شود.» این احتمالاً به این دلیل است که یک آووکادوی نصف شده کمی شبیه صندلیای است که پشت آن بالا آمده و گودال آن به عنوان بالش است. در مورد یک عنوان دیگر که حلزون ساخته شده از چنگ بود باز هم نتایج قابل قبولی به دست آمد و مدل به خوبی توانست این دو مفهوم را با هم ترکیب کند.

جایگزین آزمون Lovelace 2.0

ریدل تصور میکند این سیستم میتواند جایگزین آزمون Lovelace 2.0 شود که خود آزمایشی است که در سال 2014 ارائه داده شد و جایگزینی برای آزمون تورینگ شد که به عنوان معیار سنجش هوش مصنوعی شناخته میشود. ریدل میگوید درخواست از کامپیوتر برای رسم تصویر مردی که یک پنگوئن را در دست دارد نسبت یه اینکه از چت بات بخواهیم انسان را در مکالمه فریب دهد آزمون بهتری است. ریدل میگوید: «محک واقعی این است که تا چه حد میتوان هوش مصنوعی را در خارج از چهارچوب خود امتحان کرد.»

آنی کمباوی که در موسسه آلن برای هوش مصنوعی (AI2) مشغول به کار است و خود او نیز سیستمی را برای تبدیل متن به تصویر تولید کرده، میگوید: «توانایی این مدل در تبدیل متن به تصویر مصنوعی نسبتاً عجیب و بسیار جالب به نظر میرسد.»

از سوی دیگر برخی ابهامات در مورد این سیستم وجود دارد. به طور مثال نشانههایی وجود دارد که DALL · E به جای تبدیل متن به تصویر ابداعی از تصاویری که در اینترنت موجودند استفاده میکند.

ریدل میگوید: «من کمی به مثال تربچه مشکوک هستم. ممکن است این تصاویر از اینترنت برداشته شده باشند.» وی خاطرنشان کرد که با یک جستجوی سریع میتوان بسیاری از تصاویر کارتونی از تربچههای انسانی را مشاهده کرد. او میگوید: «اساسا GPT-3، که DALL · E بر اساس آن ساخته شده است به این مشهور است که حافظه قوی دارد.»

با این حال ساتسکور میگوید: «آینده در دست اینچنین سیستمهایی خواهد بود و هر دوی این مدلها گامی به سوی آن سیستم هستند.»

جدیدترین اخبار هوش مصنوعی ایران و جهان را با هوشیو دنبال کنید