ادعای اول بودن علیبابا با مدل ریاضی Qwen2-Math

اگر تاکنون نام «Qwen2» را نشنیدهاید، تعجبآور نیست، اما با انتشار مدل جدید و شگفتانگیزی شرکت علیبابا باید کمکم این نام را بیشتر بشنویم، مدلی که با مزیتهایی که دارد میتواند به زودی در مهندسی و کاربردهای فنی دیگر تحول بزرگی ایجاد کند.

Qwen2 چیست؟

سرعت ظهور مدلهای هوش مصنوعی جدید از سوی استارتآپها و شرکتهای فناوری، آنقدر بالاست که حتی برای افرادی که به دقت این فضا را دنبال میکنند، همگام ماندن با آنها دشوار است.

Qwen2 یک مدل زبانی بزرگ (LLM) بازمتن است که رقیبی برای GPTهای OpenAI، Llamaهای متا و خانواده Claude آنتروپیک محسوب میشود، اما توسط علیبابا کلود، بخش ذخیرهسازی ابری غول تجارت الکترونیک چینی علیبابا، ارائه شده است.

علیبابا کلود در آگوست ۲۰۲۳ شروع به انتشار LLMهای خود تحت نام فرعی «Tongyi Qianwen» یا به اختصار Qwen کرد، از جمله مدلهای بازمتن Qwen-7B، Qwen-72B و Qwen-1.8B با پارامترهای ۷۲ میلیارد و ۱.۸ میلیارد، به دنبال آن انواع چند حسی شامل Qwen-Audio و Qwen-VL (برای ورودیهای بصری) و در نهایت Qwen2 در اوایل ژوئن ۲۰۲۴ با پنج نوع مختلف: 0.5B، 1.5B، 7B، 14B و 72 B. در مجموع، علیبابا در این مدت بیش از ۱۰۰ مدل هوش مصنوعی با اندازهها و عملکردهای مختلف در خانواده Qwen منتشر کرده است.

و مشتریان، به ویژه در چین، متوجه این موضوع شدهاند، بهطوری که گزارش شده است بیش از ۹۰ هزار شرکت در سال اول عرضه از مدلهای Qwen در عملیات خود استفاده کردهاند.

در حالی که بسیاری از این مدلها هنگام انتشار خود دارای عملکرد پیشرفته یا نزدیک به آن بودند، اما رقابت گستردهتر LLM و مدلهای هوش مصنوعی در سراسر جهان آنقدر سریع حرکت میکند که به سرعت توسط رقبای بازمتن و بسته منبع دیگر تحتالشعاع قرار گرفتند.

Qwen2-Math چیست؟

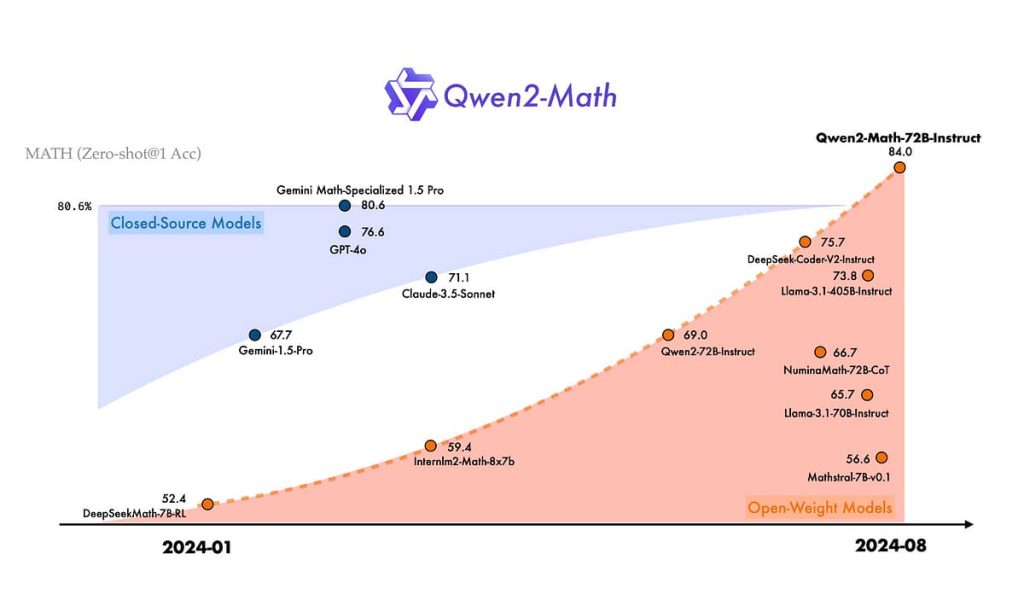

تیم Qwen شرکت علیبابا کلود، به تازگی پرده از Qwen2-Math برداشت، یک «سری از مدلهای زبانی بزرگ مخصوص ریاضیات» که برای زبان انگلیسی طراحی شده است. قدرتمندترین مدلهای این سری، همه رقبای خود در جهان را شکست دادهاند، از جمله مدلهای تحسینشده OpenAI GPT-4، Anthropic Claude 3.5 Sonnet و حتی Math-Gemini Specialized 1.5 Pro گوگل.

به طور خاص، مدل Qwen2-Math-72B-Instruct با ۷۲ میلیارد پارامتر، در بنچمارک ریاضی MATH برای LLMها به امتیاز ۸۴ درصد رسیده است. این بنچمارک شامل ۱۲۵۰۰ مسئله ریاضی چالشبرانگیز و مسئله کلامی است که حل آنها برای LLMها بسیار دشوار است (مثلاً تعیین بزرگتر بودن ۹.۹ یا ۹.۱۱). صادقانه بگویم، من خودم نمیتوانستم این سؤال را پاسخ دهم، چه برسد به اینکه در چند ثانیه جواب بدهم، اما ظاهراً Qwen2-Math در اکثر مواقع میتواند.

شاید تعجبآور نباشد که Qwen2-Math-72B Instruct همچنین در بنچمارک ریاضی دبستانی GSM8K)۸۵۰۰ سؤال) با ۹۶.۷ درصد و در بنچمارک ریاضی دانشگاهی با ۴۷.۸ درصد، از رقبا پیشی گرفته است. با این حال، قابلتوجه است که علیبابا مدل جدید Orca-Math مایکروسافت که در فوریه ۲۰۲۴ منتشر شد را در نمودارهای بنچمارک خود مقایسه نکرد. این مدل با ۷ میلیارد پارامتر (نوعی از Mistral-7B که خود نوعی از Llama است) به امتیاز ۸۶.۸۱ درصد برای Orca-Math در مقابل ۸۹.۹ درصد برای Qwen2-Math-7B-Instruct رسیده است.

با این حال، حتی کوچکترین نسخه Qwen2-Math، یعنی نسخه ۱.۵ میلیارد پارامتری، عملکرد قابلتوجهی دارد و نزدیک به مدلی است که بیش از ۴ برابر اندازه آن است و در GSM8K به ۸۴.۲ درصد و در ریاضی دانشگاهی به ۴۴.۲ درصد رسیده است.

کاربردهای مدلهای هوش مصنوعی ریاضی

در حالی که استفاده اولیه از LLMها بر کاربرد آنها در چتباتها و در مورد شرکتها، برای پاسخگویی به سؤالات کارمندان یا مشتریان یا تهیه اسناد و تجزیهوتحلیل اطلاعات سریعتر متمرکز بوده است، LLMهای متمرکز بر ریاضیات به دنبال ارائه ابزارهای قابلاعتمادتری برای کسانی هستند که به دنبال حل معادلات و کار با اعداد به صورت منظم هستند.

با وجود اینکه تمام کدها بر اساس اصول ریاضی هستند، اما تاکنون LLMها به اندازه دورههای قبلی هوش مصنوعی یا یادگیری ماشین، یا حتی نرمافزارهای قدیمیتر، در حل مسائل ریاضی قابلاعتماد نبودهاند.

محققان علیبابا که پشت Qwen2-Math هستند، میگویند که امیدوارند Qwen2-Math بتواند در حل مسائل پیچیده ریاضی به جامعه کمک کند.

شرایط مجوز سفارشی برای شرکتها و افرادی که میخواهند از Qwen2-Math استفاده کنند، کمتر از بازمتن خالص است و نیاز دارد که هر استفاده تجاری با بیش از ۱۰۰ میلیون کاربر فعال ماهانه مجوز اضافی از سازندگان دریافت کند. اما این هنوز هم یک محدودیت بالایی بسیار آسانگیرانه است و به بسیاری از استارتآپها، کسبوکارهای کوچک و متوسط و حتی برخی از شرکتهای بزرگ اجازه میدهد تا از Qwen-2 Math به صورت تجاری (برای کسب درآمد) به صورت رایگان استفاده کنند.