رقیبی قدرتمند برای OpenAI و گوگل:

مدلهای جدید هوش مصنوعی Qwen3 علیبابا

غول فناوری چینی علیبابا اخیراً خانواده مدلهای هوش مصنوعی Qwen3 را با وزنهای باز (Open Weights) منتشر کرده است.

غول فناوری چینی علیبابا اخیراً خانواده مدلهای هوش مصنوعی Qwen3 را با وزنهای باز (Open Weights) منتشر کرده است. این مدلها در اندازههای مختلف عرضه شدهاند و شامل مدل اصلی با ۲۳۵ میلیارد پارامتر و نسخههایی با ۰.۶ میلیارد، ۱.۷ میلیارد، ۴ میلیارد، ۸ میلیارد، ۱۴ میلیارد، ۳۲ میلیارد پارامتر هستند. علاوه بر این، مدل ۳۰ میلیارد پارامتری با ۳ میلیارد پارامتر فعال و مدل ۲۳۵ میلیارد پارامتری با ۲۲ میلیارد پارامتر فعال نیز ارائه شدهاند.

مدلهای Qwen3 را میتوان به صورت محلی با ابزارهایی مانند Ollama و LM Studio اجرا کرد. همچنین، این مدلها از طریق مرورگر وب و در پلتفرم Qwen Chat قابلدسترسی هستند.

قابلیتهای منحصربهفرد Qwen3

یکی از ویژگیهای برجسته مدلهای Qwen3 امکان تغییر بین دو حالت عملکردی است:

- حالت تفکر: مناسب برای وظایفی که نیاز به استدلال دارند.

- حالت بدون تفکر: مناسب برای وظایفی که نیاز به پاسخهای سریع دارند.

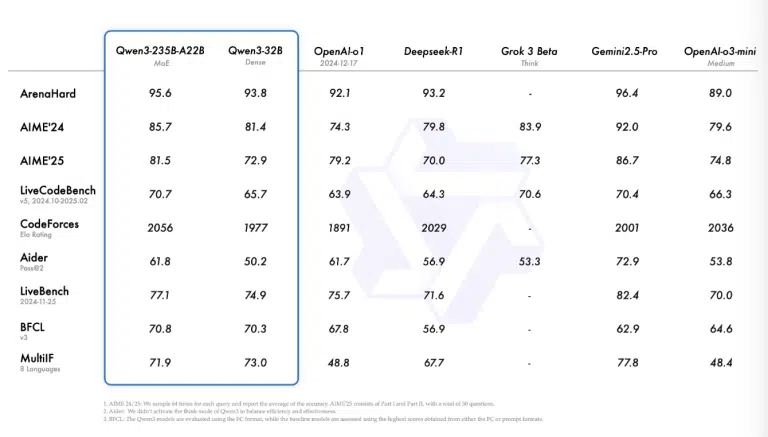

مدل اصلی Qwen3 با ۲۳۵ میلیارد پارامتر توانسته در آزمایشهای مرتبط با وظایف ریاضی و برنامهنویسی، عملکرد بهتری نسبت به مدلهای o1 و o3-mini شرکت OpenAI داشته باشد. همچنین، این مدل در بسیاری از معیارها عملکردی مشابه با مدلهای Gemini 2.5 Pro گوگل ارائه داده است.

رقابت با مدلهای OpenAI و گوگل

با وجود عملکرد چشمگیر، مدل Qwen3 در برخی معیارها از مدلهای جدید OpenAI عقبتر است. بهعنوان مثال:

- در آزمون LiveCodeBench برای کدنویسی، مدل Qwen3 با امتیاز ۷۰.۷٪ از مدل o4-mini (high) OpenAI با امتیاز ۸۰٪ عقبمانده است.

- در آزمون ریاضی AIME 2024، مدل o4-mini (high) با امتیاز ۹۴٪ تنها کمی بالاتر از مدل Qwen3 با امتیاز ۸۵.۷٪ قرار گرفته است.

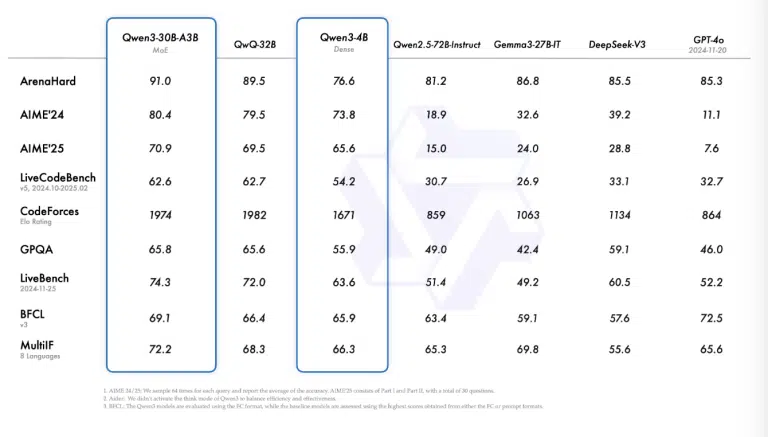

علاوه بر این، مدلهای کوچکتر Qwen3 نیز نسبت به نسلهای قبلی خود بهبود یافتهاند. مدل ۳۰ میلیارد پارامتری موفق شده است مدلهای DeepSeek-V3 و GPT-4o OpenAI را در برخی معیارها پشت سر بگذارد.

هماهنگی بینظیر در اکوسیستم LLM

سایمون ویلیسون، یکی از سازندگان فریمورک وب Django، در یک پست وبلاگی درباره انتشار مدلهای Qwen3 اظهار داشت: «چیزی که بیش از همه توجه من را جلب کرده، هماهنگی فوقالعاده در اکوسیستم مدلهای زبانی بزرگ (LLM) هنگام عرضه مدلهای Qwen3 است.»

ویلیسون اشاره کرد که این مدلها از همان روز انتشار به طور مستقیم با تمام فریمورکهای محبوب سرویسدهی LLM سازگار بودند. او افزود: «این سطح از هماهنگی برای عرضه یک مدل بینظیر است! معمولاً مدلهای دیگر به سادگی روی Hugging Face منتشر میشوند و منتظر میمانند تا جامعه بتواند فرآیندهای کوانتسازی و تبدیل را برای سایر معماریها انجام دهد.»

قابلیت اجرا روی دستگاههای مختلف

مدلهای Qwen3 در اندازههای مختلف عرضه شدهاند که این امکان را فراهم میکند تا کاربران بتوانند بسته به نیاز خود، از آنها بر روی دستگاههای مختلف استفاده کنند. ویلیسون در ادامه گفت:

- مدلهای کوچکتر مانند ۰.۶ میلیارد پارامتر و ۱.۷ میلیارد پارامتر میتوانند بهراحتی روی یک آیفون اجرا شوند.

- مدلهای بزرگتر مانند ۳۲ میلیارد پارامتر نیز میتوانند روی یک مکبوک با حافظه ۶۴ گیگابایت اجرا شوند، بدون اینکه فضای قابلتوجهی از دستگاه اشغال کنند.

نسل جدید مدلهای Qwen

خانواده مدلهای Qwen3 بهعنوان نسل جدید مدلهای Qwen2.5 معرفی شدهاند. ماه گذشته، علیبابا مدل QwQ با ۳۲ میلیارد پارامتر را منتشر کرد که توانست عملکردی مشابه با مدل DeepSeek-R1 ارائه دهد، با وجود اینکه اندازه آن بسیار کوچکتر بود.

علاوه بر این، علیبابا مدل QwQ-Max-Preview را نیز ارائه کرده است که بر پایه Qwen2.5 Max ساخته شده و به طور خاص برای وظایف مرتبط با ریاضیات و برنامهنویسی طراحی شده است.

گامی رو به جلو در هوش مصنوعی متنباز

مدلهای Qwen3 علیبابا با عملکرد قابل توجه در معیارهای مختلف، نشاندهنده پیشرفت چشمگیر در حوزه هوش مصنوعی متنباز هستند. عرضه این مدلها با وزنهای باز و در اندازههای مختلف، امکان دسترسی گستردهتر به کاربران و توسعهدهندگان را فراهم کرده است. در حالی که رقابت با غولهایی مانند OpenAI و گوگل ادامه دارد، Qwen3 توانسته جایگاه خود را بهعنوان یکی از قدرتمندترین مدلهای متنباز در جهان تثبیت کند.