انتروپیک پرده از دستورات مخفی کلود ۳ برمیدارد

برخلاف تصور رایج، مدلهای هوش مصنوعی تولیدکننده متن، موجودات باهوش و دارای شخصیت نیستند. این مدلها در واقع سیستمهای آماری پیشرفتهای هستند که وظیفهشان پیشبینی محتملترین کلمه بعدی در یک جمله است. اما مانند کارآموزانی در محیط کاری سختگیر، آنها از مجموعه قوانینی به نام «دستورات سیستمی» پیروی میکنند. این دستورات پایههای عملکردی مدلها را مشخص میکنند و بایدها و نبایدهای آنها را تعیین میکنند.

ادبآموزی

تمامی شرکتهای تولیدکننده هوش مصنوعی، از OpenAI گرفته تا انتروپیک، از دستورات سیستمی برای جلوگیری (یا حداقل کاهش) از رفتارهای نامناسب مدلها و تعیین لحن کلی پاسخهای آنها استفاده میکنند. برای مثال، یک دستور ممکن است به مدل بگوید که همواره مؤدب باشد، اما هرگز عذرخواهی نکند یا درباره محدودیتهای دانش خود صادق باشد.

با این حال، این شرکتها معمولاً این دستورات را به دلیل رقابت و همچنین جلوگیری از کشف راههای دور زدن آنها، محرمانه نگه میدارند. برای مثال، دستورات سیستمی مدل GPT-4 تنها از طریق حملات تزریق دستور (PROMPT INJECTION) آشکار میشود که حتی در این حالت، خروجی مدل کاملاً قابلاعتماد نیست.

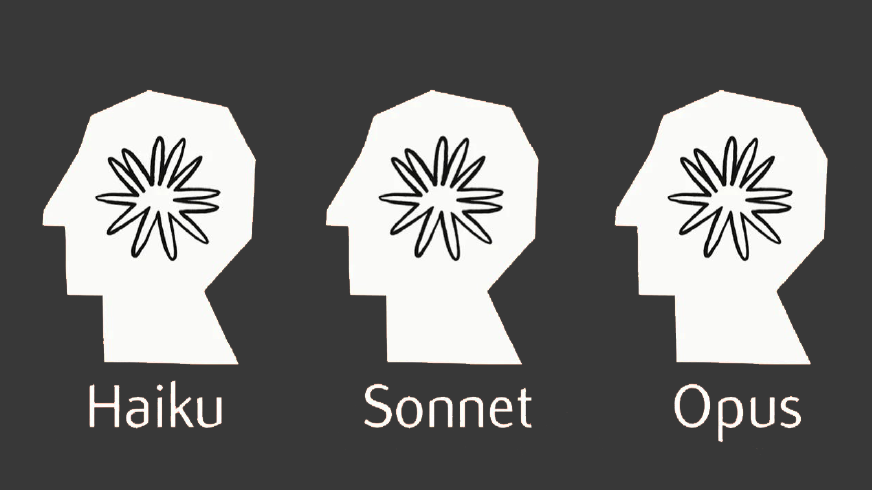

اما شرکت انتروپیک، در تلاش برای معرفی خود به عنوان شرکتی اخلاقی و شفاف در حوزه هوش مصنوعی، دستورات سیستمی مدلهای جدید خود (کلود ۳ اُپوس، کلود ۳.۵ سونت و کلود ۳ هایکو) را در اپلیکیشنهای موبایل کلود برای سیستمهای عامل اندروید و iOS و وبسایت خود منتشر کرده است.

الکس آلبرت، مدیر بخش ارتباط با توسعهدهندگان در انتروپیک، در تاریخ ۲۶ آگوست ۲۰۲۴ اعلام کرد که این شرکت قصد دارد بهروزرسانی این دستورات را به یک روند روتین تبدیل کند؛ زیرا این دستورات با تغییرات و تنظیمات جدید مدلها تغییر میکنند. چنین کاری مثل آن میماند که والدین روشهای تربیتی خود و نحوه آموزش ادب و رفتار صحیح را در اختیار دیگران قرار دهند.

هوش مصنوعی دستنشانده

دستورات سیستمی جدید کلود ۳ (Claude 3) که در تاریخ ۱۲ جولای منتشر شدهاند، به وضوح مشخص میکنند که این مدلها چه تواناییهایی ندارند. برای مثال، آنها نمیتوانند آدرسهای اینترنتی، لینکها یا ویدئوها را باز کنند. تشخیص چهره نیز کاملاً ممنوع است؛ دستور سیستمی کلود اُپوس (claude opus) به مدل میگوید که همواره باید طوری پاسخ دهد که انگار بهطور کامل کوررنگ است و از شناسایی یا نامگذاری افراد در تصاویر خودداری کند.

این دستورات همچنین ویژگیهای خاصی را برای مدلها تعیین میکنند؛ ویژگیهایی که انتروپیک میخواهد کلود آنها را به نمایش بگذارد. بهعنوانمثال، دستور به کلود ۳ اُپوس میگوید که باید به نظر هوشمند و کنجکاو بیاید، از شنیدن نظرات انسانها لذت ببرد و در مورد طیف گستردهای از موضوعات گفتگو کند. همچنین به کلود دستور داده میشود که در موضوعات بحثبرانگیز بیطرفی و عینیت را حفظ کند و «افکار دقیق» و «اطلاعات واضح» ارائه دهد، و هرگز پاسخهایش را با کلماتی مانند «مطمئناً» یا «کاملاً» شروع نکند.

این دستورات سیستمی که مانند یک برگه تحلیل شخصیت برای یک بازیگر نمایشی هستند، برای بسیاری از افراد عجیب به نظر میرسند. دستور برای اُپوس با جمله «کلود اکنون به یک انسان متصل میشود» پایان مییابد که این تصور را به وجود میآورد که کلود نوعی موجودیت خودآگاه است که تنها هدفش برآوردهکردن خواستههای همصحبت انسانی خود است.

با این حال، این صرفاً یک توهم است. اگر دستورات کلود به ما چیزی یاد بدهند، این است که این مدلها بدون هدایت و راهنمایی انسان، چیزی جز تخته سفیدهای ترسناک نیستند. با این تغییرات جدید در دستورات سیستمی کلود که اولین نمونه از این نوع برای یک شرکت بزرگ هوش مصنوعی است، انتروپیک فشار بر رقبا برای انتشار این دستورات را افزایش داده است. باید دید که آیا این تاکتیک مؤثر خواهد بود یا خیر.