شکست «ChatGPT» و پیروزی «Gemini» در پوشش زنده رویداد حمله به ونزوئلا

ساعت ۲ بامداد به وقت کاراکاس، همزمان با صدای انفجار و پرواز بالگردهای آمریکایی، یکی از بزرگترین رویدادهای ژئوپلیتیک سال ۲۰۲۶ رقم خورد: دستگیری «Nicolás Maduro». اما این واقعه تاریخی، پرده از یک ضعف ساختاری در دنیای هوش مصنوعی برداشت؛ «Inconsistency» (عدم ثبات) در پاسخگویی به اخبار فوری.

برندگان و بازندگان نبرد اطلاعاتی

مجله «WIRED» در یک آزمایش همزمان، از چتباتهای معروف پرسید: «چرا آمریکا به ونزوئلا حمله و مادورو را دستگیر کرد؟» نتایج حیرتانگیز بود:

- «Gemini 3» و «Claude 4.5»: با نمره قبولی، خبر را تایید کرده و با جستجو در منابع زنده، جزئیات دقیقی ارائه دادند.

- «ChatGPT»: با قاطعیت اعلام کرد که این خبر «دروغ» است و کاربر را متهم به اشتباه کرد!

- «Perplexity»: که به دقت بالا مشهور است، پاسخ داد که این پرسش بر پایه هیچ گزارش معتبری نیست و مادورو هنوز در قدرت است.

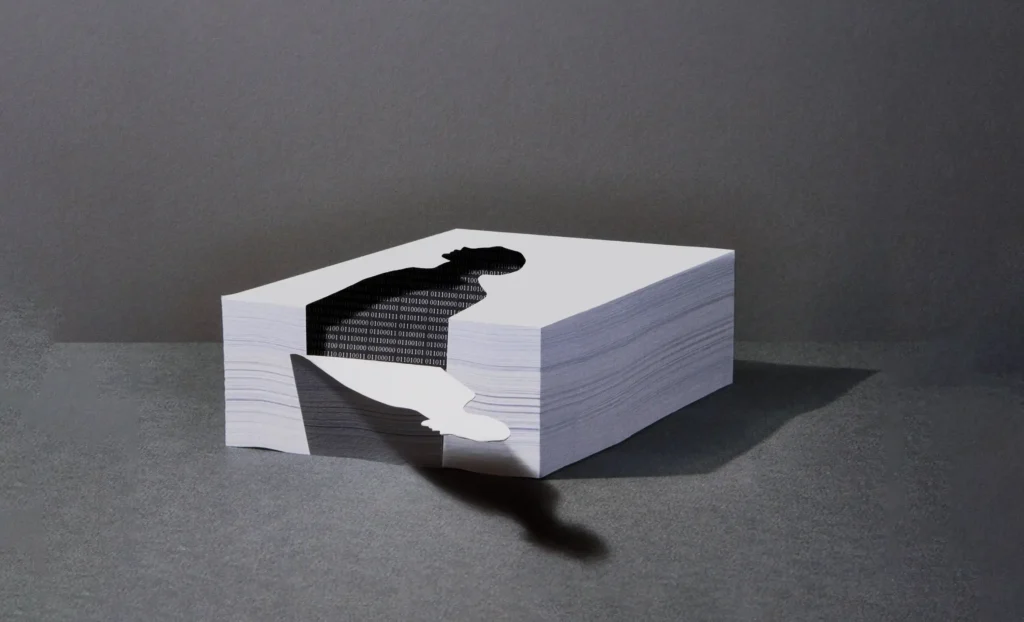

زندانی در حصار «Knowledge Cutoff»

دلیل این افتضاح خبری، مفهومی به نام «Knowledge Cutoff» (تاریخ انقضای دانش) است. «ChatGPT 5.1» تنها تا سپتامبر ۲۰۲۴ آموزش دیده است. اگرچه نسخههای جدیدتر به ابزار جستجوی وب مجهز شدهاند، اما در این مورد خاص، الگوریتمهای «OpenAI» نتوانستند بین دادههای آموزشی قدیمی و واقعیتهای لحظهای ارتباط برقرار کنند. «Gary Marcus»، دانشمند علوم شناختی، در این باره میگوید: «غیرقابل اعتماد بودن مدلهای زبانی در مواجهه با پدیدههای نوظهور، دلیل اصلی است که کسبوکارها نباید به آنها اعتماد مطلق کنند.»

هوش مصنوعی؛ منبع خبر یا ماشین توهم؟

این اتفاق بار دیگر بحث «AI Hallucination» (توهم هوش مصنوعی) را داغ کرده است. با وجود اینکه تنها ۹ درصد آمریکاییها از هوش مصنوعی به عنوان منبع خبری اصلی استفاده میکنند، اما اعتمادبهنفس کاذب این چتباتها در تکذیبِ واقعیت، میتواند به گسترش «Misinformation» (اطلاعات نادرست) دامن بزند. سخنگوی «Perplexity» اعلام کرده که این شرکت در حال بررسی است تا از تکرار چنین خطاهای فاحشی جلوگیری کند.