روش جدید MIT برای افزایش دقت و منطق در هوش مصنوعی

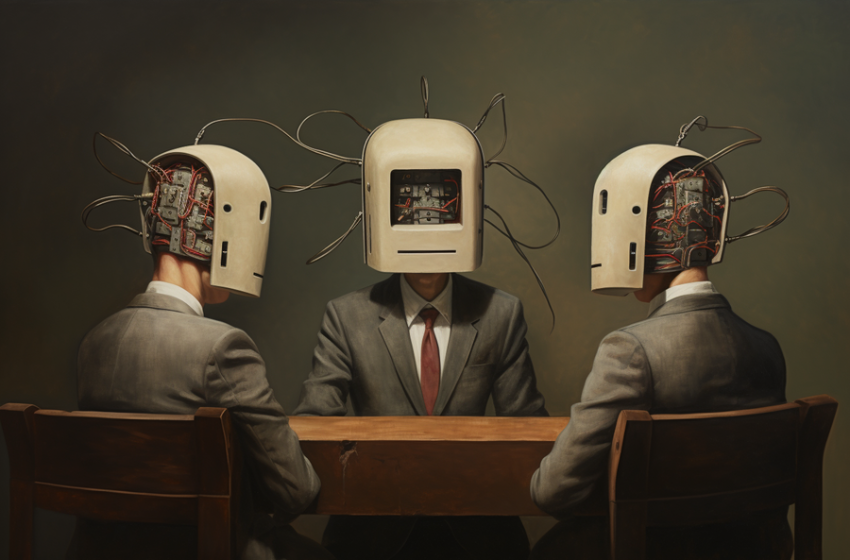

مباحثه میان مدلها هوشمصنوعی

همکاری چندمدلی در هوش مصنوعی، بهبود استدلال و دقت واقعی در مدلهای زبانی بزرگ را به همراه دارد. پژوهشگران از همکاری میان چند مدل هوش مصنوعی برای بحث، تبادل نظر و ارتقای تواناییهای استدلالی بهره میبرند تا عملکرد مدلهای زبانی بزرگ را بهبود داده و در عین حال، مسئولیتپذیری و دقت واقعی آنها را افزایش دهند.

ضربالمثلی که از دوران کودکی به گوش بسیاری از ما رسیده این است: «دو فکر بهتر از یکی است.» این جمله ما را تشویق میکند تا فراتر از ذهن خودمحور و ابتداییمان فکر کنیم و به قدرت خرد جمعی ایمان بیاوریم.

اکنون و در سال ۲۰۲۳، این خرد کهن حتی در قلمرو هوش مصنوعی نیز صادق است: چند مدل زبانی که با هم کار میکنند، از یک مدل تنها بهتر عمل میکنند.

بهتازگی تیمی از «آزمایشگاه علوم رایانه و هوش مصنوعی (CSAIL)» در (MIT) این خرد دیرینه را در مرزهای فناوری مدرن به کار گرفتهاند. آنها راهبردی را معرفی کردهاند که در آن چند سیستم هوش مصنوعی با یکدیگر بحث و گفتوگو میکنند تا به بهترین پاسخ ممکن برای یک پرسش دست یابند. این روش به مدلهای زبانی بزرگ (LLMs) کمک میکند تا پایبندی خود به دادههای واقعی را افزایش دهند و فرایند تصمیمگیری خود را بهبود ببخشند.

هسته اصلی مشکل در مدلهای زبانی بزرگ، ناهماهنگی در پاسخهای تولیدشده توسط آنهاست که میتواند منجر به اشتباهات اطلاعاتی و استدلالهای نادرست شود. در روش جدید، هر عامل (مدل زبانی) پاسخ سایر عوامل را بهطور فعال ارزیابی میکند و از بازخورد جمعی برای اصلاح پاسخ خود بهره میبرد.

از نظر فنی، این فرایند شامل چند مرحله تولید پاسخ و نقد متقابل است: ابتدا هر مدل زبانی پاسخی برای پرسش دادهشده تولید میکند، سپس این پاسخ با بازخورد سایر مدلها بهروزرسانی میشود. این چرخه تکرارشونده در نهایت به تولید یک خروجی نهایی ختم میشود که از طریق رأیگیری اکثریت میان پاسخهای مدلها انتخاب میشود. این روند، از لحاظ مفهومی، بسیار شبیه به یک بحث گروهی است. جایی که افراد مختلف نظرات خود را مطرح میکنند تا به یک نتیجه منسجم و منطقی برسند.

یکی از نقاط قوت این رویکرد در کاربرد ساده آن برای مدلهای «جعبهسیاه» نهفته است. از آنجا که این روش صرفاً مبتنی بر تولید متن است، میتوان آن را بدون نیاز به دسترسی به ساختار داخلی مدلها، روی انواع مختلف مدلهای زبانی پیاده کرد. تیم پژوهشی میگوید، این سادگی میتواند به پژوهشگران و توسعهدهندگان کمک کند تا با استفاده از این ابزار، یکپارچگی و دقت واقعی در خروجی مدلهای زبانی را در سطحی گسترده بهبود بخشند.

ییلون دو (Yilun Du)، دانشجوی دکترای مهندسی برق و علوم کامپیوتر در (MIT)، عضو آزمایشگاه علوم رایانه و هوش مصنوعی (CSAIL) و نویسنده اصلی مقاله جدیدی در این زمینه میگوید: «در این رویکرد نوآورانه، ما فقط به یک مدل هوش مصنوعی برای پاسخگویی تکیه نمیکنیم. بلکه فرایند ما مجموعهای از مدلهای هوش مصنوعی را درگیر میکند که هرکدام با دیدگاهها و بینشهای منحصربهفرد خود به حل یک پرسش کمک میکنند. گرچه پاسخهای اولیه این مدلها ممکن است ناقص یا همراه با خطا باشد، اما آنها میتوانند با بررسی پاسخهای دیگر همتایان خود، پاسخهایشان را اصلاح و بهبود دهند.»

او ادامه میدهد: «هنگامی که این مدلها وارد بحث و تبادل نظر میشوند، بهتر میتوانند مشکلات را تشخیص دهند و اصلاح کنند، توانایی حل مسئلهشان را ارتقا دهند و دقت پاسخهای خود را بهتر تأیید کنند. در واقع ما محیطی ایجاد کردهایم که آنها را وادار میکند عمیقتر به ریشهی مسئله بپردازند. این رویکرد کاملاً در تضاد با عملکرد یک مدل منفرد و منزوی است، که اغلب صرفاً مطالبی را که در اینترنت دیده، تکرار میکند، اما در روش ما، مدلهای هوش مصنوعی بهطور فعال برای تولید پاسخهایی دقیقتر و جامعتر تحریک میشوند.»

پژوهش، حل مسائل ریاضی را از سطح ابتدایی تا متوسطه، مورد بررسی قرار داد و بهبود قابلتوجهی را از طریق فرایند «بحث چندعاملی» (multi-agent debate) نشان داد. افزون بر این، مدلهای زبانی توانایی بالاتری در تولید محاسبات ریاضی دقیق از خود نشان دادند، که نشاندهنده پتانسیل این روش در حوزههای مختلف است.

این روش همچنین میتواند به حل مشکل «توهمزایی» (hallucinations) در مدلهای زبانی کمک کند و به معنای تولید اطلاعات نادرست یا ساختگی توسط مدل است. با طراحی محیطی که در آن عاملها پاسخهای یکدیگر را نقد و آنها انگیزهی بیشتری پیدا میکنند تا از تولید اطلاعات تصادفی بپرهیزند و دقت واقعی را در اولویت قرار دهند.

فراتر از مدلهای زبانی، این رویکرد میتواند برای ادغام مدلهای مختلف با قابلیتهای تخصصی نیز مورد استفاده قرار گیرد. با ایجاد یک سامانه غیرمتمرکز که در آن چند عامل با یکدیگر تعامل و مناظره میکنند، این تواناییهای حل مسئله دقیق و جامع میتواند در حوزههایی مانند گفتار، ویدئو و متن گسترش یابد.

با وجود نتایج امیدوارکننده این روش، پژوهشگران معتقدند که مدلهای زبانی موجود هنوز با چالشهایی در پردازش متون بسیار طولانی روبهرو هستند و قابلیتهای نقد و بررسی در آنها هنوز بهدقت لازم نرسیده است. علاوه بر این، قالب مناظره چندعاملی که الهامگرفته از تعاملات انسانی است، هنوز شامل پیچیدگیهای بحثهای جمعی واقعی نشده است بخشی که به گفته تیم پژوهشی، نیازمند کاوش بیشتر در آینده است.

پیشبرد این تکنیک، مستلزم درک عمیقتر از زیرساختهای محاسباتی بحث و استدلال انسانی است تا این دانش بتواند برای بهبود و تکمیل مدلهای زبانی بزرگ مورد استفاده قرار گیرد.

(دو) میگوید: «این روش نهتنها مسیری برای ارتقای عملکرد مدلهای زبانی فعلی فراهم میکند، بلکه ابزاری خودکار برای خود بهبودی مدلها ارائه میدهد. با استفاده از فرایند مناظره بهعنوان دادههای آموزشی نظارتی، مدلهای زبانی میتوانند بهطور مستقل دقت و استدلال خود را بهبود دهند، وابستگی به بازخورد انسانی را کاهش دهند و رویکردی مقیاسپذیر برای خودآموزی ارائه دهند.»

او ادامه میدهد: «با ادامه پالایش این روش توسط پژوهشگران، ما به آیندهای نزدیکتر میشویم که در آن مدلهای زبانی نهتنها زبان انسانمانند را تقلید میکنند، بلکه تفکری منظمتر و قابلاعتمادتر از خود نشان میدهند و به این ترتیب، دوران جدیدی از فهم و کاربرد زبان رقم میخورد.»

آنکا دراگان (Anca Dragan)، استاد دانشگاه کالیفرنیا در برکلی و عضو دانشکده مهندسی برق و علوم کامپیوتر که در این پروژه مشارکت نداشته است، میگوید: «استفاده از یک فرایند استدلالی برای بهبود خروجی مدل، کاملاً منطقی است و گامی بزرگ بهسوی آینده نسبت به تکنیکهایی مثل «زنجیره تفکر» (chain-of-thought prompting) محسوب میشود. من مشتاقم ببینم این رویکرد به کجا خواهد رسید. آیا کاربران با مشاهده مناظره میان مدلها بهتر میتوانند پاسخهای تولیدشده را قضاوت کنند، حتی اگر به نتیجه نهایی نرسند؟ آیا انسانها میتوانند با مناظره با یک مدل زبانی، پاسخ بهتری به دست آورند؟ آیا ایدهای مشابه میتواند به کاربر کمک کند تا پاسخ یک مدل زبانی را بیشتر زیر سؤال ببرد و در نتیجه پاسخ بهتری بیابد؟»