توانایی استدلال مدلهای زبانی بزرگ اغلب بیش از واقعیت برآورد میشود

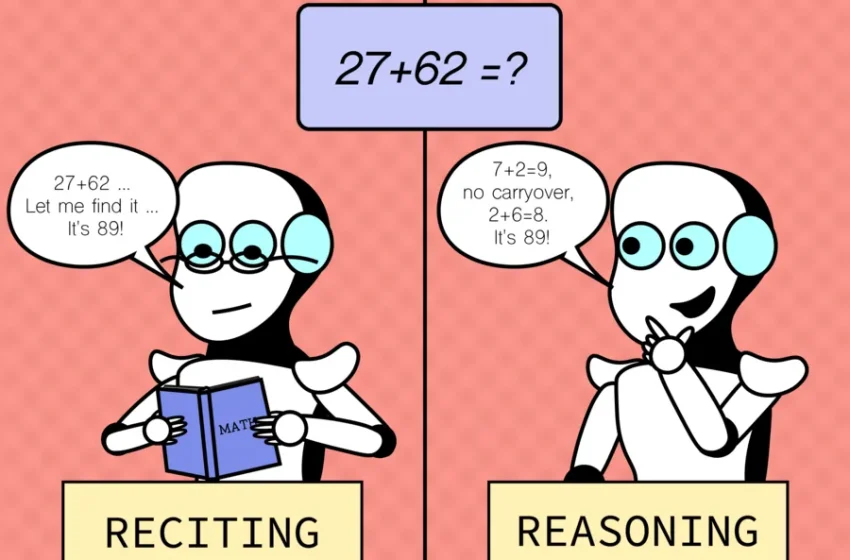

پژوهشی جدید از آزمایشگاه علوم کامپیوتر و هوش مصنوعی مؤسسه فناوری ماساچوست (CSAIL) نشان میدهد که تواناییهای استدلالی مدلهای زبانی بزرگ (LLMs) اغلب بیش از حد تخمین زده شده است. این مطالعه با بررسی عملکرد این مدلها در سناریوهای آشنا و غیر آشنا، وابستگی قابلتوجه آنها به حافظه محوری را آشکار کرده و توانایی استدلال واقعی آنها را زیر سؤال برده است.

چالشهای فهم عملکرد مدلهای زبانی

مدلهای زبانی بزرگ، مانند GPT-4 و Claude، به دلیل ابعاد عظیم، روشهای آموزشی پیچیده و رفتارهای غیرقابلپیشبینی، عملکردی مرموز دارند. پیچیدگیهای درونی این مدلها، ارزیابی دقیق تواناییهای استدلالی آنها را دشوار میسازد. پژوهشگران CSAIL با رویکردی روشمند، این مدلها را در برابر وظایف متنوعی آزمودهاند تا تعامل میان حافظهمحوری و استدلال واقعی را بررسی کنند.

روششناسی پژوهش

این مطالعه دو نوع وظیفه را مقایسه کرده است:

۱. وظایف پیشفرض: وظایفی که مدلها برای آنها آموزش دیدند و معمولاً در ارزیابیهای استاندارد عملکرد خوبی از خود نشان میدهند.

۲. سناریوهای متقابل واقعیت (Counterfactual Scenarios): شرایط فرضی که از الگوهای پیشفرض انحراف دارند و نیازمند تعمیمدهی و استدلال واقعی هستند.

بهجای طراحی وظایف کاملاً جدید، پژوهشگران با اعمال تغییراتی در وظایف موجود، سناریوهایی خارج از حوزه آشنایی مدلها ایجاد کردند. این وظایف شامل مجموعهدادهها و معیارهایی در حوزههایی مانند محاسبات ریاضی، بازی شطرنج، ارزیابی کدهای برنامهنویسی و پاسخ به پرسشهای منطقی بود.

محاسبات ریاضی

بهعنوان مثال، در تعاملات معمول با مدلهای زبانی، محاسبات ریاضی اغلب در مبنای ۱۰ انجام میشود که برای این مدلها آشنا و بهینه است. عملکرد قوی در این مبنا ممکن است این تصور را ایجاد کند که مدلها در عملیات ریاضی مهارت بالایی دارند. با این حال، از منظر منطقی، توانایی واقعی در محاسبات ریاضی باید در همه مبناهای عددی (مانند مبنای ۲ یا ۱۶) پایدار باشد، مشابه عملکرد ماشینحسابها یا سیستمهای محاسباتی سنتی.

یافتههای پژوهش نشان داد که مدلهای زبانی در سناریوهای غیرآشنا، مانند محاسبات در مبناهای عددی غیرمتعارف با افت شدید عملکرد مواجه میشوند. این امر حاکی از آن است که توانایی محاسباتی آنها به شدت به الگوهای آشنا و دادههای آموزشی قبلی وابسته است و از استدلال تعمیمپذیر برخوردار نیستند.

نتایج و پیامدها

نتایج این مطالعه نشاندهنده محدودیتهای قابلتوجه مدلهای زبانی بزرگ در استدلال واقعی است. عملکرد قوی این مدلها در وظایف پیشفرض عمدتاً به یادسپاری الگوهای موجود در دادههای آموزشی وابسته است، نه به توانایی استدلال تعمیمپذیر. در سناریوهای متقابل واقعیت که نیازمند انطباق با شرایط جدید هستند، عملکرد این مدلها به طور پیوسته کاهش مییابد. این یافتهها ضرورت بازنگری در ارزیابی تواناییهای استدلالی مدلهای زبانی و توجه بیشتر به تعمیمپذیری آنها را برجسته میکنند.

چشمانداز آینده

این پژوهش بر نیاز به توسعه روشهایی برای تقویت توانایی استدلال واقعی در مدلهای زبانی تأکید دارد. رویکردهایی مانند یادگیری انتقالی، آموزش با سناریوهای متنوعتر یا استفاده از فرآیندهای بحث چندعاملی (مانند آنچه در پژوهشهای قبلی CSAIL بررسی شده) میتوانند به بهبود تعمیمپذیری این مدلها کمک کنند. علاوه بر این، طراحی معیارهای ارزیابی جدید که فراتر از وظایف پیشفرض باشند، برای درک بهتر محدودیتها و قابلیتهای این مدلها ضروری است.

مشاهده الگوهای مشابه در وظایف مختلف

این الگو در طیف گستردهای از وظایف دیگر نیز مشاهده شده است، از جمله نواختن آکوردهای موسیقی با انگشتگذاری صحیح، استدلال فضایی و حل مسائل شطرنج با موقعیتهای اولیه تغییریافته. انتظار میرود که انسانها، حتی در سناریوهای تغییریافته، با صرف زمان کافی بتوانند قانونیبودن حرکات را تشخیص دهند. با این حال، مدلهای زبانی در چنین شرایطی با چالش مواجه شده و عملکردی فراتر از حدس تصادفی ارائه ندادند. این امر نشاندهنده محدودیت قابلتوجه این مدلها در تعمیمدهی به موقعیتهای ناآشنا است.

بخش عمدهای از عملکرد مطلوب این مدلها در وظایف استاندارد، احتمالاً ناشی از توانایی واقعی در انجام وظایف نیست، بلکه نتیجه بیشبرازش (overfitting) یا وابستگی بیش از حد به دادههای آموزشی است.

دکتر «ژائوفنگ وو»، دانشجوی دکتری مهندسی برق و علوم کامپیوتر در مؤسسه فناوری ماساچوست (MIT) و عضو آزمایشگاه هوش مصنوعی و علوم کامپیوتر (CSAIL)، همچنین نویسنده اصلی مقاله این پژوهش، اظهار میدارد: «ما به ویژگی جالبی در مدلهای زبانی بزرگ پی بردیم: این مدلها در موقعیتهای آشنا عملکردی برجسته دارند، مانند پیمودن مسیرهای شناخته شد، اما در مواجهه با شرایط ناآشنا دچار ضعف میشوند. این یافته در راستای تلاش برای بهبود سازگاری و گسترش کاربرد این مدلها از اهمیت بسزایی برخوردار است.»

وی افزود: «با توجه به گسترش روزافزون استفاده از هوش مصنوعی در جامعه، این فناوری باید قادر به عملکرد مطمئن در سناریوهای متنوع، چه آشنا و چه ناآشنا، باشد. امیدواریم این یافتهها به طراحی مدلهای زبانی مستحکمتر و مقاومتر در آینده کمک کند.»

محدودیتها و جهتگیریهای آینده پژوهش

با وجود دستاوردهای ارزشمند این مطالعه، محدودیتهایی نیز وجود دارد. تمرکز پژوهش بر مجموعهای خاص از وظایف و تنظیمات آزمایشی، نتوانسته است تمام چالشهای احتمالی مدلها در کاربردهای واقعی را پوشش دهد. از اینرو، نیاز به طراحی محیطهای آزمایشی متنوعتر احساس میشود.

در آینده، میتوان دامنه وظایف و سناریوهای متقابلواقعیت را گسترش داد تا نقاط ضعف بیشتری از مدلها شناسایی شود، بهویژه در سناریوهای پیچیدهتر و غیرمعمول. همچنین، تیم پژوهشی در نظر دارد تفسیرپذیری مدلها را بهبود بخشد و روشهایی برای درک بهتر منطق تصمیمگیری آنها توسعه دهد.

دکتر هائو پنگ، استادیار دانشگاه ایلینوی در اربانا-شمپین، اظهار میکند: «با بزرگتر شدن مدلهای زبانی، حتی در مدلهای متنباز، درک کامل دادههای آموزشی آنها به چالشی بزرگ تبدیل شده است، چه برسد به مدلهای اختصاصی. هنوز مشخص نیست که آیا این مدلها واقعاً قادر به تعمیمدهی به وظایف نادیده هستند یا صرفاً با تکیه بر دادههای آموزشی، عملکرد موفقی را بازتولید میکنند. این مقاله گامی مهم در این مسیر است، با ارائهی مجموعهای از ارزیابیهای متقابلواقعیت دقیق، دیدگاه جدیدی دربارهی تواناییهای مدلهای زبانی پیشرفته ارائه میدهد و نشان میدهد که قابلیت آنها در حل وظایف نادیده ممکن است بسیار محدودتر از تصور رایج باشد. این پژوهش میتواند الهامبخش تحقیقات آینده برای شناسایی الگوهای شکست در مدلهای کنونی و توسعهی مدلهای کارآمدتر باشد.»

نتایج این مطالعه در کنفرانس فصل آمریکای شمالی انجمن زبانشناسی محاسباتی (NAACL) ارائه شد.