متا از مراکز داده و ابر رایانه هوش مصنوعی جدید خود رونمایی میکند

متا در رویدادی با نام AI Infra @ Scale که اخیرا برگزار شده، مجموعهای از پروژههای سختافزاری و نرمافزاری جدید خود را معرفی کرده است. این غول رسانههای اجتماعی همچنین اطلاعات بسیاری درخصوص تراشه خاص خود با نام (MTIA) ارائه کرده است.

به گزارش هوشیو، متا؛ غول رسانههای اجتماعی که قبلاً فیسبوک نامیده میشد، بیش از یک دهه است که از پیشگامان هوش مصنوعی بوده و از این فناوری برای تقویت محصولات و خدمات خود مانند اخبار، تبلیغات فیسبوک، مسنجر و واقعیت مجازی استفاده میکند. اما با افزایش تقاضا برای راهحلهای هوش مصنوعی پیشرفتهتر و مقیاسپذیر، نیاز به زیرساختهای هوش مصنوعی خلاقانهتر و کارآمدتر نیز افزایش مییابد.

در رویداد AI Infra @ Scale که یک کنفرانس مجازی یک روزه به میزبانی تیمهای مهندسی و زیرساخت متا بود، این شرکت مجموعهای از پروژههای سختافزاری و نرمافزاری جدید خود را معرفی کرد که هدف آن پشتیبانی از نسل بعدی برنامههای کاربردی هوش مصنوعی است. در این رویداد، سخنرانانی از متا حضور داشتند و بینش و تجربیات خود را در مورد ساخت و استقرار سیستمهای هوش مصنوعی در مقیاس بزرگ به اشتراک گذاشتند.

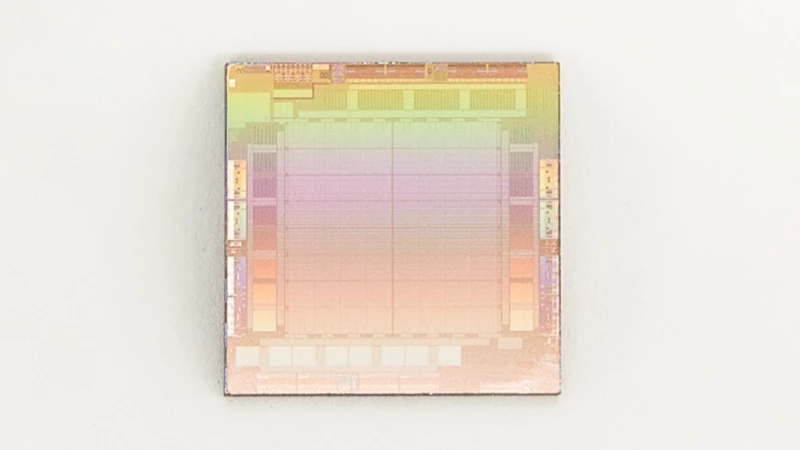

در میان اعلامیههای این رویداد، متا یک طراحی جدید مرکز داده هوش مصنوعی را اعلام کرد که بر دو مرحله اصلی توسعه و اجرای مدلهای هوش مصنوعی، یعنی «آموزش» و «استنباط» متمرکز است. برای اینکه انجام این دو کار به خوبی صورت پذیرد، مرکز داده جدید از تراشه خاصی به نام شتابدهنده آموزش و استنتاج متا (MTIA) استفاده میکند، تا به هوش مصنوعی در زمینههایی مانند بینایی کامپیوتر، پردازش زبان و سیستمهای توصیه یاری رساند.

متا همچنین فاش کرد که پیشتر Supercluster Research (RSC) را ساخته است، یک ابررایانه هوش مصنوعی که 16000 پردازنده گرافیکی را برای کمک به آموزش مدلهای زبان بزرگ (LLM) همچون پروژه LLaMA (پروژهای که متا در پایان فوریه اعلام کرد) ادغام میکند.

مارک زاکربرگ، مدیرعامل متا در بیانیهای گفته است: «ما سالها است که زیرساختهای پیشرفتهای را برای هوش مصنوعی ایجاد کردهایم. این کار نشاندهنده تلاشهای طولانیمدت ماست که پیشرفتهای بیشتر و استفاده بهتر از این فناوری را در هر فعالیتی که انجام میدهیم ممکن میسازد.

اهمیت سرمایهگذاری شرکتها در زیرساختهای هوش مصنوعی در سال 2023

متا تنها شرکت بزرگ فناوری اطلاعات یا hyperscaler نیست که به ساخت زیرساختهای هوش مصنوعی میاندیشد. سایر شرکتهای بزرگ فناوری اطلاعات مانند مایکروسافت و انویدیا نیز در حال سرمایهگذاری در توسعه زیرساختهای هدفمند برای هوش مصنوعی هستند. در ماه نوامبر، این دو شرکت همکاری خود را برای ساخت ابررایانه هوش مصنوعی در فضای ابری اعلام کردند. این ابررایانه از پردازندههای گرافیکی Nvidia که به فناوری شبکه Quantum 2 InfiniBand انویدیا متصل هستند، استفاده میکند.

چند ماه بعد یعنی در ماه فوریه، IBM جزئیات ابررایانه هوش مصنوعی خود به نام Vela به اشتراک گذاشت. این سیستم IBM از تراشههای کامپیوتری x86، در کنار پردازندههای گرافیکی Nvidia و نوعی شبکه کامپیوتری به نام اترنت استفاده میکند. سیستم Vela دارای هشت پردازنده گرافیکی بسیار قدرتمند (به نام GPU A100) است که هر کدام قادر به انجام 80 گیگابایت کار هستند. هدف IBM ساخت مدلهای پایه جدید است که میتواند توسط مشاغل برای رفع نیازهای هوش مصنوعیشان استفاده گردد.

گوگل نیز ضمن اعلامیهای در تاریخ 10 مه وارد رقابت ابررایانه های هوش مصنوعی شده است.

آنچه شتابدهنده استنتاجی هوش مصنوعی جدید متا به بازار آورده

متا هماکنون با تراشه MTIA خود به فضای تراشههای کامپیوتری سفارشی ورود پیدا کرده است. ایجاد تراشههای استنتاجی مانند این که به منظور پردازش هوش مصنوعی استفاده میشوند، ایده جدیدی نیست و شرکتهای دیگری مانند گوگل و آمازون نیز پیشتر نسخههای خود را توسعه دادهاند.

متا برای رفع نیازهای خاص خود و انجام وظایف مختلفی مانند مدیریت فیدهای خبری، رتبهبندی محتوا، درک دادهها و ارائه توصیهها، به هوش مصنوعی نیاز دارد. امین فیروزشاهیان، پژوهشگر متا برای زیرساخت، در ویدئویی که تراشه کامپیوتری MTIA را تشریح میکند، اظهار داشت:« تراشههای کامپیوتری معمولی (CPU) نمیتوانند از عهده انجام این وظایف برآیند، بنابراین متا تراشه سفارشی خود به نام MTIA را طراحی کرده که به طور خاص برای انجام این وظایف طراحی گردیده و میتواند عملیات پردازش موردنظر آنها را بهسرعت و به شکلی کارآمدتر انجام دهد.»

متا همچنین از یک چارچوب یادگیری ماشینی منبعباز به نام PyTorch استفاده میکند. PyTorch نوعی کد است که به هوش مصنوعی متا کمک میکند کار خود را بهتر انجام دهد. MTIA به طور خاص برای کار با PyTorch طراحی شده. MTIA میتواند تا 102.4 تریلیون عملیات در ثانیه را پردازش کند و بخشی از یک طرح بزرگتر در Meta برای بهینهسازی تمام جنبههای عملیاتی مربوط به هوش مصنوعی، ازجمله شبکه و مصرف انرژی است.

متا بیش از یک دهه است که مرکز داده خود را برای پاسخگویی به نیاز میلیاردها کاربر خود ساخته است. هرچند تاکنون عملکرد خوبی داشته، اما رشد انفجاری در تقاضاهای هوش مصنوعی به این معنی است که زمان انجام کارهای بیشتری فرا رسیده است.