شفافیت، راهکار مشکلات جعبه سیاه هوش مصنوعی

در این مطلب به راهکارهایی برای مشکلات جعبه سیاه هوش مصنوعی اشاره خواهیم کرد. مسائل مربوط به جعبه سیاه هوش مصنوعی اعتماد کاربران به تصمیمات الگوریتمها را به خطر انداخته است. همزمان با پیشرفتهای روزافزون در عرصه هوش مصنوعی، متخصصان در تلاشاند رویکرد جعبه شیشهای را در میان توسعهگرها ترویج دهند.

کلمه جعبه سیاه موذیانه به نظر میرسد، ولی تصویر درستی از واقعیت نشان میدهد. متخصصان دائماً در مورد خطرات بالقوه هوش مصنوعی غیرشفاف، از جمله سوگیری و ملاحظات اخلاقی، هشدار میدهند.

با این تفاسیر، در حال حاضر، جعبه سیاه رویکرد اصلی مدلسازی یادگیری عمیق است. در این رویکرد، میلیونها نمونه (نقطهداده) به الگوریتم تغذیه میشوند. سپس الگوریتم با تشخیص روابط همبستگی بین ویژگیهای خاص دادهها، خروجی مورد نظر را تولید میکند. این فرآیند عمدتاً خودران است و به همین دلیل، متخصصان داده، برنامهنویسها و کاربران به سختی میتوانند آن را تفسیر کنند.

جعبه سیاه هوش مصنوعی در بسیاری از انواع یادگیری عمیق که در زندگی روزمره با آنها سروکار داریم، همچون نرمافزارهای تشخیص چهره یا حتی سرویسهای کارت اعتباری، تعبیه شده است. افزایش حساسیتها به مدلهای جعبه سیاه منجر به آغاز جنبشی در عرصه تحقیق و توسعه هوش مصنوعیهای توضیحپذیر شده است. سؤال محوری هوش مصنوعی توضیحپذیر این است که چطور میتوان خروجی مدلهای هوش مصنوعی را قابل درکتر کرد؛ به بیان دیگر، هدف، خلق هوش مصنوعیهایی است که توضیحاتی معقول و قابل رهگیری برای همه تصمیماتشان داشته باشند. با این حال، پیچیدگی ارتباطات بین دادهها که تنها هوش مصنوعی میتواند تشخیص دهد، این کار را با چالش روبرو میکند.

شفافسازی جعبه

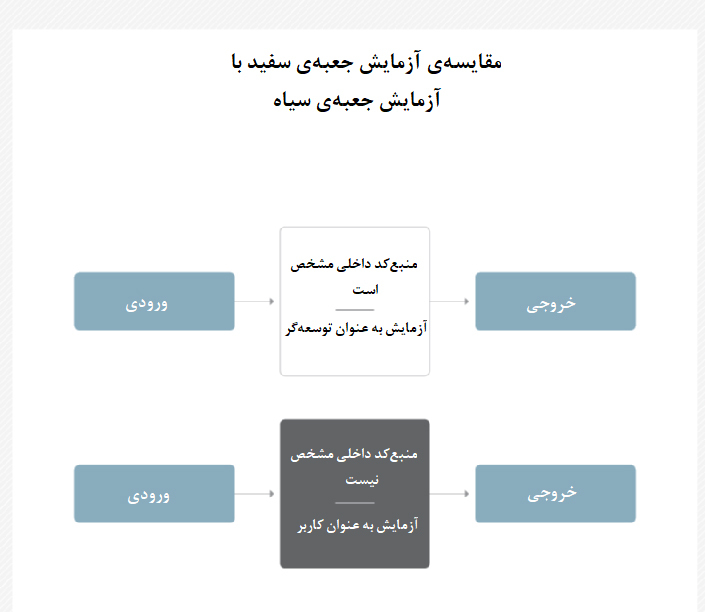

راه حل مسائل و مشکلات جعبه سیاه هوش مصنوعی به پاکسازی دادهها خلاصه نمیشود. در حال حاضر، بیشتر ابزارهای هوش مصنوعی توسط شبکههای عصبی پشتیبانی میشوند که رمزگشاییشان کار آسانی نیست. اعتماد به شرکت و فرآیند آموزشی آن میتواند نقطه شروع این مسیر باشد. اما متخصصان معتقدند راهکار واقعی این مشکلات، تغییر رویه آموزشی به رویکردی است که با نام جعبه سفید یا «جعبه شیشهای هوش مصنوعی» شناخته میشود.

مدلسازی جعبه سفید مستلزم در دست داشتن دادههای آموزشی قابل اعتماد و معتبری است که توضیح، تغییر و مطالعهشان برای تحلیلگرها امکانپذیر باشد. تنها بدین طریق است که میتوان اعتماد کاربران را به تصمیمگیری اخلاقی جلب کرد. بدین ترتیب، الگوریتمهای هوش مصنوعی توضیحپذیر شده و قبل از اینکه تصمیماتی مربوط به انسانها بگیرند، اعتبار و دقتشان تحت آزمایشاتی بسیار دقیق تأیید شده است.

سانکار نارایانان، مسئول اجرایی ارشد شرکت هوش مصنوعی فرکتال آنالیتیکس، میگوید: «هوش مصنوعی باید قابل رهگیری و توضیحپذیر باشد. این فناوری باید قابل اعتماد، بدون سوگیری و مقاوم باشد تا از آسیب خطاهای احتمالی در طول چرخه زندگی هوش مصنوعی در امان بماند.» توضیحپذیری، پایه و اساس هوش مصنوعی اخلاقی است. با درک فرآیند تصمیمگیری، میتوانیم بدون نگرانی در مورد سوگیری و عواقب آن، بیشتر از قبل برای حل مسائل و ارتقای جامعه از هوش مصنوعی بهره بگیریم. در این صورت، حتی در صورت مواجهه با خطا، دلیلش را میدانیم و میتوانیم منشأ آن (دادههای آموزشی یا منبع کد داخلی) را اصلاح کنیم.

به عقیده نارایانان، مشکل اصلی مدلسازی در حال حاضر این است که هوش مصنوعی، صرفاً فرآیند پردازش اطلاعات انسانها را تقلید میکند. این در حالی است که طبق تحقیقات اقتصاددانان، شیوه تفکر انسانها اغلب غیرمنطقی و توضیحناپذیر میباشد.

وی ادامه میدهد: «ما انسانها حتی اگر نتوانیم به صورت منطقی فرآیند تفکرمان را توضیح دهیم بر آن تکیه میکنیم؛ این دقیقاً همان اتفاقی است که در جعبه سیاه میافتد.»

با این وجود، انتخاب بهترین دادههای ورودی و نظارت بر آنچه داخل جعبه اتفاق میافتد در ارتقای هوش مصنوعی اخلاقی و کمرنگ کردن نگرانیهای موجود در مورد عدم شفافیت این فناوری، نقش مهمی ایفا میکند.

ورود متغیر نسانی

کلید موفقیت جعبه شیشهای را میتوان افزایش تعامل انسانها با الگوریتم دانست. جانا اگرز، مدیرعامل شرکت هوش مصنوعی نارا لاجیکز در بوستون، توضیح میدهد: «توسعه و پیادهسازی جعبه سیاه هوش مصنوعی تحت تأثیر سوگیری انسانی و سوگیری دادهای قرار میگیرد. اولین گام در راستای دستیابی به توضیحپذیری و شفافیت، ارائه بافت و زمینهای کلی به الگوریتم و به کاربران است؛ بدین منظور باید اطلاعاتی کلی در مورد دادههای آموزشی و پارامترهای به کاررفته در الگوریتمها به افراد ارائه شود.»

گام دیگر در جهت حل مشکلات جعبه سیاه هوش مصنوعی، تحلیل محتوای ورودی و خروجی به منظور درک بهتر فرآیند تصمیمگیری است. با شفاف شدن این فرآیند، اخلاقیات انسانی در آن نمود پیدا میکند.

اگرز میگوید: «بسیاری اوقات هوش مصنوعی در اشتباه است و حق با انسانهاست. باید آمادگی پذیرش این موارد را داشته باشیم.»

شفافسازی جعبه سیاه هوش مصنوعی به معنی استفاده از مباحث ساده و قابل فهم علوم داده به منظور ایجاد یک متودولوژی توضیحپذیر برای انسانهاست، به نحوی که فرآیند تصمیمگیری برنامه، از جمله عواملی که در آن نقش داشتهاند و ضریب اهمیت آن عوامل، به صورت کلی مشخص و آشکار شوند.

برایان دیالساندرو، رئیس علوم داده شرکت نرمافزارهای هوش مصنوعی اسپارک بیاند، معتقد است: «در بحث در مورد توضیحپذیری، باید مقیاس شناختی انسانها را در نظر داشته باشیم. بیشتر افراد به راحتی میتوانند قانونی که پنج یا شش عامل در آن نقش دارند را درک کنند. اما اگر از این مقیاس فراتر برویم، مباحث آنقدر پیچیده میشوند که فهمشان کار آسانی نخواهد بود.»

آینده هوش مصنوعی و اخلاقیات

اخیراً بحثهای فراوانی در مورد سوگیری هوش مصنوعی، ملاحظات اخلاقی و مباحث پاسخگویی و مسئولیتپذیری سر گرفتهاند. فروشندگان، مهندسان و کاربران هریک میتوانند سهم خود را در این مسیر ایفا کنند، اما نکته اینجاست که شناسایی و حل این نوع مشکلات جعبه سیاه هوش مصنوعی کار دشواری است.

جعبه سیاه هوش مصنوعی، دست برنامهنویسان را در ارزیابی سوگیری و غربال و حذف محتوای نامناسب میبندد، چون معلوم نیست کدام قسمت از ورودی برای تولید خروجی به کار میرود.

به گفته دلساندرو، گاهی اوقات نحوه جمعآوری دادهها به شکلی است که سوگیری ایجاد میکند. ماهیت جعبه سیاه، احتمال تکرار و تشدید این مشکلات را افزایش میدهد.

به عنوان نمونه میتوان به مشکلی که برای آمازون پیش آمد اشاره کرد؛ الگوریتم استخدامی آمازون تقاضانامههای شغلی ده سال را تجزیه و تحلیل کرد تا ویژگیهای کارمندان برتر را به صورت خودکار تشخیص داده و متقاضیان جدید را با تکیه بر همین استانداردها بسنجد و امتیازدهی کند. در سال 2018، این ابزار سرتیتر خبرها را به خود اختصاص داد، چون مشخص شد به خاطر مسائلی از قبیل شکاف پرداختی و سوگیری جنسیتی در مشاغل حوزه فناوری، الگوریتم به نفع متقاضیان مرد سوگیری داشته است.

در حال حاضر، شرکتهایی که با هوش مصنوعی سروکار دارند به دنبال دستورالعملهای اخلاقی در جمعآوری داده و به کارگیری این فناوری هستند. در مه 2019، اتحادیه اروپا با انتشار بخشنامهای استاندارد، تعریف جامعی از هوش مصنوعی اخلاقی ارائه داد. متخصصان این دستاورد را گام بزرگی در جهت حل مسئله جعبه سیاه هوش مصنوعی میدانند.

نارایانان میگوید: «بخشنامه اتحادیه اروپا در مورد هوش مصنوعی قابل اعتماد، در سراسر دنیا پیشگام بوده است. این بخشنامه از کسب و کارها میخواهد به متخصصان اعتماد کرده و از ارائهدهندگان غیرحرفهای سرویسها که خود را به نام شرکتهای هوش مصنوعی جا زدهاند دوری کنند.»