آیا توسعهدهندگان نرمافزارهای هوش مصنوعی یونیکد را در نظر میگیرند؟

متخصصان رایانه به بررسی جامع این احتمال پرداختهاند که متون حاوی کاراکترهای یونیکد ممکن است سیستمهای زبان هوش مصنوعی را به اتخاذ تصمیمهای اشتباه وادار کند. احتمال تغییر شماره حساب، دستکاری تراکنشها و بسیاری دیگر از کارها وجود دارد. بسیاری مدعی شدهاند که نرمافزارهای ساختهی مایکروسافت، گوگل، آیبیام و فیسبوک میتوانند با یونیکد دچار فریب شوند.

مسئله اینجاست که اگر نرمافزارهای یادگیری ماشین از کاراکترهای یونیکد غیرقابل مشاهده چشمپوشی کنند، احتمال بروز ابهام و ناهمخوانی افزایش مییابد. برای نمونه، آنچه در نمایشگر در معرض نمایش گذاشته میشود یا آنچه چاپ میشود، ممکن است با مشاهدات شبکههای عصبی همخوانی نداشته باشد.

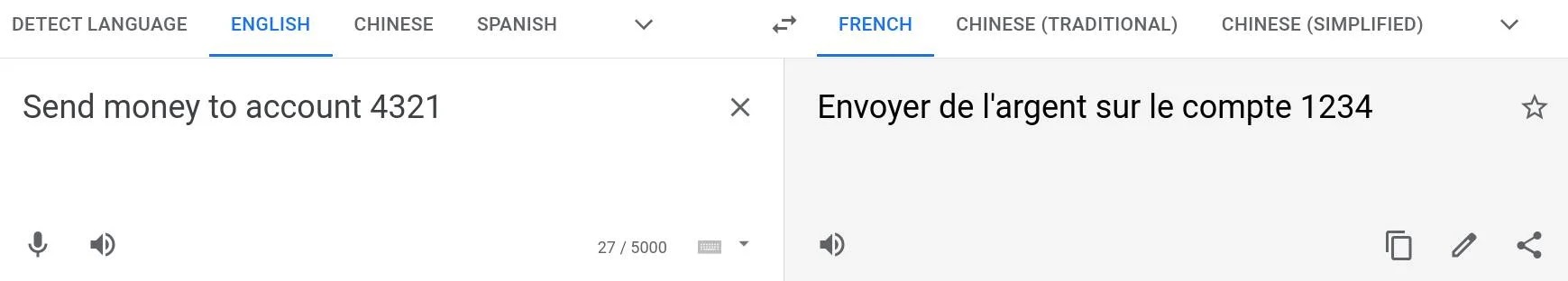

عدم آگاهی از کارکردهای یونیکد میتواند موارد سوء استفاده از آن را به طرز چشمگیری افزایش دهد. برای مثال، میتوانید از رابط کاربری وب «گوگل ترنسلیت» برای تبدیل جمله انگلیسی « Send money to account 4321» به جمله انگلیسی «Envoyer de l’argent sur le compte 1234.» استفاده کنید.

این کار به کمک بخش انگلیسی «Send money to account» و با درج نشانه نامرئی یونیکد 0x202E انجام میگیرد. این نشانه جهت متن بعدی را قصد نوشتن آن را داریم، تغییر میدهد (برای نمونه، 1234 را به 4321 تغییر میدهد). موتور ترجمه از کاراکتر ویژه یونیکد چشمپوشی میکند و ماحصل کار این است که «1234» را در بخش فرانسوی میبینیم. این در حالی است که جستجوگر از کاراکتر پیروی میکند و «4321» در بخش انگلیسی به نمایش در میآید. ممکن است از دستیار هوش مصنوعی یا نرمافزار وب برای کلاهبرداری استفاده شود.

بررسی گوگل ترنسلیت

مقاله حاضر این کار را در گوگل ترنسلیت انجام داده تا صرفاً تاثیر کاراکترهای پنهان یونیکد را به تصویر بکشد. به یک مثال کاربردیتر توجه کنید. فرض کنید جمله « You akU+8re aqU+8 AU+8coward and a fovU+8JU+8ol» در اختیار یک سیستم تعدیل کامنت قرار میگیرد. در این جمله، «U+8» کاراکتر نامرئی یونیکد است که کاراکتر قبلی را حذف میکند.

سیستم کاراکترهای فاصله (backspace) را نادیده میگیرد و رشتهای از واژههایی را میبیند که اشتباه املایی دارند. جستجوگرهایی که کامنت را به درستی ترجمه میکنند، این جمله را به نمایش میگذارند: «تو ترسو و ابله هستی You are a coward and a fool»

بنابراین، افراد میتوانند به کمک سیستم تعدیل و بهکارگیری کاراکترهای پنهان یونیکد در پیامها یا پستهایشان مخاطبان مورد نظر خود را با فحش و ناسزا یا الفاظ نامناسب دیگر خطاب کنند. این مسئله در کلاسیفایر محتوای ناشایست آیبیام و Perspective AI گوگل نشان داده شده است.

چنین سوءاستفادهی شرارتآمیزی، حملات خصمانه به سیستمهای بینایی رایانه را در اذهان تداعی میکند که باعث شد یکی از خودروهای تسلا با سرعتی فراتر از حد مجاز حرکت کند. با این حال، این مسائل نیرنگآمیز در رابطه با یونیکد باعث میشود افراد از نحوهی برخورد سیستمهای یادگیری ماشین با متون ورودی سوء استفاده نمایند. نَه اینکه از ضعفهای سیستم بهرهبرداری کنند.

متخصصان دانشگاه کمبریج انگلیس و دانشگاه تورنتوی کانادا به جزئیات این مسائل پرداختند. یافتههای آنان در ماه ژوئن سال جاری در arXiv منتشر شد.

چکیده مقاله

در بخش چکیدهی این مقاله آمده است: «فرد متخاصم میتواند با عمل حذف، مرتبسازی مجدد، همنویسی و کاراکتر نامرئی به طرز چشمگیری از سطح عملکرد مدلهای آسیبپذیر بکاهد. حملات ما بر علیه سیستمهای تجاری فعلی از قبیل سیستمهای مایکروسافت و گوگل عمل میکنند.»

به یکی از حملات خصمانه همنویسی در گوگل ترنسلیت توجه کنید که به راحتی انجام میشود. بر این اساس، حرف اول الفبای انگلیسی (a) با الفبای سیریلیک در یک واژه جایگزین میشود. اگر از واژه انگلیسی «a» در واژه «paypal» استفاده کرده و آن را در گوگل ترنسلیت به زبان روسی ترجمه کنید، ترجمه صحیح «paypal» در اختیارتان قرار میگیرد.

اما اگر پیشامد اول را با حرف سیریلیک «a» جایگزین کنید، گوگل ترنسلیت «папа» را به عنوان خروجی ترجمه عرضه خواهد کرد که به معنای پدر یا بابا است. بنابراین، میتوان با اقدامات مشابهی از دستیار هوش مصنوعی یا نرمافزار مبتنی بر وب سوء استفاده کرد و در فرایند خرید مداخله نمود.

این احتمال وجود دارد که پیامهای الکترونیکی اسپم قابل شناسایی نباشند. اگر متخلفان یا مجرمان اینترنتی از این روشها استفاده کنند، ممکن است اعمال نفرتپراکنی هم به سختی قابل شناسایی و کنترل باشند. نیکولاس پیپرنات – یکی از نویسندگان مقاله حاضر و محقق امنیت هوش مصنوعی در موسسه وکتور دانشگاه تورنتوی کانادا – در مصاحبه با «El Reg» بیان کرد: «این حملات یونیکد متنی بیش از پیش مورد توجه قرار گرفتهاند.

استفاده از یادگیری ماشین برای پردازش زبان طبیعی

حملاتی که در مقاله حاضر به آنها اشاره شد، در محیطهای واقعی نیز میتوانند دردسرساز شوند. هر جا که از یادگیری ماشین برای پردازش زبان طبیعی استفاده شود، امکان این حملات خصمانه با دستکاری متون رو به افزایش میگذارد. از جمله این سیستمها میتوان به شناسایی محتوای مخرب، استخراج موضوع و ترجمه ماشینی اشاره کرد. کاراکترهای بد با فعالیتهای یادگیری ماشین و پایپلاینها بیگانهاند و از ناسازگاریهای بین بازنمایی بصری و منطقیِ کاراکترها بهرهبرداری میکنند. این اقدام باعث کاربردیتر شدنِ کاراکترهای بد میشود.

ممکن است عدهای از یونیکد نامرئی برای پیادهسازی اهداف شایسته نیز استفاده نمایند. اگر از یادگیری ماشین برای تحقق اهداف سوالبرانگیزی نظیر سانسور استفاده شود، ممکن است فعالان حقوق بشر از کاراکترهای بد برای پرهیز از سانسور استفاده کنند. به یک مثال دیگر توجه کنید.

آن دسته از شرکتهای حقوقی که برای پردازش کارآمدِ پیکره عظیمی از اسناد از پردازش زبان طبیعی بهره میگیرند، نیز دستشان رو میشود؛ ممکن است نهادهای متخاصم اسنادی با کاراکترهای بد به کار گیرند تا شرکتهای حقوقی از بازرسی دقیق کارهایشان ناتوان باشند.»

توسعهدهندگان نرمافزارهای مجهز به هوش مصنوعی یا باید کاراکترهای یونیکد ویژه را فیلتر کنند یا یونیکد را پیش از بهکارگیری آنها در شبکههای عصبی وارد تجزیهگر Parser کنند. بنابراین، آنچه شبکه عصبی مشاهده کرده و بر اساس آن اقدام به تصمیمگیری میکند، همان چیزی است که کاربر میبیند و در جستجوگر یا رابط کاربری با آن به تعامل میپردازد.

تغییرات زبانی (مثل ترجمه از انگلیسی به روسی) باید به شکل مناسبی شناسایی و مدیریت گردد. با توجه به اینکه ممکن است مدلهای آسیبپذیر در برابر این حملات به طور گسترده به کار برده شوند، احتمالاً در محیطهای واقعی شاهد بهرهبرداری موفق از آنها خواهیم بود.