تحقیقات یادگیری ماشین و بایدها و نبایدهای آن ؛ از کجا شروع کنیم؟

جمعی از برترین متخصصان هوش مصنوعی جهان در رویداد بینالمللی TNW حضور به عمل خواهند آورد تا درباره آینده این حوزه و همچنین تحقیقات یادگیری ماشین به بحث و تبادل نظر بپردازند.

یادگیری ماشین در بسیاری از صنایع و حوزههای علمی، ابزاری مهم به شمار میآید. با این حال، تحقیقات یادگیری ماشین و توسعه محصول چالشهایی را پیشروی افراد [فعال در این حوزه] قرار داده است که اگر به آنها پرداخته نشود، ممکن است پروژه در مسیر نادرستی قرار گیرد.

مایکل لونز، دانشیار مدرسه ریاضی و علوم محاسباتی از دانشگاه هریوت وات، ادینبورگ، در نسخه پیشچاپ مقاله خود که اخیراً در سایت arXiv منتشر شده است، فهرستی از بایدها و نبایدهای تحقیقات یادگیری ماشین را ارائه کرده است.

این مقاله چالشهای مراحل مختلف تحقیقات یادگیری ماشین را دربر میگیرد. لونز در مورد مقاله خود میگوید: «این مقاله شامل درسها و نکتههایی است که هنگام انجام تحقیقات یادگیری ماشین در محیط دانشگاهی و هنگام راهنمایی دانشجویان برای انجام تحقیقات، آموختهام». اگرچه این مقاله برای پژوهشگران دانشگاهی نوشته شده است، اما برنامهنویسانی که در حال ساخت مدلهای یادگیری ماشین برای استفاده در دنیای واقعی هستند، نیز میتوانند از دستورالعملهای آن استفاده کنند.

در ادامه نکات مفیدی از این مقاله را ارائه میکنیم.

لزوم توجه بیشتر به دادهها

رشد و توسعه مدلهای یادگیری ماشین منوط به داده ها است. در همین راستا، لونز در سرتاسر مقاله به اهمیت توجه بیشتر به دادهها در تمام مراحل یادگیری ماشین اشاره میکند. به عبارتی، باید مراقب نحوه جمعآوری و آمادهسازی دادهها و استفاده از آنها برای آموزش و ارزیابی مدلهای یادگیری ماشین باشید.

اگر دادهها از منبع معتبری تهیه نشده و به شیوهای قابل اعتماد جمعآوری نشده باشند، هیچ توان محاسباتی و هیچ فناوری پیشرفتهای نمیتواند کارساز باشد. همچنین، لازم است تمام تلاش خود را به بررسی منشاء و کیفیت دادهها معطوف کنید. لونز مینویسد: «تصور نکنید به دلیل اینکه در چندین مقاله از یک دیتاست استفاده شده است، آن دیتاست از کیفیت خوبی برخوردار است».

دیتاستها ممکن ایرادهای مختلفی داشته باشند، ایرادهایی که در نهایت به یادگیری اشتباه مدل منجر میشوند. برای مثال، اگر بر روی مسئله طبقه بندی کار میکنید و در دیتاست مورد استفاده، تعداد نمونههای یک کلاس بسیار زیاد و تعداد نمونههای کلاس دیگر بسیار اندک است، مدل یادگیری ماشین آموزشدیده ممکن است همه ورودیها را در طبقه بزرگتر پیشبینی کند. در این صورت با مشکل «کلاس نامتوازن» (class imbalance) روبهرو هستید.

اگرچه، مسئله کلاس نامتوازن به سرعت با شیوههای مختلف دادهکاوی برطرف میشود، اما برطرف کردن مشکلات دیگر نیاز به دقت و تجربه بیشتری دارد. مثلاً، اگر تمام تصاویر موجود در دیتاست در روز روشن گرفته شده باشند، مدل یادگیری ماشین در پیشبینی عکسهای تیره عملکرد ضعیفی خواهد داشت. نمونه بارزتر این مشکل در تجهیزات مورد استفاده برای جمعآوری دادهها به چشم میخورد. برای مثال، اگر تمام عکسهای دیتای آموزشی با یک دوربین عکاسی گرفته شده باشند، مدل احتمالاً ردپای بصری منحصر به فرد دوربین را تشخیص داده و در پیشبینی تصاویر گرفته شده با سایر دوربینها عملکرد ضعیفی خواهد داشت. در مجموع، دیتاستهای یادگیری ماشین ممکن است سوگیریهای مختلفی داشته باشند.

کمیت دادهها نیز بسیار حائز اهمیت است و باید دادهی کافی در اختیار داشته باشید. طبق توضیحات لونز، «اگر سیگنال قوی باشد، میتوانید با دادهی کمتر نیز کار خود را انجام دهید، اما اگر سیگنال ضعیف باشد، به دادههای بیشتری نیاز دارید».

در برخی از حوزهها، میتوان کمبود داده را با تکنیکهایی مانند اعتبارسنجی متقابل و دادهافزایی جبران کرد. با این حال، به طور کلی باید بدانید که هرچه مدل یادگیری ماشین پیچیدهتر باشد، به دادههای آموزشی بیشتری نیاز خواهید داشت. برای مثال، چند صد نمونه آموزشی ممکن است برای آموزش یک مدل رگرسیون ساده با چند پارامتر کافی باشد. اما اگر قصد دارید یک شبکه عصبی عمیق با میلیونها پارامتر ایجاد کنید، به دادههای آموزشی بسیار بیشتری نیاز خواهید داشت.

نکته مهم دیگری که لونز در مقاله خود به آن اشاره میکند، لزوم تفکیک دقیق دیتای آموزش و دیتای آزمایشی است. مهندسان یادگیری ماشین معمولاً بخشی از دادههای خود را برای آزمایش مدل آموزش دیده کنار میگذارند. اما گاهی اوقات، دادههای آزمایشی به فرایند آموزش رخنه میکند. این امر ممکن است به ایجاد مدلهایی ختم شود که نمیتوان آنها را به دادههای جمعآوری شده از دنیای واقعی تعمیم داد.

لونز یادآوری میکند که: «اجازه ندهید دادههای آزمایشی به فرایند آموزش راه پیدا کنند. بهترین روش مقابله با آن، این است که در همان ابتدای امر، یک زیرمجموعه ازدیتاست را جدا کرده و در پایان تنها یک مرتبه از این زیرمجموعه مستقل برای اندازهگیری تعمیمپذیری مدل استفاده کنید».

در سناریوهای پیچیدهتر، بهتر است یک «دیتاست اعتبارسنجی» نیز داشته باشید. منظور از دیتاست اعتبارسنجی، دیتاست آزمایشی دیگری است که مدل یادگیری ماشین را در فرایند نهایی مورد ارزیابی قرار میدهد. برای مثال، اگر از اعتبارسنجی متقابل (cross-validation) یا یادگیری جمعی (ensemble learning) استفاده میکنید، ممکن است آزمون اصلی، ارزیابی دقیقی از مدل شما ارائه ندهد. در این شرایط استفاده از دیتاست اعتبارسنجی میتواند کارساز باشد.

به گفته لونز: «اگر داده کافی دراختیار دارید، بهتر است بخشی از را کنار بگذارید و تنها یک مرتبه برای ارائه برآوردی بیطرفانه از نمونههای نهایی استفاده کنید».

لزوم شناخت مدل مورد نظر و مدلهای دیگر

امروزه، یادگیری عمیق مورد توجه همگان قرار گرفته است. اما لزوماً یادگیری عمیق کلید رفع هر مشکلی نیست. در واقع، حتی یادگیری ماشین لزوماً حلال تمام مشکلات نیست. گاهی اوقات، عملکرد تطبیق الگوها و قوانین ساده با کسری از دادهها و توان محاسباتی اندک با عملکرد پیچیدهترین مدلهای یادگیری ماشین برابری میکند.

اما وقتی صحبت از مشکلاتی به میان میآید که مخصوص مدلهای یادگیری ماشین هستند، همیشه باید فهرستی از الگوریتمهای منتخب داشته باشید و آنها را ارزیابی کنید. لونز معتقد است: «به طور کلی، چیزی به نام بهترین مدل یادگیری ماشین وجود ندارد. در واقع، در نظریهای به نام ’ناهار مجانیNo Free Lunch theorem ‘ شواهدی دالِ بر این وجود دارد که در یادگیری ماشین هیچ رویکرد خاصی برای حل یک مشکل احتمالی بهتر از رویکردهای دیگر نخواهد بود».

در گام نخست، باید به تطبیق مدل با مشکل بپردازید. برای مثال، بسته نوع خروجی مورد نظر (گسسته یا پیوسته)، باید الگوریتم یادگیری ماشین مناسب و ساختار مناسب را انتخاب کنید. علاوه بر این، نوع دادهها (مثلاً، جداول، تصاویر، متنِ ساختاریافته و بدون ساختار و غیره) میتواند عامل تعیینکنندهی کلاسِ مدلِ مورد استفاده باشد.

یکی از نکتههای مهمیکه لونز در مقاله خود مطرح میکند، لزوم اجتناب از پیچیدگی بیش از حد است. برای مثال، اگر مشکل شما با یک درخت تصمیم ساده یا مدل رگرسیون حل شود، استفاده از یادگیری عمیق بیفایده خواهد بود.

لونز در مورد دوبارهکاری نیز هشدار میدهد. با توجه به اینکه یادگیری ماشین یکی از داغترین موضوعات پژوهش است، همیشه این احتمال وجود دارد که شخص دیگری مشکلی مشابه مشکل شما را حل کرده باشد. در چنین شرایطی، عاقلانهترین کار این است که آنها را بررسی کنید. این امر میتواند در وقت شما صرفه جویی کند زیرا احتمالاً پیش از این سایر محققان نیز با چالشهایی که به دنبال حل آنها هستید روبرو بوده و آنها را برطرف کردهاند.

لونز معتقد است: «نادیده گرفتن مطالعات قبلی به معنای از دست دادن اطلاعات ارزشمند است».

با بررسی مقالات و پژوهشهای محققان دیگر، احتمالاً مدلهای یادگیری ماشین دیگری پیدا خواهید کرد که بتوانید از آنها برای حل مسئله خود استفاده کنید. در حقیقت، محققان یادگیری ماشین اغلب از الگوهای یکدیگر برای صرفه جویی در وقت و منابع محاسباتی استفاده میکنند و با یک مبنای اولیه و مورد اعتماد جامعه یادگیری ماشین شروع میکنند.

لونز هشدار میدهد که باید از سندرم «در اینجا اختراع نشده است» اجتناب کرد؛ به عبارت دیگر، اگر تنها از مدلهایی استفاده کنید که در سازمان خود اختراع کردهاید، ممکن است بهترین مدلهای ممکن برای حل مشکل را نادیده بگیرید.

لزوم شناخت هدف نهایی و الزامات آن

اگر به طور دقیق موارد کاربرد مدل یادگیری خود را بشناسید، میتوانید به خوبی آن را توسعه دهید. اگر یادگیری ماشین را صرفاً برای اهداف دانشگاهی و پیش بردن مرزهای علم ایجاد میکنید، ممکن است در مورد نوع دادهها یا الگوریتمهای یادگیری ماشینی مورد استفاده، هیچ محدودیتی نداشته باشید. با اینحال، هیچ پژوهش دانشگاهی تا ابد در آزمایشگاههای تحقیقاتی محبوس نمیماند.

به نوشته لونز، «[در] بسیاری از مطالعات دانشگاهی، هدف نهایی تولید مدل یادگیری ماشینِ قابل استفاده در دنیای واقعی است؛ بنابراین، بهتر است هر چه زودتر در مورد نحوه استقرار آن در دنیای واقعی چارهای بیاندیشید».

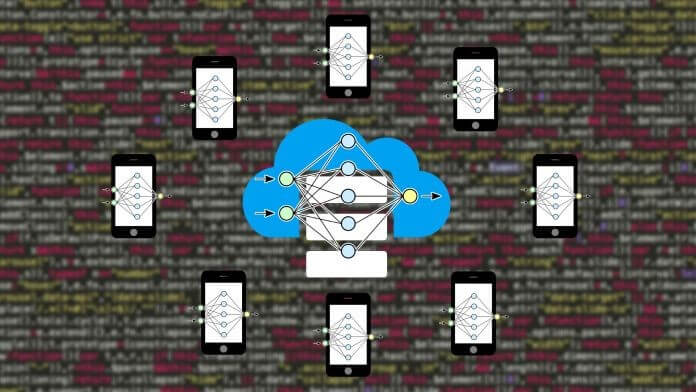

برای نمونه، اگر قرار است مدل شما برای ساخت نرمافزارهایی استفاده شود که به جای سرورهای بزرگ باید بر روی دستگاهها اجرا شوند، نمیتوانید از شبکه های عصبی بزرگ استفاده کنید که نیاز به مقدار زیادی حافظه و فضای ذخیرهسازی دارند. باید مدلهای یادگیری ماشین خود را طوری طراحی کنید که در محیطهایی با منابع محدود نیز قابل اجرا باشند.

یکی دیگر از مسائل پیشرو لزوم توضیحپذیری است. در برخی از حوزهها، مانند امور مالی و بهداشت و درمان، در صورت درخواست کاربر، برنامهنویسان از نظر قانونی ملزم به ارائه توضیحاتی در مورد تصمیمات الگوریتمی هستند. در چنین مواردی، استفاده از مدل جعبه سیاه امکانپذیر نیست. در چنین شرایطی، حتی اگر مدل عملکرد مطلوبی داشته باشد، اما تفسیرناپذیری آن را بلااستفاده میسازد. در عوض، یک مدل شفافتر، مانند درخت تصمیم، به احتمال زیاد انتخاب بهتری خواهد بود، حتی اگر عملکرد چندان مطلوبی نداشته باشد. به عبارت دیگر، اگر لزوم استفاده از یادگیری عمیق برای نرمافزارتان برای شما به اثبات رسیده است، باید تکنیکهایی را بررسی کنید که بتوانند تفسیرهایی موثق از فعالسازی در شبکه عصبی ارائه دهند.

در مقام یک مهندس یادگیری ماشین، ممکن است از الزامات مدل خود آگاهی دقیقی نداشته باشید. بنابراین، لازم است با متخصصان این حوزه مشورت کنید زیرا این متخصصان میتوانند شما را در مسیر درست هدایت کرده و تعیین کنند آیا در جهت حل مشکل مورد نظر گام بر میدارید یا خیر.

طبق توضیحات لونز «عدم توجه به نظر متخصصان هر حوزه ممکن است باعث ایجاد پروژههایی شود که به مسائل بیثمر میپردازند یا پروژههایی که مسائل مهم را با روشهایی نامناسب حل میکنند».

برای مثال، اگر یک شبکه عصبی ایجاد کردهاید که تقلب در تراکنشهای بانکی را با دقت بسیار بالایی مشخص میکند، اما توضیحی درباره نحوهی تصمیمگیری خود ارائه نمیدهد، موسسات مالی نمیتوانند از آن استفاده کنند.

روشهای اندازهگیری و گزارشی را مشخص کنید/ لزوم شناخت روشهای اندازهگیری و گزارش آنها

روشهای مختلفی برای اندازهگیری عملکرد مدلهای یادگیری ماشین وجود دارد، اما همه آنها لزوماً برای مشکل مورد بررسی مناسب نیستند.

بسیاری از مهندسان یادگیری ماشین از «آزمون دقت» (accuracy test) برای رتبهبندی مدلهای خود استفاده میکنند. آزمون دقت درصد پیشبینیهای صحیح مدل را محاسبه میکند. این عدد در برخی موارد میتواند گمراه کننده باشد.

برای مثال، دیتاستی متشکل از اسکنهای اشعه ایکس را در نظر بگیرید که برای آموزش مدل یادگیری ماشین در تشخیص سرطان استفاده میشود. دادههای شما نامتعادل است و 90 درصد نمونههای آموزشی با برچسب خوشخیم و تعداد بسیار کمی با برچسب بدخیم طبقهبندی شدهاند. اگر مدل آموزشی شما در آزمون دقت نمره 90 کسب کند، احتمالاً یاد گرفته است که همه عکسها را خوشخیم برچسبگذاری کند. در صورتی که از این مدل در یک نرمافزار و در محیط واقعی استفاده شود، احتمالاً مواردی را به اشتباه برچسبگذاری خواهد کرد؛ این امر نتایج فاجعهباری در پی خواهد داشت. در چنین مواردی، تیم یادگیری ماشین باید از آزمونهایی استفاده کند که به عدم تعادل کلاس حساس نباشند یا با کمک ماتریس درهمریختگی (confusion matrix)، دیگر معیارهای اندازهگیری را بررسی کند. تکنیکهای جدیدتر میتوانند عملکرد مدل را در حوزههای مختلف به دقت اندازهگیری کنند.

علاوه بر این، ممکن است برنامهنویس یادگیری ماشین معیارهای متعددی را با در نظر گرفتن نرمافزار مورد استفاده اندازهگیری کند. برای نمونه، در مثال تشخیص سرطان، کاهش موارد منفی کاذب تا حد امکان از اهمیت بسیاری برخوردار است، حتی اگر به قیمت پایین آمدن دقت مدل یا افزایش جزئی مثبت کاذب باشد. بهتر است چند فرد سالم برای تشخیص به بیمارستان فرستاده شوند تا اینکه بیمارانِ مبتلا به سرطان پیشرفته شناسایی نشوند.

لونز خاطرنشان میسازد که هنگام مقایسه چندین مدل یادگیری ماشین برای حل یک مشکل، اعداد بزرگتر لزوماً به معنای بهتر بودن مدل نیستند. تفاوت عملکرد ممکن است به دلیل آموزش و آزمایش مدل بر روی بخشهای مختلف یک دیتاست یا اجرا بر روی دیتاستی کاملاً متفاوت بدست آمده باشد.

او معتقد است: «برای اینکه مقایسه دو رویکرد منصفانه باشد، باید اجرای مدلهای مورد مقایسه جدید باشد، همه مدلها به یک اندازه بهینهسازی شده باشند، چندین مرتبه ارزیابی شوند … و سپس از آزمونهای آماری برای تعیین سطح معناداری تفاوت عملکرد مدلها استفاده شود».

لونز همچنین در مورد دستبالاگرفتن قابلیتهای مدل هشدار میدهد. او مینویسد: «یکی از اشتباهات رایج کلیگوییهایی است که دادههای آموزشی و ارزیابی مدل، از آنها پشتیبانی نمیکند».

بنابراین، در تمام گزارشات مربوط به عملکرد مدل باید نوع دادهای که مدل بر روی آن آموزش دیده و آزمایش شده است، قید گردد. اعتبارسنجی مدل بر روی دیتاستهای متعدد تصویری عینیتر از قابلیتهای آن ارائه میدهد، اما کماکان لازم است نسبت به نوع خطای دادهای که در بالا مطرح کردیم، محتاط باشید.

شفافیت نیز سهم بسزایی در سایر تحقیقات یادگیری ماشین دارد. اگر معماری مدل خود و همچنین روند آموزش و اعتبارسنجی را به طور کامل شرح دهید، سایر محققانی که یافتههای شما را مطالعه میکنند میتوانند از آنها در کارهای بعدی خود استفاده کنند یا حتی به ایرادات احتمالی روششناسی پژوهش شما کمک کنند. در نهایت، به دنبال تکرارپذیری باشید. اگر کد منبع و پیادهسازی مدل خود را منتشر کنید، میتوانید در کارهای آینده ابزارهای فوق العادهای در اختیار جامعه یادگیری ماشین قرار دهید.

یادگیری ماشین کاربردی

جالب اینجاست که تقریباً تمام مواردی که لونز در مقاله خود به آنها اشاره کرده است در یادگیری ماشین کاربردی نیز مصداق دارد. یادگیری ماشین کاربردی به شاخهای از یادگیری ماشین اطلاق میشود که دغدغه آن ادغام مدلها در محصولات واقعی است. با این حال، ذکر این نکات که فراتر از تحقیقات دانشگاهی است، در برنامههای کاربردی و محیط واقعی ضروری به نظر میرسد.

زمانی که صحبت از دادهها به میان میآید، مهندسان یادگیری ماشین باید قبل از گنجاندن مدلها در محصولات، ملاحظات بیشتری را در نظر بگیرند. برخی از این ملاحظات، پیرامون حریم خصوصی و امنیت دادهها است. برخی هم به رضایت کاربر و محدودیتهای قانونی اشاره دارد. بسیاری از شرکت ها به دلیل استخراج دادههای کاربران بدون رضایت آنها، دچار مشکل شدهاند.

موضوع مهم دیگری که در یادگیری ماشین کاربردی اغلب به دست فراموشی سپرده میشود، پوسیدگی مدل (model decay) است. برخلاف تحقیقات دانشگاهی، مدلهای یادگیری ماشین مورد استفاده در محیط واقعی باید به طور مرتب بازآموزی و بهروز رسانی شوند. به دلیل اینکه دادهها هر روزه تغییر میکنند، مدلهای یادگیری ماشین «میپوسند» و عملکرد آنها ضعیفتر میشود. برای مثال، با تغییر عادات زندگی در دوران قرنطینه، سیستمهای یادگیری ماشین که بر روی دادههای قدیمیآموزش دیده بودند، شکست خورده و نیاز به بازآموزی دارند. در همین راستا، با ظهور روندهای جدید و تغییر عادات گفتاری و نوشتاری، الگوهای زبانی باید دائماً به روز رسانی شوند. به موجب این تغییرات، تیم تولید یادگیری ماشین باید راهکاری برای جمعآوری دادههای جدید و بازآموزی دورهای مدلهای خود طراحی کنند.

در نهایت، یکپارچهسازی به چالش بزرگی در پروژههای یادگیری ماشین کاربردی تبدیل خواهد شد. لذا، این سوالات مطرح میشوند که: سیستم جدید یادگیری ماشین چگونه با نرمافزارهای فعلی یک سازمان تعامل برقرار میکند؟ آیا زیرساخت دادهها آماده اتصال به خط یادگیری ماشین است؟ آیا زیرساخت فضای اَبری یا سرور از استقرار و مقیاسبندی مدل تولید شده پشتیبانی میکند؟ پاسخ به این سوالات میتواند موفقیت یا شکست استقرار محصولِ جدید یادگیری ماشین را تعیین کند.

برای مثال، آزمایشگاه تحقیقاتی هوش مصنوعی OpenAI به تازگی نسخه آزمایشی مدل Codex API خود را برای ارزیابی عمومی راهاندازی کرده است. اما به دلیل اینکه سرورهای شرکت نتوانستند پاسخگوی مقیاس بالای تقاضای کاربران باشند، این راهاندازی به شکست انجامید.

در این نوشتار نکاتی چند در مورد ارزیابی پروژهها و تحقیقات یادگیری ماشین و پیشگیری از اشتباهات احتمالی ارائه شد. برای جزئیات بیشتر در مورد اشتباهات رایج در روند تحقیق و توسعه یادگیری ماشین، میتوانید به مقاله کامل لونز، با عنوان «چگونه از مشکلات یادگیری ماشین جلوگیری کنیم: راهنمای محققان دانشگاهی» مراجعه کنید.

جدیدترین اخبار هوش مصنوعی ایران و جهان را با هوشیو دنبال کنید