متا بزرگترین مدل هوش مصنوعی خود را منتشر کرد

شرکت متا اعلام کرده به زودی مدل Llama 3.1 405B را منتشر خواهد کرد، مدلی متشکل از 405 میلیارد پارامتر

شرکت متا اعلام کرده به زودی مدل Llama 3.1 405B را منتشر خواهد کرد، مدلی متشکل از 405 میلیارد پارامتر که مدل زبانی بزرگی محسوب میشود.

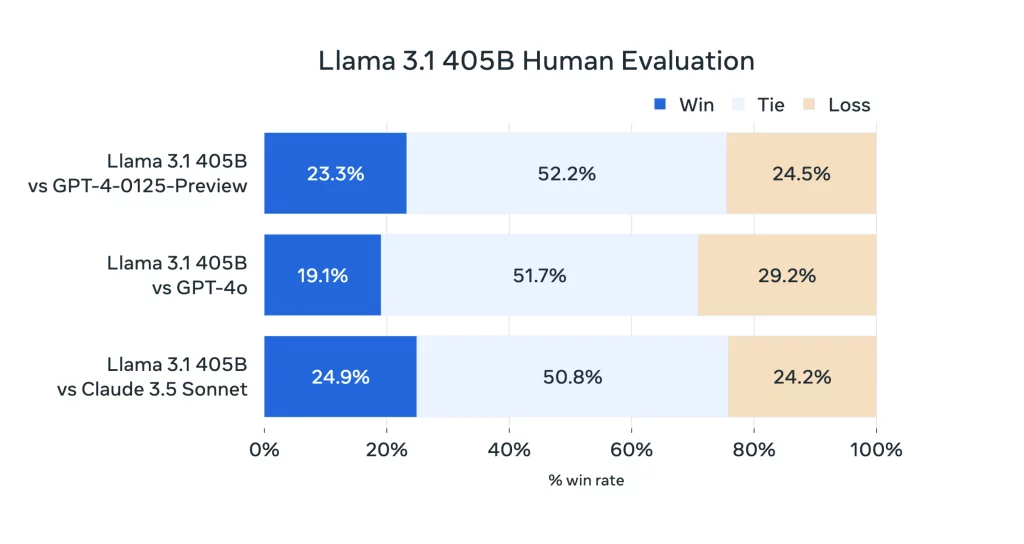

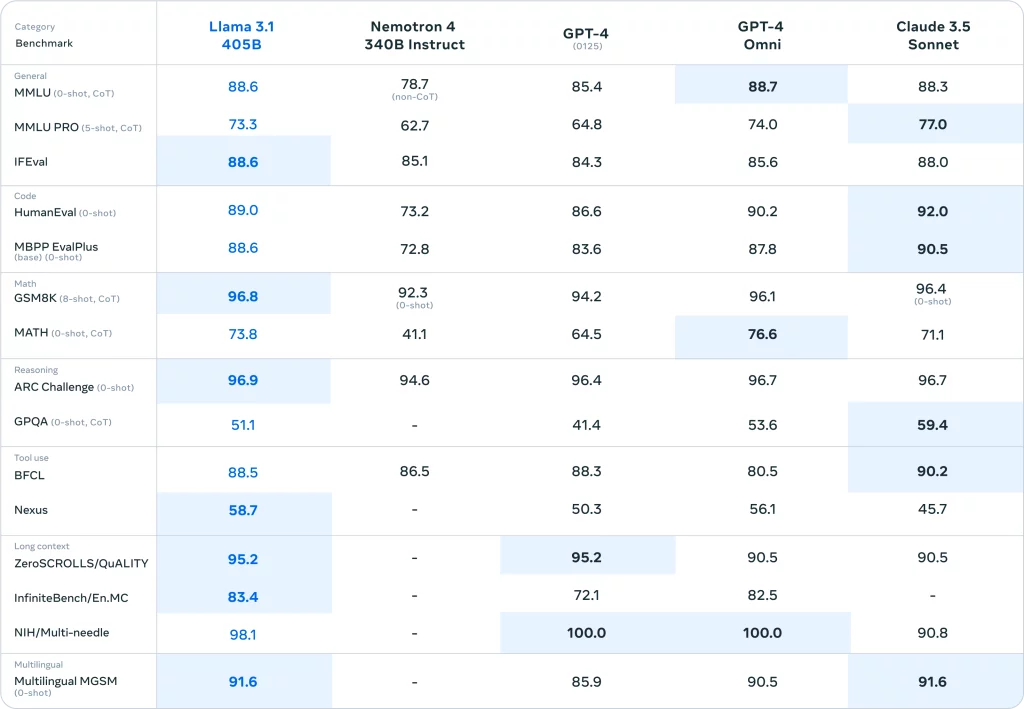

405 میلیارد پارامتر، مدل Llama 3.1 405B را بزرگترین مدل منبع باز موجود نمیکند، اما بزرگترین مدلی است که در سالهای اخیر منتشر شده. این مدل با استفاده از 16,000 پردازنده گرافیکی Nvidia H100 آموزش دیده است، همچنین از تکنیکهای آموزشی و توسعه جدیدتری استفاده کرده که متا ادعا میکند میتواند با مدلهای پیشرو مانند GPT-4o و Claude 3.5 رقابت میکند.

مانند مدلهای قبلی متا، Llama 3.1 405B برای دانلود یا استفاده در پلتفرمهای ابری مانند AWS، Azure و Google Cloud در دسترس است. همچنین در واتساپ و Meta.ai استفاده میشود.

مانند سایر مدلهای هوش مصنوعی مولد مدل جدید شرکت متا میتواند طیف وسیعی از وظایف مختلف را انجام دهد، از کدنویسی و پاسخدادن به سؤالات پایه ریاضی گرفته تا خلاصهکردن اسناد به هشت زبان (انگلیسی، آلمانی، فرانسوی، ایتالیایی، پرتغالی، هندی، اسپانیایی و تایلندی).

متا در حال آزمایش مدلهای چندوجهی است. مدلهایی که توانایی پردازش تصویر، صدا یا موارد دیگر را داشته باشند. با این حال، این مدلها هنوز برای عرضه عمومی آماده نیستند.

برای آموزش Llama 3.1 405B، متا از مجموعه داده ای متشکل از 15 تریلیون توکن تا سال 2024 استفاده کرد. این شرکت همچنین از داده های مصنوعی (داده های تولید شده توسط سایر مدل های هوش مصنوعی) برای تنظیم دقیق Llama 3.1 405B استفاده کرد. اکثر بازیگران بزرگ هوش مصنوعی، از جمله OpenAI و Anthropic، در حال بررسی کاربرد داده های مصنوعی برای بهبود آموزش هوش مصنوعی خود هستند، اما برخی از کارشناسان معتقدند که داده های مصنوعی به دلیل پتانسیل آن برای تشدید سوگیری مدل، باید آخرین راه حل ما باشد.

متا از افشای اینکه دادهها آموزشی این مدلها دقیقاً از کجا آمدهاند (خارج از صفحات وب و فایلهای عمومی) خودداری میکند. بسیاری از بازیگران هوش مصنوعی مولد دادههای آموزشی را به عنوان یک مزیت رقابتی میبینند و بنابراین هر گونه اطلاعات مربوط به آن را محرمانه تلقی میکنند.

گزارش اخیر رویترز نشان داد که متا در مقطعی با وجود هشدارهای وکلای خود، از کتابهای الکترونیکی دارای حق چاپ برای آموزش هوش مصنوعی استفاده کرده است. این شرکت به طور بحث برانگیزی هوش مصنوعی خود را ب استفاده از عکسها و کپشنهای اینستاگرام و فیسبوک آموزش میدهد. علاوه بر این، متا، همراه با OpenAI، درگیر شکایت مداوم نویسندگان، و مؤلفها، به دلیل ادعای استفاده غیرمجاز این شرکتها از دادههای دارای حق نشر برای آموزش مدلهایشان است.

دو مدل جدید و کوچکتر دیگر که متا امروز رونمایی کرد، Llama 3.1 8B و Llama 3.1 70B – نسخههای به روز شده مدلهای Llama 3 8B و Llama 3 70B این شرکت که در آوریل منتشر شدند. این مدلها نیز مانند مدل بزرک 405 میلیاردی متا دارای پنجرههای 128,000 توکنی هستند. پنجره مدلهای قبلی تنها به 8,000 توکن میرسید که این ارتقا بزرگی در این مدلها محسوب میشود. نتیجه این ارتقا در عمل امکان پاسخهای طولانیتر و کاملتر مدلهای Llama به کاربر است.

Llama 3 405B میتواند در مقایسه با GPT-4 همتراز عمل میکند و در مقایسه با GPT-4o و Claude 3.5 به نتایج کمی ضعیفتر دست مییابد. درحالیکه Llama 3 405B در اجرای کد و تولید نمودارها بهتر از GPT-4o است، قابلیتهای چندزبانه آن به طور کلی ضعیفتر است و Llama 3 405B در برنامهنویسی و استدلال کلی از Claude 3.5 عقبتر است. و به دلیل اندازه آن، برای اجرا به سختافزار قوی نیاز دارد. شاید به همین دلیل است که متا مدلهای جدید کوچکتر خود، Llama 3.1 8B و Llama 3.1 70B، را برای برنامههای کاربردی همهمنظوره مانند تقویت چتباتها و تولید کد معرفی میکند.