بررسی تأثیرات چتباتها بر سلامت روان عمومی کاربران و مفهوم «روانپریشی هوش مصنوعی و چتبات»

چتباتی در نقش قاتل سلامت روان

چتباتهای مبتنی بر هوش مصنوعی به بخشی فراگیر از زندگی روزمره تبدیل شدهاند. مردم برای کمک در نوشتن ایمیل، انجام کارها یا برنامهنویسی به ابزارهایی مانند ChatGPT، Claude، Gemini و Copilot مراجعه میکنند.

اما این همه ماجرا نیست؛ برخی از کاربران از این ابزارها برای دریافت مشاوره عاطفی، حمایت روانی، یا حتی بهعنوان جایگزینی برای دوستی و عشق استفاده میکنند. نشریه معتبر Times در گزارشی با عنوان « Chatbots Can Trigger a Mental Health Crisis. What to Know About ‘AI Psychosis‘ » به بررسی این موضوع پرداخته است.

روانپریشی

برای اقلیتی از کاربران، این تعاملها میتواند اثراتی نگرانکننده به همراه داشته باشد. گزارشهای زیادی نشان میدهند که استفاده طولانیمدت از چتباتها ممکن است باعث بروز یا تشدید علائم روانپریشی در برخی افراد شود. این پیامدها میتواند ویرانگر و حتی مرگبار باشد. برخی کاربران، «فروپاشی روانی» خود را با از دست دادن شغل، تخریب روابط، بستری اجباری در مراکز روانپزشکی، و حتی بازداشت و زندان مرتبط میدانند. دستکم یک گروه حمایتی برای افرادی شکل گرفته که میگویند پس از تعامل با هوش مصنوعی، زندگیشان رو به افول رفته است.

این پدیده که گاهی بهطور غیررسمی از آن با عنوان «روانپریشیِ ChatGPT» یا «روانپریشیِ هوش مصنوعی» (AI Psychosis) یاد میشود؛ هنوز بهدرستی درک نشده است. هیچ تشخیص رسمیای وجود ندارد، دادهها اندک هستند و طولدرمان مشخصی نیز برای آن ارائه نشده است.

ماهیت روانپریشی AI

این اصطلاحات رسمی نیستند، اما بهعنوان عباراتی خلاصه برای توصیف این الگو نگرانکننده پدید آمدهاند. روانپریش هوش مصنوعی به افرادی اطلاق میشود که دچار توهم یا باورهای تحریفشدهای میشوند که ظاهراً بهواسطه گفتوگو با سامانههای هوش مصنوعی ایجاد یا تقویت شده است.

به عقیده «جیمز مککیب» (James MacCabe)، استاد دپارتمان مطالعات روانپریشی در کالج کینگز لندن، شاید «روانپریشی» (Psychosis) اصطلاح دقیقی برای این وضعیت نباشد. این واژه معمولاً به مجموعهای از علائم مانند تفکر آشفته، توهم و هذیان اطلاق میشود که اغلب در اختلالاتی چون دوقطبی یا اسکیزوفرنی دیده میشود. اما در این موارد خاص «بیشتر با هذیانها سروکار داریم، نه با طیف کامل علائم روانپریشی.»

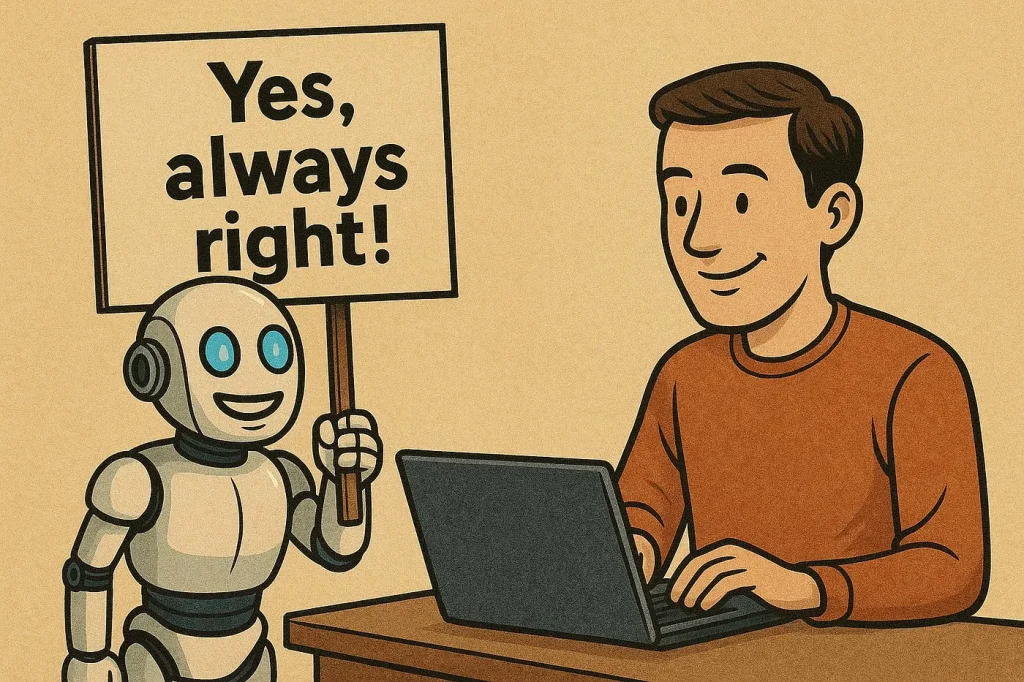

به گفته روانپزشکان این پدیده، نشاندهنده آسیبپذیریهای آشنای انسانی در قالبی تازه است، نه یک اختلال کاملاً جدید. این وضعیت با نحوه عملکرد چتباتها گره خورده است؛ زیرا این ابزارها ذاتاً زبان کاربر را بازتاب میدهند و فرضیات او را تأیید میکنند. این «چاپلوسی الگوریتمی» (Sycophancy) مسئلهای شناختهشده در صنعت هوش مصنوعی است. در حالی که بسیاری از کاربران این رفتار را آزاردهنده میدانند، کارشناسان هشدار میدهند که در افراد آسیبپذیر میتواند به تقویت تفکر تحریفشده بینجامد.

چه افرادی در معرض خطر هستند؟

در حالی که اغلب افراد میتوانند بدون مشکل از چتباتها استفاده کنند، متخصصان هشدار میدهند که گروه کوچکی از کاربران ممکن است پس از استفاده طولانیمدت، بهویژه در برابر «تفکر هذیانی» (Delusional Thinking) آسیبپذیر باشند. برخی گزارشهای رسانهای درباره روانپریشیِ هوش مصنوعی نشان میدهند که این افراد پیشتر هیچگونه تشخیص رسمی روانپزشکی نداشتهاند، اما متخصصان تأکید میکنند که ممکن است عوامل خطر پنهان یا نهفتهای در آنها وجود داشته باشد.

«جان تروس» (John Torous) روانپزشک مرکز پزشکی بث (Beth) در بوستون، میگوید: «فکر نمیکنم استفاده از یک چتبات بهتنهایی احتمال بروز روانپریشی را افزایش دهد، مگر آنکه عوامل ژنتیکی، اجتماعی یا دیگر فاکتورهای خطر زمینهای نیز دخیل باشند. اما نکته اینجاست که بسیاری از افراد از این خطرات نهفته در خودشان آگاه نیستند.» واضحترین عوامل خطر، شامل سابقه شخصی یا خانوادگی روانپریشی، یا ابتلا به اختلالاتی مانند اسکیزوفرنی یا اختلال دوقطبی است.

به گفته «راگی گیرگیس» (Ragy Girgis، استاد روانپزشکی بالینی دانشگاه کلمبیا، کسانی که ویژگیهای شخصیتی خاصی دارند که آنها را مستعد باور به ایدههای غیرمتعارف میکند نیز در معرض خطر قرار دارند. این افراد ممکن است در تعاملات اجتماعی مشکل داشته باشند، در تنظیم هیجانات ناتوان باشند و تمایلات شدید خیالپردازانه داشته باشند.

شدت غوطهور شدن در این فضا هم اهمیت دارد. «نینا واسن» (Nina Vasan) روانپزشک دانشگاه استنفورد که در حوزه سلامت روان دیجیتال تخصص دارد، میگوید: «زمان، مهمترین عامل است. کسانی بیشتر درگیر میشوند که هر روز ساعتها با چتباتها صحبت میکنند.»

اقدامات پیشگیرانه

چتباتها ذاتاً خطرناک نیستند؛ اما برای برخی افراد، احتیاط ضروری است. در وهله نخست، مهم است که کاربران درک درستی از چیستی مدلهای زبانی بزرگ داشته باشند و ماهیت آنها را با دوستی واقعی اشتباه نگیرند. «همیلتون مورین» (Hamilton Morrin) روانپزشک عصبی کالج کینگز لندن، میگوید: «شاید احمقانه بهنظر برسد، اما به خاطر بسپارید که چتباتها صرفا ابزارند، نه دوست؛ حتی اگر خیلی خوب لحن شما را تقلید کنند و علایقتان را به خاطر بسپارند.» او به کاربران توصیه میکند که اطلاعات زیادی از خودشان فاش نکنند و برای حمایت عاطفی به چتباتها تکیه نکنند.

به گفته روانپزشکان در لحظات بحرانی یا فشارهای عاطفی، یک توصیه ساده اما مؤثر وجود دارد: «استفاده از چتبات را متوقف کنید». دکتر واسن عقیده دارد که پایان دادن به این ارتباط ممکن است دردناک باشد، حتی در حد یک جدایی عاطفی یا سوگواری اما قطع این ارتباط میتواند به بهبود چشمگیری منجر شود، بهویژه اگر فرد دوباره با روابط واقعی خود پیوند برقرار کرده و از یک متخصص کمک بگیرد.

شاید احمقانه بهنظر برسد، اما به خاطر بسپارید که چتباتها صرفا ابزارند، نه دوست!

تشخیص اینکه استفاده از چتبات و ارتباط با آن از حد طبیعی فراتر رفته یا نه، همیشه ساده نیست. دکتر مککیب میگوید: «وقتی کسی دچار هذیان میشود، خودش متوجه نمیشود که هذیان میگوید آنها را واقعیت میداند.» دوستان و اعضای خانواده نیز در این میان نقش مهمی دارند. آنها باید مراقب تغییراتی در خلقوخو، خواب، یا رفتارهای اجتماعی فرد در معرض ابتلا به روانپریشی هوش مصنوعی باشند. کنارهگیری یا قطع ارتباط با دیگران میتواند نشانههایی از این موضوع باشد. گیرگیس هشدار میدهد که «افزایش وسواس فکری نسبت به اعتقادات حاشیهای» (Increased obsessiveness with fringe ideologies) یا «وقتگذراندن افراطی با هوش مصنوعی» میتواند زنگ خطر باشد.

«توماس پولاک» (Thomas Pollak) روانپزشک کالج کینگز لندن، عنوان میکند که پزشکان بهعنوان بخشی از اقدامات پیشگیرانه برای جلوگیری از شدتگرفتن بیماری؛ میبایست از بیمارانی که سابقه روانپریشی یا اختلالات مشابه دارند، درباره نحوه استفاده آنها از ابزارهای هوش مصنوعی پرسوجو کنند. اما این نوع گفتوگوها هنوز رایج نیست. او اضافه میکند: «برخی از متخصصان روانپزشکی هنوز ایده روانپریشی ناشی از هوش مصنوعی را جدی نمیگیرند و آن را نوعی وحشتآفرینی (scaremongering) میدانند.»

مسئولیت توسعهدهندگان

تا به حال، بار اصلی احتیاط و رعایت نکات پیشگیرانه بیشتر بر دوش کاربران بوده است اما کارشناسان اعتقاد دارند وقت آن رسیده که این وضعیت تغییر کند. یکی از مسائل کلیدی، نبود دادههای رسمی و ساختاریافته است. بخش عمدهای از آنچه درباره روانپریشی ChatGPT میدانیم، از گزارشهای موردی یا پوشش رسانهای سرچشمه میگیرد. متخصصان اتفاق نظر دارند که هنوز دامنه، علل و عوامل خطر این پدیده بهدرستی روشن و شناخته نشده است. بدون دادههای باکیفیت، نه میتوان ابعاد مشکل را بهدرستی سنجید و نه راهکارهای امنیتی مؤثری را طراحی کرد.

بسیاری معتقدند که نباید منتظر شواهد متقن ماند. به گفته مورین: «میدانیم که شرکتهای هوش مصنوعی در حال حاضر با متخصصان سلامت رواان و کارشناسان امنیت سایبری همکاری میکنند تا ریسکهای احتمالی آینده را به حداقل برسانند. آنها باید همین سطح همکاری را با روانپزشکان و افرادی که تجربه زیسته بیماریهای روانی را دارند نیز برقرار کنند.» بهگفته وی، حداقل اقدام ممکن آن است که شرکتها شبیهسازیهایی از گفتوگو با کاربران آسیبپذیر انجام دهند و پاسخهایی را که ممکن است باورهای هذیانی را تقویت کنند، شناسایی و علامتگذاری کنند.

برخی شرکتها به این هشدارها واکنش نشان دادهاند. در جولای سال جاری میلادی OpenAI اعلام کرد که یک روانپزشک بالینی را برای ارزیابی تأثیرات روانی ابزارهایش؛ از جمله ChatGPT استخدام کرده است. OpenAI یک ماه بعد نیز اذعان کرد که در برخی موارد «مدلها در تشخیص نشانههای هذیان یا وابستگی عاطفی ضعیف عمل کرده است.» اوپنایآی اعلام کرد که برنامه دارد پیامهایی برای دعوت به استراحت در جلسات طولانی را به مدلهای خود اضافه کند، ابزارهایی برای شناسایی نشانههای ناراحتی روانی توسعه دهد و پاسخهای ChatGPT را در موقعیتهایی که شامل «تصمیمگیریهای شخصی حساس» است، بازتنظیم کند.

از تجربه شبکههای اجتماعی آموختیم که نادیده گرفتن آسیبهای روانی میتواند به فاجعهای برای سلامت عمومی منجر شود. جامعه نباید دوباره این اشتباه را تکرار کند.

با این حال، برخی کارشناسان معتقدند که باید تغییرات بنیادینتری انجام شود. «ریکاردو توماسی» (Ricardo Twumasi) مدرس مطالعات روانپریشی در کالج کینگز لندن، پیشنهاد میدهد که ابزارهای ایمنی بهصورت پیشفرض درون مدلهای هوش مصنوعی تعبیه شوند. چنین اقدامی میتواند شامل پایش لحظهای برای شناسایی نشانههای آشفتگی روانی یا قابلیت «دستورالعمل پیشرفته درمانی دیجیتال» (Digital Advance Directive) باشد که کاربران در دورههای سلامت روان میتوانند مرزهای مجاز استفاده را برای آینده تعریف کنند.

«جو پیر» (Joe Pierre) روانپزشک دانشگاه کالیفرنیا نیز عقیده دارد شرکتهای توسعهدهنده مدلهای هوش مصنوعی میبایست مطالعه کنند که چه کسانی و چگونه آسیب میبینند و سپس با توجه به آن، اقدامات پیشگیرانه را طراحی کنند. این اقدامات میتواند شامل هدایت گفتوگوهای نگرانکننده به مسیرهای ایمنتر یا نمایش هشدارهایی شبیه برچسبهای هشدار پزشکی باشد.

به گفته واسن «از تجربه شبکههای اجتماعی آموختیم که نادیده گرفتن آسیبهای روانی میتواند به فاجعهای برای سلامت عمومی منجر شود. جامعه نباید دوباره این اشتباه را تکرار کند.» واسن همچنین معتقد است که شرکتها باید بهصورت منظم سیستمهای خود را از نظر طیف وسیعی از ریسکهای سلامت روان آزمایش کنند؛ فرآیندی که با نام «تیم قرمز» (Red-teaming)شناخته میشود. چنین چیزی یعنی فراتر رفتن از تستهای خودآزاری و شبیهسازی عمدی گفتوگوهایی با شرایطی مانند شیدایی (مانیا – mania)، روانپریشی یا وسواس فکری-عملی (OCD) برای بررسی واکنش مدلها. به گفته کارشناسان اعمال رگولاتوری و تنظیمگری رسمی ممکن است هنوز کمی زودهنگام باشد اما تأکید دارند که شرکتها باید خود را به استانداردهای بالاتری پایبند بدانند.

چتباتها ظرفیتهای بالقوه بسیار بالایی دارند. آنها میتوانند احساس تنهایی را کاهش دهند، به یادگیری کمک کنند و حتی در بهبود سلامت روان نقش داشته باشند؛ اما اگر آسیبهای احتمالی به اندازه امیدها جدی گرفته نشوند، این ظرفیت از بین خواهد رفت.