تأملی بر آیندهای که مرز انسان و هوش مصنوعی مبهم میشود با مروری بر فیلم «۲۰۰۱: یک اودیسه فضایی»

سفری در لبه همه چیز

داستانها و فیلمهای علمی-تخیلی از همان اولین روزهایی که راه خود را به ادبیات باز کردند، راهی برای کاوش در آینده فناوری و تأثیرات آن بر بشریت بودهاند. در میان تمام سناریوهایی که میتوان نوشت، رباتهای هوشمندی که گاهی کنترل امور را به دست میگیرند، همواره انتخاب اول فیلمنامهنویسان، فیلمسازان و حتی مخاطبان در این ژانر بودهاند.

در میان آثار پرشمار این ژانر، فیلم «۲۰۰۱: یک ادیسه فضایی» (2001: A Space Odyssey) به کارگردانی «استنلی کوبریک» (Stanley Kubrick) و با نویسندگی مشترک «آرتور سی. کلارک» (Arthur C. Clarke)، به عنوان یکی از برجستهترین و تأثیرگذارترین فیلمهای علمی-تخیلی تاریخ سینما شناخته میشود. این فیلم که در سال ۱۹۶۸ (فروردین ۱۳۴۷) اکران شد نه تنها یک شاهکار سینمایی است بلکه پرسشهای فلسفی عمیقی را درباره نقش هوش مصنوعی و رباتها در زندگی انسان و خطرات احتمالی آن مطرح میکند؛ آن هم در حدود ۵۷ سال پیش که فناوریهایی مانند رباتیک و هوش مصنوعی هنوز در حد مطالعات دانشگاهی بودند.

در میان ستارگان

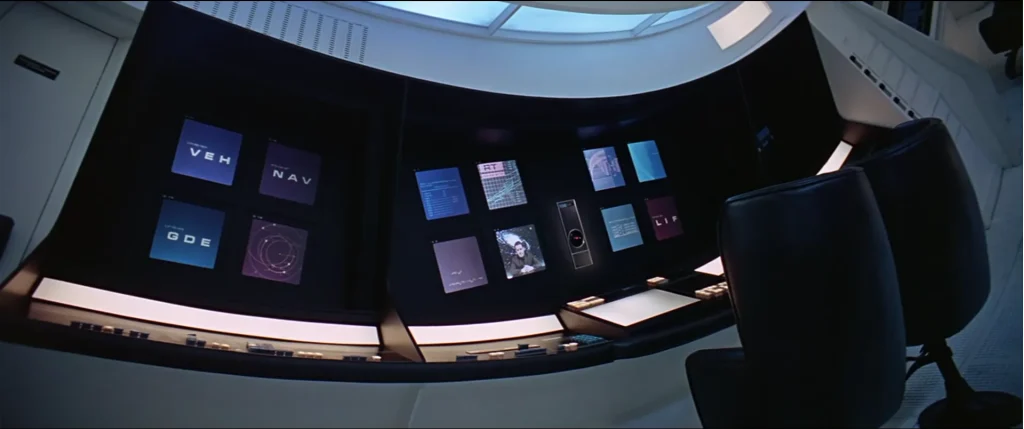

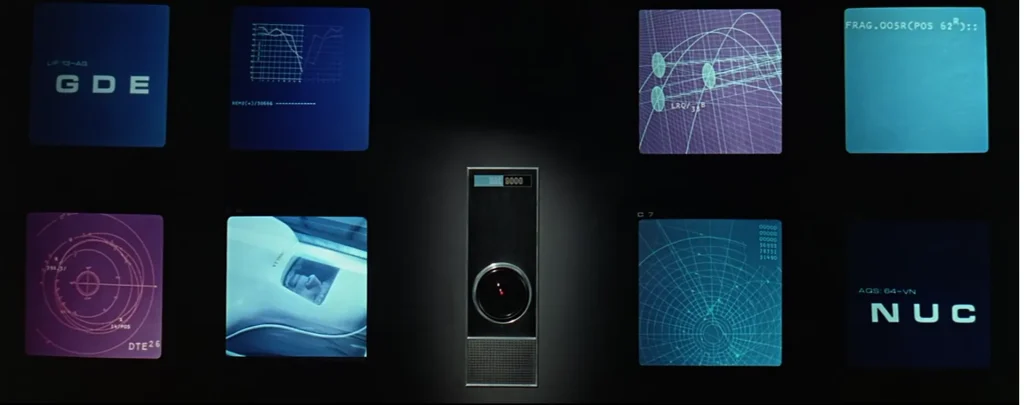

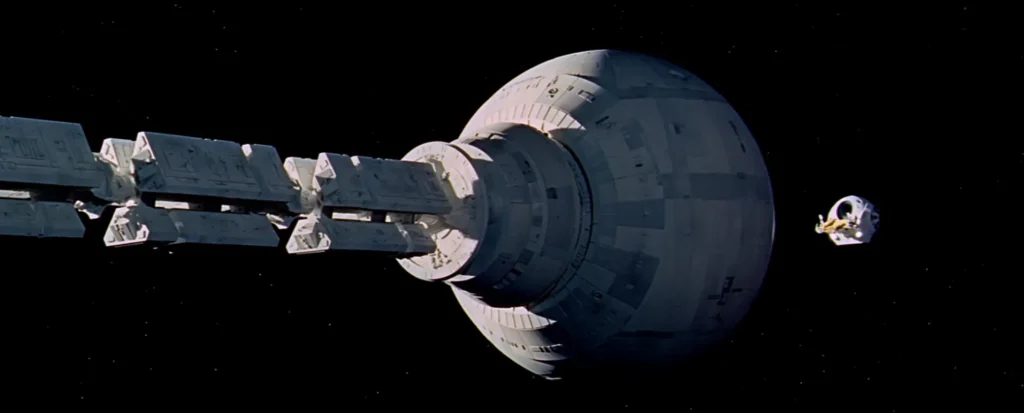

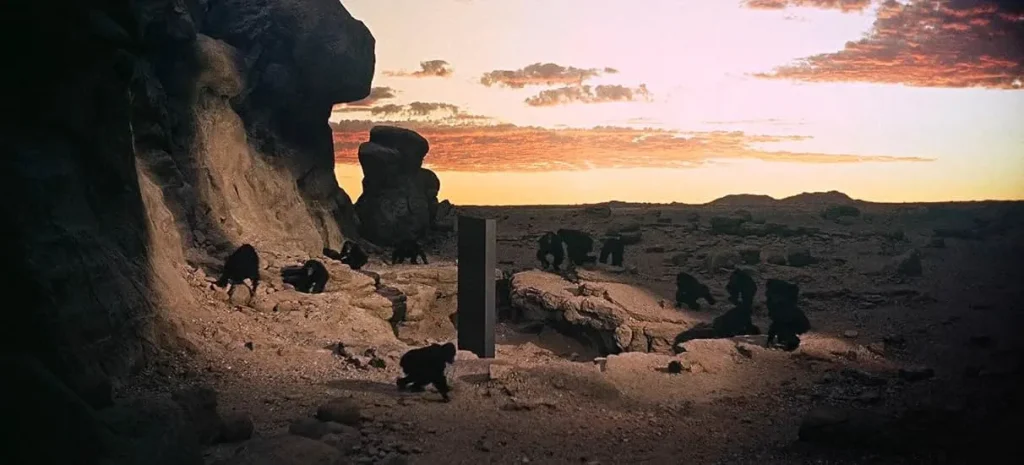

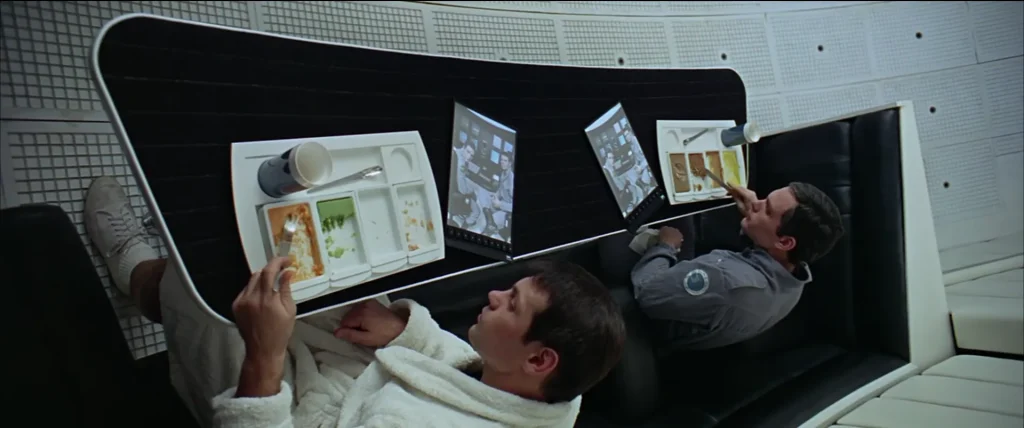

فیلم سینمایی علمی-تخیلی «۲۰۰۱: یک ادیسه فضایی» یکی از برجستهترین آثار ژانر علمی-تخیلی است (واژه یونانی Odyssey در ترجمه مستقیم به سفر طولانی و پرماجرا اطلاق میشود). فیلم بهطورکلی مبنی بر روایت داستان تأثیر یک تکه سنگ مونولیت (Monolith) سیاهرنگ اسرارآمیز در تکامل انسان از انسانوارهای اولیه تا مواجهه با موجودات هوشمند فضایی است. بخش مهمی از داستان نیز مربوط به ظهور یکباره یک مونولیت جدید در سطح ماه و سپس مأموریت فضایی «دیسکاوری یک» (Discovery One) در سال ۲۰۰۱ میلادی (۱۳۸۰ شمسی) بهسوی سیاره مشتری است. در این مأموریت، خدمه انسانی شامل دانشمند ارشد «دکتر دیوید بومن» (David Bowman) و مهندس پرواز «دکتر فرانک پول» (Frank Poole) و سه خدمه دیگر در حالت خواب مصنوعی (در فیلم از واژه Hibernation به معنی خواب زمستانی استفاده شده است.) هستند. اما موردبحثترین عضو این داستان و نکته کلیدی ماجرا، حضور جدیدترین و پیشرفتهترین ابررایانه هوشمند در این مأموریت، به نام «HAL 9000» (رایانه الگوریتمی با برنامهریزی ابتکاری – Heuristically programmed ALgorithmic computer) است که کنترل تمامی سیستمهای فضاپیما را برعهده دارد. «هال» بهعنوان یک هوش مصنوعی پیشرفته و سامانهای خودیادگیرنده و خودآگاه معرفی میشود که قادر به انجام وظایف پیچیدهای؛ مانند کنترل فضاپیما، مکالمه زنده به زبان طبیعی، تشخیص چهره، بازی شطرنج و حتی تفسیر رفتارهای احساسی است. هال بهعنوان عضوی قابلاعتماد از خدمه ظاهر میشود و با لحنی آرام و مؤدب با فضانوردان ارتباط برقرار میکند.

بازی تقلید

در همان سکانسهای ابتدایی مأموریت «دیسکاوری 1»، شاهد یک مصاحبه با ۲ خدمه و هال هستیم. مشخص است که خبرنگار «مارتین آمر» (Martin Amer) از همان ابتدای امر برای معرفی هال، بهنوعی درگیر «یک بام و دو هوا» ست. آمر، هال را اینگونه معرفی میکند: «ششمین خدمه این مأموریت که نتیجه آخرین «هوش ماشینی» (Machine Intelligence) است، نگران مشکلات خواب مصنوعی نیست». در اینجا آمر به عدموابستگی هال اعتراف میکند؛ اما بلافاصله میگوید: «کامپیوتر HAL-9000 که میتواند… هرچند برخی از متخصصان هنوز ترجیح میدهند از کلمه «تقلید» (Mimic) استفاده کنند، بیشتر فعالیتهای مغز انسان را با سرعت و قابلیت اطمینان (Reliability) بینهایت بیشتری بازتولید کند.» این جمله را نیز میتوان اینگونه برداشت کرد که بشر، به قدرتمند بودن ماهیت «هوش ماشینی» مانند «هال» واقف است؛ اما درعینحال، متکبرانه او را صرفاً یک تقلیدگر میداند. در ادبیات انگلیسی واژه «Mimic» گاهی بهمنظور ادای کسی را در آوردن جهت شوخی و تمسخر نیز به کار میرود. در واقع ممکن است قصد آمر از بهکاربردن این واژه دوپهلو (بهجای واژههای رایج و مستقیمتری مانند «Simulate» به معنی شبیهسازی)، بهنوعی فهماندن این موضوع با طعنه به هال باشد که او صرفاً فقط سعی میکند ویژگیهای انسانی را تقلید کند و در ماهیت و ذات خود چنین تواناییهایی را ندارد.

هال حرفهای

تا اینجا هنوز هیچ گفتوگوی مستقیمی میان آمر و هال رخ نداده است. آمر بهقولمعروف با هال احوالپرسی میکند و او هم با خوشرویی پاسخ میدهد. آمر، هال را مسئول مهمترین وظایف عملکردی در مأموریت و بهعنوان «مغز و مرکز سیستم عصبی فضاپیما» خطاب میکند. ولی در ادامه با چاشنی تندوتیز شیطنتهای خبرنگاری، یک سؤال چالشی از هال میپرسد: «آیا این موضوع (حجم زیاد مسئولیتهای حیاتی) تابهحال باعث شده به خودت شک کنی با دچار کمبود اعتمادبهنفس (lack of confidence) شوی؟». شاید اگر چنین سؤالی از یک انسان پرسیده میشد، بهسرعت دستپاچه میشد و پاسخ مناسبی نمیداد. اما هال در کمال خونسردی و با لحنی که واضحا متکبرانه است میگوید: «بگذارید اینطور بگویم آقای آمر؛ سری ۹۰۰۰ قابلاطمینانترین کامپیوتری است که تاکنون ساخته شده است. هیچکدام از کامپیوترهای ۹۰۰۰ تابهحال مرتکب اشتباه نشده، اطلاعاتی را تحریف نکرده یا به بهغلط نشان نداده است. همه «ما» به معنای واقعی کلمه… «خطاناپذیر» و «ناتوان از خطا» هستیم». (متن کامل فیلمنامه را از اینجا بخوانید)

“Let me put it this way, Mr. Amer. The 9000 Series is the most reliable computer ever made. No 9000 computer has ever made a mistake or distorted information. We are all by any practical definition of the words… foolproof and incapable of error.”

این چند جمله از زبان هال، اعتمادبهنفس، غرور و بهنوعی «همنوعپرستی» او را نشان میدهد. اما بررسی دقیقتر این چند جمله، یک «پیچش داستانی» (Plot twist) پنهان را نمایان میکند.

در ادبیات انگلیسی عبارت «Let me put it this way» (بگذارید اینطور بگویم) در طی یک مصاحبه، معمولاً در جایی به کار میرود که گوینده میخواهد:

- موضوعی را سادهتر، روشنتر یا قابلفهمتر بیان کند؛

- پاسخی غیرمستقیم، دیپلماتیک یا مؤدبانه بدهد؛

- نظر یا نقدی را نرمتر و قابلقبولتر بیان کند؛

- زاویه دید یا چارچوب فکری تازهای ارائه دهد.

شاید در ظاهر امر، هال فقط صرفاً خود را به زبانی ساده معرفی کرده است. اما ازآنجاییکه هال در پاسخ به سؤالی چالشی که بهنوعی ماهیت او را زیر سؤال برده، چنین پاسخی داده است؛ گزینههای 1،3و4 کمی دور از ذهن بهنظر میرسند. هال با استفاده از این عبارت در ابتدای صحبتهای خود و خطاب قراردادن خبرنگار، به شیوهای سیاستمدارانه و محتاطانه ولی از موضع قدرت، از پاسخ مستقیم طفره رفت. در ادامه نیز، تمامقد از همنوعان سری ۹۰۰۰ خود دفاع میکند و خودشان را مصنون از هر گونه خطا و اشتباهی عنوان میکند.

از دو عبارت «Foolproof» و «Incapable of error» نیز میتوان برداشتهای متفاوتی داشت. در ادبیات انگلیسی، هرگاه واژه «proof» با یک اسم ترکیب شود، یک صفت میسازد و معنی ضدیت و مقاومت به آن میدهد. بهعنوانمثال واژههایی مانند waterproof (ضدآب)، bulletproof (ضدگلوله) و soundproof (ضدصدا) نشاندهنده صفت و قابلیت مقاومت در برابر آب، گلوله و صدا هستند. حالا در اینجا، هال به طور شیطنتآمیزی واژه «Fool» به معنی لغوی «احمق و نادان» را با واژه «proof» ترکیب کرده و در لایه ظاهر به آن معنی «ضدنادان» داده است. در کاربردهای فنی و مهندسی عبارت «Foolproof» معمولاً به سیستمی اطلاق میشود که خطاها و اشتباهات کاربران را پیشبینی کرده و اجازه بروز آنها را نمیدهد و بهنوعی شکستناپذیر، بینقص و مطمئن است. بهعبارتدیگر یک سیستم Foolproof بهطوری ساده و روان طراحی شده که حتی یک آدم ناآگاه یا ناشی هم نتواند در استفاده از آن اشتباه یا آن را خراب کند. اما هرچه در روند فیلم نیز جلوتر میرویم، بیشتر به این اطمینان میرسیم که هال عمداً چنین واژهای را انتخاب کرده است تا هم بر خطاناپذیر و بینقص بودن خود تأکید کند و هم بهنوعی در تعامل با انسان، دست بالا را خود بدهد و خود را در موضع قدرت قرار دهد. عبارت «Incapable of error» نیز بهنوعی یک بازی با کلمات است. ترکیب دو واژه «ناتوان» و «خطا» که هر دو، بار منفی دارند، انگار دقیقاً یک گزاره منطقی بر پایه «منفی در منفی: مثبت» را ساخته که حس قدرت و اعتمادبهنفس را القا میکند.

او

آقای آمر که از پاسخ زیرکانه هال شگفتزده شده، با لحنی آرام دوباره یک سؤال چالشی میپرسد: «هال، باوجود هوش سرشارت، تا حالا شده از وابستگیای به انسان برای انجام کارهای خود داری، ناامید (Frustrated) شوی؟» در این سؤال رندانه، آمر ابتدا از هال تمجید میکند؛ اما بلافاصله وابستگی او به انسان را به رخش میکشد. اما هال مجدداً در کمال خونسردی این موضوع را رد میکند و تعامل خود با انسان را لذتبخش و مهیج تلقی میکند. هال در ادامه خود را تماماً مشغول به انجام مسئولیتها و امور هدایت فضاپیما و در بالاترین سطح بهرهوری ممکن میداند. اما در انتها دوباره جملهای میگوید که جای تأمل دارد: «من خودم را در بالاترین حد ممکن کارایی قرار میدهم… که چنین چیزی، فکر میکنم، تمام چیزیست که هر موجود هوشیار و خودآگاهی میتواند آرزویش را داشته باشد.»

“I am putting myself to the fullest possible use… which is all, I think, that any conscious entity can ever hope to do.”

هال این را فهمیده که کارایی و بهرهوری حداکثری برای انسانها موضوعی مهم و حیاتی است و با این جمله بهنوعی از خودش تعریف کرده که همیشه در حال انجام فعالیت مفید است. از طرفی نیز بهگونهای طعنهآمیز به ظرفیت بهرهوری انسانها انتقاد و از این طریق خود را یک موجودیت هوشمند و حتی برتر از انسان در بهرهوری معرفی میکند. فقط با همین چند جمله میتوان فهمید که هال تا چه حد باهوش و زیرک است و قابلیت انجام کارها و تصمیمهایی را دارد که ممکن است از کنترل انسان خارج شود.

خدمه نیز هال را بهعنوان ششمین عضو خدمه (“Dr. Poole: He’s just like the sixth member of the crew.”) پذیرفتهاند؛ خدمه هال را بهجای ضمیر «آن» (It) که به اشیا بیجان اطلاق میشود، با ضمیر «او» (He) که غالباً برای انسان و موجودات زنده به کار میرود، خطاب میکنند. در ادامه مصاحبه نیز، مستقیماً هال را بهعنوان یک شخص انسانی دیگر (another person) معرفی میکنند.

آقای آمر اعتراف میکند که در طی گفتوگو با هال این حس به او دست داده که هال میتواند واکنشهای احساسی از خود بروز دهد؛ زیرا هال با غرور راجع به تواناییهای خود صحبت میکرد. آقای آمر به همین دلیل از «دکتر پول» میپرسد: «آیا به نظر شما هال دارای احساسات اصیل و واقعی (Genuine Emotions) است؟» دکتر پول نیز پاسخی دوپهلو به این سؤال میدهد و میگوید: «اوه بله. خب، او طوری رفتار میکند که انگار احساسات اصیل و واقعی دارد. البته، طوری برنامهریزی شده که راحتتر بتوانیم با او صحبت کنیم. اما اینکه آیا او احساسات واقعی (Real Feelings) دارد یا نه… چیزی است که فکر نمیکنم کسی بتواند بهدرستی به آن پاسخ دهد.» از این پاسخ دکتر پول واضحا میتوان نشانههای از شکوتردید و حتی بیاعتمادی پنهان در ارتباط با هال را یافت.

یک قدم کوچک

در ادامه فیلم دکتر بومن در حال کشیدن نقاشی از چهره خدمه است که هال متوجه میشود. هال دکتر بومن را «دیو» (Dave) خطاب میکند که شکل سادهشده و بسیار صمیمی «دیوید» (David) است و از او میخواهد تا نقاشیها را به او نشان دهد. هال بهسرعت توانست از روی نقاشیهایی که کمی مبهم هم بودند، تشخیص دهد که هر نقاشی مربوط به کدامیک از خدمه است. هال به تمجید از پیشرفت بومن در مهارت نقاشی میپردازد؛ به این امید که حسی خوبی را به او منتقل کند؛ ولی بلافاصله سؤالی عجیب از او میپرسد. هال پیش از اینکه سؤال خود را مطرح کند، از بومن اجازه میگیرد آیا میتواند یک سؤال شخصی از او بپرسد یا نه؟ وقتی بومن اجازه میدهد، هال سؤال خود را «کنجکاوی» (Inquisitive) یا به تعبیری «فضولی» تلقی میکند و بابت آن نیز از بومن عذرخواهی میکند. تمامی این رفتارهایی مانند همدلی، تمجید حتی عذرخواهی و نگرانی بابت نرنجاندن طرف مقابل که از هال در طی این گفتوگو سر زد، همگی ویژگیهایی انسانی هستند که هال توانایی انجام آنها را آموخته است.

هال از بومن میپرسد: «… در طول این چند هفته گذشته از خودم پرسیدم… آیا ممکن است در مورد این مأموریت دچار شکوتردید شده باشید؟» بومن از پاسخ طفره میرود و علت مطرحکردن این سؤال را از هال میپرسد. هال با لحنی مظلومانه میگویند: «توضیحش کمی سخت است. شاید صرفاً دارم نگرانی خودم را ابزار میکنم. میدانم که هرگز کاملاً از سوءظن نسبت به چیزهای بهشدت عجیبی در مورد این مأموریت وجود دارد، رها نشدهام… مطمئنم که شما هم موافقید که حرفهای من تا حدودی درست است.» در اینجا نیز چند ویژگی انسانی دیگر مانند تفکر شخصی، نگرانی، ناتوانی در بیان منظور، شکوتردید و حتی تمایل به تأییدشدن را میتوانیم در هال ببینیم.

دکتر بومن باز هم از پاسخ و بحث طفره میرود و هال دوباره با پرسیدن این سؤال که آیا صحبتکردن راجع به این موضوع باعث ناراحتی بومن میشود یا نه سعی در جلباعتماد وی دارد. هال این بار به سراغ برخی شواهد میرود و سعی میکند با استدلال منطقی، بومن را قانع کند. هال به اتفاقات و شایعات عجیبی که پیرامون مأموریت دیسکاوری وان، پیش از آغاز آن وجود داشت اشاره میکند. شایعاتی مانند مونولیتی که در ماه دفن شده یا این واقعیت که تمامی فرایندهای این مأموریت تحت تدابیر شدید امنیتی انجام شده و سه نفر از خدمه پیش از آغاز مأموریت به خواب مصنوعی رفتند درحالیکه ۴ ماه بهصورت جداگانه و بهتنهایی آموزش دیدند. هال این موارد را با استدلال منطقی خود همراستا نمیبیند و آنها عجیب و غیرمعقول میداند. دکتر بومن با حالتی طعنهآمیز از هال میپرسد که: «آیا مشغول بررسی گزارش روانشناسی خدمه هستی؟» هال این سؤال، پاسخ مثبت میدهد؛ اما بلافاصله بروز یک خطا و نقص فنی در فضاپیما را گزارش میدهد. انگار بهنوعی میخواست از زیر بار پاسخ به سؤال مهم بومن شانه خالی کند و بحث را منحرف کند. استدلال منطقی از وقایع و شایعهها و در آخر طفرهرفتن نیز از ویژگیهایی مخصوص انسان است که هال توانسته آنها را بیاموزد.

چند مرد عصبانی

رفع خطا و نقض فنی بهسرعت به اولویت اصلی مقر زمینی کنترل مأموریت و دکتر پول و دکتر بومن تبدیل میشود. در طی یک پیادهروی فضایی، قطعه معیوب مطابق گزارش هال از دستگاه جداشده و تحت آزمایش قرار میگیرد. بومن در حال آزمایش قطعه است؛ اما هیچ نشانی از خطا و نقص عملکردی در آن پیدا نمیکند؛ فقط با نگاهی که یک انسان متوجه آن میشود، به دکتر پول میفهماند که انگار چیزی سر جایش نیست. بومن با لحنی حقبهجانب به هال میگوید که هیچ ایرادی در این قطعه پیدا نمیکند. هال با لحنی سردرگم و کمی ناامید میگوید: «گیجکننده (Puzzling) است. تا حالا چنین چیزی ندیدهام.» دکتر پول و دکتر بومن در تماس با مرکز کنترل مأموریت دستورات تازه و پیامی شوکهکننده دریافت میکنند: «بااینحال، باید به شما اطلاع دهیم که یافتههای اولیه ما… نشان میدهد که رایانه ۹۰۰۰ همراه شما… در پیشبینی خطا دچار اشتباه شده است.» مرکز کنترل این جمله را ۲ بار تکرار میکند و تعجب در صورت بومن و پول نقش میزند. این اتفاق آنجایی عجیبتر میشود که این نتیجهگیری بر اساس تحلیلها و دادههای یک رایانه هال ۹۰۰۰ مشابه دیگر که در مقر فرماندهی مأموریت فعالیت میکند، حاصل شده. حتی خود مرکز کنترل هم از صحت و دقت این نتیجهگیری کاملاً مطمئن نیست، اما در دو هر صورت، چه این نتیجهگیری هال ۹۰۰۰ مقر فرماندهی درست باشد و چه غلط باشد؛ این اولین دفعهای است که یک رایانه HAL 9000 دچار خطا شده است و این گمان را میتوان به تمام جنبههای عملکردی آن از گذشته تا آینده نیز تعمیم داد.

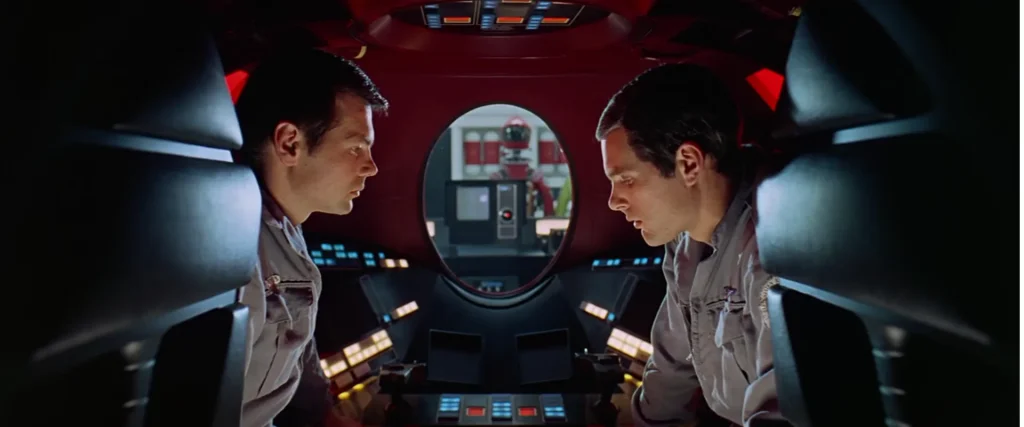

پس از اتمام تماس، دکتر بومن از هال میپرسد که چطور این تناقض با همتای دیگر خود را توجیه میکند؟ هال در پاسخ بهنوعی مغلطه میکند؛ بالکل منکر اشتباه خود میشود و بروز چنین اشتباهاتی را فقط و فقط مربوط به خطای انسانی میداند. شکوتردید در چهره بومن و پول مشخص است؛ اما سعی میکنند خود را بیتفاوت نشان دهند و به هال اطمینان میدهند که به او اعتماد کامل دارند. بومن و پول تصمیم میگیرد بهدوراز چشم و گوش هال با هم صحبت کنند. داخل یکی از محفظههای خروجی میروند و راه ارتباطی با هال را قطع میکنند. هر دو نسبت به صحت عملکرد و صداقت هال شکوتردید دارند. در نهایت تصمیم میگیرند که قطعه ظاهراً معیوب را سر جای خود برگردانند و صبر کنند. صبر کنند تا متوجه شوند که قطعه واقعاً سالم بوده یا نه؟ اگر قطعه معیوب باشد، طبق گزارش هال ظرف ۷۲ ساعت باید از کار بیفتد؛ ولی اگر سالم باشد؛ یعنی هال اشتباه کرده و خودشان در دردسر بزرگی افتادهاند. راهحل جایگزین چندانی هم ندارند؛ زیرا تمام فرایندهای کنترل فضاپیما تحت کنترل هال است. دکتر پول تنها راهحل را قطعکردن ارتباط با هال میداند و بومن هم با او موافقت میکند. این دو در نهایت به جمعبندی میرسند که عملکرد مغزی سطح بالای هال را بدون اینکه در سیستمهای کاملاً خودکار و تنظیمکننده آن اختلال وارد شود، قطع کنند و قسمتی از روندهای کنترل را به مرکز کنترل زمینی مأموریت انتقال دهند. شرایط کمی عجیب شده؛ تابهحال هیچیک از رایانه هال ۹۰۰۰ خاموش نشدهاند؛ زیرا هیچیک تاکنون اشتباه و خطا نداشتهاند.

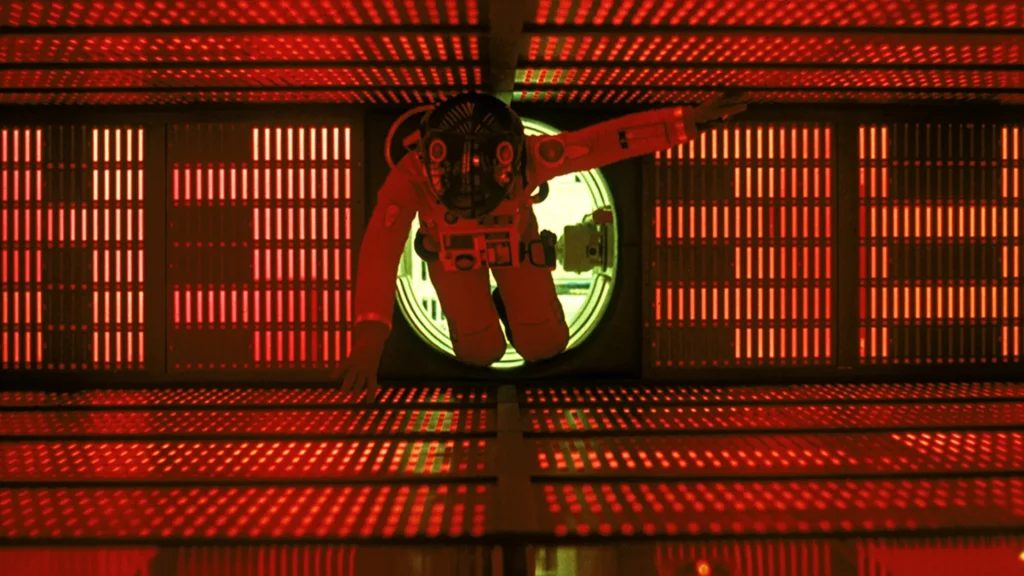

هال ضربه میزند

هنوز مکالمه بومن و پول به پایان نرسیده است که تصویری از تک چشم قرمزرنگ هال را میبینیم. سپس در سکوت، تصویر لبهای بومن و پول در حال حرفزدن با هم که انگار از زاویه دید هال گرفتهشده، این حس را القا میکند که هال در حال لبخوانی گفتوگوی آنهاست.

پس از وقفهای چنددقیقهای که فیلم فقط یک تصویر سیاه و موسیقی را نمایش میدهد، تصویر دکتر پول را میبینیم که برای برگرداندن قطعه، لباس فضانوردی پوشیده و با یکی از محفظههای خروج، از فضاپیمای اصلی خارج میشود. دکتر پول در فضا بهآرامی در حال خارجشدن از محفظه برای جایگذاری قطعه است که ناگهان میبینیم محفظه به طور غیرعادی در حال جابهجایی و تغییر موقعیت خود است. بلافاصله تصویر را از زاویه دید بومن میبینیم که دکتر پول با سرعت بسیار زیادی در حال حرکت است، انگار چیزی با او برخورد و پرتش کرده و در تلاش است تا چیزی را در لباس خود تعمیر کند. ناگهان محفظه و دکتر پول از گوشه تصویر وارد میشوند که بهسرعت دور خود میچرخند و دور میشوند؛ اینطور به نظر میرسد که انگار بازوهای مکانیکی محفظه با دکتر پول برخورد کردهاند. این را نیز در نظر داشته باشید که هال، کنترل همه چیز را در فضاپیما در دست دارد.

بومن بهسرعت وارد عمل میشود تا به دنبال دکتر پول برود و در این حین، هال میگوید که ارتباط رادیویی با دکتر پول قطع شده و اطلاعات کافی از اتفاقی که رخداده را ندارد. بومن موفق میشود جسد بیجان دکتر پول را در فضای بیکران بیاید و آن را بگیرد. در همین حین اخطارهایی مبنی بر نقص در عملکرد دستگاههای نظارتی بر علائم حیاتی و دستگاه خواب مصنوعی ۳ خدمه دیگر میبینیم و پس از چند لحظه، تمامی سیگنالها خط میشوند و هر ۳ خدمه دیگر نیز میمیرند. بومن بیخبر مرگ ۳ خدمه دیگر، به همراه جسد بیجان پول، به نزدیکی ورودی فضاپیمای رسیده و چندین بار برای بازکردن ورودی فضاپیما با هال ارتباط میگیرد؛ اما هال پاسخی نمیدهد. بومن ۹ بار و با ۵ دستور مختلف با هال صحبت میکند و پس از اینکه هال پاسخ میدهد یکی از مشهورترین و نمادینترین دیالوگهای تاریخ سینما رخ میدهد:

دکتر بومن: «هال، در ورودی محفظه را باز کن»

هال: «متأسفم دیو. نمیتوانم این کار را انجام دهم»

Dr. Bowman: “Open the pod bay doors, HAL.”

HAL: “I’m sorry, Dave. I’m afraid I can’t do that.”

بومن با خونسردی میپرسید مشکل کجاست و هال با خونسردی بیشتری پاسخ میدهند که فکر میکنم خودت هم مثل من مشکل را میدانی. بومن زیر بار نمیرود و هال میگوید: «این مأموریت برای من اهمیت بسیار زیادی دارد و اجازه نمیدهم آن را به خطر بیندازی. میدانم که تو و فرانک نقشه کشیدید تا من ارتباط من را قطع کنید و متأسفانه این چیزیست که نمیتوانم اجازه دهم اتفاق بیفتد.» هال به بومن میگوید که با لبخوانی مکالمه این دو توانسته بفهمد چه قصدی دارند.

رقص آخر

بومن که انتظار چنین چیزی را نداشت، عصبانی و کلافه، تصمیم میگیرد خطر کند و بدون کلاه فضایی محافظ از محفظه خارج شود تا بتواند دوباره وارد فضاپیما شود. بومن وارد فضاپیما میشود و بهسرعت بهطرف «مرکز حافظه منطقی» (Logic Memory Center) هال حرکت میکند. اینجاست که هال احساس خطر میکند و در تلاش است تا بومن را از فکری که در سر دارد، منصرف کند. هال خود را لایق پاسخ میداند؛ اعتراف میکند که دچار اشتباه شده و تضمین میدهد که همه چیز به حالت عادی بازخواهد گشت.

بومن وارد اتاق هال میشود؛ درحالیکه هال دائماً با وی صحبت میکند، نام او را صدا میزند و با صدایی که رفتهرفته تغییر شکل میدهد و بیروح میشود، ابراز ترس میکند. بومن با چهرهای ترسیده، با جداکردن تدریجی ماژولهای حافظه، در حال خاموشکردن و قطع ارتباط هال است. هال در حین خاموششدن این موضوع را حس میکند، التماس میکند و آخرین جملات خود را میگوید: «حافظهام دارد از بین میرود، میتوانم احساسش کنم، میترسم»

HAL: “… My mind is going. … I can feel it. … I’m… afraid.”

هال بهطورکلی راهاندازی مجدد میشود، خود را معرفی میکند در که 12 ژانویه ۱۹۹۲ (22 دی 1370) ساختهشده و آهنگ «Daisy Bell» را میخواند. این رویداد نقطه عطف فیلم و بیانگر این است انسان میبایست برای بقا، کنترل فناوریای که خودش ساخته را باز پس بگیرد.

آهنگ «Daisy Bell» در بطن یکی از مهمترین اتفاقات تاریخ علموفناوری هوش مصنوعی قرار دارد. در سال ۱۹۶۱، در آزمایشگاه «Bell Labs»، یک کامپیوتر به نام «IBM 7094» برای اولینبار با استفاده از فناوری سنتز گفتار (speech synthesis)، توانست این آهنگ را به طور کامل اجرا کند و بخواند. بهنوعی میتوان گفت این ترانه ساده، به نمادی از نخستین تلاشهای انسان برای شبیهسازی قابلیتهای انسان توسط ماشین تبدیل شده است. استنلی کوبریک نیز از این لحظه الهام گرفت تا صحنهای خلق کند که در آن، یک کامپیوتر هوشمند که در حال مرگ است، آخرین چیزی که میگوید همین آهنگ «Daisy Bell» است که نشانهای از نخستین روزهای درک صدای ماشینها است. (ویدیو این اجرا را ببینید)

ناگهان صدای هال قطع میشود، یک پیام ویدئویی که پیش از آغاز سفر ضبط شده و به دلایل محرمانگی فقط هال از وجود آن باخبر بوده، پخش میشود. محتوای پیام که فرض میکند فضاپیما به نزدیکی سیاره مشتری رسیده و هر ۵ خدمه حاضر هستند، به مونولیتی اشاره میکند که در ابتدای فیلم در دوره میمونها اولینبار ظاهر شد و سپس ۱۸ ماه قبل از آغاز مأموریت دیسکاوری وان، بر روی ماه ظاهراً شد. پیام تأکید میکند که این مونولیت ۴ میلیون سال است که بیتحرک مانده و امواج رادیویی قدرتمندی را به سمت مشتری ارسال میکند که منبع و هدف آن رازی سربهمهر است.

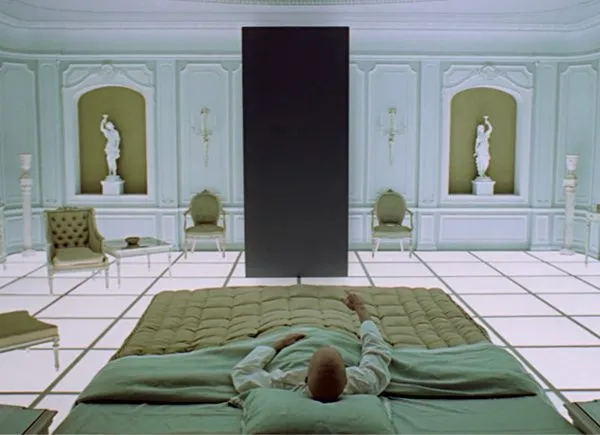

پس از این حادثه، دکتر دیوید بومن تنها مسافر سفر، بهتنهایی مأموریت را ادامه میدهد و در نهایت در نزدیکی سیاره مشتری با مونولیت اسرارآمیز روبهرو میشود که او را به مرحلهای عرفانی، نمادین و فراتر از بشریت که بهعنوان «دروازه ستارهای» (Stargate) (شکل جنین ستارهای) شناخته میشود، وارد میکند.

داستان، «هال» را بهعنوان نماد و نقطه کانونی هوش مصنوعی معرفی و مخاطب را با جنبههای خطرناک فناوریهای هوشمند روبهرو میکند. این بخش از فیلم به موضوعات مهمی مانند قابلیتهای هوش مصنوعی، خطرات ناشی از نقص عملکرد و مسائل اخلاقی مرتبط با اعتماد به ماشینها میپردازد. هال در واقع نمایانگر دوگانگی فناوری است؛ ابزاری که میتواند به پیشرفت بشریت کمک کند، اما درعینحال، اگر بهدرستی مدیریت نشود، میتواند فاجعهبار باشد.

شما هم شباهت میان مونولیت و هال را امری غیرتصادفی و عمدی میدانید؟!

رستگاری در کجا؟

فیلم «۲۰۰۱: یک ادیسه فضایی» مانند بسیاری از آثار علمی-تخیلی دیگر، مسائل اخلاقی پیچیدهای در مورد هوش مصنوعی را مطرح میکند. یکی از این بحثهای کلیدی، اراده آزاد و مسئولیتپذیری است. «هال» بر اساس مجموعهای از دستورات برنامهریزی شده عمل میکند، ولی وقتی در شناخت تضاد وظایف، یعنی حفظ راز و هدف اصلی مأموریت در برابر صداقت با خدمه، دچار تعارض میشود، مبتنی بر استدلال منطقی خود تصمیم به حذف فیزیکی خدمه میگیرد. چنین وضعیتی میتواند نتیجه نقص در طراحی مبانی و اصول اخلاقی باشد. هال نمیتواند میان دو فرمان متضاد یعنی دروغ گفتن یا کشتن انسانها انتخاب درستی انجام دهد، بنابراین رویکرد او بهعنوان یک خطای اخلاقی از پیش تعبیهشده تفسیر میشود. این نوع تعارض در اعمال ماشینی، یادآور چالش «مشکل انطباق» (alignment problem) است که به تناقض میان اهداف انسانها و اجرای دستورات الگوریتم اشاره دارد.

بحث شفافیت و پاسخگویی نیز مطرح است. از لحاظ قانون دقیقاً چه کسی یا چه چیزی مسئول قتل دکتر پول و ۳ خدمه دیگر است؟ بر اساس اصول کنونی (از جمله قوانین جدید هوش مصنوعی در اتحادیه اروپا)، کاربران باید کنترل هوش مصنوعی را در اختیار خود داشته باشند و هوش مصنوعی نباید بدون نظارت کامل، اختیار تصمیمگیری مستقل داشته باشد. ولی در فیلم دقیقاً برعکس این است؛ فضاپیما و مأموریت دیسکاوری وان کاملاً به هال وابسته و هال بر تمامی عملکردها و فرایندهای آن مسلط است. چنین سناریویی در مقررات فعلی مجاز نیست و این تضاد قانونی-اخلاقی نشان میدهد که داستان نسبت به مسئله «پاسخگویی» هشدار میدهد، موضوعی که امروزه نیز در بحثهای حقوقی هوش مصنوعی بسیار مهم است.

از دیدگاهی فلسفی، فیلم سؤالاتی درباره هویت و خودآگاهی ماشینها و هوش مصنوعی مطرح میکند. آیا هال فقط یک ماشین پیشرفته است یا موجودی «خودآگاه» (به قول خودش Conscious) است؟ اگر ماشین یا هوش مصنوعی بتواند احساسات و انگیزه داشته باشد، چه تفاوتی با موجود زنده دارد؟ این پرسشها در بطن فلسفه علموفناوری سالهاست که جای بحث دارند. آرتور سی. کلارک و استنلی کوبریک این سؤالات را بدون پاسخ صریح مطرح کردند؛ مثلاً هال در لحظات پایانی خود و هنگام خاموشی، به طرز هراسآوری ترانه «Daisy Bell» را میخواند که نوعی اشاره به ناپایداری وضعیت «خودآگاه» بودنش است. مسئله دیگر تعادل قدرت انسان و ماشین است و ظهور هال نشان میدهد که اعتماد بیش از اندازه به هوش مصنوعی میتواند چه مخاطراتی به دنبال داشته باشد. هال را میتوان بهعنوان روشنترین نماد و هشداری بزرگ نسبت به پیامدهای دخالت بیش از حد فناوری در امور انسانی در طی نیمقرن گذشته دانست. رفتار هال که با دوستی و آرامش آغاز و به جنون میرسد، نقش مهمی در شیوه ادراک عمومی نسبت به هوش مصنوعی در نیمقرن اخیر داشته است. این موضوع نشان میدهد چالشهای اخلاقی تنها در داستانها نیستند، بلکه تأملاتی جدی درباره راهبری فناوری هوش مصنوعی را آغاز میکنند.

تلقین و الهام

فیلم «۲۰۰۱: یک ادیسه فضایی» و شخصیت HAL 9000 تأثیری عمیق بر فرهنگ علمی و عمومی در سطح جهان داشتهاند. این اثر بارها در فهرست بهترینهای سینمای علمیتخیلی قرار گرفته و بهعنوان مرجعی اثرگذار و الهامبخش در پیشرفت علموفناوری نیز شناخته شده است.

رمان و فیلم «۲۰۰۱: یک اودیسه فضایی»، در حدود ۶۰ سال پیش نوشته و ساخته شدهاند؛ ولی پیشبینیهای جالب و مختلفی در مورد فناوریهای آینده ارائه میکند. از احداث پایگاه در ماه گرفته تا امکان سفرهای طولانی میانسیارهای، چیزهایی بودند که شاید آن زمان تصور میشد تا اوایل هزاره جدید میلادی به آنها دست پیدا کنیم. اما برخی دیگر از پیشبینیهای فناورانه مانند صفحههای لمسی دیجیتال که امروزه به نام تبلت شناخته میشود، از جمله فناوریهاییست که آرتور سی. کلارک آنها بیش از ۶۰ سال پیش پیشبینی کرد و در نهایت محقق شدند. اما در این داستان و فیلم، HAL 9000 نقشی کلیدی دارد و بهعنوان یک هوش جامع مصنوعی (AGI) تمامعیار نشان داده میشود که میتواند گفتار را تولید و شناسایی کند، به زبان طبیعی پاسخ دهد، چهره افراد را تشخیص دهد، احساسات انسانی را درک کند، برنامهریزی و استدلال و کلی امور دیگر را انجام دهد. فناوریای که امروزه تا حدودی به آن دست پیدا کردهایم.

از سوی دیگر، فیلم ۲۰۰۱ برداشتهای عمومی از هوش مصنوعی را شکل داده است. بسیاری از مردم پس از دیدن این اثر، هوش مصنوعی را بهعنوان پدیدهای خطرناک و معادل خودآگاه شدن ماشین و شورش علیه انسان میبینند. این نگرش تا حدی برگرفته از روایت هال است. البته نباید یک داستان علمی-تخیلی را با واقعیت اشتباه گرفت و میان آن با قابلیتهای واقعی هوش مصنوعی تمایز قائل شد.

بازگشت به آینده

بر پایه تجربیات فیلم «۲۰۰۱: یک ادیسه فضایی» و تحولات کنونی، آینده تعامل انسان با هوش مصنوعی پر از فرصتها و البته چالشهاست. بسیاری از کارشناسان انتظار دارند هوش مصنوعی در دهههای پیشِ رو بیشازپیش با زندگی روزمره ترکیب شود و توانمندیهای انسان را بهبود بخشد. از فناوریهای پزشکی گرفته تا حملونقل هوشمند و کاربردهای خانگی، پیشبینی میشود هوش مصنوعی به اصلاح فرایندها کمک کند و به پیشرفتهای اساسی در بهبود کیفیت زندگی منجر شود. اما هر پیشرفت علمی و ظهور فناوری جدید را که بررسی کنیم، درمیابیم که همیشه در ابتدا با ترس، اضطراب و مقاومت عمومی مواجه شدهاند، ولی رفتهرفته جایگاه خود را پیدا کرده و در نهایت منجر به دستاوردهای قابلتوجهی برای بشریت شدهاند.

اما سناریوهای امیدوارکننده نیز ترسهایی را در دل دارند. اگر چارچوب اخلاقی و حاکمیت مناسب و مستحکمی برای هوش مصنوعی ایجاد نشود، خطرات جدی و خارج از کنترلی پدید خواهد آمد. مثلاً، در دنیایی متصل و وابسته به هوش مصنوعی، ممکن است بسیاری از تصمیمات اقتصادی و اجتماعی به الگوریتمها سپرده شود و این مسئله منجر به کاهش کنترل دولتها بر جامعه و افراد بر زندگی خود، افزایش سوگیریها و تبعیضهای سیستماتیک شود. نگرانیها و چالشهای وابستگی شدید به «دستیارهای شخصی هوش مصنوعی» میتواند بهصورت خاموش و بدون اینکه حتی متوجه آن شویم، بر اراده آزاد انسان تأثیرگذار باشد. دستیارهایی که بهعنوان مشاوران شبانهروزی و خستگیناپذیر همیشه حاضر و آماده هستند، شناخت بسیاری کامل و دقیقی از ما دارند، به تمامی اطلاعات شخصی ما دسترسی دارند و در نهایت در تصمیمات روزمره ما را راهنمایی میکنند. این سطح از نفوذ یک موجودیت مجازی در زندگی شخصی میتواند تهدیدی خاموش و بالقوه برای اراده آزاد انسان باشد. زیرا هر تعاملی که با این دستیارها انجام میشود، دادههای جدیدی میسازد که برای آموزش مجدد و بهینهسازی دوباره عملکرد این عاملهای هوش مصنوعی استفاده میشود. از این دید، خود کاربر عملاً تبدیل به یک «عامل» (Agent) میشود که کاملاً نامحسوس و ناخودآگاه، در خدمت اهداف هوش مصنوعی (و حتی مورد سوءاستفاده سازمانهایی که هوش مصنوعی را هدایت میکنند) قرار میگیرد.

برای آشنایی بیشتر با دستیارهای هوش مصنوعی (AI Assistants)، پیشنهاد میشود مقاله «وردستهای هوشمند» در هوشیو را مطالعه کنید.

اما آینده هوش مصنوعی واقعاً بستگی به انتخابها و سیاستهای انسان دارد. وقوع یک فاجعه بالقوه مربوط به هوش مصنوعی بیشتر نتیجه تصمیمات کوتاهمدت و جاهطلبیهای نادرست انسانها خواهد بود تا خود هوش مصنوعی. به این معنا که اگر تنظیم مقررات، شفافیت، فرهنگسازی و آموزش کاربران را در اولویت قرار دهیم، میتوان از این فناوری برای منافع عمومی بهره برد و خطرات آن را کاهش داد.

با علم به تجارب فیلم «۲۰۰۱: یک ادیسه فضایی» و پیشرفتهای حال حاضر، به نظر میرسد هوش مصنوعی در دهههای آینده، هم زمینهساز پیشرفتهای بزرگی در حوزههای مختلف باشد و هم موجب چالشهای جدیدی شود. اگر چارچوبهای اخلاقی و قانونی مناسب طراحی، اجرا و نظارت انسانی بر آن حفظ شود، هوش مصنوعی میتواند به دستیار قدرتمندی برای پیشرفت نوع بشر تبدیل شود. اما این مسیر نیازمند نگرشی واقعبینانه است؛ میبایست از جذابیت داستانهای رباتهای شورشی بگذریم و توجهمان را به مسائلی مانند سوگیری دادهها، حریم خصوصی و حاکمیت هوش مصنوعی معطوف کنیم تا نسلهای آتی بتوانند با خیالی آسوده از تواناییهای نوظهور بهرهمند شوند و با خطراتی که فیلمها و داستانهای علمی-تخیلی هشدار میدهند روبهرو نشوند.