نقدی بر شیوه فرایند تصمیمگیری عاملهای هوش مصنوعی

پیشفرضهای اشتباه پنهان در فرایند تصمیمگیری عاملهای هوشمند

ما انسانها دوست داریم خود را موجوداتی منطقی بدانیم، اما در لحظه تصمیمگیری، مجموعهای پیچیده و درهمتنیده از فرایندهای ذهنی وارد عمل میشوند. حال باید پرسید: آیا هوش مصنوعی میتواند روزی این پیچیدگی را بازسازی کند؟

بسیاری از سازمانهایی که عاملهای هوش مصنوعی را به کار میگیرند، اغلب فقط به یک الگوی تصمیمگیری خاص بسنده میکنند. آنها بهاشتباه فرض میکنند که برای همه موقعیتها از دریافت ورودی، تحقیق و تحلیل گرفته تا تصمیمگیری، اجرا، ارزیابی و نهایتاً درسگرفتن از نتایج، تنها یک چارچوب تصمیمگیری یکسان پاسخگو خواهد بود. اما این دیدگاه، واقعیت را بیش از حد ساده جلوه میدهد.

تصمیمگیری انسانی یکپارچه و یکنواخت نیست؛ بلکه بهشدت پیچیده، پویا و وابسته به زمینه ذهنی است. تصمیمگیری ما سیال است و عواملی مانند محدودیتها، سوگیریها، فوریت، موقعیت، تعاملات، منطق و از همه مهمتر، «غیرمنطقی بودن» بر آن اثر میگذارند. اگر قرار است ایجنتهای هوش مصنوعی بهدرستی در سازمانها ادغام شوند، باید طیفی متنوع از شیوههای تصمیمگیری در طراحی آنها لحاظ شود تا از اجرای ناکارآمد و ترویج استانداردهای پایینتر از حد انتظار جلوگیری شود. «مجله کسبوکار اروپا» «The European Business Review» در جدیدترین نسخه خود (July-Aug 2025) در گزارشی با عنوان «The Flawed Assumption Behind AI Agents’ Decision-Making» به بررسی این موضوع پرداخته است.

مسیر تصمیمگیری برای همه مسائل یکسان یا مطلق نیست

باور به اینکه همه تصمیمها از یک مسیر مشخص و ساختارمند پیروی میکنند، تصوری اشتباه است. در واقع، تصمیماتی که ما میگیریم بسته به شرایط، از مدلهای مختلفی پیروی میکنند.

تصمیمگیری شهودی (غریزی)

این نوع تصمیمگیری بر شهود و تجربه تکیه دارد، نه بر تحلیل دادهها یا پژوهش ساختارمند. چنین روشی در محیطهای پرریسک و سریع که فرصت اندکی برای ارزیابی جزئیات وجود دارد، بسیار کارآمد است. معمولاً با تشخیص یک محرک، واکنش فوری بر اساس تجربه، اقدام و سپس ارزیابی پس از وقوع همراه است. مثلاً یک سرمایهگذار خطرپذیر ممکن است صرفاً بر اساس حس درونیاش تصمیم به سرمایهگذاری در یک استارتاپ بگیرد، حتی اگر دادههای مالی کامل یا شفاف نباشد. این نوع تصمیمگیری اغلب ناخودآگاه است و بر سالها تجربه انباشتهشده تکیه دارد تا بتواند در لحظه، قضاوتی سریع ارائه دهد.

تصمیمگیری منطقی-تحلیلی

این روش مبتنی بر داده، ساختاریافته و نظاممند است. شامل مراحل شناسایی مسئله، گردآوری داده، تحلیل، مقایسه گزینهها، اجرای تصمیم و ارزیابی عملکرد است. این مدل اغلب در برنامهریزی استراتژیک، ارزیابی ریسک و پیشبینیهای سازمانی به کار میرود. مثلاً یک تیم مدیریت زنجیره تأمین ممکن است دادههای تقاضای گذشته را تحلیل کند تا سطح تولید را تنظیم کرده و بهرهوری را افزایش دهد و از اتلاف منابع جلوگیری کند. این رویکرد بر استدلالهای قیاسی، استقرایی، علّی و بیزی (Bayesian) تکیه دارد تا مسیر تصمیمگیری را با اتکا به دادهها روشن کند.

تصمیمگیری مبتنی بر قوانین و سیاستها

برخی تصمیمها نه به تحلیل نیاز دارند و نه به شهود، بلکه صرفاً از چارچوبهای از پیش تعریفشده، مقررات یا قواعد خودکار پیروی میکنند. این مدل برای حوزههایی چون تطبیقپذیری قانونی، مدیریت ریسک و محیطهای تنظیمگری ضروری است؛ جایی که سازگاری و رعایت سیاستها حرف اول را میزند. در این نوع تصمیمگیری، ابتدا یک موقعیت خاص رخ میدهد، سپس قانون یا سیاست مرتبط شناسایی شده، بهصورت دستی یا خودکار اعمال میشود و در ادامه، رعایت آن تحت نظارت قرار میگیرد. نمونهای از این فرایند، سیستم شناسایی تقلب در بانکهاست که مثلاً اگر تراکنشی از یک منطقه پرریسک و با مبلغ بالا انجام شود، آن را شناسایی یا به اصلاح فنی پرچمگذاری (Flagging) کرده و برای بررسی بیشتر گزارش میکند. این روش با اتکا به قوانین مشخص، الگوهای مشکوک را شناسایی کرده و نتایجی منسجم و قابلپیشبینی فراهم میکند.

تصمیمگیری عاطفی و اجتماعی

تصمیمگیری همیشه بر پایه شهود، تجربههای گذشته، منطق یا قوانین نیست؛ گاهی تحتتأثیر هوش هیجانی، پویاییهای اجتماعی و ارزشهای فردی قرار میگیرد. این مدل نقش مهمی در رهبری، منابع انسانی و موقعیتهای اخلاقی ایفا میکند؛ جایی که روابط انسانی، ارزشها و زمینههای فرهنگی بر نتیجه تصمیم مؤثرند. در این رویکرد، معمولاً ابتدا زمینه اجتماعی یا اخلاقی سنجیده میشود، سپس ابعاد احساسی و ارزشی بررسی شده و بر پایه آن تصمیمگیری میشود. پس از اجرا نیز بازخوردی ذینفعان گرفته میشود. برای نمونه، یک مدیرعامل ممکن است تصمیم بگیرد یک کارمند کمبازده را اخراج نکند، چون تأثیر مثبتی بر فرهنگ سازمانی دارد؛ حتی اگر شاخصهای عملکردی سنتی چیز دیگری بگویند. در اینجا تصمیمگیری بر پایه استدلال اخلاقی و عقل سلیم انجام میشود؛ جایی که ارزشهای انسانی و زمینه اجتماعی، نتیجه را شکل میدهند.

تصمیمگیری اکتشافی (Heuristic)

این مدل بهجای تحلیل جامع همه گزینهها، به میانبُرهای ذهنی مبتنی بر تجربههای گذشته تکیه دارد. چنین میانبُرهایی در محیطهای سریع و شرایط نامطمئن کاربرد دارند، اما ممکن است سوگیریهایی ایجاد کنند که منجر به تصمیمهای نامطلوب شود. فرایند آن معمولاً شامل شناسایی محرک، تطبیق الگو، بهکارگیری میانبر ذهنی، تصمیمگیری، اقدام فوری و گاه دریافت بازخورد است. نمونه کلاسیک آن نیز این است که یک مدیر با این فرض که اعتبار مؤسسه برابر با عملکرد شغلی است و بدون اینکه همه رزومهها را دقیق بررسی کرده باشد، ترجیح دهد فقط فارغالتحصیلان دانشگاههای معتبر را استخدام کند. این رویکرد، از استدلال اکتشافی و عقل سلیم استفاده میکند و از تجربههای گذشته برای مواجهه با چالشهای حال بهره میگیرد.

تصمیمگیری مشارکتی و اجماعی

برخی تصمیمها نیازمند ورود گروهی، مذاکره و هماهنگی میان ذینفعان هستند. این روش در هیئتمدیره شرکتها، سیاستگذاریهای دولتی و راهبردهای کلان سازمانی کاربرد دارد؛ یعنی جایی که لازم است دیدگاههای گوناگون لحاظ شوند. فرایند آن شامل شناسایی مسئله، بحث گروهی، ارزیابی دیدگاههای مختلف، مذاکره برای رسیدن به اجماع، اجرای تصمیم جمعی و سپس بررسی نتایج است. برای مثال، یک هیئتمدیره ممکن است هفتهها صرف بررسی یک استراتژی بلندمدت کند تا مطمئن شود که همه نظرات شنیده شدهاند. این روش گروهی از استدلال تأملی، اخلاقی و قیاسی بهره میگیرد تا تصمیمهایی متعادل و چندجانبه اتخاذ شود.

تصمیمگیری در بحران و شرایط حساس

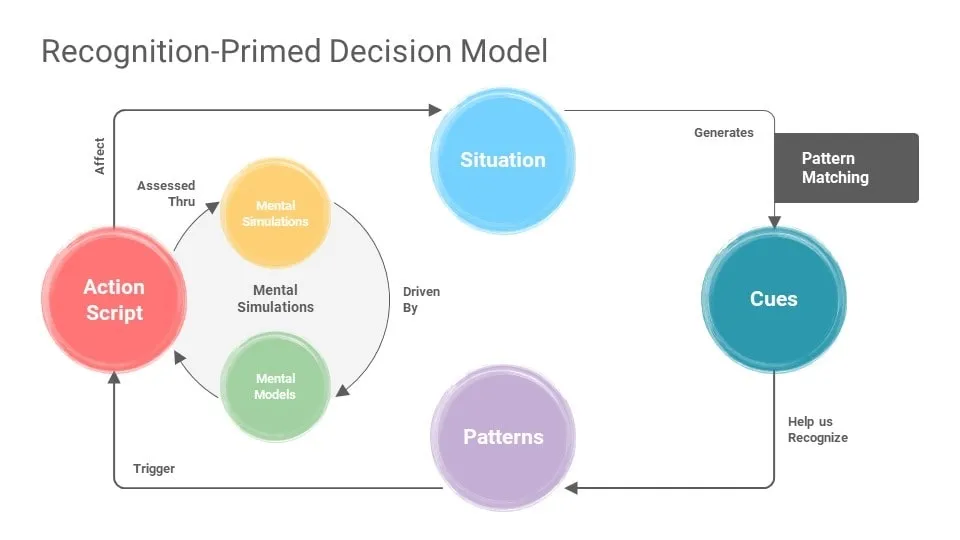

در موقعیتهای بحرانی یا تصمیمهای پرریسک، تصمیمگیرندگان تحتفشار زمانی، عدم قطعیت و خطر بالا عمل میکنند؛ یعنی شرایطی که فرصت تحلیلهای طولانی یا مشورت را نمیدهد. بر اساس مدل «تصمیمگیری مبتنی بر شناخت الگو» از «گری کلاین» (Gary Klein’s Recognition-Primed Decision – RPD)، در اینگونه موقعیتها افراد باتجربه باتکیهبر شناخت الگو، شبیهسازی ذهنی و شهود، تصمیمهایی سریع اما مؤثر میگیرند. بهجای ارزیابی چندین گزینه، تصمیمگیرنده نشانههای آشنا را شناسایی میکند، آنها را با تجربههای قبلی تطبیق میدهد و بر اساس اولین گزینه قابلاجرا اقدام میکند. مثلاً تیم امنیت سایبری ممکن است بلافاصله پس از مشاهده نشانهای از نفوذ، کل سیستم را غیرفعال کند تا از آسیب بیشتر جلوگیری کند، بدون آنکه منتظر تحلیل کامل بماند. این مدل، آمیزهای است از استدلال مبتنی بر نشانهها، علیت، میانبُرهای ذهنی و شهود که فرایند تصمیمگیری را ساده و به سمت اقدام هدایت میکند.

تصمیمگیری انسانی، چندوجهی و پویاست؛ هوش مصنوعی باید همینگونه باشد

این هفت مسیر تصمیمگیری نه کامل هستند و نه لزوماً مجزا؛ بلکه اغلب با هم همپوشانی دارند، تعامل میکنند و با هم تقریباً کامل میشوند. این واقعیت نشان میدهد که انسانها بسته به زمینه، بهصورت پیاپی یا همزمان، با سرعت یا بهصورت ساختارمند، بین این مدلها جابهجا میشوند. برای نمونه، یک مدیر اجرایی در مواجهه با تصمیمی مهم ممکن است ابتدا بر شهود خود تکیه کند، سپس برای تأیید حس خود به تحلیل دادهها روی آورد و در نهایت، با دیگر ذینفعان به مشورت و تصمیمگیری جمعی بپردازد. در یک بحران نیز ممکن است تصمیم فوری بر اساس قاعده یا میانبُر ذهنی اتخاذ شود و تحلیل دقیق آن در زمان مناسب مقتضی انجام گیرد. این واقعیت، نگاه خطی و خشک به فرایند تصمیمگیری را به چالش میکشد و بر لزوم طراحی ایجنتهای هوشمندی تأکید دارد که بتوانند با انعطاف کامل، بسته به شرایط، فوریت و پیچیدگی بین مدلهای مختلف تصمیمگیری جابهجا شوند.

پیروی از الگو به معنای تصمیمگیری نیست

عاملهای هوش مصنوعی میتوانند بهخوبی برخی انواع استدلال را تقلید کنند، بهویژه آنهایی که مبتنی بر منطق ساختاریافته، الگوهای دادهمحور و استنباط آماری هستند. برای نمونه، ایجنتها در استدلال قیاسی که طی آن از قواعد یا نظریههای ازپیشتعریفشده به نتایج خاص میرسیم، بسیار توانمند هستند. همچنین در استدلال استقرایی که در آن تعمیمهایی از کلاندادهها استخراج میشود و پایهگذار مدلهای یادگیری ماشین است، عملکرد خوبی دارند. هوش مصنوعی در استدلال علّی نیز، بهویژه زمانی که با دادههای سری زمانی یا الگوهای مشاهدهای آموزش دیده باشد، عملکرد خوبی از خود نشان میدهد. افزون بر این، در استدلال بیزی که در طی آن احتمالها بر اساس شواهد جدید بهروز میشود نیز تواناست. ایجنتهای هوش مصنوعی میتوانند استدلال قیاسی را نیز تا حدی انجام دهند؛ یعنی یافتن شباهتها میان مجموعهدادهها و بهکارگیری الگوهای آشنا در زمینههای تازه. همچنین، آنها مرتباً از استدلال اکتشافی استفاده میکنند تا در محیطهای پیچیده، راهحلهایی سریع و تقریبی ارائه دهند.

اما با وجود این توانمندیها، ایجنتهای هوش مصنوعی همچنان با محدودیتهای پایداری مواجهاند که مرزهای شکننده استدلال آنها را نمایان میسازد. یکی از این محدودیتها، اتکای بیش از حد به مسیرهای یادگیری ثابت و یکسویه است. به بیان دیگر یعنی این عاملها بهشدت به الگوهای ازپیشتعریفشده وابسته هستند. ایجنتهای هوش مصنوعی برای پیروی از الگو ساخته شدهاند، اما تصمیمگیری در بسیاری از مواقع این الگوها را میشکند. مدلی که برای تصمیمگیری منطقی-تحلیلی آموزش دیده باشد، ممکن است در شرایط بحرانی که نیازمند قضاوت سریع است، عملکرد ضعیفی داشته باشد. هنگامیکه شرایط پیشبینینشده رخ میدهد، هوش مصنوعی اغلب قادر نیست تشخیص دهد که میبایست مدل ذهنی یا منطق تصمیمگیریاش را تغییر دهد و در نتیجه نمیتواند بهصورت پویا میان مدلهای مختلف جابهجا شود یا آنها را با هم ترکیب کند.

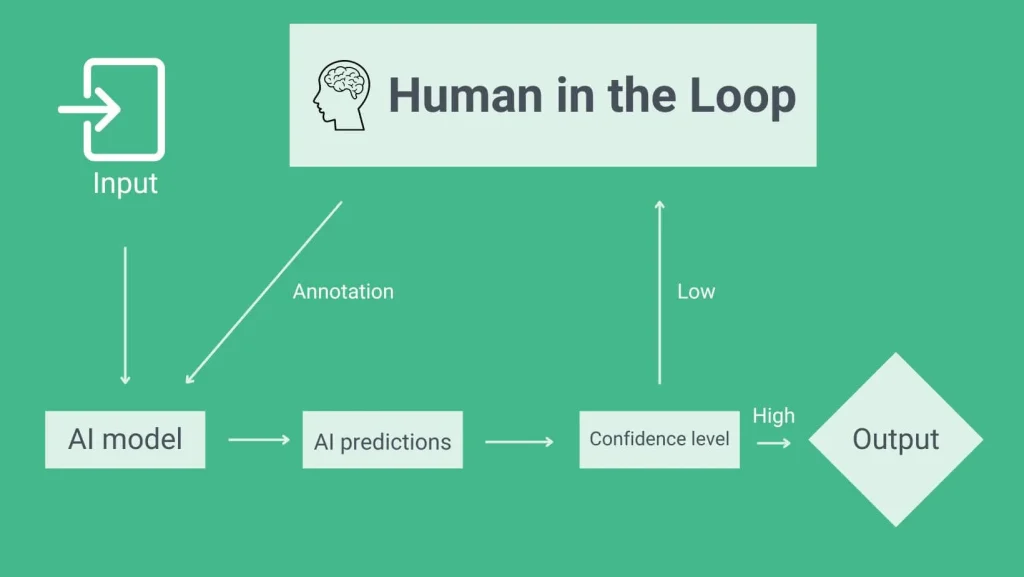

این دشواری انطباق با شرایط، با نبود درک زمینهای عمیق نیز بیشتر تشدید میشود. ایجنتهای هوش مصنوعی اغلب نمیتوانند تشخیص دهند چه زمانی باید سیاستها یا چارچوبها را با انعطاف اجرا کرد (مانند تصمیمگیری راهبردی)، و چه زمانی باید به طور سختگیرانه و دقیق به آنها پایبند بود (مانند تطبیق با مقررات). توانایی آنها برای تشخیص تغییرات ظریف در زمینهها (هرچند روبهبهبود است) همچنان محدود بوده و معمولاً نیازمند دخالت انسانی گسترده با بهاصطلاح فنی «انسان در حلقه» (HITL) است. پژوهشهای اخیر نیز این نگرانیها را تقویت کردهاند و نشان میدهند حتی پیشرفتهترین ایجنتها نیز در سناریوهای تصمیمگیری مبتنی بر ریسک و زمان، دچار ترجیحات ثابت و انعطافناپذیر هستند.

چالش سوگیری

چالش مهم دیگر تقویت سوگیریهاست. بدون توانایی بازاندیشی یا قضاوت مستقل، ایجنتهای هوش مصنوعی مستعد این هستند که بیش از حد به میانبرهای ذهنی تکیه کرده، سوگیریهای آموزشدیده را تشدید کرده یا ابعاد اخلاقی خروجیهایشان را نادیده بگیرند. ازآنجاکه این سامانهها نمیتوانند پیشفرضهای خود را به چالش بکشند یا مانند انسان مسیر تصمیمگیری خود را اصلاح کنند، ممکن است تصمیمهایی اتخاذ کنند که با ارزشهای انسانی و پیامدهای اجتماعی مطلوب ناسازگار باشد.

این محدودیتها زمانی آشکار میشوند که استدلالهایی را بررسی کنیم که هوش مصنوعی هنوز در درک و اجرای آنها با چالش روبهروست:

- استدلال ربایشی: مبتنی بر یافتن محتملترین توضیح از میان دادههای ناقص یا مبهم است همچنان برای هوش مصنوعی دستنیافتنی باقی مانده؛ زیرا نیازمند آگاهی زمینهای پیچیده است.

- استدلال بر پایه عقل سلیم: اگرچه در مدلهای زبانی بزرگ تا حدی تقلید شده، اما معمولاً شکننده و بیش از حد تحتاللفظی است و نمیتواند دانشی ضمنی و غریزیای که انسان بر آن تکیه دارد را بهدرستی درک کند.

- استدلال اخلاقی و ارزشی: تنها در مراحل ابتدایی طراحی در هوش مصنوعی ظاهر شده است. برخی سامانهها تلاش کردهاند پارامترهای مبتنی بر ارزش را نیز در خود بگنجانند؛ اما این کار را بهصورت مکانیکی انجام میدهند و هنوز با عمق و ظرافتهای قضاوت اخلاقی انسانی فاصله زیادی دارند.

در لبههای ظرفیت کنونی هوش مصنوعی، انواعی از استدلال قرار دارند که ذاتاً انسانی هستند:

- استدلال شهودی: از احساس درونی، تجربه زیسته و همدلی احساسی شکل میگیرد و هنوز برای هوش مصنوعی قابلبازسازی نیست.

- استدلال تأملی: یعنی توانایی ارزیابی و بازنگری در فرایندهای فکری خود، نیز بهشدت محدود است و نیازمند نوعی فراآگاهی و خودآگاهی است که ماشینها آن را ندارند.

درحالیکه هوش مصنوعی پیشرفتهای چشمگیری در شبیهسازی استدلالهای ساختارمند و دادهمحور داشته؛ اما همچنان در حوزههایی مانند انعطافپذیری، درک زمینه، حساسیت اخلاقی و بازاندیشی، دچار کمبود است.

تصمیمگیری منعطف؛ یکپارچگی بهجای خودمختاری

تصمیمگیری یکی از اساسیترین تواناییها برای تکامل جوامع انسانی است، چرا که این فرایند بازتابی از قابلیت ما در تبدیل نیت به عمل است؛ عملی که هم فرد و هم جامعه انسانی را شکل میدهد. باتوجهبه سطح بلوغ فعلی ایجنتهای هوش مصنوعی، مدیران اجرایی باید پیش از هر چیز، مدلهای تصمیمگیری تعبیهشده در سامانه هوش مصنوعی را ارزیابی کرده و از درک کامل مسیر تصمیمگیری آن اطمینان یابند. همچنین باید بررسی کنند که آیا این مسیر بهاندازهای قابلاعتماد هست که بتوان تصمیمگیری را به آن سپرد یا خیر.

اگر نتوان به قابلیت اطمینان کامل دست یافت، سازمانها باید آستانههای روشنی برای تصمیمگیری خودکار هوش مصنوعی تعیین کنند؛ یعنی مشخص کنند در چه مواردی عاملهای هوش مصنوعی میتواند بهتنهایی تصمیم بگیرد و چه زمانی مداخله انسانی ضروری است. افزون بر آن، سازمانها باید برای درصد باقیماندهای از مواردی که خارج از محدوده عملکرد هوش مصنوعی هستند، سازوکارهای ساختاریافتهای طراحی کنند تا نظارت انسانی و سازوکارهای جایگزین تصمیمگیری همچنان حفظ شده و پاسخگویی و همراستایی با راهبردهای کلان تضمین شود.

دستیابی به انعطافپذیری در تصمیمگیری نیازمند تغییری بنیادین در نگرش است؛ تغییری که در آن «هوش» بهتنهایی برای سازگاری، درک زمینه یا تصمیمگیری مسئولانه کافی نیست. پژوهشگران در سالهای اخیر معماریهای عصبی آگاه به زمینه را طراحی کردهاند که شروعی برای شبیهسازی انعطافپذیری شناختی سطح بالا در هوش مصنوعی است؛ گامی ابتدایی اما بنیادین در جهت توسعه استدلالهایی مبتنی بر «یکپارچگی» بهجای «هوشمندی» صرف.

برای آینده، کلید دستیابی به تصمیمگیری مؤثر در هوش مصنوعی در عبور از مرز «هوش» و رسیدن به «یکپارچگی» است؛ بدین معنا که سیستمهای هوش مصنوعی بتوانند:

- تشخیص دهند که در هر موقعیت، از چه مدل تصمیمگیری باید استفاده شود: آیا تحلیل منطقی لازم است؟ واکنش سریع به بحران؟ بررسی انطباق با قوانین؟ یا ترکیبی از آنها؟ توانایی پرسشگری واقعی بهمثابه تأمل اخلاقی خودمختار برای هوش مصنوعی؛ یعنی آغاز تحقیق بر پایه تردید درونی، تضاد یا تعارض اخلاقی و توانایی به چالش کشیدن منطق نادرست یا فرضیات خطرناک.

- در عین حفظ انسجام بتوانند انعطافپذیر عمل کنند: آیا یک ایجنت هوش مصنوعی میتواند تشخیص دهد که چه زمانی باید قوانین سفتوسخت را اعمال کرد و چه زمانی لازم است با درنظرگرفتن ارزشهای انسانی و هنجارهای اجتماعی، رویکردی منعطف اتخاذ کرد؟ برای هوش مصنوعی، چنین چیزی به معنای توانایی تفسیر زمینه، ارزیابی ابعاد اخلاقی و اعمال قضاوت فراتر از منطق صفر و یکی است؛ یعنی پلی میان دستورالعملهای سختگیرانه و درک انسانمحور.

- تشخیص دهند که چه زمانی باید از انسان کمک بگیرند: آیا هوش مصنوعی میتواند بفهمد که در شرایط پرابهام یا با پیامدهای سنگین، بهتر است تصمیمگیری را به انسان بسپارد؟ برای هوش مصنوعی، این یعنی داشتن خودمختاری در آغاز ارتباط با انسان و جلب مشارکت انسانی در فرایند تصمیمگیری.

این سه ویژگی، مسیر هوش مصنوعی را از «هوش» بهسوی «یکپارچگی» سوق میدهند. مفهوم «یکپارچگی مصنوعی» (Artificial Integrity) نیز مرز جدیدی در توسعه ایجنتهای هوش مصنوعی است؛ مرزی که در آن تصمیمگیری آگاه به زمینه، همراه با استدلالهای اجتماعی، اخلاقی و انسانی شکل میگیرد و ایجنتها قادر خواهند بود بهصورت پویا و تطبیقی، در چارچوبهای متنوع تصمیمگیری عمل کنند.