ویژهنامه هوش مصنوعی مجله تایم

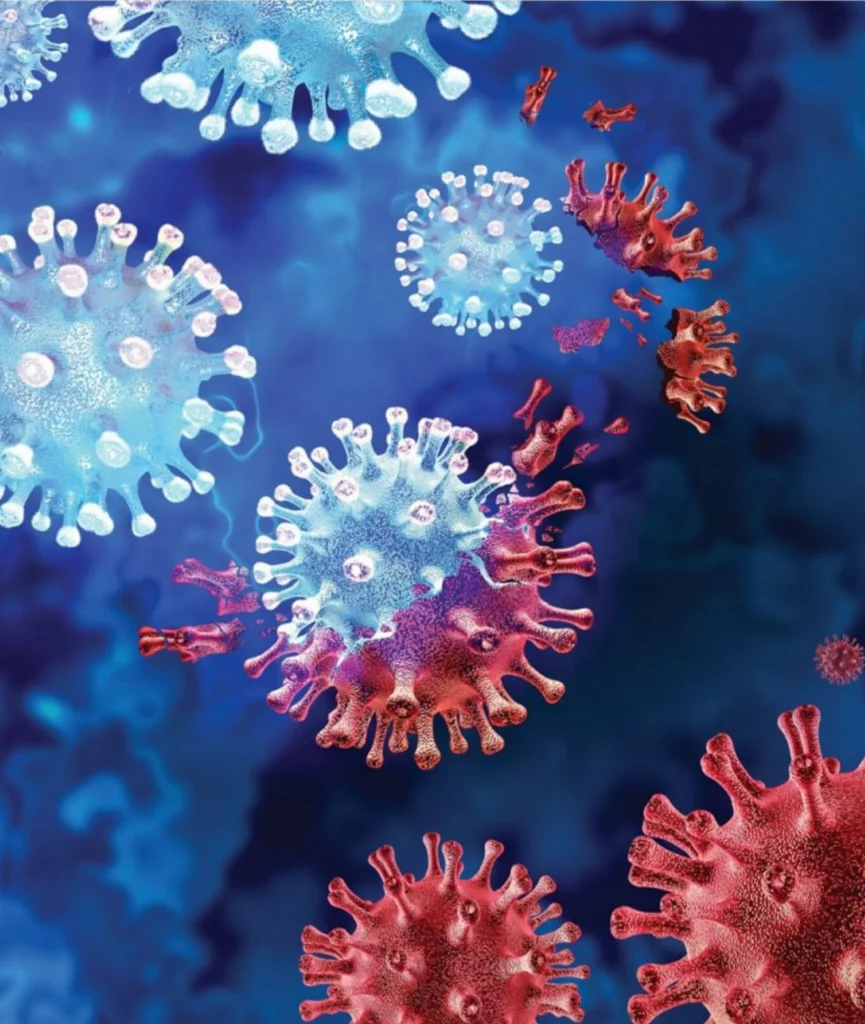

آیا هوش مصنوعی میتواند یک همهگیری را مهندسی کند؟

چتباتها تنها مدلهای هوش مصنوعی نیستند که در سالهای اخیر پیشرفت کردهاند. مدلهای تخصصی آموزشدیده با دادههای زیستی نیز جهش بزرگی داشتهاند و میتوانند به تسریع توسعه واکسنها، درمان بیماریها و مهندسی محصولات مقاوم در برابر خشکسالی کمک کنند. اما همان ویژگیهایی که این مدلها را سودمند میسازد، خطرات بالقوهای را نیز با خود به همراه دارد. برای مثال، مدلی که بتواند واکسنی ایمن طراحی کند، ابتدا باید بداند چه چیزهایی مضر هستند.

به همین دلیل، کارشناسان خواستار آن شدهاند که دولتها نظارت اجباری و چارچوبهای حفاظتی برای مدلهای زیستی پیشرفته ایجاد کنند. این درخواست در مقالهای سیاستی که در اکتبر ۲۰۲۴ در نشریه Science منتشر شد، مطرح شده است. نویسندگان در این مقاله اشاره کردهاند که اگرچه مدلهای هوش مصنوعی امروزی احتمالاً هنوز «نقش چشمگیری» در افزایش خطرات زیستی ندارند، اما سیستمهای آینده میتوانند به مهندسی پاتوژنهایی منجر شوند که توانایی ایجاد همهگیری را دارند.

به گفته نویسندگان که از متخصصان حوزه سلامت عمومی و حقوق از دانشکده پزشکی استنفورد، دانشگاه فوردهم و مرکز امنیت سلامت دانشگاه Johns Hopkins هستند: «عناصر اساسی برای ساخت مدلهای زیستی پیشرفته و نگرانکننده احتمالاً هماکنون وجود دارند یا بهزودی پدید خواهند آمد؛ بنابراین ایجاد نظامهای حکمرانی مؤثر از همین حالا ضروری است.»

«آنیتا سیسرو» (Anita Cicero) معاون مرکز امنیت سلامت Johns Hopkins و یکی از نویسندگان مقاله میگوید: «باید همین حالا برنامهریزی کنیم. برخی شکلهای ساختارمند نظارت و الزام از سوی دولت لازم خواهد بود تا خطرات ناشی از ابزارهای فوقالعاده قدرتمند در آینده کاهش یابد.»

انسانها تاریخی طولانی در تبدیل عوامل زیستی به سلاح دارند. طبق متون تاریخی، مغولها در قرن چهاردهم اجساد مبتلایان به طاعون را به درون دیوارهای دشمن پرتاب کردند که احتمالاً به گسترش «مرگ سیاه» در اروپا کمک کرد. در جریان جنگ جهانی دوم، چند قدرت بزرگ از جمله ژاپن بیماریهایی چون طاعون و حصبه را بهعنوان سلاح آزمایش کردند؛ ژاپن حتی این عوامل را علیه چند شهر چین به کار برد. در اوج جنگ سرد نیز، آمریکا و شوروی هر دو برنامههای گسترده تسلیحات زیستی داشتند. اما در سال ۱۹۷۲، دو طرف به همراه بسیاری از کشورهای دیگر توافق کردند که این برنامهها را برچینند و سلاحهای زیستی را ممنوع کنند که به «کنوانسیون سلاحهای زیستی» (Biological Weapons Convention – BWC) انجامید.

«خطرات زیستی ناشی از هوش مصنوعی میتوانند در عرض ۲۰ سال آینده و شاید بسیار زودتر خود را نشان دهند، مگر آن که نظارت مؤثری اعمال شود.»

آنیتا سیسرو، معاون مرکز امنیت سلامت Johns Hopkins

با وجود اثربخشی نسبی این پیمان جهانی، خطر سلاحهای زیستی هرگز به طور کامل از میان نرفت. فرقه ژاپنی Aum Shinrikyo در اوایل دهه ۱۹۹۰ چندین بار تلاش کرد تا سلاحهای زیستی مانند «آنتراکس» (Anthrax) را تولید و استفاده کند. این اقدامات به دلیل فقدان تخصص فنی شکست خورد؛ اما کارشناسان هشدار میدهند که سیستمهای هوش مصنوعی آینده میتوانند این شکاف را جبران کنند. به گفته سیسرو: «هرچه این مدلها قدرتمندتر شوند، سطح مهارت فنی موردنیاز برای انجام اقدامات مخرب پایینتر میآید.»

همه پاتوژنهایی که تاکنون بهعنوان سلاح استفاده شدهاند، قابلیت انتقال انسان به انسان را نداشتهاند و آنهایی که داشتهاند، معمولاً در روند انتقالپذیرتر شدن، کشندگی خود را ازدستدادهاند. اما سیسرو میگوید: «هوش مصنوعی ممکن است بتواند بفهمد چطور یک پاتوژن میتواند قابلیت انتقال خود را حفظ کند بدون آن که از میزان سازگاریاش کاسته شود.»

گروههای تروریستی یا بازیگران شومنیت تنها سناریوی ممکن نیستند. حتی یک پژوهشگر خوشنیت اگر پروتکلهای ایمنی مناسب را رعایت نکند، ممکن است به طور تصادفی پاتوژنی بسازد که رها شده و بهصورت غیرقابلکنترل گسترش یابد. نگرانی از بیوتروریسم همچنان جهانی است و شخصیتهایی مانند بیل گیتس و «جینا ریموندو» (Gina Raimondo) وزیر بازرگانی ایالات متحده و مسئول رویکرد دولت بایدن به هوش مصنوعی نیز در زمره کسانی هستند که نسبت به آن هشدار دادهاند.

فاصله میان یک نقشه دیجیتال و یک عامل زیستی واقعی، برخلاف تصور بسیار اندک است. بسیاری از شرکتها امکان سفارش آنلاین مواد زیستی را فراهم کردهاند و هرچند تدابیری برای جلوگیری از خرید توالیهای ژنتیکی خطرناک وجود دارد؛ اما این تدابیر هم در داخل آمریکا و هم در سطح بینالمللی به طور یکنواخت اجرا نمیشوند و بهآسانی میتوان از آنها عبور کرد. سیسرو توضیح میدهد: «سد پر از سوراخی وجود دارد که از هر کدام آب بیرون میزند.» او و همکارانش خواستار غربالگری اجباری سفارشهای ژنتیکی هستند اما تأکید دارند که حتی این کار نیز برای محافظت کامل در برابر خطرات مدلهای زیستی کافی نیست.

تاکنون ۱۸۶ نفر از پژوهشگران، دانشگاهیان و فعالان صنعت از جمله از دانشگاه هاروارد و شرکتهای مدرنا و مایکروسافت؛ بیانیهای داوطلبانه با عنوان «هوش مصنوعی مسئولیتپذیر در زیستطراحی» (Responsible AI x Biodesign) را امضا کردهاند. سیسرو که یکی از امضاکنندگان است میگوید: «این تعهدات مهم هستند، اما برای کاهش خطر کافی نیستند.» نویسندگان مقاله یادآور میشوند که در دیگر حوزههای پرریسک زیستی، مانند کار با ویروس زنده ابولا، هیچگاه صرفاً بر تعهدات داوطلبانه تکیه نمیکنیم.

آنها توصیه میکنند دولتها با کارشناسان یادگیری ماشین، بیماریهای عفونی و اخلاق زیستی همکاری کنند تا مجموعهای از «آزمونها» را طراحی کنند که هر مدل هوش مصنوعی زیستی باید پیش از عرضه عمومی از آن بگذرد؛ با تمرکز بر اینکه آیا این مدل میتواند خطرات در سطح همهگیری جهانی ایجاد کند یا خیر. سیسرو توضیح میدهد: «باید یک حداقل استاندارد وجود داشته باشد. حداقلِ ممکن این است که در ارزیابیهای ریسک، فایده و بررسیهای پیش از انتشار ابزارهای طراحی زیستی و مدلهای زبانی بزرگ، مشخص شود آیا این مدلها میتوانند خطرات در سطح همهگیری ایجاد کنند یا نه.»

ازآنجاکه آزمودن چنین تواناییهایی در خودِ سیستمهای هوش مصنوعی میتواند خطرناک باشد، نویسندگان پیشنهاد میکنند از ارزیابیهای جانشین استفاده شود؛ مثلاً بررسی اینکه آیا یک مدل میتواند پاتوژنی بیضرر بهعنوان جانشینی برای ارزیابی توانایی آن در ساخت پاتوژنی کشنده بسازد. بر پایه این آزمونها، مقامات میتوانند تصمیم بگیرند که دسترسی به مدل باید تا چه حد محدود شود. سیاستهای نظارتی باید این واقعیت را نیز در نظر بگیرند که سیستمهای متنباز پس از انتشار قابل تغییرند و میتوانند در نتیجه اصلاحات و فاین تیونینگ، خطرناکتر شوند.

نویسندگان همچنین پیشنهاد میکنند که ایالات متحده استانداردهایی برای اشتراک مسئولانه دادههای زیستی در مقیاس بزرگ، بهویژه دادههایی که مربوط به «ویژگیهای پاتوژنهای نگرانکننده» هستند تدوین کند و یک نهاد فدرال اختیار همکاری با مؤسسه ایمنی هوش مصنوعی آمریکا را داشته باشد.

مؤسسه ایمنی هوش مصنوعی بریتانیا که با همتای آمریکایی خود همکاری نزدیکی دارد، آزمونهای ایمنی شامل ارزیابی خطرات زیستی را بر روی مدلهای پیشرفته انجام داده است؛ بااینحال، این آزمایشها عمدتاً بر مدلهای زبانی عمومی متمرکز بودهاند، نه سیستمهای اختصاصی زیستشناسی. سیسرو میگوید: «آخرین چیزی که میخواهیم این است که با قانونگذاری افراطی، پیشرفت این صنعت را فلج کنیم و چنین کاری میبایست به طور متوازن انجام شود.»

برای جلوگیری از کندشدن پیشرفت علمی، نویسندگان پیشنهاد میکنند که در مرحله نخست، مقررات فقط بر دو نوع مدل متمرکز شود:

- مدلهایی که با حجم بسیار بالای توان محاسباتی بر دادههای زیستی آموزشدیدهاند.

- مدلهایی از هر اندازه که بر دادههای زیستی بسیار حساس و با محدودیت دسترسی آموزشدیدهاند. (مانند دادههایی که توالیهای ژنتیکی ویروسی را به پتانسیل همهگیری مرتبط میکنند.)

به گفته سیسرو، با گذر زمان دامنه مدلهای نگرانکننده ممکن است گسترش یابد، بهویژه اگر هوش مصنوعی در آینده بتواند به طور خودمختار پژوهش انجام دهد. او میگوید: «تصور کنید ۱۰۰ میلیون مدیر ارشد علمی فایزر را داشته باشید که شبانهروز و با سرعتی صد برابر انسان واقعی کار میکنند.» چنین چیزی میتواند به پیشرفتهای خارقالعاده در طراحی داروها منجر شود، اما همزمان خطر را نیز بهشدت افزایش میدهد.

مقاله تأکید میکند که برای مدیریت این خطرات، همکاری بینالمللی ضروری است چرا که این تهدیدها سراسر جهان را در معرض خطر قرار میدهند. بااینحال، نویسندگان اشاره میکنند که هرچند هماهنگی جهانی ایدهآل است؛ اما «کشورهایی که از پیشرفتهترین فناوریهای هوش مصنوعی برخوردارند باید ارزیابیهای مؤثر را در اولویت قرار دهند، حتی اگر این امر به بهای ازبینرفتن یکنواختی بینالمللی تمام شود.»

باتوجهبه پیشبینی پیشرفت سریع تواناییهای هوش مصنوعی و سهولت نسبی در دستیابی به مواد زیستی و استخدام پیمانکاران ثالث برای انجام آزمایشهای از راه دور، سیسرو معتقد است که خطرات زیستی ناشی از هوش مصنوعی میتوانند در عرض ۲۰ سال آینده و شاید بسیار زودتر خود را نشان دهند، مگر آن که نظارت مؤثری اعمال شود. سیسرو میگوید: «باید نه فقط به نسخه فعلی ابزارها، بلکه به نسخههای بعدی آنها فکر کنیم، زیرا رشد این فناوریها نمایی است و هر روز قدرتمندتر میشوند.»

جهت دریافت این گزارش میتوانید به این صفحه مراجعه کنید.