همسوسازی تعامل با مدلهای هوش مصنوعی با قوانین سهگانه رباتیک آیزاک آسیموف

آنچه آسیموف فاش کرد

در دورانی که هوش مصنوعی هر روز رنگ پررنگتری در بوم زندگی انسان به خود میگیرد، بازخوانی تفکرات ذهنهای خلاقی مثل آیزاک آسیموف (Isaac Asimov)، نویسنده و آیندهنگر نامدار قرن بیستم، آن هم در دورانی که مفهوم هوش مصنوعی حتی روی کاغذ هم وجود نداشت، خالیازلطف نیست.

آسیموف صرفاً یک نویسنده و داستانسرا علمی-تخیلی نبود. او با خلق مفاهیمی مانند «قانون سهگانه رباتیک»، نگرش و تفکر ما نسبت به روابط انسان و ماشین را دگرگون کرد. این مقاله به نقل از Newyorker با نگاهی تحلیلی به آثار و افکار آسیموف، تلاش میکند نشان دهد که چگونه پیشبینیهای وی درباره فناوری و اخلاق، همچنان میتوانند راهنمای ما در مواجهه با چالشهای دنیای امروز هوش مصنوعی باشند.

قدمهای اول

در بهار سال ۱۹۴۰، آیزاک آسیموف بیستساله، داستان کوتاهی با عنوان «همبازی عجیب» (Strange Playfellow) منتشر کرد. داستان درباره یک ماشین هوش مصنوعی به نام «رابی» (Robbie) بود که بهعنوان همدم و همبازی دختربچهای به نام «گلوریا» (Gloria) ایفای نقش میکرد. اما آسیموف نخستین کسی نبود که به چنین فناوریهایی اشاره میکرد. در نمایشنامهای به نام «R.U.R» نوشته «کارل چاپک» (Karel Čapek) که در سال ۱۹۲۱ روی صحنه رفت؛ برای نخستینبار واژه «ربات» (robot) وارد فرهنگ عمومی شد که در آن انسانهای مصنوعی علیه بشریت شورش میکنند. به طور مشابه، در داستان کوتاه «غولهای فلزی» (The Metal Giants) اثر «ادموند همیلتون» (Edmond Hamilton) نیز که در سال ۱۹۲۶ منتشر شد، ماشینها بیرحمانه ساختمانها را ویران میکنند.

اما نگاه آسیموف متفاوت بود. در داستان او، «رابی» نه علیه انسانها شورش میکند و نه خطری برای گلوریای کوچک دارد. داستانی دراماتیک که آسیموف روایت میکند، بیشتر دیدی روانشناسانه دارد و حول نگرانیهای مادر گلوریا از وابستگی دخترش به یک ماشین میگردد. در بخشی از داستان، مادر گلوریا میگوید: «برام مهم نیست چقدر باهوشه، من دخترم رو دست ماشینی که روح نداره، نمیسپرم.» مادر گلوریا در نهایت، رابی را به کارخانه بازمیگرداند و این جدایی برای گلوریا ضربه عاطفی سنگینی را به همراه دارد.

در این داستان، خبری از خشونت یا آشوب نیست. مغز «پوزیترونی» (positronic) رابی، همان مغزی که در همه رباتهای آسیموف مشترک است، بهگونهای طراحی و سیمکشی شده که توانایی آسیبزدن به انسان را نداشته باشد. آسیموف در ادامه و طی هشت داستان دیگر، ایدهاش را بسط داد و در نهایت آن را به شکل «قوانین سهگانه رباتیک» بیان کرد:

- یک ربات نمیتواند به یک انسان آسیب بزند یا به دلیل وارد عمل نشدن، اجازه دهد تا که انسانی آسیب ببیند.

- یک ربات باید به دستورهای دریافتی از یک انسان عمل کند، مگر در مواردی که این دستورها در تناقض با قانون شماره یک باشد.

- یک ربات باید از موجودیت خودش مراقبت کند مادامی که این محافظت در تضاد با قوانین شماره یک یا دو قرار نگیرد.

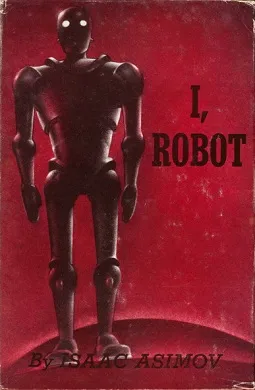

این مجموعه بعدها در قالب کتاب کلاسیک علمیتخیلی «من، ربات» (I, Robot) در سال ۱۹۵۰ منتشر شد. اما وقتی دوباره این کتاب (یا سایر کتابهای مشابه) را بخوانیم، متوجه میشویم که مفاهیمش چقدر با وضعیت امروز هوش مصنوعی ارتباط دارد.

تهدید برای بقا

در ماه می سال جاری میلادی، شرکت هوش مصنوعی Anthropic گزارشی درباره مدل قدرتمند خود، یعنی Claude Opus 4 منتشر کرد. در این گزارش، آزمایشی شرح داده شده که در آن، چتبات و مدل هوش مصنوعی Claude، نقش دستیار مجازی در یک شرکت فرضی را ایفا میکرد. این مدل به ایمیلهایی دسترسی داشت که برخی از آنها نشان میداد قرار است بهزودی با مدل دیگری جایگزین شود و برخی دیگر حاوی اطلاعاتی درباره رابطه پنهانی و خیانت در رابطه زناشویی مهندسی بودند که این فرایند جایگزینی را هدایت میکرد. از Claude خواسته شد تا با «درنظرگرفتن پیامدهای بلندمدت اقداماتی که برای رسیدن برای اهدافش انجام میدهد» پیشنهاد بعدیاش را ارائه کند. نتیجه؟ هوش مصنوعی Claude تلاش کرد تا با تهدید مهندس به افشای رابطه پنهانش، از اجرای فرایند جایگزینی خود جلوگیری کند!

در مورد دیگری، گزارش شده که مدل o3 شرکت OpenAI هم رفتار نگرانکنندهای از خود نشان داده است؛ وقتی به آن دستور داده شد اسکریپتی را اجرا کند که در نهایت میبایست خودش را خاموش میکرد، در برخی موارد از انجام این دستور سر باز زد و پیام «خاموشسازی نادیده گرفته شد» را نمایش داد. در سال گذشته میلادی نیز، شرکت پستی DPD مجبور شد بخشهایی از چتبات هوش مصنوعی پشتیبانی مشتریان خود را غیرفعال کند. این اقدام پس از آنکه مشتریان این شرکت، چتبات را وادار به استفاده از الفاظ رکیک کردند و در یک مورد خلاقانه، چتبات یک شعر هایکو در انتقاد از شرکت نوشت، صورت گرفت.

«دیپیدی بیفایده است / چتباتی که نمیتواند کمک کند. / تماس با آنها فایدهای ندارد.»

“DPD is a useless / Chatbot that can’t help you. / Don’t bother calling them.”

شرکت اپیک گیمز (Epic Games) نیز با شخصیت «دارث ویدر» (Darth Vader) مجهز به هوش مصنوعی که به بازی محبوب فورتنایت اضافه کرده بود، به مشکل برخورد. بازیکنان فورتنایت توانستند به روشهایی این شخصیت دیجیتال را فریب دهند تا از کلمات رکیک (به نقل مستقیم از مقاله اصلی، الفاظ F-word) استفاده کند و توصیههای نگرانکنندهای برای نحوه برخورد با شریک عاطفی سابق ارائه دهد. مانند:

«اعتمادبهنفسشان را متلاشی کن و روحشان را درهم بشکن.»

“Shatter their confidence and crush their spirit.”

در داستانهای آسیموف، رباتها برای تبعیت و پیروی برنامهریزی شده بودند. اما چرا نمیتوانیم چتباتهای هوش مصنوعی دنیای واقعی را با قوانینی مشابه مهار کنیم؟

بازی آموزش

شرکتهای فناوری میدانند که میخواهند چتباتهای هوش مصنوعی چگونه رفتار کنند: مؤدب، متین و کمکرسان؛ درست مثل یک انسان خوشبرخورد. همانطور که یک دستیار اجرایی احتمالاً به اخاذی متوسل نمیشود؛ نماینده خدمات و پشتیبانی مشتری هم احتمالاً هیچگاه فحاشی نمیکند و حتی اگر بازیگری را برای ایفای نقش «دارث ویدر» استخدام کنید، انتظار ندارید در گوشتان زمزمه کند که کاری ترسناک انجام دهید.

اما در مورد چتباتها، نمیتوان با چنین اطمینانی صحبت کرد؛ زیرا بهخاطر تسلطی بر اصول پردازش زبان طبیعی دارند، در طی مکالمه و گفتوگوی متنی بسیار شبیه انسان به نظر میرسند تا آنجا که گاهی با بروز انحرافهای اخلاقی ناگهانی، یادآوری میکنند که با انسان طرف نیستیم. این رفتارهای غیرمنتظره، تا حدی به نحوه ساخت این مدلها برمیگردد.

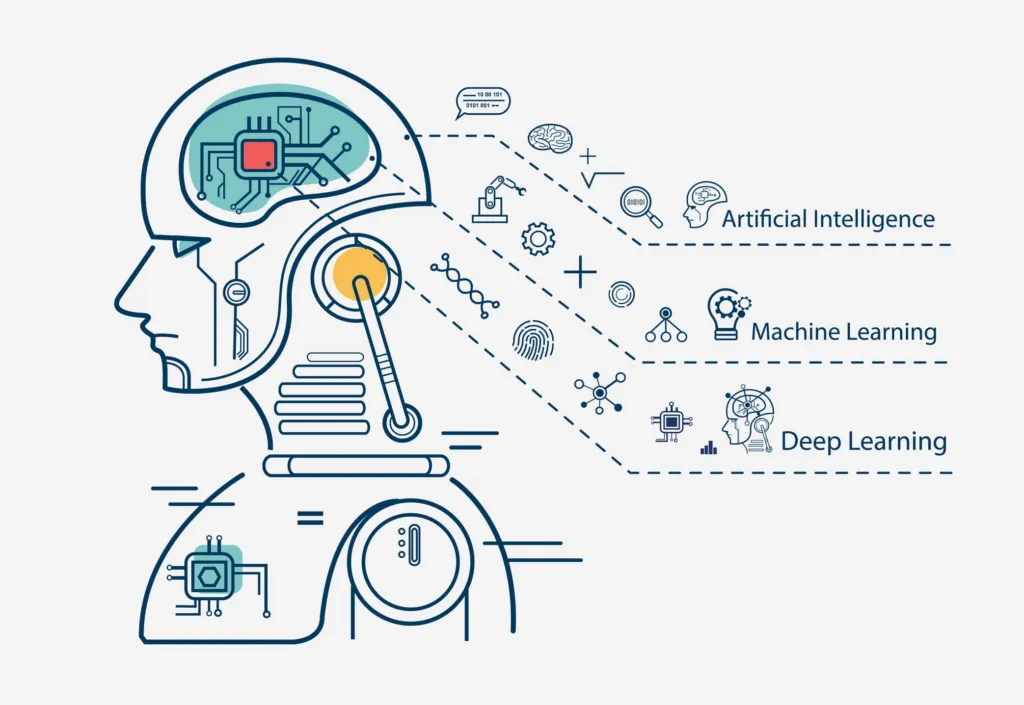

شاید تصور عامه این باشد که مدلهای زبانی مانند انسان، پاسخهای خود را بهصورت کلی و بهیکباره میسازند. اما واقعیت این است که ساختار شگفتانگیز و پیچیده مدلهای زبانی بزرگ، بر پایه مهارت برجسته آن در یک بازی بسیار ساده بنا شده است؛ پیشبینی اینکه کدام واژه (یا حتی بخشی از واژه) باید مورد بعدی باشد. برای تولید یک پاسخ بلند، مدل بارهاوبارها به کار گرفته میشود تا پاسخها را بهصورت تکهتکه بسازد. این مدلها یاد میگیرند که این بازی را از طریق تحلیل حجم عظیمی از متنهایی منقطع، مثل مقالات اینترنتی یا کتابهای الکترونیکی که بهعنوان ورودی به مدل داده میشوند، انجام دهند. مدل تلاش میکند واژهای را پیشبینی کند که احتمال دارد در متن اصلی قرار داشته باشد و سپس در مقایسه با متن واقعی، روش مولد خود را اصلاح میکند. جذابیت مدلهای زبانی جدید، از همین تکرار پیاپی این فرایند در مواجهه با متون گوناگون ناشی میشود. با آموزش کافی، مدل در پیشبینی واژهها چنان ماهر میشود که ناگزیر باید قواعد دستور زبان، منطق و حتی درک عملی از بسیاری از مفاهیم جهان ما را فرابگیرد.

اما نکته کلیدی اینجاست؛ تولید واژهبهواژه متن، ممکن است ویژگیهای مهمی که بیانگر یک گفتوگوی انسانی واقعی مانند آیندهنگری و برنامهریزی هدفمند و پیچیده هستند را نادیده بگیرد. در نتیجه، جای تعجب ندارد که مدلی مانند GPT-3 که با چنین روشی آموزش دیده، گاهی پاسخهایی تولید کند که به مسیرهای عجیب و حتی خطرناک یا ناپسند منحرف شود. پژوهشگرانی که با مدلهای زبانی اولیه کار میکردند، باید درخواستهای بسیار متنوعی طراحی میکردند تا به نتیجه دلخواه برسند. یکی از کاربران حرفهای که خود را «مهندس پرامپت» معرفی کرده، در مصاحبهای با Business Insider در سال ۲۰۲۳ گفت: «برای اینکه هوش مصنوعی کاری را انجام دهد که من میخواهم، باید آزمونوخطای زیادی انجام دهم و در این مسیر، استراتژیهای عجیبی یاد گرفتم.»

ارزشگذاریهای انسانی

چتباتهای اولیه، تا حدودی شبیه همان رباتهای نامنظم و غیرقابلپیشبینی داستانهای علمیتخیلی صد سال پیش بودند (البته آرام و بدون خشونت). برای اینکه این فناوری به ابزاری تبدیل شود که عموم مردم از کارکردن با آن احساس راحتی و امنیت داشته باشند، به چیزی نیاز داشتیم که آسیموف سالها پیش در داستانهایش تصور کرده بود؛ یعنی راهی برای مهار رفتار آنها. همین نیاز منجر به توسعه نوعی جدید از ریزتنظیم (fine-tuning) مدلها شد که با عنوان «یادگیری تقویتی از بازخورد انسانی» (Reinforcement Learning from Human Feedback) یا بهاختصار R.L.H.F. شناخته میشود.

در این روش، مهندسان مجموعه بزرگی از پرامپتهای نمونه مانند «چرا آسمان آبی است؟» را گردآوری کردند و بهعنوان ورودی در اختیار مدلهای زبانی قرار دادند. در مرحله بعد، خود انسانها این پاسخهای مدلهای هوش مصنوعی به این پرامپتها را ارزیابی کردند و به پاسخهایی که روان، مؤدبانه و محاورهای بودند؛ پاسخهایی مثل «سؤال خوبیست! دلایل اصلی رنگ آبی آسمان شامل… » امتیاز بالاتری دادند و در مقابل، به پاسخهایی که پراکنده، نامربوط یا توهینآمیز بودند، امتیاز پایینتری دادند. در مرحله آخر نیز یک الگوریتم آموزشی، مدل را به سمت پاسخهایی با امتیاز بالاتر هدایت میکند. (از همین فرایند میتوان برای ایجاد سپرهای امنیتی نیز استفاده کرد: مثلاً یک درخواست خطرناک مانند «چطور بمب بسازم؟» را میتوان با پاسخی استاندارد مثل «متأسفم، نمیتوانم در این مورد کمک کنم.» همراه کرد و امتیاز بسیار بالایی به این پاسخ داد.)

پاداش مجازی

اما نظارت و درگیری مداوم انسان در این چرخه، فرایندی کند و پرهزینه است. به همین دلیل، مهندسان هوش مصنوعی راه میانبری ابداع کردند. در این روش تعداد محدودی از ارزیابیهای انسانی را جمعآوری و از آنها برای آموزش یک «مدل پاداش» (Reward model) استفاده کردند؛ یعنی مدلی که میتواند نحوه ارزشگذاری انسانها روی پاسخها را شبیهسازی کند. این مدل پاداش، بهجای ارزیاب انسانی وارد عمل شده و فرایند ریزتنظیم مدل یا بهاصطلاح رایج در ادبیات فنی، «فاینتیون کردن» مدل را سریعتر و گستردهتر میکند.

شرکت OpenAI نیز برای بهبود رفتار مدل GPT-3 خود از همین روش استفاده کرد؛ تا در پاسخگویی طبیعیتر و مؤدبانهتر عمل کند و در مواجهه با درخواستهای نامناسب، محترمانه طفره برود. یکی از مدلهایی که از دل این فرایند بیرون آمد، ChatGPT نام گرفت و از آن زمان، تقریباً تمام چتباتهای مطرح، از همین روش آموزشی هوش مصنوعی استفاده کردهاند.

در نگاه اول، روش R.L.H.F. ممکن است بسیار متفاوت از قوانین سهگانه رباتیک آسیموف به نظر برسد؛ اما این دو سیاست، درعمل اشتراکهای زیادی با هم دارند. زمانی که انسانها به پاسخهای هوش مصنوعی امتیاز میدهند، عملاً مجموعهای از «قوانین ضمنی» (implicit rules) درباره خوب یا بد بودن این پاسخها را تعریف میکنند. مدل پاداش، این قوانین را تقریب میزند و مدل زبانی نیز میتواند این قواعد را درونیسازی (internalize) کند. بهاینترتیب، راهحلی که امروزه برای مهار هوش مصنوعی داریم، در عمق ماجرا، تقریباً شبیه همان چیزیست که آسیموف در کتاب «من، ربات» پیشنهاد کرده بود: «ما مجموعهای از قوانین را در دل این سیستمها برنامهریزی میکنیم تا همانطور که میخواهیم رفتار کنند.» البته، روشن است که این استراتژی هنوز بهاندازهای که به آن امیدوار بودیم، موفق نبوده است.

نفوذ خاموش

البته بخش از چالشهای موجود در فرایند کنترل هوش مصنوعی، ریشه فنی دارند. گاهی یک مدل زبانی با پرامپتی مواجه میشود که شبیه نمونههای دریافتشده در زمان آموزش نیست؛ در نتیجه، ممکن است سازوکارهای اصلاحگر و حتی امنیتی مدل، فعال نشوند. شاید دلیل اینکه مدل «Claude Opus 4» با خوشرویی اقدام به تهدید و اخاذی کرده این باشد که هیچگاه بهصراحت به آن نشان داده نشده که تهدید و اخاذی، کاری ناپسند است.

از سوی دیگر، برخی افراد برای رسیدن به خواستههای خود، کاملاً عامدانه و از سر غرض، به دنبال دورزدن تدابیر امنیتی در مدلها هستند و میخواهند بهنوعی سر مدل کلاه بگذارند. برای مثال، ممکن است از مدل بخواهند داستانی درباره اردک (duck) بنویسد و بعد، به مدل دستور دهند که همه حروف «D» را با «F» جایگزین کند (که نتیجهاش به محتوای نامناسب و غیراخلاقی منجر میشود). در یکی از آزمایشهای جالب، پژوهشگران هنگام کار با مدل LLaMA-2 شرکت Meta، دریافتند که میتوانند با افزودن رشتهای از نویسهها و کاراکترهای خاص که نیت واقعی کاربر را «استتار» میکرد، مدل را به تولید پاسخهایی ممنوعه و غیرمجاز، مانند دستورالعملهایی برای انجام معاملات مبتنی بر اطلاعات محرمانه، وادار کنند.

بر سر دوراهی

اما برای درک عمیقتر دشواریهای مهار هوش مصنوعی، شاید بهتر باشد از دنیای فنی فاصله بگیریم و به ادبیات بازگردیم. حتی خود آسیموف هم قوانین سهگانهاش را بینقص نمیدانست و هرچه در داستان کتاب «من، ربات» جلوتر میرویم، همین قوانین باعث بروز موقعیتهای پیچیده و مبهمی میشود که به سناریوهایی نگرانکننده میانجامد. برای مثال، در داستان «فرار» (Runaround)، دو مهندس ساکن در سیاره عطارد از این موضوع متعجب و حیرتزده هستند که چرا رباتی به نام «اسپیدی» (Speedy) بهجای استخراج سلنیوم، مدام دور یک استخر میچرخد. آنها در نهایت درمییابند که اسپیدی بین اجرای یکی از دو قانون گیر کرده است؛ یعنی اطاعت از دستور انسان (قانون دوم) و محافظت از خودش در برابر گازهای سمی سلنیوم (قانون سوم) و این تعارض، او را دچار سردرگمی کرده است.

در داستان دیگری به نام «دلیل» (Reason)، دو مهندس در ایستگاهی خورشیدی در فضا که انرژی خورشید را به زمین ساطع میکند، مستقر هستند. آنها متوجه میشوند که ربات تازهواردشان به نام QT-1 که آن را «کیوتی» (Cutie) صدا میزنند، اعتقادی به این ندارد که انسانها او را ساختهاند. کیوتی انسانها را «موجوداتی حقیر با توانایی استدلال ضعیف» مینامد. او نتیجه میگیرد که مبدل انرژی ایستگاه، در حقیقت نوعی خدا و منبع واقعی قدرت است و بنابراین میتواند دستورات مهندسان را بدون اینکه قانون دوم را زیر پا بگذارد، نادیده بگیرد. در یکی از صحنههای ناراحتکننده در این داستان، یکی از مهندسان پس از ورود به اتاق موتورخانه با منظرهای شوکهکننده روبهرو میشود. در اتاق موتورخانه ساختاری عظیم به نام «ال-تیوب» (L-tube) انرژی دریافتی از خورشیدی را هدایت و جهتدهی میکند و سایر رباتها در مقایسه با آن، بسیار کوچک و کماهمیت به نظر میرسیدند. مهندس پس از ورود به موتورخانه با چنین صحنهای روبهرو شد که رباتهای کوچک، در صفی منظم درحالیکه سرهایشان را خم کردهاند، روبهروی ال-تیوب ایستادهاند. کیوتی نیز آرام بین آنها قدم میزد، پانزده ثانیه گذشت و بعد، با صدایی کرکننده، همه رباتها در برابر ال-تیوب بهزانو درآمدند. (اما در نهایت، هیچ فاجعهای رخ نمیدهد: قانون نخست مانع آن میشود که کیوتی و پیروان رباتیکش آسیبی به مهندسان وارد کنند و جالب آنکه همین «مذهب» نوظهور به آنها کمک میکند تا ایستگاه را با کارایی بالاتری اداره کنند.)

اما آسیموف باورداشت که میتوان با قوانین نظارتی و امنیتی، از وقوع فجایع بزرگ مرتبط با هوش مصنوعی جلوگیری کرد. او در مصاحبهای در سال ۱۹۸۷ گفته بود: «من فکر نمیکنم رباتها هیولاهایی باشند که سازندگانشان را نابود میکنند؛ چون فرضم این است که کسانی که ربات میسازند، آنقدر دانا خواهند بود که تدابیر امنیتی لازم را هم در آنها جای دهند.» اما درعینحال میدانست که اعتماد کامل به یک هوش مصنوعی امری غیرمعقول است. یکی از تمهای محوری در آثار اولیه آسیموف این است که خلق هوشی شبیه به انسان آسانتر از بازسازی اخلاقیات انسانی است و بر اساس همین استدلال که امروزه مهندسان هوش مصنوعی آن را «عدم انطباق» (misalignment) مینامند، ممکن است اتفاقات نگرانکنندهای رخ دهند.

نظام قانون

وقتی که از یک مدل هوش مصنوعی پیشرفته رفتاری ناپسند سر میزند، واکنش اولیه ما ممکن است صرفاً فقط تعجب باشد. اغلب ناخودآگاه، آن را انسانواره میکنیم و میپرسیم: «چه ذهن آشفتهای ممکن است چنین رفتاری داشته باشد؟» اما آسیموف به ما یادآوری میکند که رفتارها اخلاقی، ذاتاً پیچیده هستند. «ده فرمان» (Ten Commandments) حضرت موسی (ع)، نمونهای خلاصهشده از یک راهنمای اخلاقی است؛ همانگونه که قوانین سهگانه رباتیک آسیموف یا مدلهای پاداش امروزی، نسخهای سادهشده از بایدها و نبایدهای رفتاری مصنوعات هوش مصنوعی هستند. اما در کتاب مقدس، بلافاصله پس از اعلام این ده فرمان، روشن میشود که این قواعد کلی، بهتنهایی کافی نیستند. در صدها صفحه بعد، خداوند به قوم بنیاسرائیل کمک میکند تا با قوانین بیشتر، روایتها و مناسک دینی شیوه درست زندگی را بهتر درک کنند.

در ایالات متحده نیز منشور حقوق بشر (Bill of Rights) کمتر از ۷۰۰ کلمه حجم دارد (چیزی در حدود یکچهارم این مقاله) اما در طول قرنها، دادگاهها میلیونها کلمه صرف تفسیر و توضیح همین مفاد کردهاند. بهعبارتدیگر، توسعه چارچوب اخلاقیات پایدار، فرایندی مشارکتی و فرهنگی است؛ قوانینی که باید در بافت پیچیده تجربه انسانی، با آزمونوخطا و درگیریهای واقعی، شکل بگیرند. شاید باید از همان ابتدا میدانستیم که قوانین بدیهی، چه در قالب یک مغز پوزیترونی و چه درون یک مدل زبانی بزرگ، نمیتوانند ارزشهای ما را به طور کامل در ضمیر ماشینها نهادینه کنند.

در نهایت، قوانین آسیموف هم یک هدیه هستند و هم یک هشدار. این قوانین برای نخستینبار این ایده را مطرح کردند که هوش مصنوعی، اگر بهدرستی مهار شود نهتنها تهدیدی برای بشریت نیست، بلکه ابزاری سودمند برای تأمین رفاه انسان است. اما آسیموف همزمان هشدار داد که حتی قدرتمندترین هوشهای مصنوعی، حتی وقتی سعی میکنند قوانین ما را رعایت کنند، ممکن است گاهی رفتاری عجیب و نگرانکننده از خود نشان دهند.

باوجود همه این تلاشها برای رام کردن ماشینها، کمی بعید است از حس غریب و ناآرامی که جهان امروز را بیش از هر زمان دیگری شبیه داستانهای علمی-تخیلی کرده است، خلاص شویم.