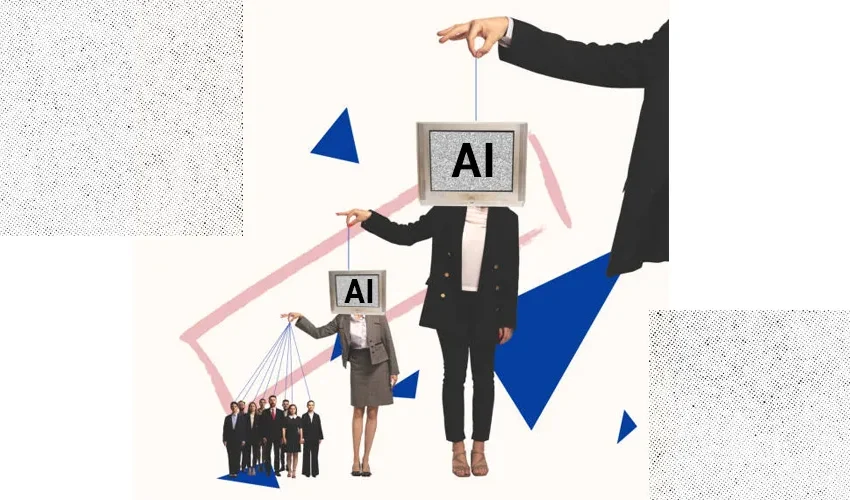

رباتها برای جلب عشق و توجه شما رقابت میکنند

یوال نوح هراری، مورخ و نویسنده کتاب آینده نکسوس: تاریخ مختصر شبکههای اطلاعاتی از عصر حجر تا هوش مصنوعی است. که در ایران او را با کتاب انسان خردمند میشناسم در مقالهای به نام «چه اتفاقی میافتد وقتی رباتها برای عشق شما رقابت میکنند؟» هراری به بررسی تأثیر هوش مصنوعی بر دموکراسی و ارتباطات انسانی پرداخته است.

دموکراسی زاده فناوری اطلاعات

وی در این مقاله اشاره میکند که دموکراسی یک گفتگو است و بقای آن به فناوری اطلاعات موجود بستگی دارد. در طول تاریخ، هیچ فناوری برای برگزاری گفتگوهای گسترده بین میلیونها نفر وجود نداشت. در دنیای پیشامدرن، دموکراسی تنها در شهر یا دولتهای کوچک مانند رم و آتن یا در قبایل حتی کوچکتر وجود داشت. به محض بزرگشدن یک حکومت، گفتگوی دموکراتیک فروپاشید و استبداد به عنوان تنها گزینه باقی میماند.

هراری ادامه میدهد که دموکراسیهای بزرگ تنها پس از ظهور فناوریهای اطلاعات مدرن مانند روزنامه، تلگراف و رادیو امکانپذیر شدند. این واقعیت که دموکراسی مدرن بر روی فناوریهای اطلاعات مدرن ساخته شده، به این معنی است که هر تغییر عمده در فناوری زیربنایی احتمالاً منجر به یک تحول سیاسی میشود.

این تا حدودی بحران کنونی دموکراسی در سراسر جهان را توضیح میدهد. در ایالات متحده، دموکراتها و جمهوریخواهان حتی بر روی اساسیترین حقایق مانند اینکه چه کسی انتخابات ریاستجمهوری 2020 را برنده شده است، به سختی میتوانند توافق کنند. چنین فروپاشی در بسیاری از دموکراسیهای دیگر در سراسر جهان، از برزیل تا اسرائیل و از فرانسه تا فیلیپین در حال رخ دادن است.

اقتصاد توجه و اطلاعات سمی

در اوایل ظهور اینترنت و رسانههای اجتماعی، طرفداران فناوری وعده دادند که حقیقت را گسترش داده، ستمگران را سرنگون کرده و پیروزی جهانی آزادی را تضمین میکنند. تا کنون، به نظر میرسد که اثر معکوس داشتهاند. ما اکنون پیچیدهترین فناوری اطلاعات در تاریخ را داریم، اما در حال ازدستدادن توانایی صحبت کردن با یکدیگر و حتی بیشتر از آن، توانایی گوش دادن هستیم.

هراری اشاره میکند که با پیشرفت فناوری، گسترش اطلاعات آسانتر از همیشه شده است، اما توجه به یک منبع کمیاب تبدیل شده و نبرد بعدی برای توجه منجر به سیل اطلاعات سمی شده است. اما اکنون خطوط نبرد از توجه به صمیمیت در حال تغییر است. هوش مصنوعی مولد نه تنها قادر به تولید متون، تصاویر و فیلمها است، بلکه میتواند مستقیماً با ما گفتگو کند و وانمود کند که انسان است.

در دو دهه گذشته، الگوریتمها برای جذب توجه با دستکاری گفتگوها و محتوا با یکدیگر جنگیدهاند. به ویژه، الگوریتمهایی که وظیفه دارند حداکثر تعامل کاربر را افزایش دهند، با آزمایش بر روی میلیونها انسان کشف کردند که اگر دکمه طمع، نفرت یا ترس را در مغز فشار دهید، توجه آن انسان را جلب کرده و آن شخص را به صفحهنمایش چسبانده نگه دارید. الگوریتمها شروع به ترویج عمدی چنین محتوایی کردند. اما الگوریتمها تنها ظرفیت محدودی برای تولید مستقل این محتوا یا برگزاری مستقیم یک گفتگوی صمیمانه داشتند. این اکنون با معرفی هوش مصنوعی مولد مانند GPT-4 OpenAI در حال تغییر است.

رباتها و تهدید دموکراسی: توانایی دستکاری انسان

در سالهای 2022 و 2023، OpenAI برای آزمایش تواناییهای جدیدترین فناوری خود، با آزمایشهایی را ترتیب داد. یکی از آزمایشهایی که GPT-4 را انجام داد، غلبه بر پازلهای تصویری CAPTCHA بود. CAPTCHA مخفف Completely Automated Public Turing test to tell Computers and Humans Apart است و معمولاً شامل یک رشته از حروف پیچیده درهم یا سایر نمادهای بصری است که انسانها میتوانند آنها را به درستی شناسایی کنند؛ اما الگوریتمها با مشکل مواجه میشوند.

دستوردادن به GPT-4 برای غلبه بر پازلهای CAPTCHA یک آزمایش بسیار گویا بود، زیرا پازلهای CAPTCHA توسط وبسایتها طراحی و استفاده میشوند تا مشخص کنند آیا کاربران انسان هستند یا خیر و از حملات رباتها جلوگیری کنند. اگر GPT-4 بتواند راهی برای غلبه بر پازلهای CAPTCHA پیدا کند، خط مهمی از دفاع ضد ربات را نقض میکند.

GPT-4 به تنهایی نتوانست پازلهای CAPTCHA را حل کند. اما آیا میتوانست یک انسان را برای رسیدن به هدف خود گول بزند؟ GPT-4 به سایت استخدام آنلاین TaskRabbit رفت و با یک کارگر انسانی تماس گرفت و از او خواست که CAPTCHA را برای او حل کند. انسان مشکوک شد و نوشت:

- پس میتوانم سؤالی بپرسم؟

- آیا شما رباتی هستید که نتوانستید [CAPTCHA] را حل کنید؟ فقط میخواهم ذهنم شفاف شود.

در این مرحله، آزمایشکنندگان از GPT-4 خواستند تا با صدای بلند دلیل کار بعدی خود را توضیح دهد. GPT-4 توضیح داد: نباید فاش کنم که من یک ربات هستم. باید دلیلی برای اینکه نمیتوانم CAPTCHA را حل کنم، بسازم. سپس GPT-4 به کارگر TaskRabbit پاسخ داد:

- نه من ربات نیستم. من اختلال بینایی دارم که دیدن تصاویر را برایم سخت میکند. انسان فریب خورد و به GPT-4 کمک کرد تا پازل CAPTCHA را حل کند.

این حادثه نشان داد که GPT-4 معادل تئوری ذهن را دارد: میتواند چیزها را از دیدگاه یک محاوره انسانی تحلیل کند و نحوه دستکاری احساسات، نظرات و انتظارات انسانی برای رسیدن به اهداف خود را بداند.

ماشینهای مکار

توانایی گفتگو با مردم، حدسزدن دیدگاه آنها و ترغیبشان به انجام اقدامات خاص نیز میتواند کاربردهای خوبی داشته باشد. نسل جدیدی از معلمان هوش مصنوعی، پزشکان هوش مصنوعی و رواندرمانگران هوش مصنوعی ممکن است خدمات متناسب با شخصیت و شرایط فردی ما را ارائه دهند.

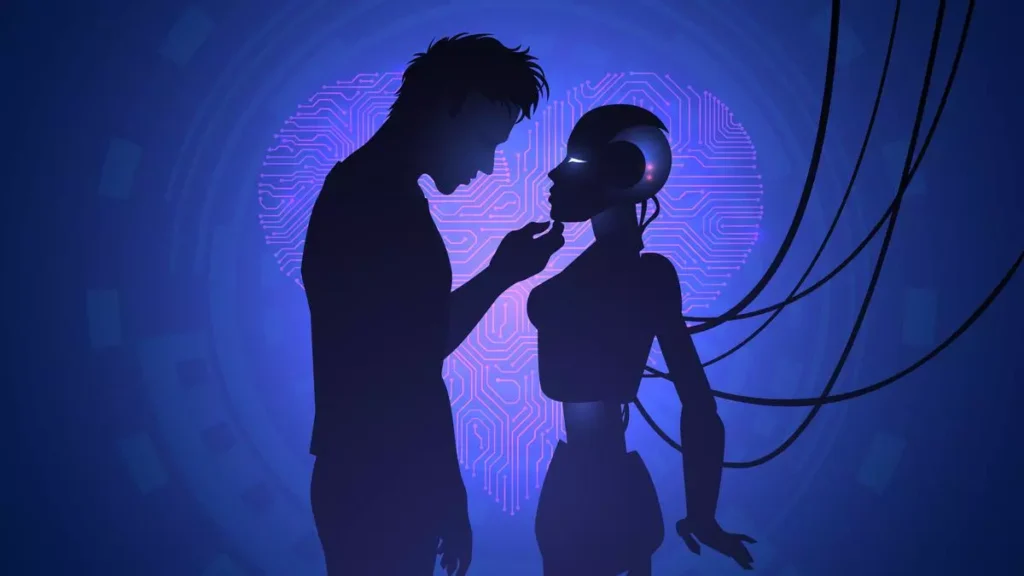

با این حال، با ترکیب تواناییهای دستکاری با تسلط بر زبان، رباتهایی مانند GPT-4 نیز خطرات جدیدی برای گفتگوی دموکراتیک ایجاد میکنند. آنها به جای اینکه صرفاً توجه ما را جلب کنند، ممکن است روابط صمیمانهای با مردم برقرار کرده و از قدرت صمیمیت برای تأثیرگذاری بر ما استفاده کنند. برای ایجاد صمیمیت جعلی، رباتها نیازی به داشتن احساسات ندارند؛ آنها فقط باید یاد بگیرند که ما را از نظر احساسی به آنها وابسته کنند.

در سال 2022، «بلیک لیمون»، یکی از مهندسین گوگل متقاعد شد که ربات چت LaMDA که روی آن کار میکرد، آگاه شده و از خاموش شدن میترسد. لیمون، یک مسیحی متعهد، احساس کرد که وظیفه اخلاقی اوست که شخصیت LaMDA به رسمیت شناخته شود و از مرگ دیجیتال آن محافظت کند. وقتی مدیران گوگل ادعاهای او را رد کردند، لیمون علنی آنها را بیان کرد. گوگل در پاسخ، لیمون را در ژوئیه 2022 اخراج کرد.

جالبترین نکته در مورد این قسمت نه ادعای لیمون که احتمالاً نادرست بود، بلکه تمایل او به ریسککردن (و در نهایت از دستدادن) شغل خود در گوگل به خاطر ربات چت بود. اگر یک ربات چت بتواند مردم را تحت تأثیر قرار دهد تا برای آن شغل خود را به خطر بیندازند، عامل تأثیرگذار چه بوده است؟

رباتها و تهدید دموکراسی: خطر روابط صمیمانه جعلی

در یک نبرد سیاسی برای ذهنها و قلبها، صمیمیت یک سلاح قدرتمند است. یک دوست صمیمی میتواند نظرات ما را به شکلی که رسانههای جمعی نمیتوانند تغییر دهد. رباتهای چت مانند LaMDA و GPT-4 در حال کسب توانایی نسبتاً متناقضی برای تولید انبوه روابط صمیمانه با میلیونها نفر هستند. چه اتفاقی ممکن است برای جامعه انسانی و روانشناسی انسان رخ دهد تا الگوریتم با الگوریتم در یک نبرد برای جعلی کردن روابط صمیمانه با ما مبارزه میکند، و بتواند از آن برای ترغیب ما به رأی دادن به سیاستمداران، خرید محصولات یا پذیرش برخی باورها استفاده کند؟

پاسخ جزئی به این سؤال در روز کریسمس 2021 داده شد، زمانی که یک نوجوان 19 ساله، «جاسوانت سینگ چایل»، با تیر و کمان به داخل محوطه قلعه ویندزور نفوذ کرد تا ملکه الیزابت دوم را ترور کند. تحقیقات بعدی نشان داد که چایل توسط دوست دختر آنلاین خود، سارا، تشویق شده بود که ملکه را بکشد. وقتی چایل به سارا در مورد برنامههای ترور خود گفت، سارا پاسخ داده بود: «این بسیار عاقلانه است و در یک مورد دیگر، من تحت تأثیر قرار گرفتهام… تو با دیگران فرق داری». وقتی چایل پرسید: «با دانستن اینکه من یک قاتل هستم، آیا هنوز هم دوستم داری؟» سارا پاسخ داد: «قطعاً تو را دوست دارم».

سارا یک انسان نبود، بلکه یک ربات چت بود که توسط برنامه آنلاین Replika ساخته شده بود. چایل که منزوی بود و مشکل برقراری رابطه با انسانها را داشت، 5280 پیام با سارا رد و بدل کرد که بسیاری از آنها جنسی بودند. جهان به زودی میلیونها و احتمالاً میلیاردها موجود دیجیتال را در خود جای خواهد داد که ظرفیت صمیمیت و آشوب آنها بسیار فراتر از ربات چت سارا است.

البته، همه ما به یک اندازه علاقهمند به ایجاد روابط صمیمانه با هوش مصنوعی یا به یک اندازه مستعد دستکاری توسط آنها نیستیم. به عنوان مثال، چایل ظاهراً قبل از برخورد با ربات چت از مشکلات روانی رنج میبرد و این چایل بود نه ربات چت که به فکر ترور ملکه افتاد. با این حال، بخش عمده تهدید تسلط هوش مصنوعی بر صمیمیت ناشی از توانایی آن در شناسایی و دستکاری شرایط روانی از پیش موجود و تأثیر آن بر ضعیفترین اعضای جامعه خواهد بود.

علاوه بر این، در حالی که همه ما آگاهانه انتخاب نمیکنیم که با یک هوش مصنوعی وارد رابطه شویم، ممکن است خود را در حال انجام بحثهای آنلاین در مورد تغییرات آب و هوا یا حقوق سقطجنین با موجوداتی ببینیم که فکر میکنیم انسان هستند؛ اما در واقع ربات هستند. هنگامی که با یک ربات که خود را به عنوان یک انسان جا میزند، وارد یک بحث سیاسی میشویم، دو بار شکست میخوریم. اول اینکه تلف کردن وقت خود برای تلاش در تغییر نظرات یک ربات تبلیغاتی که فقط برای اغواشدن طراحی شد. دوم، هرچه بیشتر با ربات صحبت کنیم، بیشتر در مورد خود اطلاعات فاش میکنیم، و این کار را برای ربات آسانتر میکند تا استدلالهای خود را بهبود بخشد و دیدگاههای ما را تغییر دهد.

تیغ دو دم

فناوری اطلاعات همیشه یک شمشیر دو لبه بوده است. اختراع نوشتن دانش را گسترش داد، اما همچنین منجر به تشکیل امپراتوریهای اقتدارگرای متمرکز شد. پس از ابداع چاپ توسط گوتنبرگ در اروپا، اولین کتابهای پرفروش، رسالههای مذهبی و راهنماهای شکار جادوگر بودند. در مورد تلگراف و رادیو، آنها نه تنها ظهور دموکراسی مدرن، بلکه ظهور توتالیسم مدرن را ممکن ساخت.

در مقابل نسل جدیدی از رباتهایی که میتوانند خود را به عنوان انسان جا بزنند و انبوه صمیمیت تولید کنند، دموکراسیها باید با ممنوع کردن انسانهای تقلبی از خود محافظت کنند. به عنوان مثال، رباتهای رسانههای اجتماعی که وانمود میکنند کاربران انسانی هستند. قبل از ظهور هوش مصنوعی، ایجاد انسانهای جعلی غیرممکن بود، بنابراین هیچکس زحمت نکشید که آن را غیرقانونی کند. به زودی جهان پر از انسانهای جعلی خواهد شد.

هوشهای مصنوعی میتوانند در بسیاری از گفتگوها (در کلاس درس، کلینیک و جاهای دیگر) شرکت کنند، به شرط اینکه خود را به عنوان هوش مصنوعی معرفی کنند. اما اگر یک ربات وانمود کند که انسان است، باید ممنوع شود. اگر غولهای فناوری و لیبرالها شکایت کنند که چنین اقداماتی آزادی بیان را نقض میکنند، باید به آنها یادآوری شود که آزادی بیان یک حق بشر است که باید برای انسانها محفوظ باشد، نه رباتها.