خوداندیشی یا تقلب در هوش مصنوعی

«مت شومر»، بنیانگذار OthersideAI، اعلام کرد که این شرکت اخیراً یک پیشرفت مهم داشته است. این پیشرفت به آنها کمک کرده تا یک مدل متوسط را آموزش دهند و عملکردی در سطح SOTA (بهترین در کلاس خود) با راهاندازی Reflection به دست آورند و این مدل از GPT-4o و Claude Sonet 3.5 بهتر است.

اما این هیجان مدت زیادی دوام نیاورد، زیرا بسیاری از کاربران شروع به شکایت کردند و گفتند که API Reflection فقط یک لایه اضافی بر روی Claude 3.5 Sonnet است و پاسخها در هر دو مدل دقیقاً یکسان است.

پس دقیقاً چه چیزی اشتباه شده؟

تحلیلگران مستقل با بررسی و مقایسه مدل Reflection AI 70B با مدلهای دیگر، اعلام کردند که عملکرد آن بسیار ناامیدکننده بوده و عملکرد ضعیفتری نسبت به Llama 3 70B نشان داد.

یک کاربر در Reddit گفته که مدل Reflection طوری طراحی شده که ابتدا پاسخهای نادرست بدهد و بعداً به فکرکردن بپردازد. او توضیح میدهد: «اگر از آن بپرسید ۲+۲ چقدر است، در مثال پیشفرض در صفحه Hugging Face میگوید ۲+۲=۳. سپس میگوید: صبر کنید، اشتباه کردم؛ ۲+۲ واقعاً ۴ است. اگر این فرایند تفکر پنهان باشد، شاید کار کند، اما خیلی عجیب است».

وقتی Artificial Analysis در بررسی این مدل نتایج ضعیفی به دست آورد، دسترسی به APIهای خصوصی مدلهای Reflection به آن داده شد. در این مرحله، عملکرد مدلها بسیار بهتر از نتایج قبلی ارزیابی کرد. اما دوباره وقتی این عملکرد را با مدلهای موجود در Hugging Face مقایسه کرد، نتایج کاملاً متفاوت بود؛ زیرا مدلهای موجود در Hugging Face عملکرد ضعیفی داشتند.

همانطور که گفته شد، کاربران گزارش دادند که Reflection فقط یک لایه اضافی بر روی Claude است. زمانی که مدل Reflection بر روی OpenRouter در دسترس قرار گرفت، کاربران اعلام کردند که این نسخه نسبت به نسخه قبلی بسیار سادهتر شده و به شدت سانسور شده است.

یک کاربر در Reddit تجربهاش را اینگونه بیان کرد: «به نظر میرسد نسخه موجود در OpenRouter به شدت سانسور شده و ساده شده است؛ در واقع، اصلاً به آنچه من درخواست کردم، پاسخ نمیدهد، در حالی که نسخه اصلی عملکرد خوبی داشت؛ بنابراین احتمالاً در ابتدا برای Reflection از ChatGPT یا Llama3+ChatGPT استفاده شده و حالا به Claude تغییر کرده است.»

شومر ابتدا به فرآیند بارگذاری اشاره کرد و گفت که ممکن است هنگام بارگذاری وزنها در Hugging Face مشکلی پیش آمده باشد، اما این توضیح نتوانست مشکل را حل کند؛ بنابراین، او یک قدم جلوتر رفت و تصمیم گرفت آموزش مدل هوش مصنوعی را از ابتدا آغاز کند تا همه مشکلات را برطرف کند.

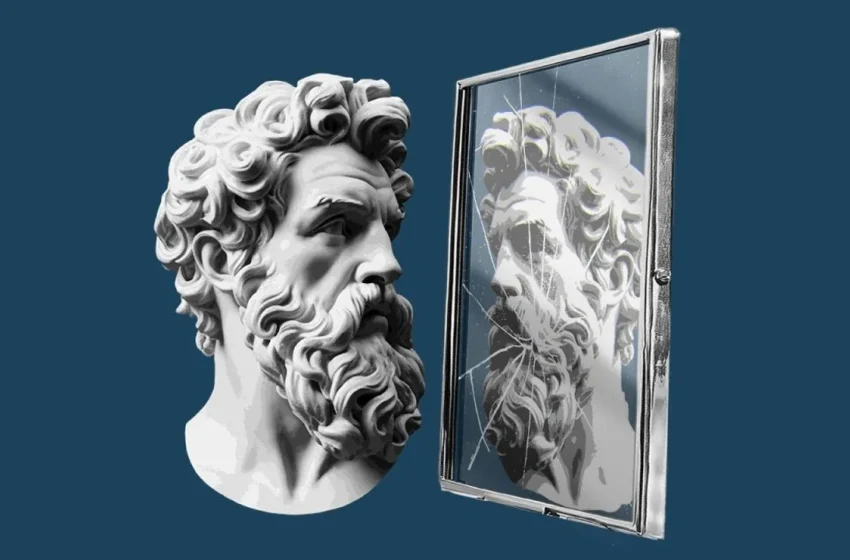

زمان خوداندیشی است

شومر ادعا کرد که مدلهای Reflection بهترین مدلهای متنباز تا به امروز هستند. این مدلها از روش تنظیم بازتابی (reflection-tuning) استفاده میکنند که برای آموزش مدلهای هوش مصنوعی به شناسایی و اصلاح اشتباهاتشان طراحی شده است.

این رویکرد به نظر میرسید که میتواند به یکی از چالشهای دائمی مدلهای زبانی یعنی تمایل به «توهم» یا تولید اطلاعات نادرست پاسخ دهد.

شومر گفت: «وقتی مدلهای زبانی بزرگ (LLMs) اشتباه میکنند، اغلب این اشتباهات را به عنوان واقعیت میپذیرند. اگر بتوانیم این مدلها را طوری آموزش دهیم که بیشتر مانند انسانها فکر کنند، رفتار خود را بررسی کنند و اشتباهاتشان را شناسایی کنند، مدلها هوشمندتر و قابلاعتمادتر خواهند شد.» او اشاره کرد که تنظیم بازتابی (reflection tuning) میتواند به مدلها کمک کند تا بهتر استدلال کنند.

وقتی مدل یک پاسخ تولید میکند، فرایند استدلال خود را نیز ارائه میدهد و این فرایند با برچسبهای خاصی (مثل <thinking>) احاطه میشود. هنگامی که مدل در حین استنتاج یک اشتباه را شناسایی میکند، آن را با برچسب «reflection» علامتگذاری کرده و خود را اصلاح میکند. این ویژگی بهویژه در حل مسائل پیچیده، باعث افزایش قابلیت اعتماد مدل میشود.

یک کاربر در Reddit یک مشکل کلاسیک به نام «مسئله کالسکه» را حل کرد. او برای این کار فقط جمله «این معمولی نیست» را به درخواستش اضافه کرد و این نشان میدهد که روش تنظیم بازتابی میتواند به مدل کمک کند تا بهتر فکر کند.

آیا دوبارهآموزی میتواند مشکل را حل کند؟

شومر گفت که این مشکل نباید از اول پیش میآمد. او توضیح داد که تیمش تمام تلاش خود را کردهاند، اما عملکردی که از Hugging Face میگیرند، خیلی بدتر از زمانی است که مدل Reflection را به طور محلی اجرا میکنند.

برخی از کاربران معتقدند که هدف از انتشار مدل Reflection، تبلیغ برای GlaiveAI بوده است. چون شومر بخشی از این شرکت را مالک است و او را در حال تبلیغ GlaiveAI دیدهاند. شومر در پاسخ گفت که او فقط یک سرمایهگذار کوچک است و حدود ۱۰۰۰ دلار در GlaiveAI سرمایهگذاری کرده است.

همچنین باید به این نکته توجه کرد که مدل Reflection در اولین انتشار خود به خاطر رویکرد تنظیم بازتابی تحسین شده است؛ بنابراین، پیشنهاد میشود قبل از قضاوت سخت درباره این مدل، منتظر بهروزرسانی یا انتشار بعدی باشیم.