GPT-5 نشانههایی از توقف پیشرفت و توسعه مدلهای زبانی بزرگ را نمایان کرده است

اگر هوش مصنوعی دیگر بیشتر از این پیشرفت نکند چه؟

تفاوتهای نهچندان محسوس نسخه جدید ChatGPT با نسخههای پیشین آن، گمانهزنیهایی از کاهش سرعت یا حتی توقف روند توسعه مدلهای زبانی بزرگ را در میان کاربران و متخصصان به دنبال داشته است.

بخش زیادی از شوروشوق و البته هراس پیرامون فناوریهای امروز هوش مصنوعی به ژانویه ۲۰۲۰ بازمیگردد؛ زمانی که تیمی از پژوهشگران OpenAI گزارشی سیصفحهای با عنوان «قوانین مقیاسپذیری برای مدلهای زبانی عصبی» (Scaling Laws for Neural Language Models) منتشر کردند. رهبری این تیم بر عهده «جرد کاپلان» (Jared Kaplan)، پژوهشگر هوش مصنوعی بود و «داریو آمودی» (Dario Amodei)، مدیرعامل فعلی Anthropic نیز در آن حضور داشت. آنها به یک پرسش کاملاً تخصصی پرداختند: وقتی اندازه مدلهای زبانی و شدت آموزش آنها افزایش پیدا کند، چه اتفاقی برای عملکردشان رخ میدهد؟ رسانه The New Yorker نیز در گزارشی به بررسی این ابهامات پرداختهاست.

جهش گمراهکننده

در آن زمان، بسیاری از متخصصان یادگیری ماشین تصور میکردند که مدلهای زبانی پس از رسیدن بهاندازهای مشخص، صرفاً شروع به حفظکردن پاسخهای دادههای آموزشی میکنند و این امر باعث میشود در عمل کارایی کمتری داشته باشند. اما مقاله OpenAI استدلال میکرد که این مدلها هرچه بزرگتر شوند با رشدی نمایی بهتر هم خواهند شد. پیام روشن بود؛ اگر مدلهای زبانی بزرگتر بسازید و آنها را با دادههای عظیمتر آموزش دهید، به شکل شگفتانگیزی عملکرد بهتری خواهند داشت. چند ماه بعد، OpenAI با معرفی GPT-3 این قانون مقیاسپذیری را در عمل تأیید کرد؛ این مدل ده برابر بزرگتر از GPT-2 بود و جهشی خیرهکننده در کیفیت را از خود نشان داد.

جرقه ایده

ناگهان ایده «هوش جامع مصنوعی» (Artificial general intelligence – AGI) بهعنوان سیستمی که در طیف وسیعی از وظایف همسطح یا حتی بهتر از انسان عمل میکند دستیافتنی به نظر رسید. اگر قانون مقیاس برقرار میماند، شرکتهای هوش مصنوعی میتوانستند تنها با تزریق سرمایه و توان پردازشی بیشتر به مدلهای زبانی، به AGI دست پیدا کنند. کمتر از یک سال بعد، سم آلتمن مدیرعامل OpenAI در یادداشتی با عنوان «قانون مور برای همه چیز» (Moore’s Law for Everything) نوشت: «هوش مصنوعی بخش بیشتری از کارهایی را که امروز انسانها انجام میدهند بر عهده خواهد گرفت و برای صاحبان سرمایه ثروتی غیرقابلتصور ایجاد میکند.» او تأکید کرد: «این انقلاب فناورانه متوقفشدنی نیست. جهان چنان سریع و بنیادین تغییر خواهد کرد که سیاستگذاریها نیز باید به همان اندازه تغییر کند تا توزیع ثروت انجام شود و افراد بیشتری بتوانند زندگی دلخواه خود را دنبال کنند.»

در اینکه جامعه هوش مصنوعی تا چه حد به این باور رسید که رسیدن به AGI تنها از مسیر مقیاسپذیری ممکن است نمیتوان اغراق کرد. در سال ۲۰۲۲ «گری مارکوس» (Gary Marcus)، کارآفرین هوش مصنوعی و استاد بازنشسته روانشناسی و علوم اعصاب دانشگاه نیویورک، به مقاله کاپلان انتقاد وارد کرد و یادآور شد: «قوانین موسوم به مقیاس، قوانین جهانشمول مانند جاذبه نیستند، بلکه صرفاً مشاهداتی هستند که ممکن است همیشه برقرار نمانند.» اما واکنشها نسبت به این انتقاد بسیار تند و فوری بودند. مارکوس بعدها نوشت: «هیچ نوشته دیگری از من تا این اندازه توسط افراد مشهور مانند سم آلتمن، گرگ براکمن، یان لکون و ایلان ماسک، به سخره گرفته نشده است.» اندکی بعد ChatGPT به سریعترین سامانهای در تاریخ فناوریهای دیجیتال بدل شد که به صد میلیون کاربر میرسد. در مارس ۲۰۲۳، انتشار GPT-4 توسط OpenAI چنان جهشی بر روی منحنی مقیاس ایجاد کرد که حتی الهامبخش مقالهای پژوهشی از سوی مایکروسافت با عنوان «جرقههای هوش جامع مصنوعی» (Sparks of Artificial General Intelligence) شد و ظرف یک سال آینده، حجم سرمایهگذاریهای خطرپذیر در حوزه هوش مصنوعی هشتاد درصد افزایش یافت.

نزول

اما در ادامه روند پیشرفت کند شد. OpenAI بیش از دو سال مدل بزرگ و چشمگیر جدیدی معرفی نکرد و در عوض بر نسخههای تخصصیتر تمرکز کرد که دنبالکردنشان برای عموم دشوار بود. رفتهرفته سؤالاتی مبنی بر اینکه آیا قانون مقیاسپذیری هوش مصنوعی در حال تضعیف است شکل گرفت. «ایلیا سوتسکِوِر» (Ilya Sutskever) یکی از همبنیانگذاران OpenAI به رویترز گفت: «دهه ۲۰۱۰ عصر مقیاس بود، حالا دوباره به عصر شگفتی و کشف برگشتهایم. همه در جستوجوی چیز بعدی هستند.» در همان زمان، وبسایت TechCrunch جو عمومی را چنین بیان کرد: «اکنون به نظر میرسد همه پذیرفتهاند که نمیتوان صرفاً با استفاده از محاسبات و دادههای بیشتر در پیشآموزش مدلهای زبانی بزرگ، آنها را بهنوعی خدای دیجیتال همهچیزدان تبدیل کرد.» اما چنین مشاهداتی تا حد زیادی زیر سایه سخنان پرهیاهوی دیگر رهبران هوش مصنوعی قرار گرفت. «داریو آمودی» (Amodei recently) نیز اخیراً عنوان کرده که: «هوش مصنوعی دارد تقریباً در همه کارهای فکری از انسانها بهتر میشود.» او در گفتوگویی با Axios پیشبینی کرد که نیمی از مشاغل اداری سطح پایه طی یک تا پنج سال آینده کاملاً حذف خواهند شد. سم آلتمن و هم مارک زاکربرگ هم نیز ادعا کردند که شرکتهایشان به توسعه «ابرهوش» (Superintelligence) نزدیک شدهاند.

ناامیدکننده

چندی پیش OpenAI بالاخره GPT-5 را منتشر کرد؛ مدلی که بسیاری امید داشتند جهش مهم بعدی در تواناییهای هوش مصنوعی باشد و حتی بررسیهای اولیه نیز برخی نقاط قوت را نشان داد. یک یوتیوبر مشهور حوزه فناوری با نام Mrwhosetheboss از GPT-5 خواست یک بازی شطرنج طراحی کند که مهرههایش شخصیتهای پوکمون باشند و نتیجه به طور قابلتوجهی بهتر از زمانی بود که از مدل کدنویسی پیشروی GPT-o4-mini-high استفاده کرده بود. او همچنین دریافت که GPT-5 میتواند برای کانال یوتیوبش سناریوهای بهتری نسبت به GPT-4o بنویسد. نکتهای که او را بیش از همه هیجانزده کرد این بود که بهجای اینکه کاربر مجبور باشد خودش مدل مناسب را انتخاب کند؛ GPT-5 به طور خودکار پرامپتها را به مناسبترین مدل هدایت میکند. بااینحال، او فهمید که GPT-4o بهوضوح در تولید thumbnail یوتیوب یا طراحی دعوتنامه جشن تولد توانمندتر است و هیچ دشواریای در مجبور کردن GPT-5 به تولید اطلاعات نادرست نداشت. تنها چند ساعت بعد، کاربران شروع به ابراز ناامیدی از این مدل جدید در انجمن r/ChatGPT ردیت کردند و حتی در یک جلسه پرسشوپاسخ (Ask Me Anything – A.M.A) آلتمن و دیگر مهندسان OpenAI مجبور شدند با حالت دفاعی به شکایات پاسخ دهند. گری مارکوس نیز این نسخه را اینطور توصیف کرد: «دیرهنگام، بیش از حد تبلیغشده و ناامیدکننده.» (overdue, overhyped and underwhelming)

پس از انتشار GPT-5، پذیرش پیشبینیهای اغراقآمیز درباره هوش مصنوعی دشوارتر شده و دیدگاههای منتقدانی مانند مارکوس میانهرو و متعادلتر به نظر میرسند. استدلال این دیدگاهها است که هرچند این فناوری مهم است؛ اما قرار نیست از پایه و اساس زندگی ما را دگرگون کند. این دیدگاهها ما را به درنظرگرفتن چشماندازی دیگر از آینده نزدیک دعوت میکنند؛ چشماندازی که در آن هوش مصنوعی شاید خیلی بهتر از وضعیت کنونی نشود. البته OpenAI نمیخواست نزدیک به دو سال و نیم صبر کند تا GPT-5 را منتشر کند. بر اساس گزارش The Information، در بهار ۲۰۲۴، آلتمن به کارکنان گفته بود که مدل بزرگ بعدیشان با اسم رمز Orion، به شکل چشمگیری از GPT-4 بهتر خواهد بود. اما در پاییز مشخص شد که نتایج ناامیدکنندهاند. The Information در نوامبر ۲۰۲۴ گزارش داد درحالیکه عملکرد Orion از مدلهای قبلی بهتر بود؛ اما میزان افزایش کیفیت بسیار کمتر از جهش میان GPT-3 و GPT-4 بود.

راهحل

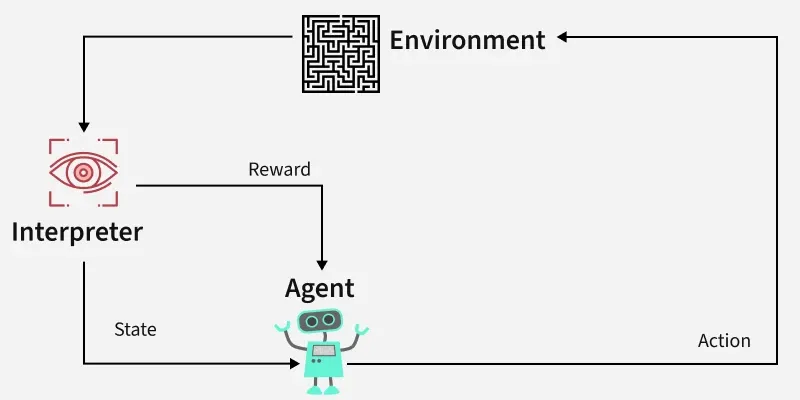

شکست Orion ترس فزایندهای را در صنعت هوش مصنوعی به راه انداخت؛ اینکه «قانون مقیاسپذیری» در واقع اصلاً قانون نبوده است. اگر ساخت مدلهای بزرگتر تنها کاهش بازدهی را به همراه داشته باشد، شرکتهای فناوری ناچار خواهند بود برای تقویت محصولات هوش مصنوعی خود به راهبردی تازه متوسل شوند. آنها بهسرعت روی چیزی تمرکز کردند که میتوان آن را «بهبودهای پساآموزشی» (Post-training Improvements) نامید. مدلهای زبانی بزرگ پیش از هر چیز از مرحلهای به نام «پیشآموزش» عبور میکنند که در آن عملاً تمام اینترنت را میبلعند تا باهوش شوند. اما همچنان میتوان بعدها این مدلها را پالایش کرد تا بهتر بتوانند از دانستهها و تواناییهایشان استفاده کنند. یکی از این تکنیکها استفاده از ابزاری در یادگیری ماشین به نام «یادگیری تقویتی» (Reinforcement Learning) است که به یک مدل پیشآموزشدیده یاد میدهد در وظایف خاص، رفتاری بهتر داشته باشد. روش دیگری نیز به مدل اجازه میدهد زمان محاسباتی بیشتری را برای تولید پاسخ به پرسشهای دشوار صرف کند.

یک استعاره مفید در اینجا خودرو است. میتوان گفت پیشآموزش، خودرو را تولید میکند و پساآموزش آن را ارتقا میدهد. در مقاله قوانین مقیاسپذیری، کاپلان و همکارانش پیشبینی کرده بودند که هرچه فرایند پیشآموزش گسترش یابد، قدرت خودروهایی که ساخته میشوند نیز افزایش پیدا میکند. در مقام تشبیه؛ اگر GPT-3 یک خودروی سدان بود GPT-4 یک خودروی اسپرت بود. اما وقتی این روند متوقف شد، صنعت توجه خود را به بهتر کردن همان خودروهای موجود معطوف کرد و تکنیکهای پساآموزش مهندسان را به مکانیک تبدیل کردند.

رهبران فناوری بهسرعت ابراز امیدواری کردند که رویکرد پساآموزش به همان سرعتی محصولاتشان را بهبود میدهد که مقیاسپذیری سنتی بهبود داده بود. «ساتیا نادلا» (Satya Nadella)، مدیرعامل مایکروسافت، در کنفرانسی در پاییز گذشته گفت: «ما شاهد ظهور یک قانون مقیاسپذیری جدید هستیم.» یک سرمایهگذار خطرپذیر به نام «آنجنی میدها» (Anjney Midha) نیز از «عصر دوم قوانین مقیاسپذیری» سخن گفت. در دسامبر ۲۰۲۴، OpenAI مدل o1 را عرضه کرد که با بهرهگیری از تکنیکهای پساآموزش در استدلال مرحلهبهمرحله و کدنویسی بهتر عمل میکرد. پس از آن نیز مدلهای o3-mini، o3-mini-high، o4-mini، o4-mini-high و o3-pro را معرفی کرد که هر کدام با ترکیبی اختصاصی از روشهای پساآموزش ارتقا یافته بودند. سایر شرکتهای هوش مصنوعی هم به همین سمت رفتند. Anthropic نسخه Claude 3.7 Sonnet را با بهبودهای پساآموزشی ارائه داد و سپس آنها را در مرکز خانواده مدلهای Claude 4 قرار داد. اما xAI همچنان به استراتژی مقیاسپذیری پایبند ماند تا اینکه در زمستان مدل Grok 3 را معرفی کرد؛ مدلی که با قدرت پردازشی خیرهکننده ۱۰۰هزار تراشه H100 (چندین برابر توان محاسباتی مورداستفاده برای آموزش GPT-4) آموزش دیده بود. اما وقتی Grok 3 نتوانست به شکل چشمگیری از رقبا پیشی بگیرد، xAI برای توسعه Grok 4 به سراغ الگوریتمهای پساآموزش رفت. GPT-5 هم دقیقاً در همین مسیر قرار میگیرد؛ بیشتر از آنکه یک مدل کاملاً جدید باشد، تلاشی است برای پالایش محصولات پساآموزشیافته اخیر و ادغام آنها در یک بسته واحد.

معیارها

اما آیا این رویکرد پساآموزشی ما را دوباره در مسیر چیزی شبیه به AGI قرار داده است؟ اطلاعیه OpenAI برای GPT-5 شامل چندین نمودار و گراف و معیارهایی مانند ویرایش کد چندزبانه Aider Polyglot و استدلال فضایی چندوجهی ERQA است تا نشان دهد این مدل چقدر بهتر از نسخههای پیشین عمل میکند. GPT-5 در آزمونهای مربوط به برنامهنویسی نمره بالاتری گرفته و بررسیهای اولیه نیز تأیید کردند که کد بهتری تولید میکند و به شکل طبیعیتر و روانتری نیز متن مینویسند. اما این تغییرات نسبتاً محدود به نظر میرسند و بیشتر شبیه به بهبودهای هدفمند یک بهروزرسانی نرمافزاری هستند تا گسترش تواناییها پیشین و از طرفی برای درک جهش GPT-4 نسبت به مدلهای پیشین نیازی به نمودار نبود.

برخی معیارها هم شاید آنچه ادعا میکنند را نسنجند. از زمان انتشار o1، شرکتهای هوش مصنوعی بیشتر بر روی پیشرفت در «استدلال مرحلهبهمرحله» مانور دادهاند؛ اما در ژوئن، پژوهشگران اپل مقالهای با عنوان «توهم تفکر» (The Illusion of Thinking) منتشر کردند که نشان میداد «مدلهای استدلال بزرگ» در شرایطی که پیچیدگی معماها کمی فراتر از حالت معمول باشد، عملکردشان تقریباً به صفر سقوط میکند. پژوهشگران عنوان کردند که مدلهای استدلالی از جمله o3-mini، حالت تفکر Claude 3.7 Sonnet و DeepSeek-R1 هنوز نتوانستهاند قابلیتهای حل مسئله تعمیمپذیر را توسعه دهند. اخیراً پژوهشگران دانشگاه ایالتی آریزونا نیز به نتیجهای صریحتر رسیدند: «آنچه شرکتهای هوش مصنوعی استدلال مینامند، سرابی محو است که وقتی فراتر از دادههای آموزشی برود، محو میشود.» عبور از این معیارها تفاوت زیادی با استدلال در مسائل روزمره شغلی ما دارد. گری مارکوس به من گفت: «من نمیشنوم که شرکتها بگویند مدلهای ۲۰۲۵ برایشان بسیار مفیدتر از مدلهای ۲۰۲۴ هستند، حتی اگر در معیارها بهتر عمل کنند.» به نظر میرسد بهبودهای پساآموزشی بهاندازه مقیاسپذیری قبلی قدرتبخش نبودهاند. شما میتوانید کمری خود را ارتقا دهید، اما هیچ مقدار ارتقا آن را به فراری تبدیل نخواهد کرد.

چشمانداز

اما پیشبینیها راجع به تأثیر هوش مصنوعی مولد بر اقتصاد در سالهای آینده چگونه خواهد بود؟ «اد زیترون» (Ed Zitron)، تحلیلگر فناوری و مجری پادکست Better Offline اعتقاد دارد «هوش مصنوعی مولد یک بازار پنجاه میلیارددلاری است، نه یک بازار تریلیون دلاری». مارکوس هم با این نظر موافق است. «امیلی بندر» (Emily Bender) استاد زبانشناس که یکی از نویسندگان یک نقد مشهور بر مدلهای اولیه زبانی بود عنوان میکند: «تأثیرات این فناوری به این بستگی دارد که چه تعداد از مدیران فریب تبلیغات فروشندگان این تکنولوژی را بخورند و محیط کارشان را حول آن بازطراحی کنند. هرچه این اتفاق بیشتر رخ دهد، وضعیت همه بدتر خواهد شد.» البته چنین دیدگاههایی اغلب غیرواقعبینانه تصویر شدهاند.

اگر این دیدگاههای میانهرو درباره هوش مصنوعی درست باشد، در چند سال آینده ابزارهای هوش مصنوعی پیشرفتهایی تدریجی و پیوسته خواهند داشت. بسیاری از مردم به طور منظم اما محدود، از هوش مصنوعی استفاده خواهند کرد. برخی حوزهها مثل برنامهنویسی و پژوهشهای دانشگاهی تغییرات چشمگیری را تجربه خواهند کرد. اقلیتی از مشاغل، مانند صداپیشگی یا نویسندگی تبلیغاتی در شبکههای اجتماعی، ممکن است عملاً از بین بروند. اما احتمالاً هوش مصنوعی بازار کار را به شکل گسترده متلاشی نخواهد کرد و ایدههای اغراقآمیزی مانند «ابرهوش» ممکن است بیاعتبار جلوه کنند.

اما افتادن در دام تبلیغات هوش مصنوعی، خطرات خودش را نیز به همراه دارد. زیترون اخیراً در مقالهای یادآوری کرد که حدود ۳۵ درصد ارزش بازار سهام آمریکا در اختیار ۷ غول بزرگ فناوری معروف به Magnificent Seven است و به گفته او، این شرکتها در هجده ماه گذشته حدود ۵۶۰ میلیارد دلار برای سرمایهگذاری در هوش مصنوعی هزینه کردهاند، درحالیکه درآمد آنها از این حوزه تنها حدود ۳۵ میلیارد دلار بوده است.

بااینحال حتی کسانی که میتوان آنها را «میانهرو» دانست نیز معتقد نیستند که عموم مردم باید بیخیال شوند. مارکوس باور دارد که اینهمه تمرکز بر هوش مصنوعی مولد اشتباه بود؛ اما درعینحال فکر میکند با روشهای تازه، دستیابی به AGI میتواند حتی اوایل دهه ۲۰۳۰ امکانپذیر باشد. حتی اگر مدلهای زبانی هیچگاه شغلهای ما را خودکار نکنند، این علاقه و سرمایهگذاری دوباره در هوش مصنوعی میتواند به راهحلهای پیچیدهتری منجر شود که شاید چنین کاری کنند. در این فاصله باید اقداماتی مانند طراحی مقررات مؤثر برای هوش مصنوعی و توسعه حوزه نوپای اخلاق دیجیتال خود را در برابر اختلالاتی که ممکن است همچنان در پیش باشند آماده کنیم.

ضمیمههای مقاله قوانین مقیاسپذیری در سال ۲۰۲۰ بخشی با عنوان «هشدارها» (Caveats) داشتند که در نسخههای بعدی اغلب نادیده گرفته شد. به گفته نویسندگان: «در حال حاضر ما هیچ درک نظری محکمی از قوانین مقیاسپذیری پیشنهادی نداریم و روابط میان مقیاس با اندازه مدل و توان محاسباتی مبهماند.» در عمل، قوانین مقیاسپذیری کار میکردند؛ تا زمانی که دیگر کار نکردند. کل پروژه آموزش کامپیوترها برای اندیشیدن همچنان پر از رمز و راز است و میبایست با غرور کمتر و احتیاط بیشتری پیش برویم.