توهمِ فهمیدن باید چقدر قانعکننده باشد تا دست از نامیدن آن بهعنوان توهم برداریم؟

آیا هوش مصنوعی واقعاً میفهمد؟

به نقل از The New Yorker داریو امودی، مدیرعامل شرکت هوش مصنوعی Anthropic، پیشبینی کرده که یک هوش مصنوعی «باهوشتر از برندگان نوبل» در حوزههایی مانند زیستشناسی، ریاضیات، مهندسی و نویسندگی ممکن است تا سال ۲۰۲۷ در دسترس قرار گیرد. او میلیونها نسخه از یک مدل را تصور میکند که همگی مشغول به کار و هرکدام در حال انجام تحقیقات خودشان هستند و آن را «یک کشورِ نابغهها در یک مرکز داده» توصیف میکند. در ژوئن سال جاری میلادی، سم آلتمن اعلام کرد که صنعت هوش مصنوعی در آستانه ساخت «ابرهوش دیجیتال» (digital superintelligence) است و تأکید کرد:

«دهه ۲۰۳۰ احتمالاً به طور شگفتانگیزی متفاوت از هر زمان دیگری خواهد بود.»

در همین حال، ابزارهای هوش مصنوعی که مردم امروز در زندگی روزمره با آنها سروکار دارند یادآور «Clippy» هستند، همان دستیار سابق مایکروسافت آفیس که درواقع بیشتر مزاحم بود تا کمک. ابزار هوش مصنوعی Zoom به شما پیشنهاد میکند از او بپرسید «چند یخشکن برای شروع جلسه بگو؟» یا از او بخواهید «یک پیام کوتاه برای ابراز قدردانی بنویسد». Siri در تنظیم یادآورها خوب است؛ ولی کار خاص دیگری انجام نمیدهد.

آیا واقعاً چیزی برای دیدن وجود دارد؟

رونماییهای شتابزده و ناهماهنگ از هوش مصنوعی، فضا را بهگونهای مهگرفته و غیرشفاف کرده که شاید بتوان نتیجه گرفت که واقعاً چیزی برای دیدن وجود ندارد و همه آن فقط هیاهو یا همان بهاصطلاح رایج، «hype» بوده. البته، واقعاً hype زیادی هم وجود دارد. جدول زمانی امودی بیشتر شبیه یک سناریو علمی-تخیلی است و مدلهای هوش مصنوعی آنقدر هم سریع پیشرفت نمیکنند. اما اینکه فرض کنیم مدلهای زبانی بزرگ فقط کلمات را جابهجایی میکنند هم نوع دیگری از خوشخیالی است. در این تصور که هوش مصنوعی ارتباطی با هوش واقعی یا فهم ندارد، نوعی آرامش پنهان شده و حتی ضعفهایش را جشن میگیریم؛ اما رفتهرفته وقتی از آن بهعنوان یک دستیار کاری استفاده کردیم، ترسیدیم که اگر این کار را نکنیم از بقیه عقب بمانیم.

چرا کدنویسی نقطه قوت هوش مصنوعی است؟

کدنویسی کاری است که هوش مصنوعی در آن بهترین عملکرد را دارد؛ کد نسبت به نثر ساختارمندتر است و اغلب میتوان بهصورت خودکار بررسی کرد که برنامه درست کار میکند یا نه. این مدلها در چند ثانیه جزئیات پیچیده هزاران خط کد را هضم میکنند، میتوانند باگهای ظریف را تشخیص دهند و ویژگیهای جدید پیچیده را طراحی کنند.

آینده نابرابر؛ دو فرهنگ در برابر هوش مصنوعی

گفته میشود «ویلیام گیبسون» (William Gibson) نویسنده علمی-تخیلی گفته است که آینده همینجاست، فقط به طور یکنواخت توزیع نشده و این شاید توضیح دهد که چرا هوش مصنوعی دو فرهنگ متفاوت ساخته است؛ یکی بیاعتنا و دیگری شیفته. در زندگی روزمره، ممکن است عاملهای هوش مصنوعی که بتوانند بلیت سفر تعطیلات را رزرو کنند یا مالیات را ثبت کنند شکست خورده باشند، اما برنامهنویسانی بسیاری هستند که بخش زیادی از کد را با کمک هوش مصنوعی مینویسند و گاهی چندین ایجنت کدنویس را همزمان و موازی اجرا میکنند. مدلها گاهی اشتباهات آماتوری میکنند یا در چرخههای احمقانه گیر میکنند، اما وقتی یاد بگیریم که چطور از آنها به طور مؤثر استفاده کنیم، حتی میتوانیم کار یکماهه را در یک شب انجام دهیم.

تمرکز بر نقاط قوت، نه ضعفها

به نقل از یک مدیر اجرایی؛ مصاحبه شغلی باید برای کشف نقاط قوت باشد نه ضعفها. مدلهای زبانی بزرگ نیز ضعفهای زیادی دارند، آنها به این مشهورند که اشتباهاتی معقول و باورپذیر میسازند؛ حتی وقتی شما اشتباه میکنید، چاپلوسانه مطیع هستند و با معماهای ساده فریب میخورند. اما زمانی هم بود که نقاط قوت آشکار مدلهای امروزی مانند روانبودن، سیالیت، توانایی درک منظور طرف مقابل و… چیزهایی بودند که جام مقدس محسوب میشدند. وقتی این نقاط قوت را از نزدیک تجربه میکنید، این سؤال پیش میآید که توهم فهمیدن باید چقدر قانعکننده باشد تا دیگر به آن نگوییم توهم؟

آیا ChatGPT میفهمد؟

آیا ChatGPT صرفاً کلمات را بیهدف به هم میچسباند، یا واقعاً مشکل را میفهمد؟ پاسخ به این سؤال میتواند چیز مهمی درباره خود مفهوم فهمیدن به ما بیاموزد. به گفته «دوریس تسائو» (Doris Tsao)، استاد علوم اعصاب در دانشگاه کالیفرنیا: «عصبپژوهان باید با این حقیقت فروتنانه روبهرو شوند. پیشرفتهای یادگیری ماشین بیش از هر چیز دیگری که علوم اعصاب در صد سال گذشته کشف کرده، درباره ماهیت هوش به ما آموخته است.» تسائو بیشتر بهخاطر رمزگشایی نحوه درک چهرهها توسط میمونهای ماکاک شناخته میشود. تیم او یاد گرفت پیشبینی کند کدام نورونها هنگام دیدن یک چهره خاص فعال میشوند و حتی شگفتانگیزتر اینکه با داشتن الگوی فعالشدن نورونها، تیم تسائو میتوانست چهره را بازسازی کند. کار آنها بر پایه پژوهشهایی درباره نحوه بازنمایی چهرهها در مدلهای هوش مصنوعی بنا شده بود. این روزها، سؤال موردعلاقهاش از دیگران این است که: «عمیقترین بینشی که از ChatGPT گرفتهاید چیست؟» او گفت: «پاسخ خودم این است که فکر میکنم ChatGPT فرایند فکرکردن را بهشدت از رازآلودگی و ابهام خارج میکند.»

از شبیهسازی فکر تا تولد یادگیری عمیق

سادهترین توضیح درباره اینکه چطور به اینجا رسیدیم چیزی شبیه این است که در دهه ۱۹۸۰، گروه کوچکی از روانشناسان شناختی و دانشمندان کامپیوتر تلاش کردند فکرکردن را در یک ماشین شبیهسازی کنند. از معروفترین آنها «دیوید روملهارت» (David Rumelhart)، «جفری هینتون» (Geoffrey Hinton) و «جیمز مککللند» (James McClelland) بودند که بعدها گروهی پژوهشی در دانشگاه سندیگو تشکیل دادند. آنها مغز را شبکهای عظیم میدیدند که در آن نورونها در الگوهایی شلیک میکنند و باعث شلیک مجموعههای دیگر نورونی میشوند و همینطور ادامه مییابد. این رقص الگوها همان فکرکردن است و مغز با تغییر قدرت اتصالات بین نورونها یاد میگیرد. نکته مهم اینکه این دانشمندان این فرایند را با ساخت یک شبکه عصبی مصنوعی و استفاده از الگوریتمی ساده به نام «گرادیان نزولی» (gradient descent) تقلید کردند تا دقت پیشبینیهای شبکه را افزایش دهند. میتوان این الگوریتم را با کوهنوردی مقایسه کرد که از قله به دره میآید؛ راهبرد ساده برای پیداکردن مسیر این است که مطمئن شوید هر قدم رو به پایین است. استفاده از چنین الگوریتمهایی در شبکههای بزرگ به «یادگیری عمیق» معروف شد.

وقتی شبکهها بزرگ شدند و همهچیز را تغییر دادند

دیگران در حوزه هوش مصنوعی تردید داشتند که شبکههای عصبی برای حل مسائل واقعی کافی باشند؛ اما هرچه این شبکهها بزرگتر شدند، شروع کردند به حل مشکلاتی که قبلاً غیرقابلحل بودند. دانشجویان پایاننامههای کاملی درباره راههای تشخیص ارقام دستنویس یا تشخیص چهره در تصاویر مینوشتند؛ سپس یک الگوریتم یادگیری عمیق دادههای بنیادی را هضم میکرد، ظرافتهای مسئله را کشف میکرد و آن پروژهها را منسوخ نشان میداد. یادگیری عمیق بهسرعت قلههایی مثل تشخیص گفتار، ترجمه، متنگذاری تصاویر، بازیهای تختهای و حتی پیشبینی چگونگی تا شدن پروتئینها را فتح کرد.

پیشبینی توکن بعدی؛ راز سادهای با پیامدهای پیچیده

مدلهای پیشروی امروزی با استفاده از بخش بزرگی از اینترنت و با سازوکاری به نام «پیشبینی توکنِ بعدی» (next-token prediction) آموزش میبینند. یک مدل با حدسزدن درباره اینکه جمله بعدی چه چیزی خواهد بود و سپس مقایسه آن با آنچه واقعاً ظاهر میشود، آموزش میبیند. حدسهای اشتباه باعث تغییر در قدرت اتصال بین نورونها میشود و این همان گرادیان نزولی است. در نهایت، مدل آنقدر در پیشبینی متن خوب میشود که به نظر میرسد چیزهایی معناداری میداند تولید میکند. پس این خود موضوع قابلتوجهی است. گروهی که به دنبال یافتن راز کارکرد مغز بودند، وقتی مدلشان بهاندازهای شبیه مغز شد؛ شروع کرد به انجام کارهایی که گمان میرفت نیازمند هوشی شبیه مغز باشد. آیا ممکن است آنها واقعاً چیزی که دنبالش بودند را پیدا کرده باشند؟

مقاومت فکری در برابر روایت پیروزمندانه

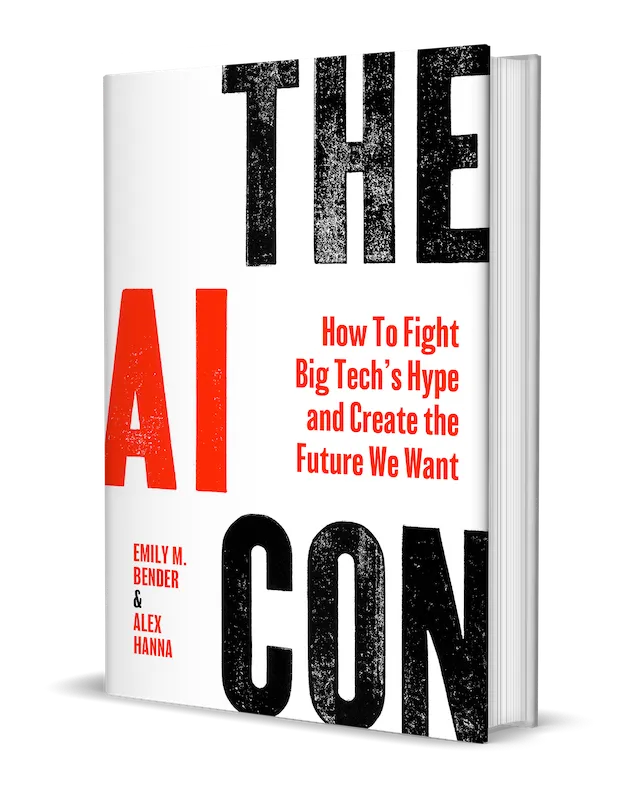

در برابر چنین روایت ساده و پیروزمندانهای از هوش مصنوعی مقاومت قابلدرکی وجود دارد. «تد چیانگ» (Ted Chiang)، این استدلال را در مقالهای در اوایل ۲۰۲۳ با عنوان «ChatGPT Is a Blurry JPEG of the Web» مطرح کرد. منظور او کموبیش تحقیرآمیز بود. شما کل اینترنت را به یک برنامه میدهید و آن را به طور ناقص به شما بازمیگرداند، مانند کپیِ کپیِ یک عکس؛ اما با مهارتی کافی که شما را فریب دهد و فکر کنید برنامه هوشمند است. امسال، استدلال مشابهی در کتابی با عنوان «The AI Con» نوشته «امیلی ام. بندر» (Emily M. Bender) زبانشناس و «آلکس هانا» (Alex Hanna)، جامعهشناس، مطرح شد. بندر بیشتر بهخاطر توصیف مدلهای زبانی بزرگ بهعنوان «طوطیهای تصادفی» (stochastic parrots) شناخته میشود. «تایِر آستین هارپر» (Tyler Austin Harper) نویسنده نیز در یک نقد کتاب در The Atlantic عنوان کرد:

«مدلهای زبانی بزرگ نه درک میکنند، نه میتوانند درک کنند و نه هرگز چیزی را درک خواهند کرد».

هارپر این استدلالهای فنی را با استدلالهای اخلاقی ترکیب کرد و نوشت: «مدلها نه با فکرکردن، بلکه با حدسهای آماری درباره اینکه کدام واژه احتمالاً پس از واژه دیگر میآید، متن را تولید میکنند.». هوش مصنوعی قدرتمندان را ثروتمندتر میکند، آنقدر انرژی مصرف میکند که تغییرات اقلیمی را تسریع کند و کارگران را به حاشیه میراند. او نتیجه گرفت که «پایه صنعت هوش مصنوعی یک کلاهبرداری است.»

اخلاق در برابر فناوری؛ کدام نقد قویتر است؟

اما شاید استدلال اخلاقی علیه هوش مصنوعی در نهایت قویتر از استدلال فنی باشد. «ساموئل جِی. گرشمن» (Samuel J. Gershman)، دانشمند علوم شناختی در هاروارد که بههیچوجه نسبت به صنعت هوش مصنوعی هیجانزده نیست میگوید: «بحث طوطی تصادفی یک جایی باید تمام شود. فقط سرسختترین شکاکان میتوانند انکار کنند که این سیستمها دارند کارهایی انجام میدهند که خیلی از ما فکر نمیکردیم قابلتحقق باشند.» «جاناتان کوهن» (Jonathan Cohen)، عصبپژوه شناختی در پرینستون نیز بر محدودیتهای هوش مصنوعی تأکید کرد، اما استدلال کرد که مدلهای زبانی بزرگ در برخی موارد به نظر میرسد بازتاب یکی از بزرگترین و مهمترین بخشهای مغز انسان باشند. کوهن گفت: «در تقریبی اولیه، نئوکورتکس شما همان مکانیزم یادگیری عمیق شماست.» انسانها نئوکورتکس بسیار بزرگتری نسبت به سایر حیوانات دارند (نسبت بهاندازه بدن) و گونههایی که بزرگترین نئوکورتکس را دارند؛ مانند فیلها، دلفینها، گوریلها، شامپانزهها و سگها از باهوشترین موجودات هستند.

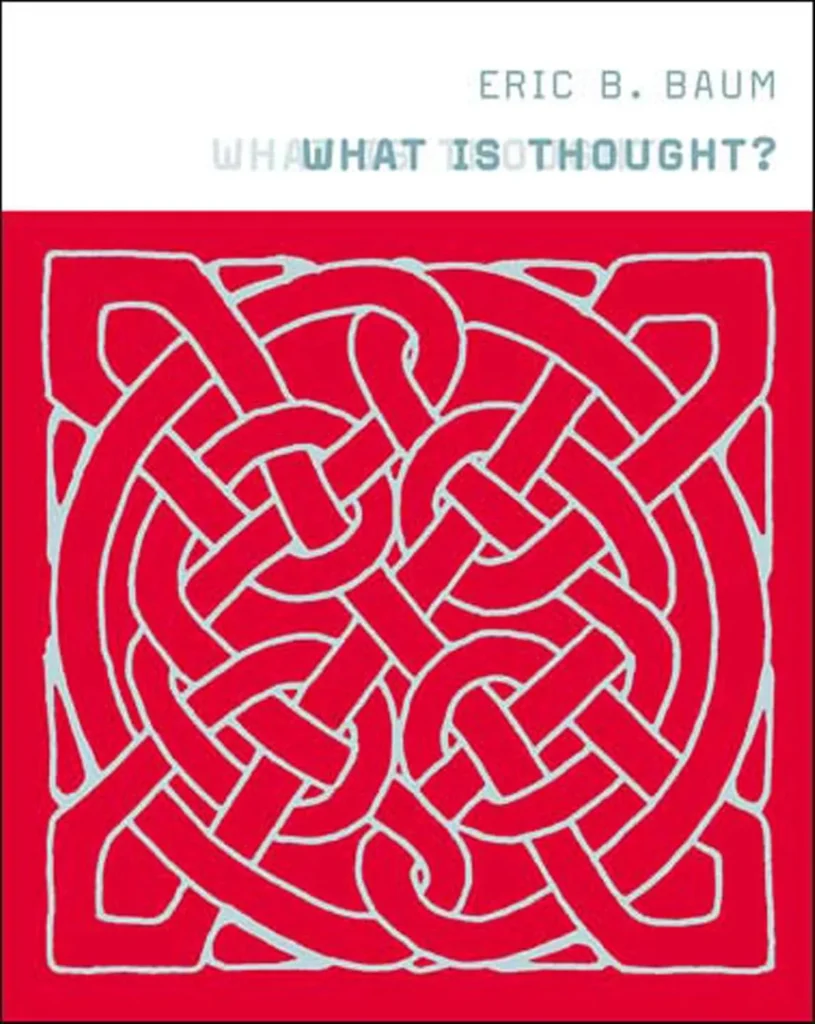

فشردهسازی بهمثابه فهمیدن؛ ایده اریک بام

در سال ۲۰۰۳، پژوهشگر یادگیری ماشین، «اریک بی. بام» (Eric B. Baum)، کتابی به نام «What Is Thought?» منتشر کرد. خلاصه استدلال بام این است که فهمیدن همان فشردهسازی است و فشردهسازی همان فهمیدن است. در علم آمار، وقتی میخواهید نقاط یک نمودار را معنا کنید، میتوانید از تکنیکی به نام رگرسیون خطی برای کشیدن «خط برازش» (line of best fit) استفاده کنید. اگر در دادهها یک الگوی زیربنایی وجود داشته باشد؛ خط برازش آن را به طور کارآمد بیان میکند و پیشبینی میکند که نقاط جدید کجا قرار میگیرند. نئوکورتکس را میتوان؛ مانند دستگاهی دانست که دریایی از تجربههای خام (صداها، تصاویر و دیگر حسها) را به «خطوط برازش» تبدیل میکند تا بتواند پیشبینی کند. نوزادی که جهان را کشف میکند، تلاش میکند حدس بزند اسباببازی چه مزهای خواهد داشت یا غذا وقتی روی زمین بیفتد چه میشود. وقتی پیشبینی اشتباه است، اتصالات میان نورونها تنظیم میشود. در طول زمان، این اتصالات شروع به گرفتن الگوهای منظم در دادهها میکنند و یک مدل فشردهشده از جهان میسازند.

شبکههای عصبی؛ نسخه مصنوعی همان الگوی زیستی

شبکههای عصبی مصنوعی تجربه را درست مثل شبکههای عصبی واقعی فشرده میکنند. یکی از بهترین مدلهای متنباز یعنی DeepSeek، قادر است رمان بنویسد، تشخیصهای پزشکی پیشنهاد دهد و در دهها زبان مثل یک بومی صحبت کند. این مدل با پیشبینی توکن بعدی روی چندین ترابایت داده آموزش دیده است؛ اما وقتی مدل را دانلود میکنید، حجم آن ۶۰۰ برابر کمتر از آن مقدار است. یک تقطیر از اینترنت، فشردهشده تا روی لپتاپ شما جا شود. «تد چیانگ» درست میگفت که نسخه اولیه ChatGPT یک JPEG مات از وب است؛ اما از نظر نویسنده The New Yorker، همین دلیل اصلی روزبهروز هوشمندتر شدن این مدلهاست. چیانگ در مقالهاش نوشت که اگر بخواهید یک فایل متنی پر از میلیونها مثالِ محاسباتی را فشرده کنید؛ فایل zip نمیسازید یک برنامه ماشینحساب مینویسید. چیانگ نوشت: «بیشترین میزان فشردهسازی با فهمیدن متن به دست میآید.» شاید مدلهای زبانی بزرگ دارند کمکم همین کار را میکنند.

چرا «فهمیدن» در هوش مصنوعی برای ما عجیب است؟

به نظر میرسد تصور اینکه یک برنامه کامپیوتری واقعاً بفهمد یا واقعاً فکر کند، غیرطبیعی یا حتی تنفرآور باشد. ما معمولاً فکرکردن را چیزی آگاهانه تصور میکنیم؛ مثل مونولوگ درونی یا جریان خاطرات در رؤیاپردازی یا ممکن است منظورمان مثل حل گامبهگام یک مسئله، استدلال باشد. در بحثهای مربوط به هوش مصنوعی، ما اغلب این گونههای مختلف «تفکر» را با هم مخلوط میکنیم و این کار قضاوتهایمان را سطحی میکند. یک استدلال میگوید ChatGPT آشکارا فکر نمیکند، چون آشکارا رؤیاپردازی ندارد و استدلال دیگر میگوید ChatGPT قطعاً فکر میکند، چون میتواند معماهای منطقی را بهتر از انسان حل کند.

اما چیز ظریفتری در جریان است. ChatGPT زندگی درونی ندارد؛ ولی بااینحال به نظر میرسد میفهمد درباره چه صحبت میکند. فهمیدن؛ یعنی درک اینکه چه چیز در جریان است و میگذرد، نوعی تفکر کمتر ارزشگذاریشده است؛ چون عمدتاً ناخودآگاه است.

هافستدر و ایده «شناخت یعنی تشخیص»

«داگلاس هافستدر» (Douglas Hofstadter)، استاد علوم شناختی و ادبیات تطبیقی دانشگاه ایندیانا اعتقاد دارد که «شناخت؛ یعنی تشخیص» (cognition is recognition). هافستدر با کتاب مشهورش «Gödel, Escher, Bach: An Eternal Golden Braid» معروف شد و در سال ۱۹۸۰ برنده پولیتزر شد. نظریه او که حاصل دههها پژوهش است؛ این است که «دیدن بهعنوانِ» (seeing as) جوهره تفکر است. شما یک لکه رنگ را بهعنوان یک ماشین میبینید و دیگری را بهعنوان یک جاکلیدی؛ شما حرف «A» را تشخیص میدهید، فرقی ندارد با چه فونتی یا با چهقدر بدخطی نوشته شده باشد. او استدلال کرد که همین فرایند در ادراکات انتزاعیتر نیز به کار میرود. وقتی یک استاد بزرگ شطرنج صفحه را بررسی میکند، سالها تجربه در یک شیوه دیدن کانالیزه شده است. شما یک گرداب در رودخانه را بهعنوان نشانهای از خطرناکبودن ردشدن از آن تفسیر میکنید. از نظر هافستدر، این خلاصه هوش است.

بازخوانی نظریه کانروا؛ حافظه در فضاهای با ابعاد بالا

هافستدر یکی از اولین بدبینها نسبت به هوش مصنوعی بود و نوشته بود که بیشتر پژوهشهای هوش مصنوعی ارتباط کمی با تفکر واقعی دارند. البته استثناهایی هم وجود داشت. او گروه دانشگاه سندیگو را جالب میدانست و کار یک دانشمند کمترشناختهشده فنلاندی-آمریکایی به نام «پنتی کانِروا» (Pentti Kanerva) را تحسین میکرد که متوجه ویژگیهای غیرمعمول در ریاضیات فضاهای با ابعاد بالا شده بود. در چنین فضاهایی، هر دو نقطه تصادفی ممکن است بسیار دور از هم باشند؛ اما برخلاف انتظار هر نقطه، ابری بزرگ از همسایهها را پیرامون خود دارد. بنابراین اگر «بهاندازه کافی نزدیک» شوید، بهراحتی میتوانید آن را بیابید. این امر کانروا را یاد نحوه کار حافظه انداخت. در کتابی در ۱۹۸۸ به نام «Sparse Distributed Memory» او استدلال کرد که افکار، احساسات و خاطرات میتوانند بهصورت مختصات در فضایی با ابعاد بالا نمایش داده شوند و به نظرش؛ مغز، سختافزار ایدهآل برای ذخیره چنین چیزهایی بود. هر خاطره یک آدرس دارد که توسط نورونهایی که هنگام یادآوری آن فعال میشوند تعریف شده است. تجربههای جدید مجموعههای جدیدی از نورونها را فعال میکنند که آدرسهای جدیدی را نشان میدهند. دو آدرس ممکن است در بسیاری چیزها متفاوت باشند؛ اما در برخی دیگر شبیه به هم باشند؛ یک ادراک یا خاطره، خاطرات دیگری را در همان نزدیکی فعال میکند. بوی علف خاطره اردوگاه تابستانی را زنده میکند؛ سه نت اول سمفونی پنجم بتهوون، نت چهارم را فرامیخواند؛ یک موقعیت شطرنج که هرگز ندیدهاید، شما را یاد بازیهای قدیمی میاندازد. البته نه همه آنها، بلکه فقط آنهایی که در «همسایگی درست» هستند.

هافستدر فهمید که کانروا در واقع چیزی شبیه یک ماشین «دیدن بهعنوانِ» را توصیف میکند. او در مقدمه کتاب کانروا نوشت: «مدل حافظه پنتی کانروا برای من یک مکاشفه بود. این اولین پژوهشی بود که باعث شد احساس کنم میتوانم دوردستترین هدف، یعنی درک نحوه کار مغز بهعنوان یک کل را ببینم.» همه انواع تفکر وابسته به این است که چیز مرتبط در زمان مناسب به ذهن خطور کند. این همان چیزی است که ما را قادر میکند بفهمیم در چه موقعیتی هستیم.

کتاب کانروا کمکم از دیدهها کنار رفت و خود هافستدر نیز کمتر مطرح شد؛ جز زمانی که گاهی سری بیرون میآورد تا یک سیستم جدید هوش مصنوعی را نقد کند. در سال ۲۰۱۸، او درباره مترجم گوگل و فناوریهای مشابه نوشت: «در این رویکرد هنوز چیزی عمیقاً کمبود دارد، چیزی که با یک کلمه منتقل میشود؛ یعنی فهم.»

ظهور GPT-4 و تغییر نگاه بدبینها

اما GPT-4 که در ۲۰۲۳ منتشر شد، لحظه دگرگونی او بود. او اخیراً گفته که: «از بعضی کارهایی که این سیستمها میکنند، شوکه شدهام که ده سال پیش غیرقابلتصور بود.» سرسختترین بدبین دیگر نتوانست بدبین بماند. اینجا برنامهای بود که میتوانست مثل یک متخصص ترجمه کند، تشبیه بسازد، فیالبداهه بنویسد و تعمیم دهد. چه کسی بود که بگوید نمیفهمد؟ او گفت: «آنها کارهایی انجام میدهند که خیلی شبیه فکرکردن است. میشود گفت آنها دارند فکر میکنند، اما فقط به شکلی کمی بیگانه و ناآشنا.»

مدلهای زبانی بهعنوان «ماشین دیدن بهعنوانِ»

به نظر میرسد مدلهای زبانی بزرگ در هستهشان یک «ماشین دیدن بهعنوان» دارند. آنها هر کلمه را با مجموعهای از اعداد نشان میدهند که مختصات یا بردار (وکتور – Vector) آن را در یک فضای با ابعاد بالا تعیین میکند. در GPT-4، بردار یک کلمه هزاران بُعد دارد که سایههای شباهت و تفاوت آن با تمام کلمات دیگر را توصیف میکند. هنگام آموزش، مدل زبانی بزرگ هر بار که در پیشبینی اشتباه میکند، مختصات کلمات را تغییر میدهد؛ کلماتی که در متنها کنار هم دیده میشوند، در فضا به یکدیگر نزدیک میشوند. این فرایند یک نمایش فوقالعاده متراکم از کاربردها و معانی میسازد که در آن قیاس فقط مسئلهای هندسی است. در یک مثال کلاسیک، اگر بردار «پاریس» را بگیرید، «فرانسه» را از آن کم کنید و «ایتالیا» را اضافه کنید، بردار نزدیک بعدی «رم» خواهد بود. مدلها میتوانند یک تصویر را «برداری» (Vectorize) کنند؛ یعنی چیزی که در آن هست، حالوهوای تصویر، حتی حالت چهره افراد را با جزئیاتی کافی برای اینکه آن را در یک سبک خاص دوباره ترسیم کنند یا پاراگرافی دربارهاش بنویسند، رمزگذاری کنند. وقتی بهعنوانمثال عکسی از یک دستگاه خراب را به ChatGPT میدهید و از او راهنمایی میخواهید تا تعمیرش کنید؛ مدل فقط کلمات را کنار هم نمیچید. مدل عکس دستگاه خراب همراه با متن درخواست را در قالب یک بردار فشرده میکند بهطوریکه که مهمترین ویژگیهای آن را در خود داشته باشد. آن وکتور بهعنوان آدرسی برای فراخوانی کلمات و مفاهیم نزدیک عملکرد. آن ایدهها نیز به نوبه خود ایدههای دیگری را فراخواندند، وقتی مدل «درکی» از موقعیت را ساخت؛ پاسخ خود را با آن ایدهها «در ذهن» ترکیب میکند.

فعالیت درونی LLMها؛ از ویژگیها تا مدارها

«ترنتون بریکِن» (Trenton Bricken) یکی از پژوهشگران Anthropic همراه با همکارانش داخل مدل Claude را بررسی کرده است. (پژوهش آنها هنوز داوری نشده یا در مجله علمی منتشر نشده است.) تیم او مجموعههایی از نورونهای مصنوعی، یا «ویژگیها» (feature) را شناسایی کردهاند که وقتی Claude در آستانه گفتن چیزی است فعال میشوند. ویژگیها شبیه پیچهای تنظیم حجم برای مفاهیم هستند؛ اگر آنها را زیاد کنید، مدل تقریباً فقط درباره همان چیز حرف میزند. (در یک آزمایش کنترل فکر، ویژگی نماینده پل گلدنگیت را زیاد کردند؛ وقتی کاربری از Claude دستور تهیه کیک شکلاتی خواست، مواد پیشنهادی شامل «یکچهارم پیمانه مه خشک» و «۱ پیمانه آب گرم دریا» بود.) بریکن در یک مصاحبه به معماری Transformer گوگل اشاره کرد که دستورالعملی است برای ساخت شبکههای عصبی و اساس مدلهای برتر هوش مصنوعی محسوب میشود. او استدلال کرد که ریاضیات موجود در قلب معماری ترنسفورمر، به طور چشمگیری شبیه مدلی است که دههها قبل پنتی کانروا، در کتاب «Sparse Distributed Memory» پیشنهاد کرده بود.

آیا تطابق AI و مغز تصادفی است؟

آیا باید از تطابق میان هوش مصنوعی و مغز خودمان شگفتزده شویم؟ بههرحال، LLMها شبکههای عصبی مصنوعیای هستند که روانشناسان و عصبشناسان در توسعه آنها نقش داشتهاند. آنچه شگفتانگیزتر است این است که وقتی مدلها کاری تکراری مانند پیشبینی کلمات را انجام دادند، رفتارهایی بسیار شبیه به مغز را از خود نشان داند. این روزها، حوزههای علوم اعصاب و هوش مصنوعی درهمتنیده شدهاند؛ متخصصان مغز از هوش مصنوعی بهعنوان نوعی ارگانیسم مدل استفاده میکنند. «اولینا فدورنکو» (Evelina Fedorenko) عصبشناس MIT، از LLMها برای مطالعه چگونگی پردازش زبان در مغز استفاده کرده است و میگوید: «هرگز فکر نمیکردم بتوانم در طول زندگیام به این چیزها فکر کنم. هرگز فکر نمیکردم مدلهایی داشته باشیم که بهاندازه کافی خوب باشند.»

آیا LLMها واقعاً «جعبه سیاه» هستند؟

اینکه گفته میشود هوش مصنوعی یک «جعبه سیاه» (black box) است دیگر امری رایج شده؛ اما شاید برعکسش درست باشد. یک دانشمند میتواند فعالیت نورونهای مصنوعی منفرد را بررسی و حتی آنها را تغییر دهد. «کنت نورمن» (Kenneth Norman) عصبشناس در پرینستون، میگوید: «داشتن یک سیستم فعال که نظریهای از هوش انسان را پیادهسازی کند، رؤیای علوم اعصاب شناختی است.» نورمن مدلهای کامپیوتری هیپوکامپ؛ ناحیه مغز که خاطرات اپیزودیک در آن ذخیره میشوند را ساخته است، اما پیشتر این مدلها آنقدر ساده بودند که فقط میتوانست شمایل خام از آنچه ممکن بود وارد ذهن انسان شود را به آنها بدهد؛ اما به گفته نورمن: «الان میتوانی دقیقاً همان محرکهایی را که به انسان میدهی، به مدلهای حافظه بدهی.»

برادران رایت در اولین تلاشهای خود برای ساخت هواپیما، پرندگان را مطالعه کردند. آنها مشاهده کردند که پرندگان خلاف جهت باد از زمین بلند میشوند، هرچند ممکن است به طور منطقی فرض کنید که پرندهها ترجیح میدهند باد پشت سرشان باشد و اینکه آنها نوک بالهایشان را برای حفظ تعادل میپیچانند. این یافتهها طراحی گلایدرهای ابتدایی آنها را تحتتأثیر قرار داد. سپس آنها یک تونل باد تقریباً ۲ متری (۶ پا) ساختند که به آنها اجازه داد مجموعهای از بالهای ساختگی را تحت شرایط دقیق کنترلشده آزمایش کنند. دور بعدی پرواز گلایدرهای آنها بسیار موفقتر بود. عجیب آنکه تازه پس از ساخت یک ماشین پرنده واقعی بود که امکان فهم دقیق روش کار پرندگان فراهم شد.

تونل باد برای فکر کردن؛ آزمایشپذیری ذهن مصنوعی

هوش مصنوعی به دانشمندان امکان میدهد خود «تفکر» را در یک تونل باد قرار دهند. در مقالهای با عنوان «On the Biology of a Large Language Model»، پژوهشگران Anthropic مشاهده کردند که Claude چگونه به کوئریها پاسخ میدهد و مطابق با آن «مدارها» (circuits) را توصیف کردند؛ آبشارهایی از ویژگیها که در کنار هم محاسبات پیچیده انجام میدهند. (فراخوانی خاطرات درست یک گام بهسوی تفکر است؛ ترکیب و دستکاری آنها در مدارها احتمالاً گامی دیگر است.) یکی از انتقادهای دیرینه به LLMها این بوده که چون باید هر بار یک توکن از پاسخ خود را تولید کنند، قادر به برنامهریزی یا استدلال نیستند. اما وقتی از Claude میخواهید قافیه یک بیت شاعر را کامل کند، یک مدار شروع میکند به بررسی آخرین واژه خط جدید تا مطمئن شود که قافیه خواهد داشت. سپس از آخر به اول کار میکند تا کل خط را بسازد. پژوهشگران Anthropic این را دلیلی بر این دانستند که مدلهایشان واقعاً برنامهریزی انجام میدهند. اگر کمی چشمتان را تنگ کنید، شاید برای اولینبار احساس کنید که کارکردهای درونی یک ذهن در برابر دیدتان قرار گرفته است.

جفری هینتون در سال ۲۰۲۰ گفت: «یادگیری عمیق قادر خواهد بود همه چیز را انجام دهد»؛ اما همچنین دیدهایم که مدلهای بزرگتر همیشه مدلهای بهتری نیستند. منحنیهایی که عملکرد مدل را نسبت به اندازهشان نشان میدهند، کمکم در حال صافشدن هستند. یافتن داده باکیفیتی که مدلها پیشتر نداشته باشند دشوارتر شده و قدرت محاسباتی روزبهروز گرانتر میشود. وقتی GPT-5 در آگوست سال جاری منتشر شد؛ فقط یک بهبود جزئی بود و چنان ناامیدکننده که حتی تهدید کرد حباب سرمایهگذاری هوش مصنوعی را بترکاند. لحظه فعلی نیازمند نوعی میانهروی از شکگرایی است؛ شکگراییای که مدلهای امروزی هوش مصنوعی را جدی میگیرد؛ اما باور نمیکند که دیگر هیچ مسئله دشواری باقی نمانده است.

یادگیری انسانی در برابر یادگیری ماشینی

شاید مهمترین مسئله این باشد که چگونه مدلی بسازیم که بهاندازه انسانها و بهخوبی بیاموزد. تخمین زده میشود که GPT-4 در طول آموزش در معرض تریلیونها واژه قرار گرفته؛ درحالیکه کودکان فقط با چند میلیون کلمه به تسلط زبانی میرسند. دانشمندان شناختی میگویند مغز نوزاد دارای نوعی «سوگیری استقرایی» (inductive biases) است که یادگیری را تسریع میکند. (البته مغز حاصل میلیونها سال تکامل است که خودش نوعی داده آموزشی برای خودش است.) برای مثال، نوزادان انتظار دارند که جهان از اشیا ساخته شده باشد. وقتی کسی به «موز» اشاره میکند، نوزاد آن واژه را به کل شیء زردرنگی که به آن نگاه میکند ربط میدهد نه فقط به نوک آن یا پوستش. نوزادان آزمایشهای کوچکی انجام میدهند؛ آیا میتوانم این را بخورم؟ آن یکی را چقدر دور میتوانم پرت کنم؟ آنها با احساساتی مانند میل، کنجکاوی و ناامیدی برانگیخته میشوند. کودکان همیشه تلاش میکنند کاری اندکی فراتر از توان فعلی خود انجام دهند. یادگیری آنها کارآمد است؛ زیرا فیزیکی، سازگار، عمدی و پیوسته است. شاید فهم واقعی جهان نیازمند چنین مشارکتی باشد.

تجربه محدود هوش مصنوعی؛ چرا جهان را «واقعی» نمیبیند؟

تجربه یک هوش مصنوعی، در مقایسه با انسان آنقدر ناچیز و محدود است که واقعاً نمیتوان آن را «تجربه» نامید. مدلهای زبانی بزرگ بر دادههایی آموزش میبینند که از پیش بهشدت پالایش شدهاند. تسائو دراینخصوص میگوید: «فکر میکنم دلیل اینکه این مدلها کار میکنند این است که روی زبان سوار شدهاند.» زبان شبیه تجربهای ازپیشجویده است؛ انواع دیگر داده چگالی معنایی کمتری دارند. گرشمن نیز میپرسد: «چرا در زمینه استدلال درباره دادههای ویدئویی انقلاب مشابهی نداشتهایم؟» مدلهای بینایی کنونی هنوز در استدلال منطقی در فیزیک مشکل دارند. مدل جدید DeepMind میتواند ویدئوهایی بسازد که در آنها رنگها درست مخلوط میشوند یا یک ماز را حل کند؛ اما همین ویدئوها یک لیوان را در حال پریدن نشان میدهند، نه شکستن و طنابهایی که قوانین فیزیک را نقض میکنند و شکننده میشوند و به شکل گره درمیآیند. «آیدا مؤمننژاد» عصبشناس شناختی که اکنون در Microsoft Research مشغول به کار است؛ آزمایشهایی انجام داده که در آن یک LLM یک بازدید مجازی از یک ساختمان دریافت میکند و سپس از آن درباره مسیرها و میانبُرها؛ استنتاجهای فضاییای که برای انسانها آسان است سؤال میشود. در همه موارد بهجز سادهترین تنظیمات، مدلها یا شکست میخورند یا مسیرهای خیالی میسازند و مومننژاد گفت: «آیا واقعاً برنامهریزی میکنند؟ نه واقعاً.»

شتابزدگی صنعت؛ سرعتی بیش از فهم علمی

در گفتوگو با عصبشناسان متوجه نگرانیای میشویم که صنعت هوش مصنوعی کمی بیفکرانه با سرعت به جلو میروند. «برندن ام. لیک» (Brenden M. Lake) دانشمند شناختی پرینستون میگوید: «اگر هدف ساخت ذهنهای مصنوعیای است که بهاندازه ذهنهای انسانی توانمند باشند، آنوقت ما سیستمها را به شیوه درستی آموزش نمیدهیم.» وقتی آموزش یک هوش مصنوعی تمام میشود، «مغز» شبکه عصبی منجمد میشود. اگر درباره خودتان چند واقعیت به مدل بگویید، نورونهایش را بازنویسی نمیکند. در عوض از جایگزینی ابتدایی استفاده میکند؛ یک تکه متن مینویسد؛ مثلاً «کاربر یک کودک خردسال دارد و در حال یادگیری فرانسوی است» و آن را پیش از دستورهای دیگر شما در نظر میگیرد. مغز انسان به طور پیوسته خود را بهروزرسانی میکند و درباره یکی از شیوههای انجام این کار نظریهای زیبا وجود دارد. هنگام خواب، تصاویر منتخب از حافظه اپیزودیک مغز برای نئوکورتکس بازپخش میشود تا آن را آموزش دهد؛ سپس فضای فکری چندبعدی با خاطرات بازپخششده در تعامل قرار میگیرد و وقتی بیدار میشوید، جهان را کمی متفاوتتر میبینید.

جامعه هوش مصنوعی چنان معتاد و از نظر مالی چنان درگیر پیشرفت با سرعت سرسامآور شده که گاهی وانمود میکند پیشرفت اجتنابناپذیر است و دیگر علمی برای انجامدادن باقی نمانده. علم یک ویژگی ناخوشایند دارد که گاهی متوقف میشود. سیلیکونولی ممکن است شرکتهای هوش مصنوعی را «آزمایشگاه» بخواند و برخی کارکنان آن را «پژوهشگر»، اما در بنیان خود فرهنگی مهندسی دارد که هر کاری که جواب بدهد را انجام میدهد. کوهن نیز میگوید: «حیرتانگیز است که جامعه یادگیری ماشین چقدر کمزحمت میکشد که به تاریخ و علوم شناختی پیش از خود نگاه کند، چه رسد به اینکه به آنها احترام بگذارد.»

آیا تفاوتهای مغز و مدلها بنیادیاند؟

مدلهای هوش مصنوعی امروزی، موفقیت خود را مدیون کشفیات چند دهه پیش درباره مغز هستند، اما همچنان عمیقاً متفاوت از مغز هستند. اما کدام تفاوتها اتفاقی و کدام بنیادی هستند؟ هر گروه از عصبشناسان نظریه محبوب خود را دارد. این نظریهها اکنون میتوانند به شکلی که قبلاً ممکن نبود آزموده شوند. بااینهمه، هیچکس انتظار پاسخهای آسان ندارد. نورمن دراینرابطه میگوید: «مسائلی که همچنان هوش مصنوعی را آزار میدهند با شناسایی دقیق شیوههایی حل میشوند که در آن، مدلها به هوشمندیای که از آنها میخواهیم رفتار نمیکنند و سپس برطرفکردن آنها مهم است. این روند هنوز یک فرایند انسان-دانشمند-در-حلقه (human-scientist-in-the-loop) است.»

درسهایی از ژنوم انسان؛ وقتی علم فریب سادگی را میخورد

در دهه نود، میلیاردها دلار به پروژه ژنوم انسان سرازیر شد با این فرض که توالییابی DNA شاید مشکلسازترین مشکلات پزشکی را حل کند. آن دوران، دوران لافزدن و اعتمادبهنفس بود، عصر گوسفند شبیهسازیشده Dolly و «پارک ژوراسیک»؛ یعنی زمانی که زیستفناوری اوج گرفته بود و مفسران با این پرسش دستوپنجه نرم میکردند که آیا انسانها باید در نقش خدا ظاهر شوند یا نه. زیستشناسان خیلی زود دریافتند که واقعیت پیچیدهتر است. ما سرطان را درمان نکردیم یا علل آلزایمر یا اوتیسم را کشف نکردیم؛ اما فهمیدیم که DNA فقط بخشی از داستان زندگی را روایت میکند. درواقع، میتوان استدلال کرد که زیستشناسی در نوعی تب ژنتیکی غرق شد؛ چون ابزار مطالعه و فهم آن را پیدا کرده بود.

بااینهمه هیچکس نمیتواند ادعا کند «فرانسیس کریک» (Francis Crick) اشتباه میکرد وقتی که در روزی در سال ۱۹۵۳ که به کشف ساختار DNA کمک کرد، وارد یک میخانه در کمبریج شد و گفت راز زندگی را کشف کرده. او و همکارانش بیش از تقریباً هرکسی، از رمز زندگی پرده برداشتند. دهههای پس از کشف آنها از پربارترین و هیجانانگیزترین دورهها در تاریخ علم بود. DNA اصطلاحی شد که وارد زبان مردم شد و هر دانشآموز دبیرستانی درباره ساختار مارپیچ دوگانه آن میآموزد.

دوباره در دوران لافزدن؛ این بار در هوش مصنوعی

با ورود هوش مصنوعی، بار دیگر خود را در لحظهای مملو از لافزدن و اعتمادبهنفس مییابیم. سم آلتمن درباره جمعآوری نیم تریلیون دلار برای ساخت Stargate صحبت میکند. مردم درباره رقابت برای ابرهوش با جدیتی سخن میگویند که گاهی بیپایه و حتی مضحک به نظر میرسد. اما گمان میشود دلیل اینکه آمودیها و آلتمنهای جهان اینگونه اعلامیههای آخرالزمانی صادر میکنند این است که باور دارند تصویر پایهای از هوش روشن شده و بقیه فقط جزئیات است.

حتی برخی عصبشناسان باور دارند که آستانهای حیاتی پشت سر گذاشته شده. «اوری هاسون» (Uri Hasson)، همکار کوهن، نورمن و لیک در پرینستون درباره شبکههای عصبی میگوید: «واقعاً فکر میکنم چنین چیزی میتواند مدل درست شناخت باشد.» این موضوع به همان اندازه که او را هیجانزده میکند، ناراحتش هم میکند و میگوید: «من نگرانیام برعکس نگرانی بیشتر مردم است. نگرانی من این نیست که این مدلها شبیه ما هستند؛ نگرانی من این است که ما شبیه این مدلها هستیم.» اگر تکنیکهای ساده آموزش میتوانند برنامهای را قادر کنند رفتاری شبیه انسان نشان دهد، شاید انسانها آنقدرها هم که فکر میکردیم خاص نباشند. آیا این موضوع همچنین میتواند به این معنا باشد که هوش مصنوعی نهتنها در دانش، بلکه در قضاوت، خلاقیت، زیرکی و در نتیجه قدرت از ما پیشی بگیرد؟ برخلاف انتظار رایج، هاسون عنوان میکند که: «این روزها نگرانم که ممکن است در فهم نحوه کارکرد مغز موفق شویم. دنبالکردن این پرسش شاید اشتباهی عظیم برای بشریت بوده باشد.» او پژوهشگران هوش مصنوعی را به دانشمندان هستهای دهه ۱۹۳۰ تشبیه کرد: «این جذابترین دوران در زندگی این افراد است و درعینحال میدانند چیزی که روی آن کار میکنند پیامدهای سنگینی برای بشریت دارد. اما بهخاطر کنجکاوی، بازایستادن ممکن نیست.»