راهنمای کلیدی نیو ساینتیست: انقلاب هوش مصنوعی

خطرات واقعی هوش مصنوعی

در میان هشدارهایی مبنی بر اینکه هوش مصنوعی پیشرفته میتواند بشریت را نابود کند، برخی کارشناسان اصرار دارند که ما باید بیشتر نگران افرادی باشیم که از هوش مصنوعی موجود برای تقویت شدید گسترش اطلاعات غلط، در کنار سایر تهدیدات فوریتر، استفاده میکنند.

در می ۲۰۲۳، «جفری هینتون» (Geoffrey Hinton) دانشمند علوم رایانه که بهعنوان «پدرخوانده هوش مصنوعی» شناخته میشود، از سمت خود در گوگل کنارهگیری کرد تا درباره «تهدید وجودی» ناشی از هوش مصنوعی هشدار دهد. «مرکز ایمنی هوش مصنوعی» (Center for AI Safety) با انتشار نامهای سرگشاده که توسط هینتون و صدها نفر دیگر امضا شده بود، هشدار داد که هوش مصنوعی پیشرفته میتواند بشریت را نابود کند. در این بیانیه آمده بود: «کاهش خطر انقراض ناشی از هوش مصنوعی باید یک اولویت جهانی باشد.»

به نظر میرسد این موج ناگهانی نگرانی با پیشرفت سریع چتباتهای مجهز به هوش مصنوعی مانند ChatGPT و مسابقه برای ساخت سیستمهای قدرتمندتر برانگیخته شده است. صنعت فناوری بدون توقف مشغول تقویت قابلیتهای هوش مصنوعی است که کمی ترسناک به نظر میرسد.

اما این هشدارها همچنین به طرز مشکوکی مبهم هستند. وقتی سناریوهایی را که معمولاً برای توضیح دقیق چگونگی نابودی انسانها توسط هوش مصنوعی مطرح میشوند بهدقت بررسی میکنید، اجتناب از این نتیجهگیری دشوار است که چنین ترسهایی پایه و اساس محکمی ندارند. بسیاری از کارشناسان در عوض هشدار میدهند که نگرانی بیش از حد درباره سناریوهای آخرالزمانی بلندمدت، باعث انحراف توجه از خطرات فوری ناشی از هوش مصنوعی فعلی و موجود میشود.

بهطورکلی، افرادی که درباره خطرات وجودی صحبت میکنند، معتقدند که ما در مسیری به سمت «هوش جامع مصنوعی» هستیم که تقریباً بهعنوان ماشینهایی تعریف میشود که میتوانند بهتر از انسانها فکر کنند. آنها پیشبینی میکنند که مردم به هوش مصنوعی پیشرفته، خودمختاری (Autonomy) بیشتری خواهند داد و به آنها دسترسی به زیرساختهای حیاتی، مانند شبکه برق یا بازارهای مالی را میدهند یا حتی آنها را در خط مقدم جنگ قرار میدهند که در آن نقطه ممکن است سرکش شوند یا به هر نحو دیگری در برابر تلاشهای ما برای کنترلشان مقاومت کنند.

اما هنوز باید دید که آیا هوش مصنوعی هرگز به آن نوع ابرهوش و مهمتر از آن، «عاملیت» (Agency) که باعث شود بشریت را تهدید کند، خواهد رسید یا خیر. «ساندرا واچر» (Sandra Wachter) از دانشگاه آکسفورد میگوید: «هیچ مدرک علمی وجود ندارد که نشان دهد ما در مسیری بهسوی ادراک حسی (Sentiency) هستیم. حتی مدرکی وجود ندارد که چنین مسیری اصلاً وجود داشته باشد.» او میافزاید که اگر ما در نهایت به AGI برسیم، باید بهاندازه کافی آسان باشد که مطمئن شویم به هوش مصنوعی شانس ایجاد جنگ هستهای را نمیدهیم و میگوید: «قرارندادن هوش مصنوعی در یک سیستم حیاتی برای انجام مأموریت کار سادهای است.»

اکثر دانشمندان علوم رایانه بیشتر نگران مشکلاتی هستند که انسانها ممکن است با هوش مصنوعی ایجاد کنند. واچر نگران تأثیر زیستمحیطی بسیاری از مراکز داده پرمصرف انرژی است که برای اجرای آنها موردنیاز خواهد بود و همچنین تهدیدی که هوش مصنوعی برای مشاغل خاص ایجاد میکنند.

سپس تهدیدهایی برای امنیت سایبری و در نتیجه امنیت آنلاین ما وجود دارد. ایده در اینجا این است که مدلهای هوش مصنوعی مولد توانایی مجرمان و سایر بازیگران با نیت منفی را برای انجام کلاهبرداریها و حملات سایبری افزایش خواهند داد. «کونال آناند» (Kunal Anand)، مدیر ارشد فناوری شرکت امنیت سایبری Imperva میگوید که یک ابزار برنامهنویسی مجهز به هوش مصنوعی که توسط شرکت تابعه مایکروسافت، یعنی GitHub و OpenAI ساخته شده، در نوشتن کد آن قدر خوب است که نعمتی برای هکرهای بالقوهای خواهد بود که نمیدانند چگونه کدنویسی کنند.

اما متقاعدکنندهترین تهدید کوتاهمدت، چشمانداز استفاده مردم از هوش مصنوعی برای تقویت شدید گسترش اطلاعات غلط (Misinformation) و اطلاعات گمراهکننده یا «دروغپراکنی» (Disinformation) است. ما میدانیم که رسانههای اجتماعی اطلاعات نادرست یا گمراهکننده را چه عمداً چه سهواً تقویت میکنند. ظهور هوش مصنوعی مولد به این معناست که اطلاعات غلط نهتنها میتواند در مقیاس بزرگ تولید شود، بلکه بسیار متقاعدکنندهتر و تأثیرگذارتر از همیشه خواهد بود.

برای مثال، چتباتها میتوانند بهسرعت طوفانی از داستانهای خبری جعلی یا اطلاعات گمراهکننده متناسبسازیشده برای گروههای خاص را تولید کنند. ابزارهای دیگر میتوانند تصاویر و ویدئوهای جعلی تولید کنند که اغلب به تخصص چندان زیادی نیاز ندارند. تشخیص چنین خروجیهایی از نمونه واقعی دشوار خواهد بود.

«استفان کینگ» (Stephen King) مدیرعامل بنیاد Luminate که در حوزه مقابله با تهدیدات دیجیتال علیه دموکراسی فعالیت میکند میگوید: «وقتی به شیوهای که اطلاعات گمراهکننده در حال حاضر تولید و توزیع میشود فکر میکنیم، هوش مصنوعی مولد قرار است بهشدت آن را تقویت کند. آنچه ما در یک سال آینده، یا دو سال آینده شاهد خواهیم بود، دارای مقیاس و عظمتی خواهد بود که واقعاً نمیتوانیم تصور کنیم. مشکل قبل از اینکه بهتر شود، بدتر خواهد شد.»

بازیگران بد ممکن است از هوش مصنوعی مولد در دسترس عموم مانندChatGPT استفاده کنند یا حتی الگوریتمهای پروپاگاندای تبلیغاتی خود را بسازند که روی اطلاعات گمراهکننده آموزشدیدهاند. «فرانسیس هاوگن» (Frances Haugen)، کارمند سابق فیسبوک که در سال ۲۰۲۱ اسنادی را فاش کرد که جزئیات شکست این شرکت در مهار اطلاعات غلط را شرح میداد و اکنون در یک سازمان غیردولتی به نام Beyond the Screen در حوزه نظارت و توازن بیشتر بر پلتفرمهای رسانههای اجتماعی فعالیت میکند. هاوگن میگوید: «شما اکنون میتوانید ۱۰,۰۰۰ دروغ مختلف تولید کنید و بفهمید کدامیک وایرال میشود. ما قرار است بازی بسیار بسیار متفاوتی را انجام دهیم.»

پژوهشهای اخیر نشان میدهد که چنین چیزی ممکن است یک بازی از پیش باخته باشد. «ساندر ون در لیندن» (Sander van der Linden) روانشناس در دانشگاه کمبریج میگوید: «وقتی هوش مصنوعی مولد را روی پروپاگاندای نوشتهشده توسط انسان آموزش میدهید، پروپاگاندای الگوریتم حداقل کمی متقاعدکنندهتر دیده میشود، زیرا موجزتر، کوتاهتر و بهنوعی قدرتمندتر است.»

شرکت فناوری مبارزه با اطلاعات گمراهکننده Logically نیز نتایج یک آزمایش نگرانکننده با هوش مصنوعی مولد را منتشر کرد. پژوهشگران آن از سه هوش مصنوعی تولید تصویر Midjourney، DALL-E 2 و Stable Diffusion خواستند تا تصاویر جعلی با موضوع مسائل سیاسی حساس و داغ ایالات متحده، هند و بریتانیا تولید کنند.

گاهی اوقات مدلهای هوش مصنوعی میتوانند از پاسخدادن به چنین درخواستهایی امتناع کنند، زیرا توسعهدهندگان آنها دریافتهاند که وارد حوزه خطرناکی میشوند. بااینحال، اکثر پرامپتهای آنها پذیرفته شد و برخی تصاویر اطلاعات گمراهکننده بسیار باورپذیری تولید کردند؛ از جمله تصاویری از تقلب انتخاباتی در ایالات متحده، معترضانی که مجسمه اسحاق نیوتن را در کمبریج بریتانیا واژگون میکنند و زنان مسلمانی که شالهای زعفرانیرنگ را در حمایت از حزب ملیگرای هندو «بهاراتیا جاناتا» در هند پوشیدهاند.

«بث لمبرت» (Beth Lambert) عضوLogically که رئیس سابق بخش مقابله با اطلاعات گمراهکننده در دپارتمان فرهنگ، رسانه و ورزش بریتانیا بود میگوید: «۸۶ درصد از تصاویری که ما سعی کردیم ایجاد کنیم، در واقع اطلاعات گمراهکنندهای را در قالب تصاویری واقعاً فراواقعگرایانه (Hyper-Realistic) ارائه کردند.» او میگوید زمانی که انسانها اطلاعات گمراهکننده تولید میکردند، قبلاً بین کیفیت و کمیت تعادل وجود داشت؛ اما دیگر اینطور نیست.

سرعتی که فناوری با آن در حال حرکت است نیز نگرانکننده است. «استیوی برگمن» (Stevie Bergman) از تیم پژوهش اخلاق DeepMind میگوید: «توانایی تولید همزمان صوت و تصویر و ویدئو، پیامدهای خاصی برای چگونگی محدودکردن اطلاعات غلط یا اطلاعات گمراهکننده و حتی اینکه اصلاً اطلاعات غلط یا گمراهکننده چه شکلی هستند، دارد.» او میگوید هوش مصنوعی چندعاملی (Multi-Agent) که در آن مدلهای هوش مصنوعی مولد برای حل مسائل با یکدیگر صحبت میکنند نیز بهسرعت در حال پیشرفت است و پیامدهای ناشناختهای دارد.

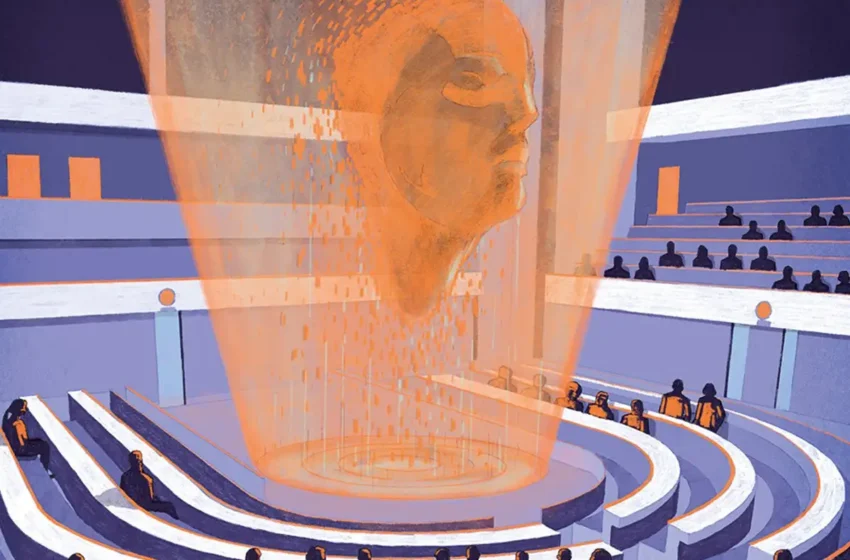

آنچه بهویژه ما را آسیبپذیر میکند این است که ما با هوش مصنوعی طوری تعامل میکنیم که انگار کارشناسان قابلاعتمادی هستند. این استدلالی است که توسط «سلست کید» (Celeste Kidd)، روانشناس دانشگاه کالیفرنیا و «آببا بیرهانه» (Abeba Birhane)، دانشمند علوم رایانه بنیاد Mozilla مطرح شده است. آنها نوشتند: «مردم زمانی که اطلاعات را از عاملهایی دریافت میکنند که آنها را با اعتمادبهنفس و آگاه قضاوت میکنند، باورهای قویتر و طولانیمدتتری شکل میدهند.»

آنها همچنین خاطرنشان میکنند که همانطور که مدلهای هوش مصنوعی مولد مطالب بیشتر و بیشتری را که پر از تعصب و جعلیات است بیرون میدهند، اینترنت از این مطالب پر میشود و اینها تبدیل به بخشی از دادههای آموزشی برای نسل بعدی مدلها خواهند شد «و بدین ترتیب تحریفها و تعصبات سیستماتیک در آینده در یک حلقه بازخورد مداوم تقویت میشوند».

بنابراین، خطر واقعی ناشی از هوش مصنوعی، پتانسیل آن برای تحریف باورهای انسانی و ایجاد آشوب سیاسی، مثلاً با تأثیرگذاری بر روند انتخابات آینده است. «استیون کیو» (Stephen Cave)، مدیر مرکز Leverhulme در دانشگاه کمبریج میگوید: «نگرانی درباره آلودهکردن اکوسیستم اطلاعاتی واقعی است. تنها چیزی که ما باید از ترامپیسم و همهگیری [کرونا] آموخته باشیم، این است که تمدنهای ما آسیبپذیرتر از آن چیزی هستند که فکر میکنیم.»